深度学习技术在影像密集匹配方面的进展与应用

2020-12-04王蓬勃叶龙杰

张 卡,宿 东,王蓬勃,陈 辉,张 珊,叶龙杰,赵 娜

(1.自然资源部城市国土资源监测与仿真重点实验室,深圳 518034;2.南京师范大学地理科学学院,南京 210023;3.南京师范大学虚拟地理环境教育部重点实验室,南京 210023;4.江苏省地理信息资源开发与利用协同创新中心,南京 210023;5.江苏省地理环境演化国家重点实验室培育建设点,南京 210023)

密集匹配作为三维重建的核心步骤,通过对影像进行逐像素的匹配,自动找寻其同名点,计算各像素点视差值,根据能量方程最优化,得到稠密或准稠密的视差图。并且需要在匹配过程中克服弱纹理、重复纹理、物体遮挡等典型复杂区域的影响。Scharstein等[1]在其开创性的分类学工作中认为,如今经典立体匹配算法主要由4个构建模块组成:①匹配代价计算;②匹配代价集聚;③视差计算;④视差优化处理。匹配代价主要包括归一化互相关系数(normalized cross correlation,NCC)、互信息(MI)、SSD(sum of squared differences)等常用的相似度计算函数,通过给定的相似性度量在待搜索图像中进行逐像素查找,生成视差空间(disparity space image,DSI)。匹配代价集聚是通过对待匹配像素进行一定范围的匹配代价累加,消除其中噪声带来的消极影响。常见的代价集聚方式有半全局匹配算法(semi-global matching,SGM)[2]和置信度传播[3]等。视差计算主要是通过赢者通吃(winner take all,WTA)方法选取视差范围中对应匹配代价最优的作为视差。最后进行视差优化,通过对获取的视差图进行左右一致性检验、亚像素增强等操作,剔除误差较大的点,获取更为平滑的视差图。

传统密集匹配方法主要分为全局匹配方法和局部匹配方法。全局匹配方法通过构建模型的方式,将问题转化为能量函数最优解,从而获取视差图。具有代表性的包括置信度传播、图割算法[4]等。全局方法生成的视差图效果更好,但计算成本更高,花费时间较长。局部匹配方法计算过程与全局匹配方法大致相同,不同之处在于代价集聚方式主要采用固定窗口大小的方式进行集聚。为了优化局部匹配方法的匹配结果,研究人员采用了自适应窗口[5-6]、自适应权值参数[7-9]以及更优异的相似性测度[10]。Hirschmǖller[2]提出了一种半全局匹配算法,利用8个或16个方向上的一维代价集聚替代二维代价集聚。该算法近似于全局匹配算法,但运算速度更快。

近年来,随着计算机硬件和大数据的快速发展,深度学习也快速兴起。并且深度学习已逐渐成为机器学习的主流[11]。各类型的卷积神经网络(CNN)在目标检测、语义分析、图像分类等计算机视觉领域都取得了丰硕的成果。因此,如何将深度学习技术高效地应用于影像密集匹配以提高其可靠性,是众多学者研究的热点。现针对深度学习在影像密集匹配上的应用研究现状,从基于图像块的相似性度量学习和端对端生成视差图两个方面,论述现有研究的优缺点,并展望其未来发展趋势。

1 深度学习在影像密集匹配中应用的中外研究现状

深度学习源于机器学习,在20世纪40年代就有相关雏形出现,但直到2006后,深度学习才开始得到快速发展。深度学习相较于机器学习模型的神经学观点,更加注重“多层次组合”的原理。随着计算机软硬件基础设备和大数据的极速发展,原本局限于此的计算机人工神经网络已经突破其桎梏。深度学习因其具有较深层的网络结构,在人工神经网络与计算机视觉领域得到大力推广应用,并取得了较为丰硕的成果。深度学习多使用监督或半监督的方式,从大量已知数据中学习,通过参数的调整,得到一个能解决此类问题的神经网络模型。即通过利用具有基本事实的数据集,模拟学习,显著提高其准确性;最后将待预测数据通过导入该模型,得到较为精确的结果。

Lecun等[12]最早在1998年提出采用卷积神经网络进行手写字体的高效识别。卷积层作为卷积神经网络最重要的核心,通过卷积滤波器对二维图像进行处理,将其应用于图像领域,可以获得图像中的多种特征。文献[13]作为现代卷积神经网络的奠基之作,自此之后,卷积神经网络真正进入研究者们的视线,并由此产生了各种结构的深度神经网络。

但是,在如何将深度学习利用到影像的密集匹配这一方面,却迟迟没有进展。直到2015年,Žbontar等[14]通过将深度学习与半全局匹配算法结合,使用监督学习的方式获得视差空间,以此代替传统手工代价函数。在此之后,越来越多的深度学习方法被应用在影像的密集匹配上。Mayer等[15]、Kendall等[16]提出的端到端深度学习方法不再沿用前者通过学习匹配代价的方式获取视差图,而是通过学习已知训练数据,直接获取未知图像对的视差图。端到端的学习方式真正通过训练数据解决现有问题,但随之也会带来训练数据量增大、复杂程度增加等问题。

深度学习方法的核心思想是利用多层的卷积层、池化层、全连接层以及整数线性单元(ReLU)等激活函数组成的卷积神经网络,从输入图像块中提取特征向量。因此,卷积神经网络最终预测结果的好坏与其结构的优劣也密切相关。基于图像块的相似性度量学习和端对端生成视差图两个方面论述深度学习在影像密集匹配方面应用的中外研究现状。

2 基于图像块的相似性度量学习

相似性度量学习的核心思想是将深度学习方法应用到现有匹配代价计算中,将数据作为驱动,替代原有的包含人工参与的计算。在已有真实视差值的情况下,通过监督学习的方式获取卷积神经网络中的各项权值参数。在大量训练数据集的基础上,利用神经网络正反传播计算,得到比手工设定的函数更为优异的匹配代价。下面将从常用神经网络结构及匹配优化手段上详述基于图像块的相似性度量学习的研究现状。

2.1 Siamese Network的应用

目前,针对影像匹配问题的深度学习网络模型形式多样,并且在KITTI数据集、Middlebury数据集上均取得了较好的效果。在影像匹配领域中,主要使用的神经网络模型是孪生神经网络(Siamese-network,Sia-Net)。Sia-Net由Bromley等[17]在1993年提出,用于鉴定支票上的客户签名与银行处存留的签名是否一致。Sia-Net具有两条构造完全相同的神经网络分支,并且共享网络权值,主要用于监督学习,输入数据也不再是单一的一张图像,而是一对图像对。其主要原理是通过两条分支分别输入左右图像,通过简单的距离度量(例如欧式距离)等判断图像对之间的相似性。

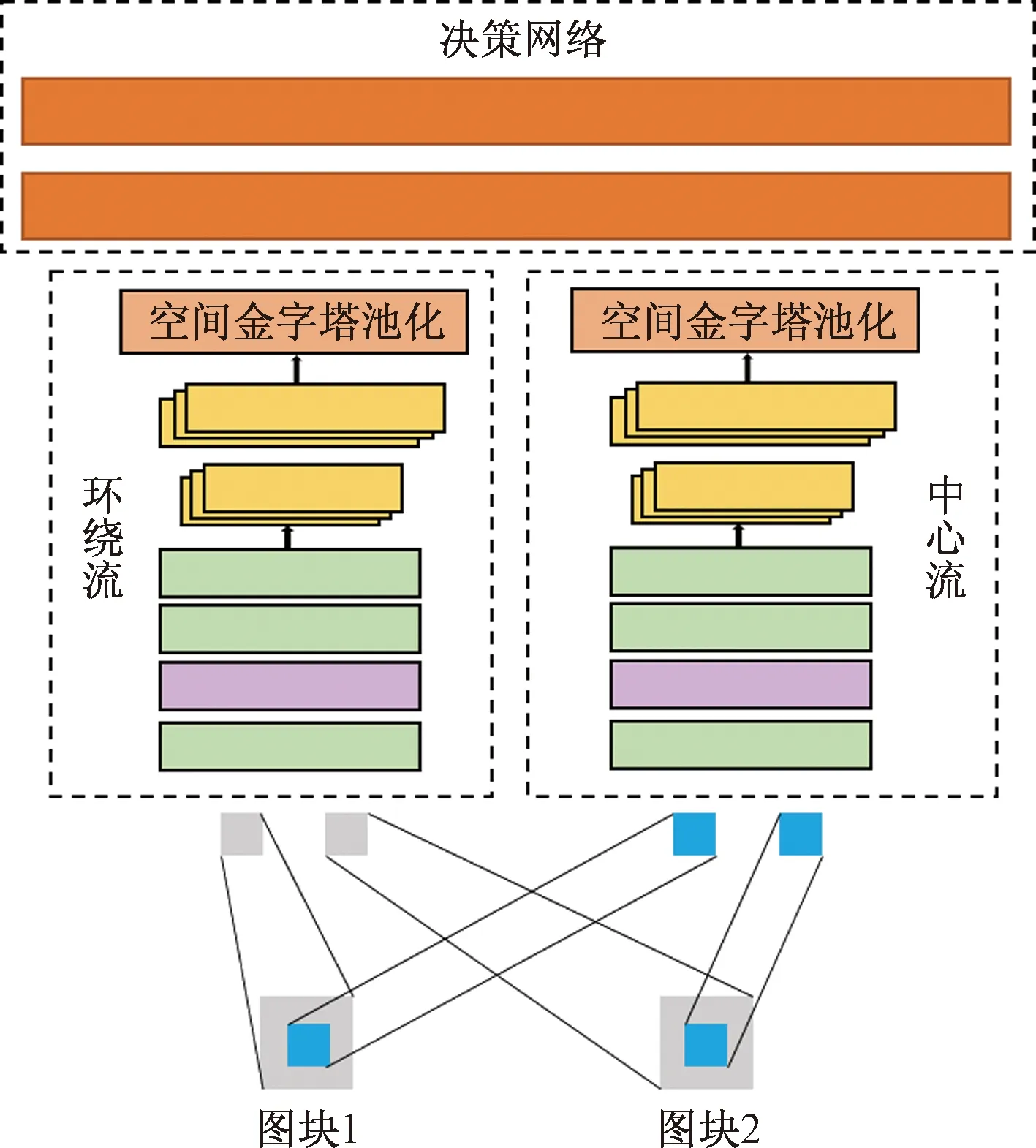

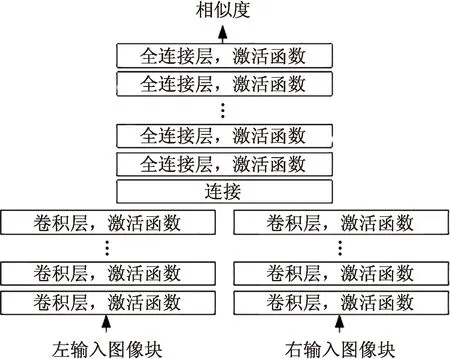

Zagoruyko等[18]在2015年提出了一种改进的Siamese网络,即2-channel network。基于之前广泛使用的传统Siamese网络,提出了三点主要创新:①提出2-channel结构;②加入了中心环绕双流网络结构;③结合了空间金字塔池化(spatial pyramid pooling,SPP)[19],网络结构如图1所示。上述三项改进使得网络模型训练速度更快;多尺度的输入使得网络的鲁棒性更好;并且通过引入SPP来避免多尺度图像输入时所需的归一化尺寸步骤。2-channel结构将两张灰度图像视为一张两通道图像,经过同样的卷积网络处理后,在最后全连接层中输出其相似性度量,不同于原有网络利用两条相同分支,分别处理后再聚合。中心环绕双流网络通过从图片中心截取固定尺寸比例的图像块和降采样后的图像块,利用多尺度的输入,加强网络运算效率,对图片中心区域的预测更为可靠。其与SSP的结合,使得卷积层提取出的特征向量进入全连接层前不再需要固定尺寸大小,为多尺度的实现提供了帮助。并且明显增强的神经网络的鲁棒性,使其可以面对更加复杂的预测情况。

图1 改进Siamese网络[18]Fig.1 Improved Siamese network[18]

从文献[20-21]中可以发现,卷积层中所使用的卷积核尺寸大小并不是越大越好,而是根据输入图片的尺寸和网络结构来设定。并且在网络模型结构的修改中存在如下基本准则:①避免使用较大的卷积核参与卷积;②尽可能减少网络模型中的参数,避免过拟合现象的发生;③多使用非线性激活函数,提升特征的特性[21]。

2.2 相似性度量学习

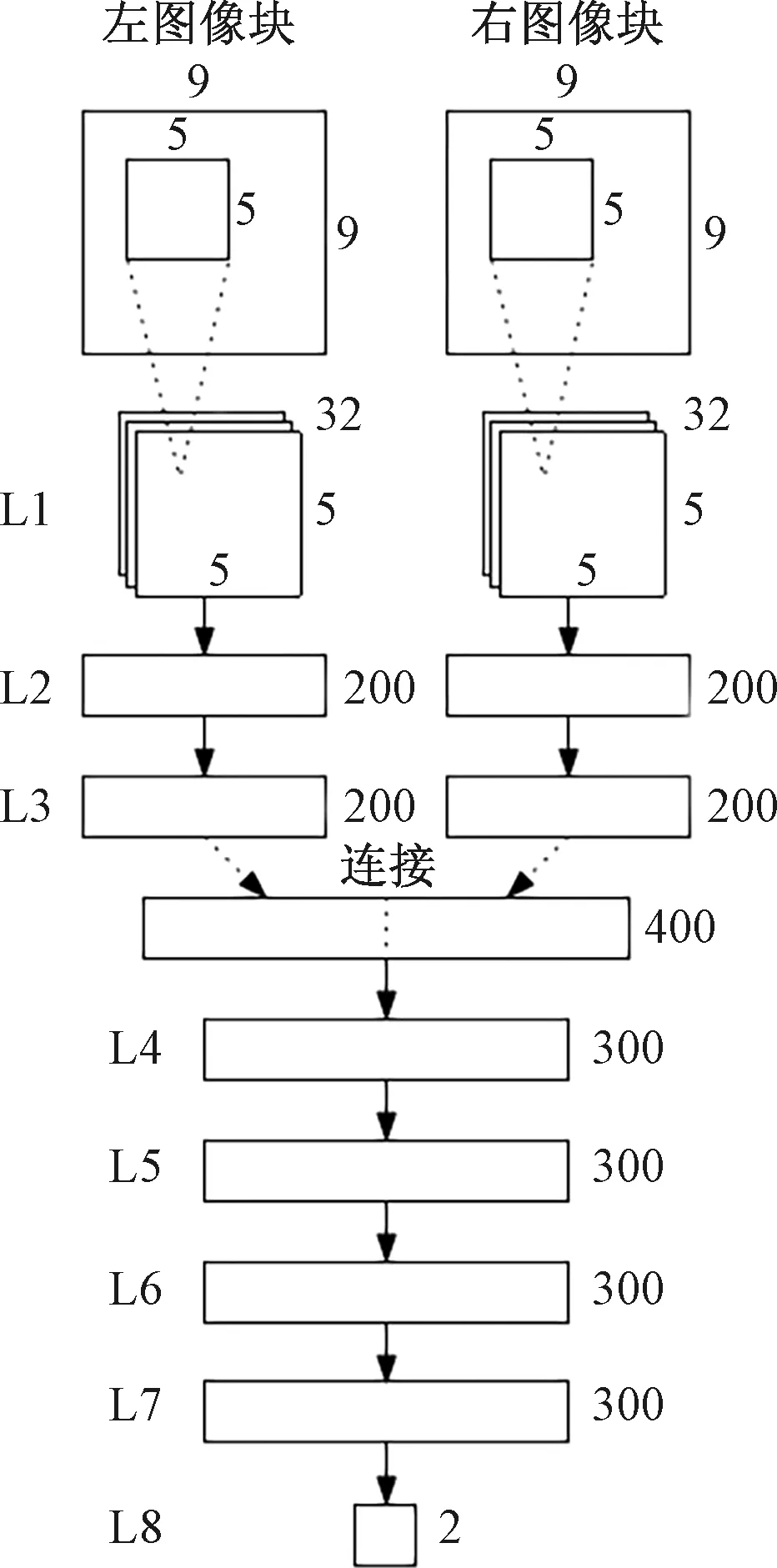

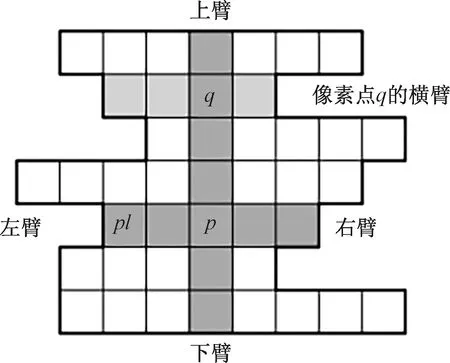

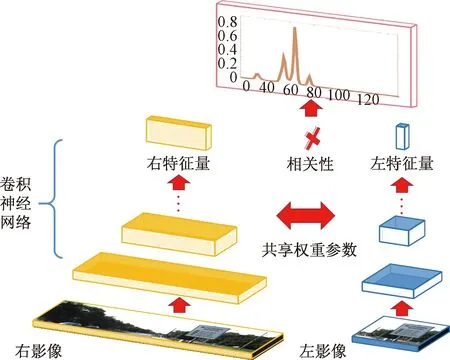

2008年,Hirschmǖller等[2]提出了使用半全局匹配和互信息进行立体匹配得到视差图,之后该方法被大量应用于计算机视觉和摄影测量等领域的视差图生成及三维重建中。2015年,Žbontar等[14]首次将深度学习应用到影像的密集匹配中,提出了用于计算匹配代价的MC-CNN(matching cost convolutional neural networks),网络结构如图2所示。该架构在流程中没有使用池化的情况下占用了9×9窗口,而由于窗口的尺寸有限,计算出的匹配视差图是有噪声的。因此,它通过使用基于交叉的成本集聚(cross-based cost aggregation,CBCA)方法对神经网络模型计算得到的匹配代价进行集聚,左右一致性检验、均值滤波以及双边滤波用于平滑视差图。基于交叉的成本集聚方法如图3所示。目前绝大多数性能排名靠前的深度卷积神经网络都是以此作为启发。

L1为网络的卷积层;L2~L8为全连接层;L1中以5×5×1的32个卷积核进行卷积;200、400、300为全连接层中的神经元个数图2 MC-CNN网络结构Fig.2 MC-CNN network structure

p表示一个区域像素点的集合;q表示另一区域像素点的集合图3 基于交叉的成本聚合Fig.3 Cross-based cost aggregation

通过神经网络结构改进和匹配代价优化两个方面详述相似性度量学习的主要优化手段。

2.2.1 基于卷积神经网络结构的改进

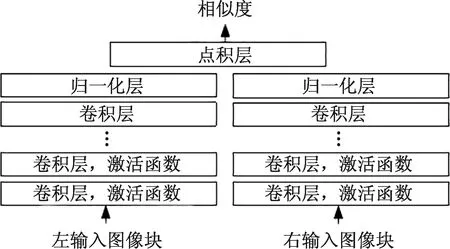

Žbontar等[22]在其原有MC-CNN网络基础上进行了改进,提出了快速架构(MC-CNN-fst)和精准架构(MC-CNN-acrt)。MC-CNN-fst如图4所示,用于提取左右图像块的特征向量,并通过多个完全连接层学习特征向量之间的相似性度量。该结构的输入为左右两个图像快,输出0~1的单个实数作为两者间的相似性度量;该结构对于像素点的视差预测更为准确。MC-CNN-acrt如图5所示,通过两个包含卷积层和ReLU的子网络,从左右输入图像块提取矢量并计算其余弦相似度来得到相似性度量;余弦相似度计算分为归一化和点积。这使得该网络所需内存更少,在训练及预测速度上更有优势。

图4 MC-CNN-fst网络结构示意图Fig.4 Schematics of MC-CNN-fst network

图5 MC-CNN-acrt网络结构示意图Fig.5 Schematics of MC-CNN-acrt network

同样是使用基于块匹配的思想,Luo等[23]提出一种新的内积层用于计算Siamese-Network[17]两个网络分支的内积结果,并且在图形处理器(GPU)的帮助下实现了更快的运算。对于图像块的相似性判断也不再是文献[14]所采用的单纯的“相似”与“不相似”分类问题,而是根据视差值范围定义为多分类问题。网络结构如图6所示。最终在GPU的计算下,通过牺牲一些主观效果,可将视差预测结果控制在1 s内。

图6 文献[23]结构思路Fig.6 Structural schematic proposed by reference[23]

He等[19]针对于卷积神经网络的尺寸局限性,首次提出了使用空间金字塔池化来消除CNN的尺寸局限。该网络通过在神经网络后端加入SPP层,将输入的不同尺寸大小的特征图进行归一化后,输入到全连接层中进行分类处理,避免了额外的固定尺寸要求。

文献[24-27]已经证明训练样本的多尺度决定了神经网络的普适性与精确性;Chen等[28]对多尺度的应用进行了研究,提出了一种多尺度嵌入模型以获取更为可靠的局部匹配代价。该多尺度嵌入模型通过给定CNN输出的特征向量,直接利用点积层在欧几里得空间中计算其相似性,与文献[14]相比不再使用架构复杂的全连接层,这使得其速度更快,重建精度上也几乎没有过多的浪费。并且该模型从多尺度集合框架中学习[18],其可以自动融合在不同尺度空间下学习到的特征向量。在Li等[29]同样对尺度的应用进行了研究,其在Siamese-Network的基础上加以改进,提出了一种具有反卷积层的高效率Siamese-Network。反卷积层的加入,使得卷积神经网络不再仅局限于卷积和池化操作,并且可以获得更大的感受野,捕获更多的特征,由此提高网络的多样性。与文献[14]不同的是,对于像素点,不再采用一正一负的训练输入图像对。其采用针对每个像素点左右网络分支输入不同大小的图像块,图像块之间的尺寸差异由给定的最大视差决定,文献[29]的神经网络输出变为针对所有可能视差大小的多分类问题。如式(1)所示,虽然同样采用dot-product,但与文献[23]不同的是,在计算最终损失的时候不再仅考虑像素点的损失,而是考虑像素点周边像素损失的总和,采用基于交叉熵最小化损失函数,以优化权重θ,从而权衡网络。

(1)

式(1)中:q为待匹配点;Ω(p)为输出图像块的待匹配点集合;N为最后一层反卷积层的滤波器总数;n为每层滤波器数目,qn为使用n个滤波器时q的值;θ为权重参数;pgt(q)为增量函数,其表达式如式(2)所示;pout(qn,θ)为对应θ的神经网络输出值。

(2)

式(2)中:d(qGT)为像素点q对应真实视差值;qGT为q点的真值;d(q)为像素点q输出视差值。

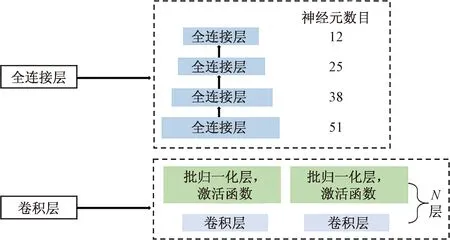

深度卷积神经网络除了重视预测结果准确度外,同样需要考虑运行成本和时间成本。一个优秀的网络模型应该具备准确度高、耗时少、鲁棒性好等特点。如图7所示,肖进胜等[30]提出了一种基于MC-CNN的改进神经网络,其主要贡献包括:在卷积神经网络中的特征信息提取过程中,在每一层卷积层后添加批归一化层[31],使其可以采用更大的学习率,更快收敛;对网络末端的全连接层采用“逐层缩减”的方式,在保证精度的同时下加快网络运行速度。

图7 文献[30]网络结构改进示意图Fig.7 Schematic of network structure improvement by reference [30]

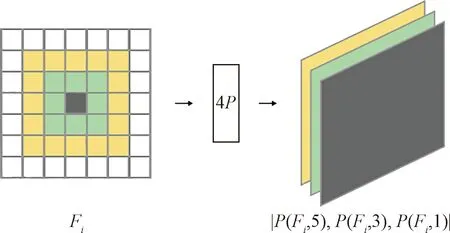

传统卷积神经网络的前向传播中,主要使用max-pooling、mean-pooling层等对卷积层输出结果进行处理,可以在保留主要特征的同时,减少参数数量,防止过拟合现象的发生。Park等[32]提出了一种逐像素金字塔池化层(per-pixel pyramid-pooling layer,4P层),用大的池窗替代具有步长的小池窗来实现感受野的期望大小,并执行具有不同窗口大小的多个池化,将输出串联起来以创建新的特征图。生成的特征图包含从粗到精的比例尺的信息。该模块可以成功地利用来自大区域的丰富信息,而又不至于损失分辨率及细节,避免了在丢失细节的大窗口和丢失空间信息的小窗口之间权衡。并且面对弱纹理区域、深度不连续区域、光照等,具有良好的鲁棒性。如图8所示,P(Fi,si)为进行步长为1、窗口尺寸为si的池化操作,其中Fi为图像块窗口。

图8 4P层对特征的一个通道处理示意图[32]Fig.8 Schematic of one channel processing of 4P layer for features[32]

2.2.2 匹配代价优化

除对神经网络结构进行改进外,匹配代价优化同样至关重要。2018年,Batsos等[33]在MC-CNN的启发下提出了一种类似的神经网络:CBMV(coalesced Bidirectional matching volume),与MC-CNN相比,具有更好的可扩展性。CBMV的核心是包含有归一化互相关(NCC)等4种传统匹配函数,通过计算每种匹配函数和每个匹配方向的度量:从左到右和从右到左,可将其作用于各种优化算法的匹配体积计算。在计算过程中,虽然左右图像像素之间的匹配代价相同,但其可能由于匹配方向的不同而产生不同的置信和模糊性。针对此类问题,文献[33]对2个匹配方向所产生的竞争程度(模糊性)进行测量,并对产生的结果匹配和置信数据使用一种高效的机器学习算法:随机森林(RF)[34]进行合并,最后该分类器预测每个视差值正确的概率。Liang等[35]提出了一种将立体匹配的代价计算、代价聚合、视差计算和视差优化四个步骤整合到同一个网络中进行训练,不再是单独训练匹配代价。马伟等[36]在马尔科夫随机场框架下利用简单线性迭代聚类(SLIC)[37]方法计算分割图,在网络模型结果中加入分割线索的约束,从而在一定程度上克服弱纹理及无纹理区域带来的挑战。

Seki等[38]提出了一种基于深度学习的处罚估计方法。SGM有惩罚参数,它们控制视差图的平滑性和不连续性,不再使用传统的经验估计来设置惩罚,而是通过深度学习的方法预测图像3D对象结构中的惩罚。并且提出了一种新颖的SGM参数化方法,其可以根据正或负的视差变化来部署不同的惩罚[38]。

3 端到端的视差值学习

从上述诸多文献可以看出,基于图像块相似性度量的学习已经显示出较好的可靠性和扩展性,但是它们并不能通过网络直接获取像素点视差值,依然需要依靠后续步骤才能得到可靠的视差图。于是一种端到端的深度学习方式开始兴起。该模型利用神经网络替代原有的传统正则化和后处理步骤,通过监督学习的方式,直接预测出像素点视差值。得益于大量的训练数据集,基于端到端方式的密集匹配方法在KITTI 2012和KITTI 2015[39-40]数据集排名中均取得了较为靠前排名。端到端的视差学习可主要分为以下两类:监督型密集匹配和非监督型密集匹配。

3.1 监督型密集匹配

监督式学习由于具有较好的鲁棒性与可扩展性,在机器学习领域被广泛利用。在监督型密集匹配方面,Mayer等[41]通过将卷积神经网络对光流的预测扩展到对视差的预测,首次提出了端到端视差估计网络DispNet,并且合成了一个大型立体数据集用于卷积神经网络的训练。其按照FlowNet[42]的结构组建了自己的神经网络模型DispNet:包含一个收缩部分和一个扩展部分,两部分之间通过远程链接进行连接。收缩部分包括多个卷积层,扩展部分由上卷积(upconv)、卷积(iconv)和损失层(loss)交替组成[41]。该网络模型在预测精度上略低于MC-CNN-acrt[22],但运行速度更快。该文章中还提出通过将FlowNet与DispNet组合,可以得到用于场景流预测的深度神经网络。

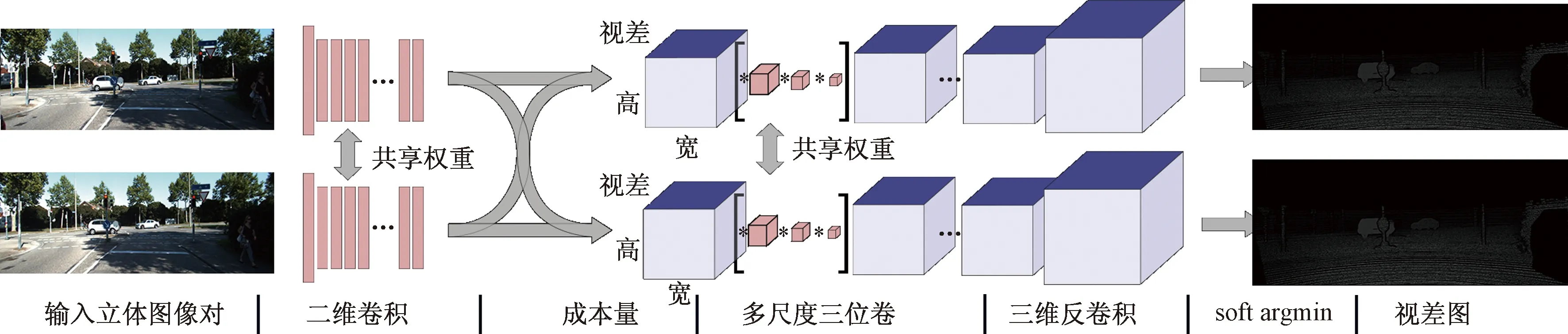

如图9所示,Kendall等[43]在2017年提出了几何与上下文网络(geometry and context network,GC-Network)。与文献[41]所不同的是,GC-Network将视差图作为二维影像的第三维度,使用3D卷积来结合上下文信息直接生成最优视差图,不会在计算匹配代价时破坏特征维度。Kendall等[43]针对经典密集匹配算法中采用argmin获取视差值存在的多种问题,使用一种柔性argmin函数直接从成本空间回归得到亚像素视差值,该改进函数不但可以利用微分进行反向传播,还能通过回归得到一个平滑的视差预测结果,函数计算方式如式(3)所示:

图9 端到端立体匹配回归模型[43]Fig.9 End-to-end stereo matching regression model[43]

(3)

式(3)中:soft argmin为柔性argmin函数;d为视差值;Cd为对应视差d的匹配代价;Dmax为最大视差值。这种柔性注意力机制由文献[44]首次引入。

2018年,Chang等[45]提出一种端到端的金字塔立体匹配网络(pyramid stereo matching network,PSMNet),其核心是金字塔池化和3D卷积神经网络。金字塔池化模块通过聚合不同尺度和不同位置的环境信息构建匹配代价体(cost volume),将全局环境信息结合到图像特征中;3D CNN通过将多个堆叠的沙漏网络(hourglass network)与中间监督(intermediate supervision)结合起来,去调整匹配代价体。金字塔池化模块将全局环境信息结合到图像特征中,堆叠的沙漏3D CNN来扩展匹配代价体中的环境信息支持。

对于端到端方式的密集匹配,匹配代价的计算与集聚同样至关重要。Yu等[46]对关注较少的匹配代价集聚方面进行了研究,提出了一种基于学习的代价集聚方式,并可以作为子结构与其他端到端网络合并,所采用的双流网络在保留低级结构信息的同时,还保留了丰富的语义信息,表现出了极强的特征融合能力。

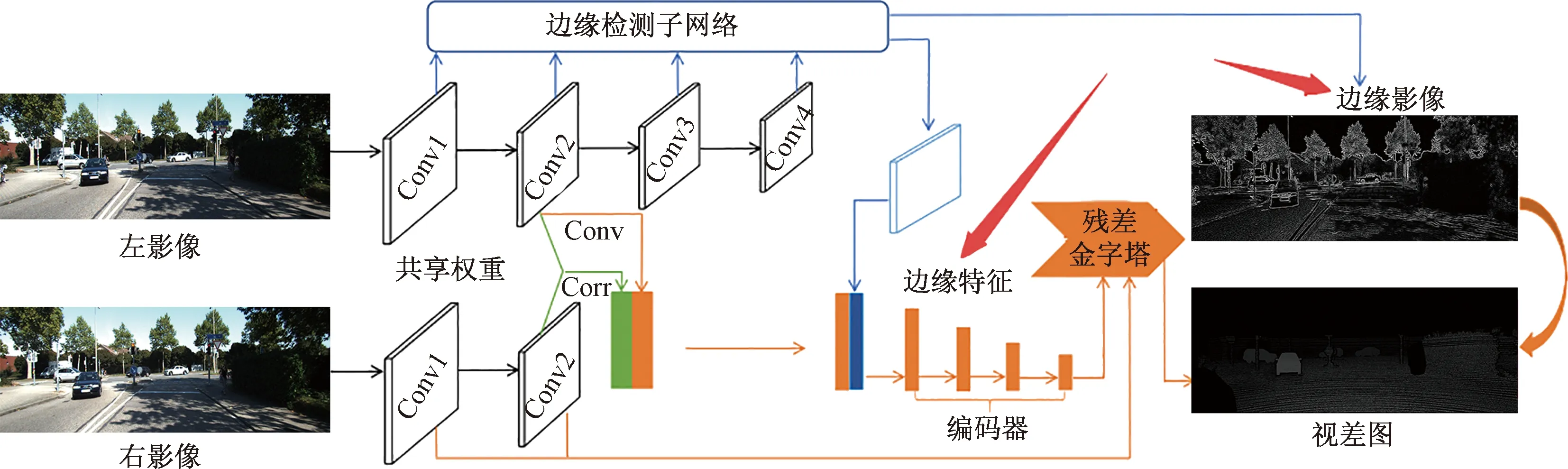

此外,Song等[47]针对密集匹配中最具有挑战性的细小结构、无纹理区域提出了对应的解决方案,即多任务学习网络EdgeStereo。该网络由视差预测和边缘检测两个子网络构成,可对视差图和边缘图进行端对端预测,如图10所示。首先使用ResNet[48]从立体声对中提取图像描述符,并通过互相关层[42]计算成本。然后,将左图像描述符、匹配的成本量和边缘特征的串联反馈到正则化模块,以残差金字塔模块回归全尺寸视差图。Jie等[49]希望将后处理步骤中单独的、手工设计的左右一致性检验加入网络模型中,以提高网络预测的正确率。针对这一问题,提出了一个LRCR(left-right comparative recurrent)模型,该模型通过学习左右一致性检验来改善视差结果。通过加入RNN结构,LRCR模型可以通过学习前一步所产生的左右视差不匹配区域来选择性地改善下一步预测结果。

图10 文献[47]所提算法流程图Fig.10 Overall flow chart of algorithm proposed by reference[47]

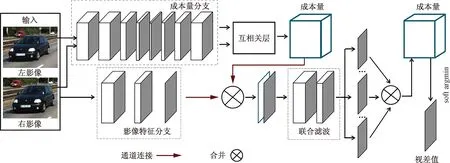

3.2 非监督型密集匹配

附带有标签的训练数据集是深度学习中最关键的环节之一,训练数据的好坏与数量对神经网络的学习效果起着至关重要的作用。在大量训练数据集的帮助下,监督学习的方式取得了较好的匹配效果。但具有真实标签的数据集制作成本较高、数量有限,不足以应对现实世界中的各项复杂环境。因此在过去几年里,Zhong等[50]、Zhou等[51]、Kuznietsov等[52]和Garg等[53]开始研究在无真实视差值参考时,神经网络模型的构建方式。

现有非监督学习方法主要围绕左右一致性检验来进行迭代学习。文献[51]提出了一种带有分支的CNN框架,用于影像密集匹配的特定学习任务。如图11所示,该网络结构包含两条分支:位于上部的分支用于匹配代价体的计算,该分支以Siamese-Network作为基础,将不含有真实视差值的左右图像作为输入,提取其图像块的特征图到Correlation layer中计算匹配代价;位于下部的分支用于获取含有颜色信息的图像特征。之后,将两部分结果进行多维数组连接操作,利用Joint Filter(联合滤波)将匹配代价与颜色信息合并,在3个卷积层处理下产生最终的匹配代价,最后使用WTA(winner take all)获取视差图。

图11 文献[51]提出的网络结构示意图Fig.11 Schematic of network structure proposed by reference[51]

如式(4)所示,在神经网络的迭代过程中,将前一次获取的左右视差图进行左右一致性检验,得到置信度图C,即

(4)

4 立体影像密集匹配评价与对比

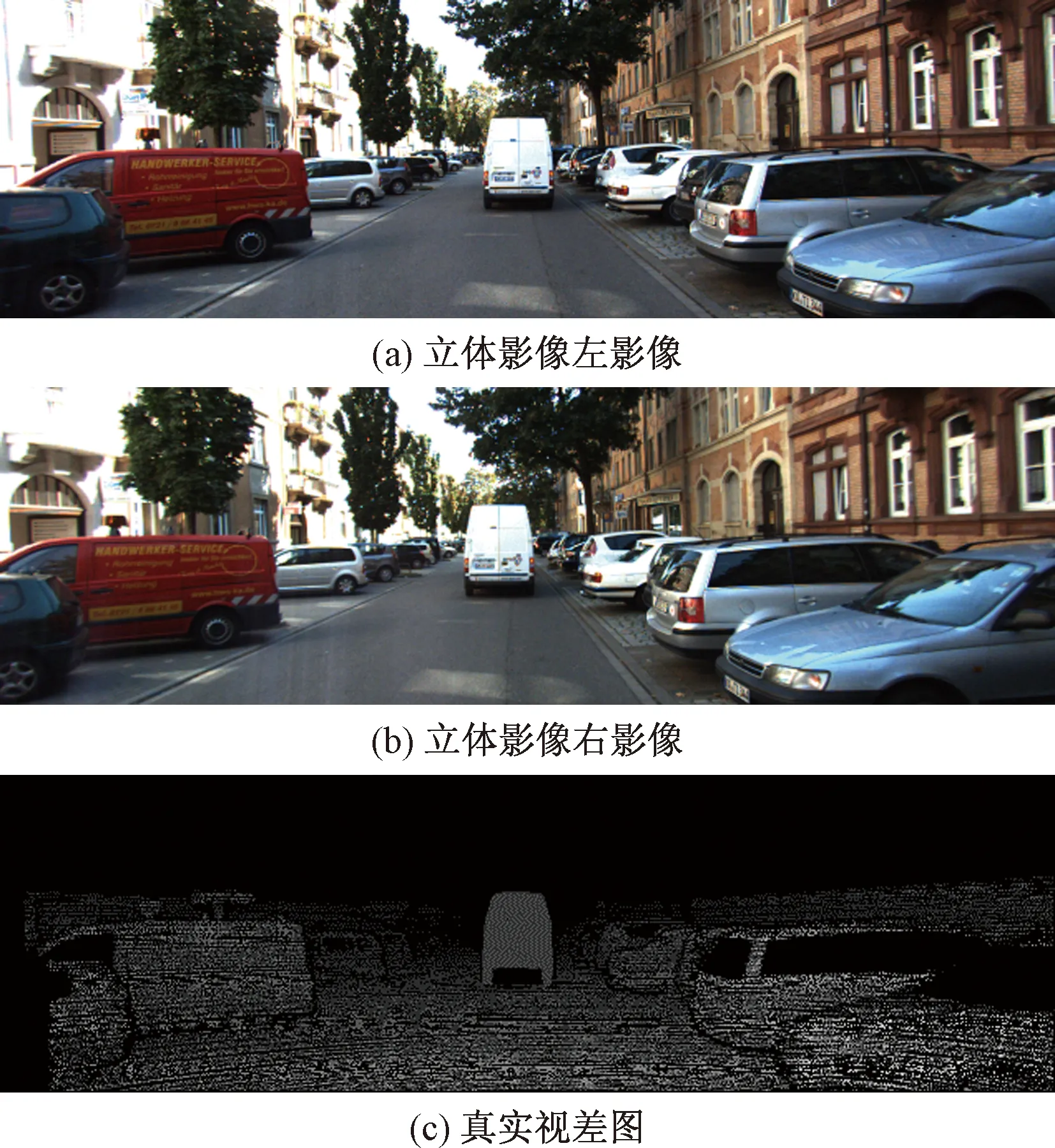

影像密集匹配主要将视差结果与真实视差值之间的差异大小及多少作为评价标准,KITTI2015数据集作为标准数据集之一,具有较为完善的评价指标及流程,被广泛用于影像匹配研究方法的优劣评定。如图12所示,KITTI2015[40]数据集为室外真实街景,由194个训练场景和195个测试场景组成,通过激光雷达等手段获取了其稀疏的真实视差值。为了更为直观地对近年来基于深度学习的密集匹配方法进行定量比较,采用EPE (end-point-error)来测量像素点真值与预测视差值之间欧氏距离的平均值。并且将EPE大于n的像素数目百分比作为n-pixel error。对于KITTI2015,通常采用EPE小于3 px或总差值的5%作为度量,计算方法如式(5)、式(6)所示:

图12 KITTI5数据集中的部分实验数据Fig.12 Part of experimental data in the KITTI5 dataset

(5)

(6)

式中:N为像素总数;n为阈值;PX表示像素;p为当前像素点;A为所有像素点的集合;d(p)、dgt(p)分别为像素点预测视差值与真值。

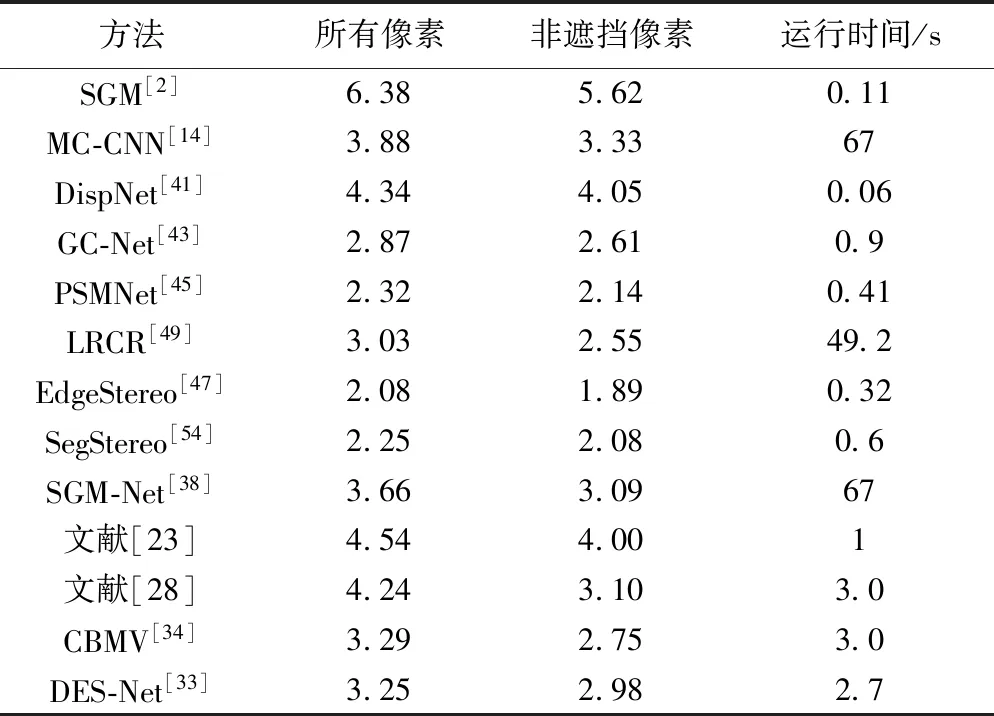

前述部分文献所提方法及传统密集匹配方法在KITTI2015数据集上的表现如表1所示。分别对测试图像对的第一帧进行评估,包括评估地面真值的所有像素及非遮挡像素两个方面,评估范围默认为所有像素。运行时间由于硬件设备不同,存在不可避免的差异。

表1 部分算法在KITTI2015基准测试数据集上的评价比较Table 1 Evaluation of selected algorithms on KITTI2015 benchmark dataset

5 结论与展望

计算机硬件与大数据的发展,使得深度学习技术愈加成熟,所应用的领域也更为广阔。通过对近年来深度学习在密集匹配上的研究进行分析,可以看出现有研究存在如下不足。

(1)一个成熟的网络模型必须具备良好的泛化能力。深度学习方法发展到今天,在密集匹配领域中已经赶超传统方法,这得益于网络模型的不断完善与训练数据的扩充。常用的具有真值的基准数据集包括KITTI[39-40]、Middlerbury[55]、ETH 3D[56]等,包括了真实街景、室内物体近景及建筑物近景。刘等[57]将多种深度神经网络模型[14,41,43]在制作好的小幅航空遥感影像数据集上进行了迁移学习与泛化能力的测试,并与传统方法、商用软件进行了比较,结果表明深度学习方法明显好于传统算法,与商用软件相比也略有优势,且具有较强的泛化能力。但现有模型对于弱纹理区域、遮挡区域的效果仍然略有不足[58]。

(2)卷积层在对预测准确率提升方面远比全连接层效果好,利用其增加神经网络的深度可以明显提升网络准确率[59]。但加深卷积神经网络会对网络的优化带来另一项难题,即长期依赖——由于变身的结构使模型失去了学习到先前信息的能力,让优化变得极其困难[60]。

根据现有阶段的方法成果来看,端到端的方式在匹配效果上要明显优于相似性度量学习的方式。并且在泛化学习和迁移学习方面,基于相似性测度的底层学习方式也明显弱于端到端的学习方式。

深度学习在密集匹配中的应用还有很长的路要走,各个领域的三维重建都面临着不同的难题。目前深度学习方法依靠电脑硬件强大的图形计算能力,获得了较为突出的成果。但随着未来应用场景的变化,在训练数据方面需加以扩充,使其更加全面。如何综合网络深度、卷积核尺寸及超参数设置,在加强网络模型学习能力的同时减少训练时间,也是未来考虑的重点之一。将深度学习低成本、高效率地应用到影像密集匹配中,并且以此进行大规模的商业化运用也是未来的研究趋势。

在自动驾驶等方面,在图像识别的基础上,实时的三维重建是最核心的技术,只有将二维影像恢复至三维场景,才能实现人与环境地交互。而密集匹配作为三维重建的核心技术,如何将其与图像识别在深度神经网络中结合,可能是计算机视觉未来的热点之一。深度学习方法的优劣很大程度上取决于现有计算机硬件的性能高低,这使得在标准数据集上表现优异的深度神经网络模型能否应用到分辨率更高、尺寸更大、图像内容更复杂的卫星遥感影像上仍然有待考究。在摄影测量领域中,随着倾斜摄影测量技术的成熟与推广,传统垂直摄影已被逐步替代。倾斜摄影多角度拍摄的影像包含更多的侧面信息,能够更加真实客观地反映被摄对象的实际情况。而目前现有深度学习密集匹配方法主要针对的都是单一的立体像对,在多图幅、多角度的航空影像三维重建中并不适用,因此这也是科研人员未来可深究的热点问题。