基于相关滤波的重检测目标跟踪算法

2020-12-01理政伍悠张建明

理政 伍悠 张建明

摘要:针对目标跟踪中因严重遮挡、变形、快速运动等因素导致的跟踪失败问题,提出一种基于相关滤波的重检测跟踪算法。首先使用相关滤波算法Staple对目标进行位置估计,然后构造一个检测滤波器对Staple算法跟踪结果进行置信度检测,将检测分数作为跟踪结果的置信度评估结果。若检测分数小于给定阈值,则激活在线SVM分类器对跟踪结果进行重检测。同时用检测滤波器对SVM分类结果进行检测,若检测分数大于Staple跟踪算法检测分数,则采用SVM的跟踪结果。在基准数据集OTB-2013上的实验结果表明,该算法精度达到80.2%,成功率达到60.6%,整体性能优于其它6种对比算法。

关键词:目标跟踪;相关滤波;重检测;检测滤波器;置信度评估

DOI:10. 11907/rjdk. 192813

中图分类号:TP312文献标识码:A 文章编号:1672-7800(2020)010-0055-06

Abstract: In order to avoid tracking failure caused by severe occlusion, deformation, fast motion and other factors in object tracking, a re-detection tracking algorithm based on correlation filter is proposed. Firstly, we use the correlation filter algorithm Staple to estimate the target position, and then a detection filter is constructed to run to confidence test of the tracking results of the Staple algorithm. The detection score of the detection filter is used as the confidence evaluation of the tracking results. If the detection score is less than the given threshold, the online SVM classifier is activated to detect the tracking results again. For SVM classification results, we use a detection filter to make detection. If the detection score is greater than the detection score of the Staple, we employ SVM tracking results. Experimental results on the dataset OTB-2013 show that the proposed algorithm achieves an accuracy of 80.2% and a success rate of 60.6%, and the overall performance is better than the other six compared algorithms.

Key Words: object tracking; correlation filter; re-detection; detection filter; confidence evaluation

0 引言

視觉目标跟踪是计算机视觉领域一个发展迅速的研究方向,在机器人、视频监视、人机交互等方面有着广泛应用[1-3]。目标跟踪通常是指在给定初始状态(位置和大小)下,估计目标在图像序列中的空间轨迹。但由于受到遮挡、变形、光照变化、快速运动和背景杂波等因素影响,在多帧背景下寻找相应目标区域仍是一个具有挑战性的问题。

根据目标外观建模的不同,跟踪方法可分为生成式方法[4-6]和判别式方法[7-9]。生成式跟踪方法通常在忽略背景信息的基础上对目标外观进行建模,容易在复杂场景中漂移,而判别式跟踪方法则将跟踪任务当作一个二分类目标,将目标与周围背景区分开来。相关滤波算法是典型的判别式跟踪算法,基于相关滤波的跟踪算法通过使用循环矩阵和快速傅立叶变换实现了高效率的计算,近年来已在多个跟踪数据集[10-12]上显示了较高的准确性和鲁棒性。

Bolme等[13]最先将相关滤波应用于目标跟踪中,并提出MOSSE算法。随后,研究者们对MOSSE算法进行了改进。2012年,Henriques等[14]提出具有循环结构的检测跟踪 (Circulant Structure of Tracking-by-detection with Kernel,CSK)算法,其在MOSSE基础上引入核方法,并利用相邻子窗口的循环结构,快速学习密集采样下的目标外观模型。核相关滤波器(High-speed Tracking with Kernelized Correlation Filters, KCF)[15]是CSK的扩展版本,通过使用HOG特征代替灰度特征,将核相关滤波器由单通道扩展到多通道,显著提升了跟踪性能;Danelljan等[16-17]引入颜色属性对CSK算法进行改进,又提出一种判别尺度空间跟踪器算法,以实现实时尺度自适应跟踪;Bertineto等[18]提出Staple (Sum of Template And Pixel-wise Learners)算法,将相关滤波器与全局颜色直方图相结合,对目标形变和颜色变化具有较好的鲁棒性。尽管基于相关滤波的方法取得了一定成果,但仍存在以下问题:基于相关滤波的跟踪器一般会在第一帧提取样本,训练一个滤波器模型,为了适应目标的外观变化,会在上一帧预测目标周围提取样本对滤波器模型进行更新,但在实际跟踪过程中,目标受到快速运动、变形、严重遮挡等因素影响,很容易发生跟踪漂移。如果跟踪漂移无法得到及时纠正,将会污染滤波器模型,从而导致跟踪失败。针对该问题,Kalal等[19]将跟踪任务分成跟踪、学习和检测3个模块。跟踪模块用于跟踪目标;检测模块用于估计跟踪模块误差,若误差很大,则改正跟踪结果;学习模块在预测过程中不断修正负样本库,以提高检测模块修正精度。但该方法每一帧都需要检测跟踪结果,计算量太大。

因此,针对相关滤波框架发生跟踪漂移无法纠正的问题,本文在相关滤波算法Staple基础上引入重检测机制。首先重新训练一个检测滤波器用来计算跟踪结果置信度,以确定是否跟踪失败,然后训练一个在线SVM分类器用于重检测,当出现跟踪漂移或跟踪失败的情况时,利用SVM重新修正跟踪目标。在基准数据集OTB-2013上的实验结果表明,本文算法在精度和成功率上优于其它算法。

1 Staple跟踪算法

KCF[15]、DSST[17]等相关滤波算法采用HOG特征表达目标,其对运动模糊和光照变化鲁棒性强,但对目标快速变形和快速运动不敏感。Staple算法根据颜色直方图对目标形变具有鲁棒性的特点,将HOG特征与颜色直方图相结合,利用两种特征的互补性取得了较高的跟踪精度,速度也达到80fps,所以本文选择Staple作为基础的相关滤波算法。Staple算法解决了两个岭回归(ridge regression)问题,分别训练两个跟踪模型,一个是相关滤波器模型,另一个是颜色直方图(color histogram)模型。Staple算法最后得到结果是两个模型分数的线性组合,具体表达式如下:

1.1 相关滤波器模型

在Staple中,提取包含目标及周围信息的图像块[f],通过对图像块进行循环移位得到训练样本,然后提取训练样本的d维HOG特征训练相关滤波器[h]。[fl]代表第[l]维HOG特征向量,其中[l∈1,2,...,d]。通过最小化以下损失函数求得最优滤波器[h]:

通过傅里叶变换将式(2)转换到频域进行计算,可快速求得式(2)的解,如式(3)所示。

每一帧通过最小化损失函数误差训练一个最优滤波器,会导致计算量较大,从而影响跟踪器速度。在相关滤波器算法中,采用线性差值方式更新每一帧的滤波器,计算方式如下:

目标位置由最大分数所在位置决定。

1.2 颜色直方图模型

颜色直方图模型是通过计算每个像素属于目标前景的概率得到的。給定输入图像[I],[HIO]、[HIB]分别表示前景区域和背景区域的颜色直方图,[HIΩ(b)][HIΩ(b)]表示区域[Ω∈I]上的颜色直方图[H]在第[b]个区间的统计个数,其中[Ω∈{O,B}]。由贝叶斯分类器[20]可得在像素[x]的目标似然概率为:

通过计算颜色直方图可得到前景先验概率[P(x∈O|I)]和背景先验概率[P(x∈B|I)],如式(7)、式(8)所示。

2 本文算法实现

2.1 算法描述

图1给出了本文算法总框架。给定新一帧图像,以上一帧估计的位置为中心裁剪搜索区域,即图1的红色矩形框区域;然后使用Staple算法预测目标位置,详细过程见本文第1节;以Staple跟踪算法估计的目标位置为中心,按照上一帧中的目标大小比例裁剪图像块,使用检测滤波器[HD]计算图像块的置信度分数[yHD],详细过程见2.2节。当置信度分数小于阈值[T1]时,激活SVM分类器,在Staple算法预估的位置重新进行检测,SVM分数最大的地方就是目标所在位置;在获得检测结果后,也重新使用检测滤波器[HD]对SVM分类器结果作一个置信度评估,如果检测出的置信度分数[y''HD>yHD],则采用SVM重检测结果,否则还是采用Staple算法跟踪结果,详细过程见2.3节。

2.2 置信度评估

对目标重检测算法而言,提供一个有效的置信度指标判断目标是否跟踪失败是至关重要的。与以往相关滤波算法使用最大响应值评估跟踪置信度不同,本文方法通过训练另一个检测滤波器评估跟踪结果。在相关滤波跟踪算法中,包括第1.1节中的滤波器模型H,在训练时都会考虑目标区域与目标周围的上下文信息,如图2中的红色矩形框区域,从而使训练得到的滤波器包含更多判别信息,有利于从背景中检测出目标。为了适应跟踪过程中目标外观的变化,滤波器模型还会以一定速率进行更新,但这种更新方案只能维持目标外观的短期记忆。当目标出现遮挡或剧烈形变时,算法容易产生漂移,使得滤波器学习到污染后的样本导致错误更新。本文检测滤波器[HD]是用置信度最高的目标区域特征训练得到的,如图2中的黄色矩形框区域。当跟踪器确定新一帧目标位置后,从新的目标位置处提取核心目标区域特征,使用训练好的检测滤波器与提取的特征作卷积操作,将其响应作为跟踪器的结果置信度。检测滤波器[HD]与滤波器H求解方式相同,不同的是检测滤波器只提取目标核心区域的HOG特征。

为防止检测滤波器污染,本文并不是每一帧都更新检测滤波器[HD],而是仅在跟踪结果可信,即检测滤波器响应分数[yHD>T2]时更新,从而使检测滤波器可以长期存储目标外观。

2.3 目标重检测

在大多数时间,视频帧都是跟踪难度较低的简单帧,且相邻视频帧之间目标外观变化缓慢。相关滤波算法Staple针对目标外观变化不大的简单帧可以有效定位,但当目标出现遮挡、快速运动、严重变形、背景杂乱等外观发生较大变化时,Staple算法则会出现预测误差。在误差不断积累时,跟踪器将会跟丢目标。一个鲁棒性强的跟踪算法需要重检测机制恢复对目标的跟踪,本文使用一个SVM分类器用于目标重检测。

对于需要进行重检测的帧,首先在目标周围提取样本,利用训练好的SVM分类器模型参数[wSVM]获取分类分数[score],公式如下:

在本文方法中,对新一帧先使用Staple算法确定目标位置,然后用检测滤波器[HD]计算置信度分数[yHD],计算方式如式(5)所示。当置信度分数[yHD]小于预先定义的阈值[T1]时,调用一个在线SVM分类器进行重检测。值得注意的是,在得到重检测的位置后,本文会重新作一个置信度评估,用检测滤波器对SVM分类器得到的位置进行检测,当得到的响应分数[y''HD]大于[yHD]时,才采用重检测得到的位置,否则还是采用Staple算法预测的位置。以下为基于相关滤波的重检测跟踪算法流程。

输入:第一帧目标位置p0。

输出:第t帧目标位置pt 。

For t = 2: n

目标位置估计

1. 在pt-1周围裁剪获得第t帧的感兴趣区域,分别用式(5)、式(9)计算滤波器响应和颜色直方图响应分数。

2. 使用式(1)计算滤波器响应和颜色直方图响应分数加权和,预估目标位置[pt]。

置信度评估

3.在预估位置裁剪目标大小的图像块,使用检测滤波器[HD],根据式(5)计算置信度响应分数[yHD]。

目标重检测

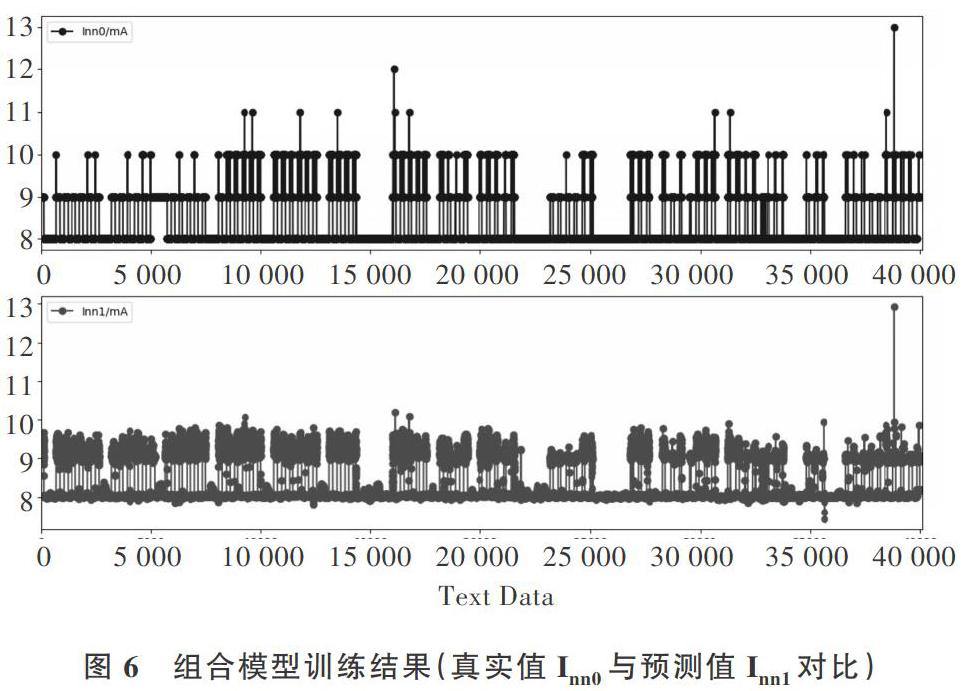

4.如果[yHD 5. 在SVM预估位置裁剪目标大小的图像块,使用检测滤波器[HD],根据式(5)计算图像块的置信度响应分数[y''HD]。 6. 如果[y''HD>yHD],采用SVM预测的目标位置。 模型(滤波器)更新 7.根据式(4)更新滤波器[H]。 8. 如果[yHD>T2],根据式(4)更新检测滤波器[HD]。 END 3 实验与结果分析 3.1 实验环境及参数设置 本实验软件平台为Matlab R2017a,硬件运行环境配置为Intel (R) Core (TM) i7-6700K 4.00 GHz CPU。本文使用的基准数据集是OTB-2013,包含51个挑战视频。视频中主要包括11种场景挑战属性:光照变化(IV)、尺度变化(SV)、遮挡(OCC)、形变(DEF)、运动模糊(MB)、快速运动(FM)、平面内旋转(IPR)、平面外旋转(OPR)、低分辨率(LR)、出视野(OV)、背景杂乱(BC)。使用成功率(Success rate)和精度(Precision)两个评价指标,给定预测框[b1]和真实框[b2],成功率为当[b1?b0b1?b0>0.5]时帧数占总帧数的百分比,精度为估计中心位置误差小于给定距离阈值(例如20个像素)的帧数占总帧数的百分比。 设置学习率[η]为0.025,正则化参数[λ]为0.001,参数[γ]为0.7。由于选择不同阈值会影响实验效果,为了选择合适的阈值[T1]和[T2],本文通过实验进行探索。首先确定阈值[T1]、[T2]的大致区间,然后代入区间阈值,比较其实验结果,最后选出使实验效果最好的阈值。在本文方法中,并不是每一帧都会调用SVM作重检测,而是当置信度分数[yHD 3.2 定量分析 本文在OTB-2013数据集上与其它6种算法进行对比,结果如图3所示。其它6种算法包括Staple[18]、DSST[17]、TLD[19]、KCF[15]、MIL[8]、CSK[14],本文算法在所有對比算法中取得了最好成绩,精度达到80.2%,成功率达到60.6%。相比Staple算法,精度与成功率分别提高了1.7%和1.3%,说明本文提出的重检测机制是有效的。 3.3 属性分析 为了更充分地评估本文算法的跟踪性能,利用数据集OTB-2013的11个挑战属性对算法作进一步评估。图4是本文算法与其它6种算法针对11个不同挑战属性的精度图。本文算法在平面外旋转、遮挡、形变、运动模糊、快速运动、平面内旋转、背景杂乱等7个挑战属性上都排名第一,在低分辨率上仅次于Staple算法,排名第二。通过定量分析及挑战属性对比,本文算法相对其它算法具有更高的准确性。 3.4 定性分析 本文算法与其它4个优秀的跟踪器(Staple[18]、TLD[19]、MIL[8]和CSK[14])在5个具有挑战性的序列上进行比较,如图5所示。coke序列包含光照变化、平面内旋转,前期各算法都能成功跟踪,到后期出现光照变化和平面内旋转时,MIL跟踪失败。在jogging序列的第77帧与soccer序列的第106帧,目标都发生了遮挡,Staple算法与本文算法都跟踪失败,但在jogging序列的第124帧与soccer序列的第126帧,Staple算法跟丢目标后未能重新跟踪,而本文算法又再次成功跟踪了目标,这得益于本文提出的重检测机制。在跟踪失败的情况下,TLD算法也能够重新检测目标,但TLD方法无法像本文方法那样充分利用目标的上下文信息,因此在面对如skating视频中明显变形和快速运动的目标时表现不佳。CSK也是基于相关滤波的算法,其在singer视频上表现不太理想,原因是CSK仅使用了灰度特征,对目标缺乏表达能力。 4 结语 本文在相关滤波算法Staple的基础上加入重检测机制。首先使用Staple算法用于目标跟踪,然后重新构造一个检测滤波器用于跟踪结果的置信度评估。当置信度较低时,调用一个在线SVM分类器进行目标重检测,提高了算法精度。为避免检测滤波器被污染,只有在目标具有高置信度的情况下才更新检测滤波器。最后在基准数据集OTB-2013上进行实验,实验结果表明,该算法在准确性和鲁棒性方面均优于其它6种对比算法。 参考文献: [1] 卢湖川,李佩霞,王栋. 目标跟踪算法综述[J]. 模式识别与人工智能,2018,31(1):61-76. [2] 黄凯奇, 陈晓棠, 康运锋,等. 智能视频监控技术综述[J]. 计算机学报, 2015, 20(6):1093-1118. [3] WANG N, SHI J, YEUNG D Y, et al. Understanding and diagnosing visual tracking systems[C]. IEEE International Conference on Computer Vision, 2015: 3101-3109. [4] SUI Y, ZHANG S, ZHANG L. Robust visual tracking via sparsity-induced subspace learning[J]. IEEE Transactions on Image Processing, 2015, 24(12):4686-4700. [5] ZHANG T, BIBI A, GHANEM B. In defense of sparse tracking: circulant sparse tracker [C]. IEEE Conference on Computer Vision and Pattern Recognition, 2016:3880-3888. [6] SUI Y, WANG G, TANG Y, et al. Tracking completion[C]. European Conference on Computer Vision, 2016:194-209. [7] NING J, YANG J, JIANG S, et al. Object tracking via dual linear structured SVM and explicit feature map[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2016: 4266-4274. [8] BABENKO B, YANG M H, BELONGIE S. Robust object tracking with online multiple instance learning[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(8):1619-1632. [9] SUN H, LI J, CHANG J, et al. Efficient compressive sensing tracking via mixed classifier decision [J]. Science China Information Sciences, 2016, 59(7):072102. [10] WU Y, LIM J, YANG M H. Online object tracking: a benchmark [C]. IEEE Conference on Computer Vision and Pattern Recognition, 2013: 2411-2418. [11] WU Y, LIM J, YANG M H. Object tracking benchmark [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848. [12] KRISTAN M, MATAS J, LEONARDIS A, et al. The visual object tracking VOT2016 challenge results [C]. Amsterdam, 14th European Conference on Computer Vision, 2016: 777-823. [13] BOLME D S, BEVERIDGE J R, DRAPER B A, et al. Visual object tracking using adaptive correlation filters [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2010: 2544-2550. [14] HENRIQUES J F, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels [C]. Proceedings of the European Conference on Computer Vision, 2012: 702-715. [15] HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596. [16] DANELLJAN M, SHAHBAZ KHAN F, FELSBERG M, et al. Adaptive color attributes for real-time visual tracking [C]. IEEE Conference on Computer Vision and Pattern Recognition, 2014: 1090-1097. [17] DANELLJAN M, H?GER G, KHAN F, et al. Accurate scale estimation for robust visual tracking [C]. British Machine Vision Conference, 2014: 1-5. [18] BERTINETTO L, VALMADRE J, GOLODETZ S, et al. Staple: complementary learners for real-time tracking [C]. IEEE Conference on Computer Vision and Pattern Recognition, 2016: 1401-1409. [19] KALAL Z, MIKOLAJCZYK K, MATAS J. Tracking-learning-detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(7): 1409-1422. [20] POSSEGGER H, MAUTHNER T, BISCHOF H. In defense of color-based model-free tracking[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2015: 2113-2120. (責任编辑:黄 健)