基于红外与可见光图像融合的交通标志检测

2020-08-04李舒涵许宏科武治宇

李舒涵 许宏科 武治宇

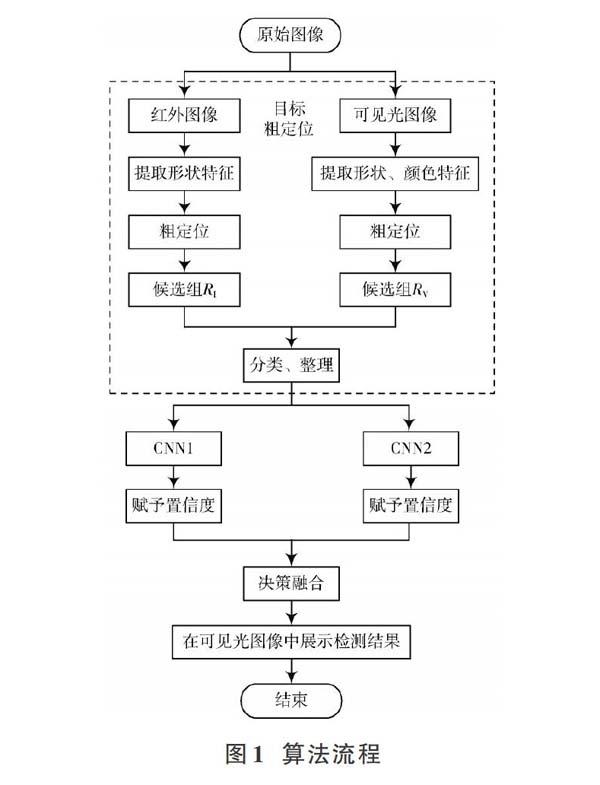

摘 要: 针对大多数交通标志检测方法易受光照和天气影响的问题,提出一种基于红外与可见光融合的交通标志检测方法。首先,分别在红外与可见光图像中提取交通标志的形状和颜色特征,对目标进行粗定位,并将结果放入候选组内进行分类与整理;然后,将候选组放入卷积神经网络,对粗定位结果赋予相应的置信度;最后,根据置信度对红外与可见光的粗定位结果进行决策融合,并将融合结果展示在可见光图像中。实验结果表明,该算法对检测环境的变化更加鲁棒,在白天、夜晚和不良天气等多种环境下有效地提高了检测效率,具有良好的适用范围。

关键词: 交通标志检测; 图像融合; 目标粗定位; 卷积神经网络; 定位结果分类; 红外图像; 可见光图像

中图分类号: TN911.73?34 文献标识码: A 文章编号: 1004?373X(2020)03?0045?05

Traffic sign detection based on infrared and visible image fusion

LI Shuhan1, XU Hongke1, WU Zhiyu2

(1. School of Electronic & Control Engineering, Changan University, Xian 710064, China;

2. School of Mechanical?Electrical Engineering, Xidian University, Xian 710071, China)

Abstract: A traffic sign detection method based on infrared and visible image fusion is proposed to deal with the fact that the traffic sign detection is susceptible to light and weather. In the method, the shape and color features of traffic signs are extracted from infrared and visible images respectively to roughly locate the targets, and the results are put into the candidate groups for classification and sorting. Then the candidate groups are placed in the convolutional neural network to give corresponding confidence to the rough positioning results. Finally, the rough positioning results from infrared and visible light images are fused according to the confidence, and the fused results are displayed in visible images. The experimental results show that the proposed method is more robust to the change of detection environment, effectively improves the detection efficiency in various environments such as daytime, night and adverse weather conditions. Therefore, the application scope of the proposed method is wide.

Keywords: traffic sign detection; image fusion; target rough positioning; convolutional neural network; positioning result classification; infrared image; visible image

0 引 言

交通标志识别系统(Traffic Sign Recognition,TSR)作为先進辅助驾驶系统(Advanced Driver Assistance Systems,ADAS)的重要组成部分[1],能够为驾驶员提供实时的道路信息,为司乘人员提供行车安全保障。交通标志识别系统通常分为检测和识别两个部分,精准的检测能为后续的识别、辅助定位与导航提供有效保障[2],因而标志检测一直是交通标志识别系统的重点。

由于大部分的交通标志都被设立在户外环境中,标志检测容易受到天气、光照、能见度等因素的影响。现有的检测方法,如基于颜色与形状特征的检测算法[3?6]和基于深度学习的特征提取检测算法[7?8],在光照变化剧烈或能见度低的条件下,鲁棒性较差,检测准确率较低。为了解决上述问题,本文利用红外图像不易受环境影响的特性,提出一种红外与可见光图像融合检测的方法。

仅利用可见光图像在户外进行目标检测不能有效应对天气和光照的变化[9],因此,红外与可见光图像的融合检测被广泛应用于目标检测领域。文献[10]通过分析图像滑窗稀疏系数的特点,提出一种基于稀疏向量的融合算法;文献[11]提出了一种通过主成分分析和小波变换的融合算法;文献[12]提出了一种基于频域分割及轮廓滤波的融合算法,较好地保留了源图像中的边缘和细节信息;文献[13]提出了多线索的目标跟踪算法,通过融合提取更加鲁棒的目标特征;文献[14]根据稀疏系数得到源图像的全局和局部显著图,提出一种显著图的融合算法;文献[15]提出一种基于显著性检测和双尺度图像分解的融合算法,提高了检测的实时性。

本文提出了一种基于深度学习的决策融合算法,先在红外与可见光图像中进行交通标志的粗定位,然后利用卷积神经网络对粗定位结果赋予置信度,并对赋予置信度的结果进行决策融合,最终将目标融合检测的结果展示在可见光图像序列中。

1 交通标志粗定位

交通标志通常用不同的颜色和形状来代表不同的指示功能,为了使交通标志与背景环境明显区分,大多数标志都采用强烈的色彩,如红、黄、蓝,以及容易辨别的形状,如矩形、圆形、三角形。同时,红外图像能在光照变化或能见度低等不利自然条件下稳定成像,如雨雾天气、傍晚光线昏暗或逆光等场景,但缺乏可见光图像所具有的色彩和质地等细节信息。因此,根据交通标志、红外与可见光图像的特点,本文在红外与可见光图像中进行目标粗定位,为后续的卷积神经网络识别及决策融合做准备。算法流程如图1所示。

1.1 红外图像下的粗定位

红外图像属于单通道图像,在红外图像中呈现的物体会丢失颜色信息,但红外图像具有局部稳定特性,能为特征描述算子搭建良好的应用平台。同时,特征描述算子能够充分地反映特征点附近的形状和纹理结构。因此,红外图像下的特征描述算子具有良好的适用性和鲁棒性。

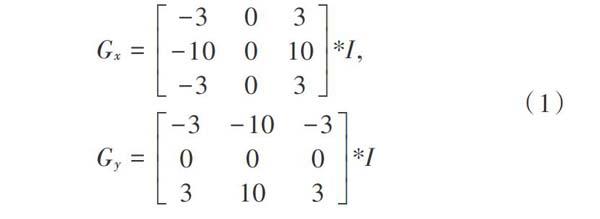

Sobel算子在进行边缘检测时的效率较高,但只能够较好地处理沿[x]轴和[y]轴排列的轮廓,在处理其他角度的轮廓时效果不佳,因此采用对其改进的Scharr滤波器进行边缘检测。Scharr滤波器能够增加多个角度的边缘特征。

Scharr滤波器通过计算灰度函数的近似梯度来求出目标的边缘轮廓。首先,对输入图像[I=(x,y)]分别在[x]和[y]方向上做卷积运算,计算公式为:

式中:[Gx]为横向梯度分量;[Gy]为纵向梯度分量。

然后计算像素点的近似梯度:

如果近似梯度大于某一阈值,则认为该点为边缘点。

在Sobel算子检测效果图中,部分轮廓特征不完整容易导致漏检,而Scharr滤波器对边缘特征的检测效果足以满足后续的形状特征提取,效果对比如图2所示。

将Scharr滤波器处理后的边缘特征图像针对圆形、三角形、矩形进行形状检测,并使用矩形框对形状检测结果进行标注。同时,通过设定检测框周长的阈值过滤较小的干扰物,从而完成红外图像下的交通标志粗定位。

1.2 可见光图像下的粗定位

在可见光图像下,交通标志的颜色特征较为明显,因此本文通过提取交通标志牌的颜色特征进行目标检测。

RGB空间的[R],[G],[B]分量间存在复杂的联系且易受光照变化的影响。而交通标志大多数设立于户外,同一颜色的标志在不同光照下有较大差别,如图3所示。由于HSI颜色空间中的色调(Hue)和饱和度(Saturation)分量独立于亮度(Intensity)分量,能够较好地排除光照和天气对颜色分割的干扰,因此本文将图像由RGB颜色空间转换到HSI颜色空间进行颜色特征的提取。

为了使颜色特征模型能够适应更加复杂的背景环境,采集并建立了不同环境中红、黄、蓝三种颜色的交通标志库,分别对三种颜色的色调H和饱和度S标准化至[[0,1]]进行统计,如图4所示。

根据统计结果确定色调与饱和度的阈值区间,并进行感兴趣区域的提取,具体步骤如下:

其中,[I (i,j)]為坐标[ (i,j)]处的像素点;[H(i,j)]和[ S(i,j)]分别为[I (i,j)]处的色调与饱和度;[Hi(i=1,2,…,6)]为各颜色的色度阈值;[Si(i=1,2,3)]为各颜色的饱和度阈值;[ D]为目标框的面积;[ d]为目标框阈值;[red(i,j)]为红色感兴趣点;[yellow(i,j)]为黄色感兴趣点;[blue(i,j)]为蓝色感兴趣点。

通过将感兴趣点[red(i,j)],[yellow(i,j)],[blue(i,j)]的值置为255,其余像素点置为0的方式对图像进行二值化,并利用形态学滤波清除噪声及干扰物,从而完成颜色特征的提取。

基于颜色特征的目标检测容易受到背景环境的影响,在存在与目标颜色相同的物体时容易导致误判。因此在可见光图像下采取颜色与形状特征提取相结合的方式进行目标粗定位,形状特征的提取方式与红外图像相同。

最后使用矩形框对检测结果进行标注。与红外图像下的粗定位相同,通过设定检测框周长的下阈值过滤较小的干扰物,完成可见光图像中的交通标志粗定位。

1.3 候选信息分类

红外与可见光粗定位输出的检测结果用矩形框在图像中标出,矩形框拥有[Point(x,y),width,height]三项参数。其中,[Point(x,y)]为矩形框的中心坐标,[width]为矩形框的宽度,[height]为矩形框的高度。

将在红外图像中得到的矩形框参数放入候选组,可见光图像中得到的参数放入候选组。由于粗定位是分别在红外与可见光图像中进行的,难以区分候选组[RI]与候选组[RV]内的信息是否为同一目标,因此需要对候选信息进行分类。

对[RI]的信息逐一进行提取(分别提取每一个检测框的参数),并分别与[RV]中的信息进行计算与比较,从而判别两个矩形框是否检测的是同一目标物。若检测的是相同目标,则分别将两个检测框标记为1,反之,则标记为0。对[RI]的信息再次进行提取时,仅与[RV]中标记为0或未被标记的信息进行判別。最后,为保证全部粗定位结果都会经过卷积神经网络,需要在[RI]中补充[RV=0]的信息,在[RV]中补充[RI=0]的信息。最后,根据检测框的坐标对[RI]和[RV]的信息进行排序,得到新的候选组

设[RiI]为[RI]的第[i]个信息,[RjV]为[RV]的第[j]个信息。本文采用欧氏距离和矩形框的面积比对候选组的信息进行分类,具体步骤如下。

首先,根据检测框的中心坐标,计算[RiI]和[RjV]的欧氏距离[ρIVij]:

式中:[(XIi,YIi)]为[RiI]的中心坐标参数;[(XVj,YVj)]为[RjV]的中心坐标参数。

计算[RiI]和[RjV]的面积比[Sij]:

通过设定[ρIVij]和[Sij]的阈值,对[RiI]和[RjV]进行标记:

式中:[A=Min{RIi?width,RIi?height,RVj?width,RVj?height}]为[ρIVij]的阈值;经过多次实验,[Sij]的下阈值[B1]设定为0.75,上阈值[B2]设定为1.25。

2 红外与可见光融合检测方法

2.1 基于CNN的粗定位置信度计算

整理完的候选区内仍潜在误判的区域,因此采用CNN对候选区内的图像进行识别,尽可能剔除不存在交通标志的区域以提高检测的准确率。

在选择CNN网络模型框架之前,需要对交通标志的特征进行建模分析。由于交通标志的特征较为单一,形状颜色有一定规则,因此选用EdLeNet网络架构,这种浅层的网络结构能够很好地处理简单图像特征。此外,浅层的CNN网络能够提高分类的实时性,降低卷积运算量。本文分别对红外样本和可见光样本进行预训练,得到两个卷积神经网络CNN1和CNN2。

以可见光模型为例,训练好的CNN结构如图5所示。将EdLeNet网络输入灰度图像的尺寸统一缩放为[32×32],通过三层卷积层、三层池化层以及两层全连接层,用SoftMax作为输出层给出最终的结果。在第一层卷积层采用[3×3]的卷积核,深度为32,步长为1,选用ReLU函数作为激活函数,然后使用尺寸为[2×2]的下采样滤波器对特征进行下采样,步长为1。之后的两层卷积层除了将卷积核的深度依次乘2倍加深以外,其余的参数并未做出改变。除此之外,用两层全连接层对所有的特征重新进行拟合,由最后的SoftMax函数输出层给出分类置信度。

2.2 红外与可见光决策融合

单纯在红外与可见光图像中进行目标检测,并不能保证检测结果具有很高的准确性。考虑到红外与可见光图像的互补性,运用决策融合算法对红外与可见光两个候选区内的检测结果进行选择。

3 实验结果与分析

3.1 实验数据集

本文分别利用红外相机与可见光相机采集用于训练CNN的交通标志样本,其中,红外图像2 141个,可见光图像2 317个,部分数据集样本如图6所示。

同时,用于预训练CNN的输入图像需要进行预处理,具体步骤如下:

1) 图像尺寸的调整,将输入的ROI区域统一缩放为[32×32]。

2) 对图像进行归一化处理,确定图像数据集分布的中心,从而提高CNN网络模型在处理图像时的一致性。

3) 针对可见光图像样本需要进行灰度化处理为单通道图像,能够极大减少数据运算量,提高系统的实时性。

其余测试样本分别用红外与可见光相机同时进行拍摄,在白天和夜间分别采集了红外和可见光图像(图像已配准)共500张,采集数据时间分为两个时段,分别为11:00—13:00和19:00—21:00。

3.2 实验过程与结果

1) 分别在红外与可见光图像中对交通标志进行粗定位,并将粗定位结果放入候选组[RI]和候选组[RV]。

2) 根据粗定位的坐标与面积参数对[RI]和[RV]的信息进行分类。

3) 将分类后的[RI]和[RV]分别放入训练好的CNN1和CNN2模型中,对粗定位的结果赋予置信度。

4) 对赋予置信度后的红外与可见光粗定位结果进行决策融合,在可见光图像中给出检测结果。

该算法在复杂背景、黄昏、夜晚和雾天场景的处理结果如图7所示。

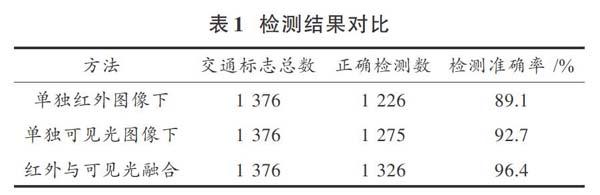

自然场景中的交通标志极易受到环境影响,例如,在雨雾天气时可见光相机拍摄的图像对比度会降低,但保留了场景的颜色和细节信息,而红外相机能较稳定地对场景进行采集,但不能完整反映真实的场景。因此,利用红外与可见光图像融合检测能够较好地适应户外环境的改变,提高检测准确率。为比较融合算法的检测效果,分别对单独的红外、可见光图像下检测结果与融合算法的结果进行对比,如表1所示。其中,测试样本包括白天、夜晚和雨雾天气等多个场景。

4 结 论

本文将红外与可见光图像下的交通标志检测结果相结合,提出了一种基于卷积神经网络的决策融合算法。实验结果表明,红外与可见光融合检测能够很好地适应环境的变化,能够在交通标志牌的检测中充分利用多种图像特征的互补性,因此可以应用于多种有针对性场景的交通标志牌检测。

本文主要通过交通标志的颜色和形状信息进行粗定位,并没有对粗定位结果进一步进行筛选,有较多的误判信息被采集到候选区内,由于卷积神经网络需要对每一个候选信息进行识别,因此粗定位结果在一定程度上会影响算法的效率。对候选区信息进行筛选,以提高算法效率是值得进一步研究的方向。另外,本文未对检测到的交通标志进行识别,这也是今后的研究内容。

参考文献

[1] ZAKLOUTA F, STANCIULESCU B. Real?time traffic sign recognition in three stages [J]. Robotics & autonomous systems, 2014, 62(1): 16?24.

[2] 葛园园,许有疆,赵帅,等.自动驾驶场景下小且密集的交通标志检测[J].智能系统学报,2018,13(3):366?372.

[3] ZHANG M, LIANG H, WANG Z, et al. Real?time traffic sign detection and recognition for intelligent vehicle [C]// 2014 IEEE International Conference on Mechatronics and Automation. Tianjin, China: IEEE, 2014: 1125?1131.

[4] 贾永红,胡志雄,周明婷,等.自然场景下三角形交通标志的检测与识别[J].应用科学学报,2014,32(4):423?426.

[5] 常发亮,黄翠,刘成云,等.基于高斯颜色模型和SVM的交通标志检测[J].仪器仪表学报,2014,35(1):43?49.

[6] SALTI S, PETRELLI A, TOMBARI F, et al. Traffic sign detection via interest region extraction [J]. Pattern recognition, 2015, 48(4): 1039?1049.

[7] YANG Y, LUO H, XU H, et al. Towards real?time traffic sign detection and classification [J]. IEEE transactions on intelligent transportation systems, 2016, 17(7): 2022?2031.

[8] 刘占文,赵祥模,李强,等.基于图模型与卷积神经网络的交通标志识别方法[J].交通运输工程学报,2016,16(5):122?131.

[9] FENDRI E, BOUKHRISS R R, HAMMAMI M. Fusion of thermal infrared and visible spectra for robust moving object detection [J]. Pattern analysis & applications, 2017, 20(10): 1?20.

[10] 张生伟,李伟,赵雪景.一种基于稀疏表示的可见光与红外图像融合方法[J].电光与控制,2017,24(6):47?52.

[11] NAIDU V P S, RAOL J R. Pixel?level image fusion using wavelets and principal component analysis [J]. Defence science journal, 2008, 58(3): 338?352.

[12] 蔡怀宇,卓励然,朱攀,等.基于非下采样轮廓波变换和直觉模糊集的红外与可见光图像融合[J].光子学报,2018,47(6):225?234.

[13] LAN X, MA A J, YUEN P C, et al. Joint sparse representation and robust feature?level fusion for multi?cue visual tracking [J]. IEEE transactions on image processing, 2015, 24(12): 5826?5841.

[14] LIU C H, QI Y, DING W R. Infrared and visible image fusion method based on saliency detection in sparse domain [J]. Infrared physics & technology, 2017, 83: 94?102.

[15] BAVIRISETTI D P, DHULI R. Two?scale image fusion of visible and infrared images using saliency detection [J]. Infrared physics & technology, 2016, 76: 52?64.