基于深度学习与多特征融合的舌象诊断算法

2020-04-10邱童

摘 要:舌象诊断是临床决策中非常重要的一个环节。研究人员提出了自动化的舌象诊断方法。他们通常从图片提取舌象,然后通过特征工程或深度学习方法,提取出相关的特征并分类,取得了不错的效果。然而,使用特征工程设计舌头特征需要很大工作量,另外仅使用手工特征或深度特征,无法较好地表示舌头的特征,特别是在舌头处于非统一光源和姿态下。因此,文章首先设计了基于Faster-RCNN的检测框架对舌象进行预处理,然后使用了多特征融合的方法,对底层特征和高层语义特征进行特征融合,使用该方法来对舌象进行分类。结果表明,该算法具有更好的诊断效果。

关键词:舌头图像;检测框架;多特征融合;深度特征;小样本舌象

中图分类号:TP391.41 文献标识码:A 文章编号:2096-4706(2020)01-0063-04

Abstract:Tongue image diagnosis is a very important step in clinical decision-making. The researchers proposed an automated method of tongue image diagnosis. They usually extract tongue images from images,and then extract relevant features and classify them through feature engineering or deep learning methods,and achieve good results. However,it takes a lot of work to use feature engineering to design tongue features. In addition,only manual features or depth features are used to represent tongue features,especially when the tongue is in a non-uniform light source and posture. Therefore,this paper first designs a Faster-RCNN based detection framework to preprocess the tongue image,and then uses the method of multi feature fusion to fuse the features of the underlying features and the high-level semantic features,using this method to classify the tongue image. The results show that the algorithm has better diagnosis effect.

Keywords:tongue image;detection frame;multi-feature fusion;depth feature;small sample tongue image

0 引 言

随着社会经济的不断发展,人们对医疗资源的需求逐渐提高。面对日益增长的需求,许多使用计算机辅助诊断的系统被研发出来缓和资源紧张的局面。对于中医来说,主要围绕舌诊系统进行开发。现有的舌诊系统在数据采集和诊断准确率方面存在问题,一是数据采集需要较大人力成本,二是系统诊断准确率容易受到外界因素的影响,例如光照、姿势等等。因此本文提出了基于Faster-RCNN的检测框架,用来处理图片采集的问题,另外针对现有的诊断模型一般需要在受限条件下进行诊断的问题,本文提出了一种多特征融合的诊断模型,能够较好地解决上述问题。本文组织如下,首先介绍了所提出的检测和诊断框架,然后进行了实验并与其他方法进行比较,最后总结全文。

1 中医智能舌诊介绍

舌象诊断在传统中医学中是非常重要的一个部分。通过望诊观察病人的舌头,中医从业者能够评估病人的健康状态。尽管高级的医生诊断水平很高,然而对于初级医生来说,由于缺乏足够的经验,他们很容易对病人的情况进行误判。因此,研究者提出了一些基于机器学习的自动诊断算法,希望能够在缺少医疗资源或者医生经验不足的情况下使用该方法进行辅助诊断,从而缓解医疗资源紧张的情况,同时减少误诊的情况。

基于机器学习的舌象诊断算法,一般来说包括以下步骤,首先从给定的舌象图片中定位到舌头,然后使用相关的算法对舌头的特征进行提取,最后使用提取好的特征来判断这个舌象是否异常。目前的工作主要集中在对舌象的特征提取上,对舌象的特征提取工作可以分为两个部分,一方面是基于传统手工特征工程的方法,另一方面是基于深度学习的自动提取特征的方法。在参考文献[1-3]中,使用底层手工特征将舌象的形状、纹理和颜色等特征提取出来,用来进行分类;另一方面,参考文献[4-6]尝试使用了基于深度学习技术的方法自动提取高层语义特征,并使用该特征来对舌头图像进行分类。

尽管以前的工作在舌头分类这个任务上取得了很好的成绩,然而依然有很多问题需要考虑。首先,在之前的工作中,舌头的舌体图像是相关人员手工从原始图片中提取出来的,这是一个十分费时费力的工作;第二,以前的工作往往使用单一手工设计特征进行舌象分类,例如,使用颜色特征来区分舌象的异常,或者是使用纹理特征来判断舌象是否存在裂纹从而判断异常,使用单特征的方法仅仅能从一个方面来判断舌象异常,具有较大的局限性。参考文献[6]中使用了多个手工特征组合的特征进行分类,效果好于使用单一手工特征。然而使用手工特征的局限性很大,一方面是设计这些特征需要相关的领域知识,并且有时想要设计出一个好的特征存在困难,另一方面,这些特征一般容易受到如光线、姿势、变形等外界因素的影响,例如,如果图片偏亮或者偏暗就会使颜色特征提取器提取出错误的特征。使用深度学习技术自动从舌象图片里提取特征,一方面降低了手工设计特征的復杂性以及困难性,另一方面深度学习提取的高层语义特征一般具有鲁棒性,较少受限于外界因素,然而深度学习一般需要使用大量数据进行训练,当数据量不够大时,深度学习可能无法提取出满意的特征,特别是在舌象诊断这个领域,往往缺乏大量的图片来训练一个好的深度学习分类器。

为了解决第一个问题,本文提出了一个检测框架来对舌头图像进行提取,这个检测框架能够有效地对舌头图像进行定位。在第二个问题上,本文结合了传统特征和深度特征的特点,提出了一个基于多特征融合的特征提取方法,将传统的手工特征HOG、LBP以及从ResNet-50提取的高层的深度语义特征进行融合。相比于之前仅仅使用底层特征或者高层特征来诊断舌头图像,本文的方法考虑到传统特征和深度特征各自的优势,利用这种多特征融合方法能够表达更完整和准确的舌象特征,从而取得更好的舌象分类结果。

本文的贡献在于,首先,提出了一个舌象预处理的检测框架;第二,提出了一个基于多特征融合的方法来改善舌象分类的准确率。本文剩下的部分按如下组织,第二节介绍了整个舌象分析框架,包括检测框架和多特征融合方法,第三节展示了实验结果,最后一节进行总结。

2 舌象检测与诊断架构

本文提出的分析框架包括两个部分,分别是检测模型和分类模型。一个舌头首先通过检测模型从原始的舌头图片中被定位出来,然后将它们切割并调整到同样的大小。最后,这样的舌头图像被分类模型进行分类。本文所提出的框架如图1所示。

2.1 检测模型

本文首先介绍非常有名的检测网络Faster-RCNN[7],然后提出本文所使用的检测网络。

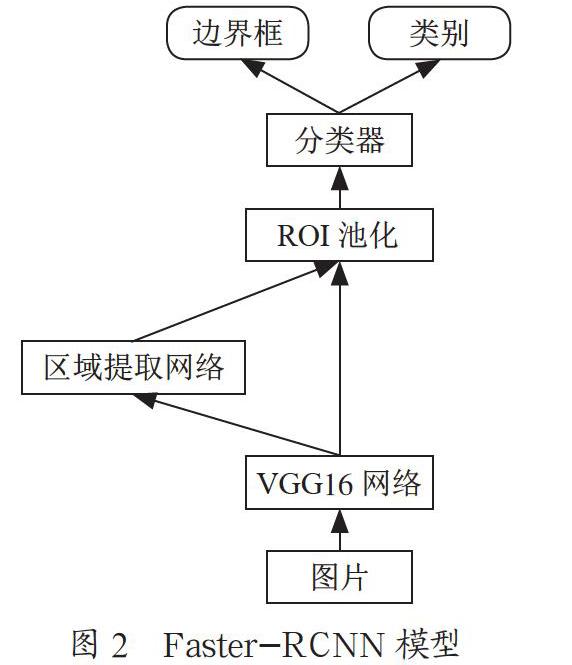

Faster-RCNN是检测领域的领先算法,它能够在很多任务上取得非常高的检测准确率。原始的Faster-RCNN算法由骨干网络、区域提出网络、兴趣区池化层以及分类网络组成。骨干网络用来从原始的图片提取高层语义特征。区域提出网络使用这些特征来生成边界框和一个类别描述来判断其是否存在物体或者背景。在给定了边界框之后,使用非极大值抑制算法将多余的边界框去除,剩余的边界框和从骨干网络中提取出的特征一起被送到兴趣区池化层,将它们调整成同样的形状,最终被分类网络进行分类是否是舌象。Faster-RCNN系统框架如图2所示。

然而在舌象诊断的任务中,仅仅只有一个物体也就是舌象需要被检测。而原始的Faster-RCNN是用来进行多任务检测的。因此需要将Faster-RCNN的输出调整成两类,即舌头和背景。另外,原始的Faster-RCNN使用了VGG16作为其骨干网络,这样的网络没有近期出现的更深的神经网络,例如ResNet-50,具有更强大的特征提取能力。因此将VGG16替换成了ResNet-50,如图3所示。

2.2 分类模型

本文使用HOG和LBP方法来获得手工设计的底层特征,使用ResNet-50来生成高层的语义特征。这些特征被使用拼接的特征融合方法融合成一组特征,然后将它们送入分类器进行舌象状态的识别。

HOG[8]是一个被用在计算机视觉领域特征描述的描述器。这个描述器计算了一个图片里被定位部分的梯度方向。这样做的基本想法是,在一个图片里,局部物体的外貌和形状能够被梯度强度和边的方向分布所描述。因此,这个方法能够被用来提取图像的边缘特征。

LBP[9]是一种视觉描述器。它在1994年被最先提出,从那时起到现在被认为是非常强大的用于提取纹理特征的特征提取器工具。在本文中使用这个描述器来提取舌象的纹理特征。

ResNet-50[10]是一种人工神经网络,这个网络包括了一种残差神经网络,其能够利用跳过连接或者捷径来跳过一些层而不进行训练[10]。相比于那些浅层的神经网络,这种神经网络能够学习到更多的关键语义信息。因此使用这个网络来获取舌象的高层语义特征。

本文所提出的多特征融合方法如图4所示。多个特征使用拼接方式进行特征融合,融合后的特征被送入支持向量机和K-最邻近邻居算法进行分类,从而识别舌头的状态。

3 舌象诊断实验

3.1 数据集

使用搜索引擎在网上(百度、谷歌以及Pinterest)收集到了185张舌头图片,包括94张正常的样例和91张异常的样例。这些舌头图像包括完整的舌头,并且适合做舌象诊断。另外又从网上收集了若干舌象并打上标签,送入一个预训练好的检测框架里进行微调,从而训练出了一个能够进行舌象定位的检测框架。而185张舌头图片则用于分类,需要注意的是,这些图片不是在统一的光源和姿态下采集的,并且舌头的形状和大小的区别也较大。

在训练分类模型的时候,首先使用IMAGENET训练集来预训练ResNet-50模型,在预训练好整个模型后,再用这个已经预训练好的模型,并利用训练舌象对模型进行再次训练,从而对整个模型进行微调。当模型训练完之后,模型被去掉最后一层全连接层并新增了平均池化层来得到输出,此时的模型输出可以拿来用作深度特征提取器。

3.2 实验结果

在分类阶段,本文比较了所提出的多特征融合方法,包括HOG、LBP以及ResNet-50这三类特征提取器。本文使用了支持向量机和K-最邻近邻居作为分类器,并使用了准确率、精确度、召回率和F1-score作为度量指标来评价模型的分类性能。因为没有公开的数据集,本文使用收集的数据集来评估上文提出的指标。文献[6]使用了HOG和LBP特征对舌象进行分类,本文提出的多特征融合的算法将与文献[6]进行比较。

HOG和LBP被选为底层手工设计特征的代表特征提取器。ResNet-50则被用作是深度语义特征提取器。

结果展示在了表1和表2中。从表1和表2能够看出,本文提出的多特征融合的方法比使用传统的手工设计特征的方法以及深度语义特征的方法能取得更好的性能。這里能够比文献[6]的特征提取方法取得更好的效果,可能的原因是,该文章里的舌象是处于固定姿态且统一光源的情况下,在这些因素改变的情况下,传统的手工特征提取器可能会失效。另外,本文使用支持向量机能够取得比K-最邻近邻居更高的准确率。

4 结 论

本文设计了一个舌象检测框架,并提出了一种使用多特征融合方法,包括底层手工设计特征和高层深度语义特征,来解决舌象分类问题。结果表明,本文提出的多特征融合方法能够在舌象分类任务上取得较好的结果。

参考文献:

[1] KANAWONG R,OBAFEMI-AJAYI T,MA T,et al. Automated Tongue Feature Extraction for ZHENG Classification in Traditional Chinese Medicine [J].Evidence-Based Complementary and Alternative Medicine,2012.

[2] WANG X. Statistical Analysis of Tongue Images for Feature Extraction and Diagnostics [J].Image Processing,IEEE Transactions on Image Processing,2013,22(12):5336-5347.

[3] ZHANG B,ZHANG H .Significant Geometry Features in Tongue Image Analysis [J/OL]. Evidence-Based Complementary and Alternative Medicine,2015:897580 (2015-07-13).https://scite.ai/reports/10.1155/2015/897580.

[4] HUO C M,ZHENG H,SU H Y,et al. Tongue shape classification integrating image preprocessing and Convolution Neural Network [C]// Intelligent Robot Systems.IEEE,2017.

[5] HOU J,SU H Y,YAN B,et al. Classification of Tongue Color Based on CNN// [C].Proceedings of 2017 IEEE 2nd International Conference on Big Data Analysis(ICBDA 2017).Institute of Electrical and Electronics Engineers,2017:745-749.

[6] MENG D,CAO G,DUAN Y,et al. A deep tongue image features analysis model for medical application [C]//2016 IEEE International Conference on Bioinformatics and Biomedicine (BIBM).IEEE,2016.

[7] REN S,HE K,GIRSHICK R,et al. Faster R-CNN:Towards Real-Time Object Detection with Region Proposal Networks [J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2015,39(6):1137-1149.

[8] DALAL N,TRIGGS B. Histograms of Oriented Gradients for Human Detection [C]// 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR05).IEEE,2005.

[9] OJALA T,PIETIKAINEN M,MAENPAA T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2002,24(7):971-987.

[10] HE K,ZHANG X,REN S,et al. Deep Residual Learning for Image Recognition [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).IEEE Computer Society,2016.

作者簡介:邱童(1994.11-),男,汉族,江苏徐州人,硕士在读,研究方向:数据分析。