改进Otsu算法与ELM融合的自然场景棉桃自适应分割方法

2018-08-10尹爱军

王 见,周 勤,尹爱军

改进Otsu算法与ELM融合的自然场景棉桃自适应分割方法

王 见1,2,周 勤1,2,尹爱军1,2

(1. 重庆大学机械传动国家重点实验室,重庆 400044;2. 重庆大学机械工程学院,重庆 400044)

针对动态行进过程中拍摄的自然棉田场景图像的棉桃分割问题,提出了一种改进的自适应优化分割方法。首先利用改进的Otsu分割算法定位棉桃区域,对棉桃和背景区域像素点的RGB值分别采样;将样本用于训练ELM(extreme learning machine)分类模型;把图像分割转化为像素分类问题,用分类模型对棉桃图像进行像素分类以实现棉桃图像的分割。对晴天和阴天场景下自然棉田的图像进行了算法验证,能正确分割棉桃并定位棉桃位置,实现了非结构光环境下对棉桃的无监督的采样和分割定位,每幅图像的平均分割时间为0.58 s,晴天和阴天状况下棉桃的平均识别率分别达到94.18%和97.56%。将该算法与经典分类算法SVM(support vector machine)和BP在增加纹理特征和采用RGB特征的情况下进行对比,并分析了该算法在分割速度和识别率上都有较大优势的原因。试验证明该算法在棉桃分割中有很好的实时性、准确性和适应性,可为智能采棉机的棉桃识别算法提供参考。

图像分割;作物;图像识别;改进的Otsu算法;极限学习机;自适应

0 引 言

随着人工智能的发展,国内外相关学者进行了大量有关机器视觉在农机应用方面的研究[1-5]。农田环境属于非结构化的自然环境,对目标农作物的准确分割和定位是长期以来的技术难点[6-10]。在图像领域,图像分割算法已由R-CNN经Fast R-CNN和Faster R-CNN发展到了Mask R-CNN,图像的分割已达到高精度的像素级别。由于目前还没有已标注的相关农作物的图像数据集,对于农作物的分割算法主要有2种方式:第一种是通过人工在图像中标注来获取样本,再训练分类器进行分割或者识别,如王星等[11]通过选取像素点的YCbCr特征训练GA(genetic algorithm)神经网络,实现了简单背景下棉花图像的分割,分割准确率达到91.9%;张成梁等通过利用人工交互选点的方式,对选定点的5×5邻域计算颜色特征均值及纹理特征,训练GA-SVM分类器对机采籽棉杂质进行分割识别[12],识别率达到92.6%;第二种是不需要人工标注的自适应分割算法,如王丽丽等[13]采用基于Niblack自适应修正系数的温室成熟番茄目标提取方法,该方法对温室成熟番茄图像有较好的分割效果;李凯等设计了一种联合分割算法对棉花苗叶片图像进行自动分割[14],对晴天、阴天、雨后天气下的图像分割精度分别达到84.8%、87.7%和91.6%;贺付亮等[15]提出基于视觉显著性和脉冲耦合神经网络的成熟桑葚图像分割方法,对小目标桑葚识别有较好的效果。第一种方式原理较简单,但是需要人工进行大量标注,且对于非结构化环境的适应性差;第二种方式不需要人工标注,对非结构化环境适应性较好,但是算法原理复杂,调参过程困难且耗时,可移植性低。因此提高图像分割算法的运行速度和非结构化环境的适应性是人工智能应用在农业实际生产中亟待解决的问题[16-18]。

棉桃的视觉分割,相对于其他果蔬分割,具有植株密集,形状不规则,颜色受光照影响大的特点[19-20]。本文结合上述2种方式的优点,改进了Otsu分割算法分离棉桃和背景区域,对分割结果分别采样得到训练样本,避免了人工标注的过程;再选择在训练速度、准确率和稳定性上都表现较好的ELM(extreme learning machine)算法[21-26]作为分类判别器分割图像;最后与第一种方式中常用的分类算法SVM、BP(back propagation neural network)对比,以证明改进Otsu与ELM融合的方法在分割速度、准确性和稳定性上是否具优势。

1 自适应分割算法原理

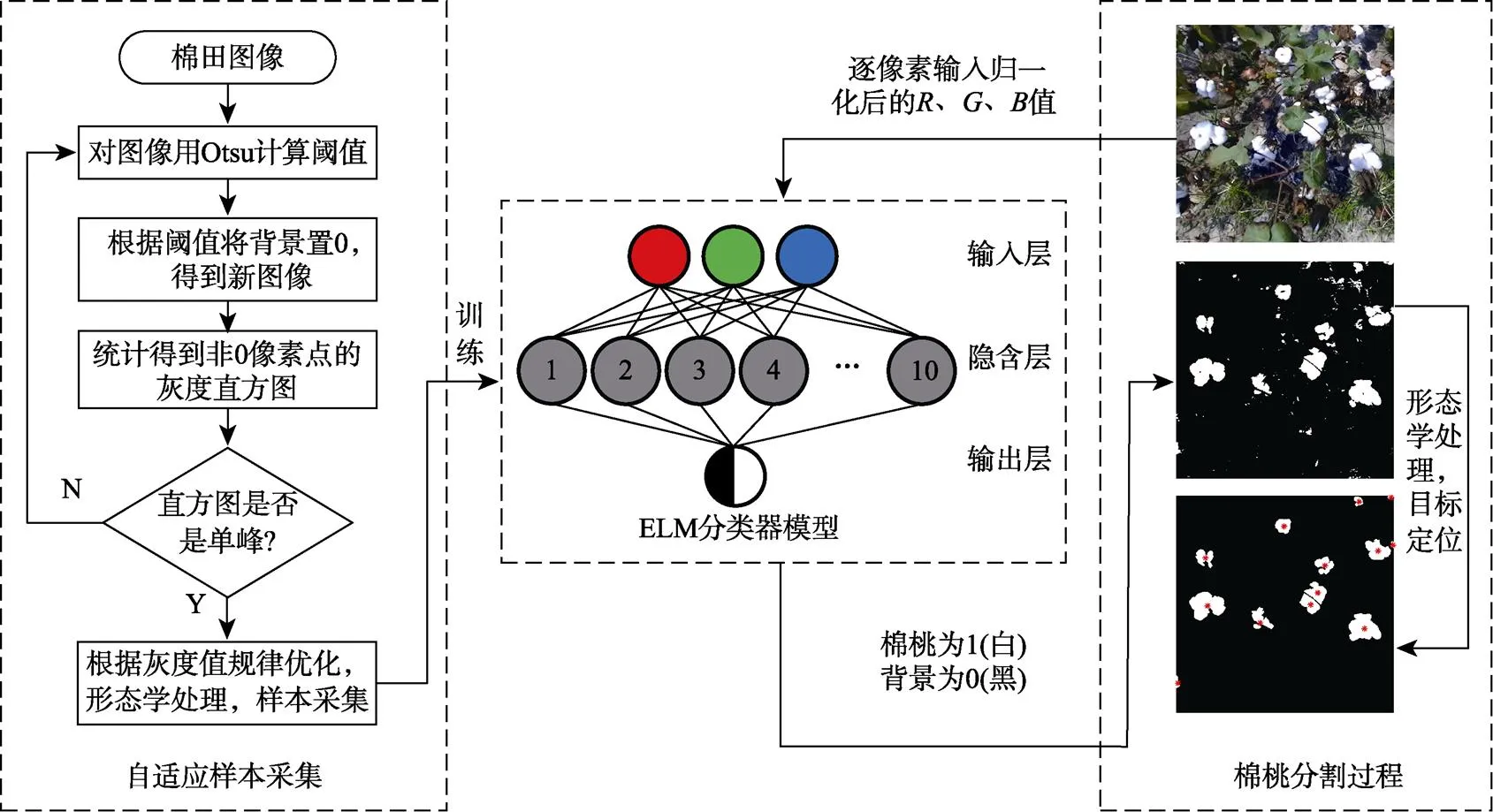

自然环境下棉田图像的棉桃像素点和背景像素点的RGB颜色特征差异明显,但是在不同光照条件下各类像素点RGB值变化也较大。如果能根据光照情况实时自动采样训练分类器,就能实现非结构光环境下自适应棉桃分割。以此为思路,提出基于改进Otsu算法初步分割棉桃,从分割结果中采样得到以像素点RGB值为特征向量的训练样本。将样本用于训练ELM分类器,再对图像进行逐像素分类,最后对分类结果进行处理即可完成棉桃的识别。

1.1 基于改进Otsu算法的自适应样本采集

1.1.1 改进Otsu算法

Otsu是运用统计学的原理,选定分割阈值使前景和背景的类间方差最大的一种自适应阈值确定方法[27]。设表示一幅图像的灰度级,根据阈值将图像像素点分成2类。

式中p表示像素点灰度值为的概率,()表示像素点灰度值小于等于的概率,0和1分别表示背景和前景的概率。

以0和1分别表示背景和前景的灰度均值:

前景和背景的类间方差σ2表示

最佳阈值为:

此种方法只适合前景和背景面积相差不大,灰度直方图呈双峰状态的图像分割。由于棉桃目标与背景面积相差太大,灰度直方图没有明显的双峰,呈现多峰状态,使用传统的Otsu不能将棉桃从背景中分割出来。

针对棉田图像灰度直方图分布呈多峰分布,本文改进了Otsu算法对图像进行棉桃分割。

1)将灰度范围为0~255之间的图像、、值归一化到0~1;

3)根据阈值t将背景像素点置0,得到新的图像;

4)统计得到非零像素点的灰度直方图;

5)重复上述2)、3)、4)步骤次,直至直方图分布为陡峭的单峰分布,分割过程结束,t即为最终的分割阈值。

改进后的Otsu算法通过多次迭代,以非0像素的直方图分布形状作为判别标准,能在不同光照场景中自适应地分割出大部分棉桃。

1.1.2 基于灰度值统计的分割结果优化

通过改进Otsu算法分割后,有一部分图像的分割结果中会剩余较少部分反光薄膜、泥土等背景。为提高样本质量,将600幅图像用改进Otsu分割后,选取10幅光照条件差异较大且有误分割的图像,将分割结果中误分割为棉桃的像素点人工圈选出来,共计1 854个像素点;再获取相同个数的棉桃像素点。将误分割为棉桃的背景和棉桃像素点做统计分析(如图1所示),背景像素在归化-、归一化-值分布图中的位置在45°线以下。所以当某像素点的归一化值大于归一化值或者归一化值大于归一化值,则可判定此像素点为背景像素。此关系是针对不同光照条件下图像的误分割统计,可以在改进Otsu算法分割后再根据此关系优化分割结果,进一步提高采样质量。

图1 棉桃与误分割背景的归一化G-R、B-R、B-G值分布

1.1.3 样本采集

将图像用改进的Otsu方法分割后,根据归一化、、值进一步优化分割结果。此时分割结果中棉桃和背景的像素点值分别为1和0。识别像素点值为1的连通区域,去除像素面积小于阈值的小面积噪声部分;再对二值图像进行闭运算,得到最终的分割结果。将结果中棉桃部分像素点对应到原图,取对应像素点的归一化、、值为特征向量,像素点的个数为棉桃样本个数。均匀提取与棉桃样本等数量的背景像素点的归一化、、值作为背景样本。为减少样本数量,将同类样本中、、值都相等的多个像素点的特征值保留一个;为避免正负样本中产生重叠,再去掉正负样本中共有的像素点,最终得到用于训练像素分类器的样本集。

使用自适应样本采集方法对10幅图像采集120 000个样本,统计位于背景部分的棉桃样本共计297个,位于棉桃部分的背景样本共计45个,此时样本标签的正确率达到99.7%以上,证明了基于改进Otsu算法的自适应样本采集方法的正确性。此样本采集过程不需要人工干预,且能适用于多种光照条件下。

1.2 ELM图像分割

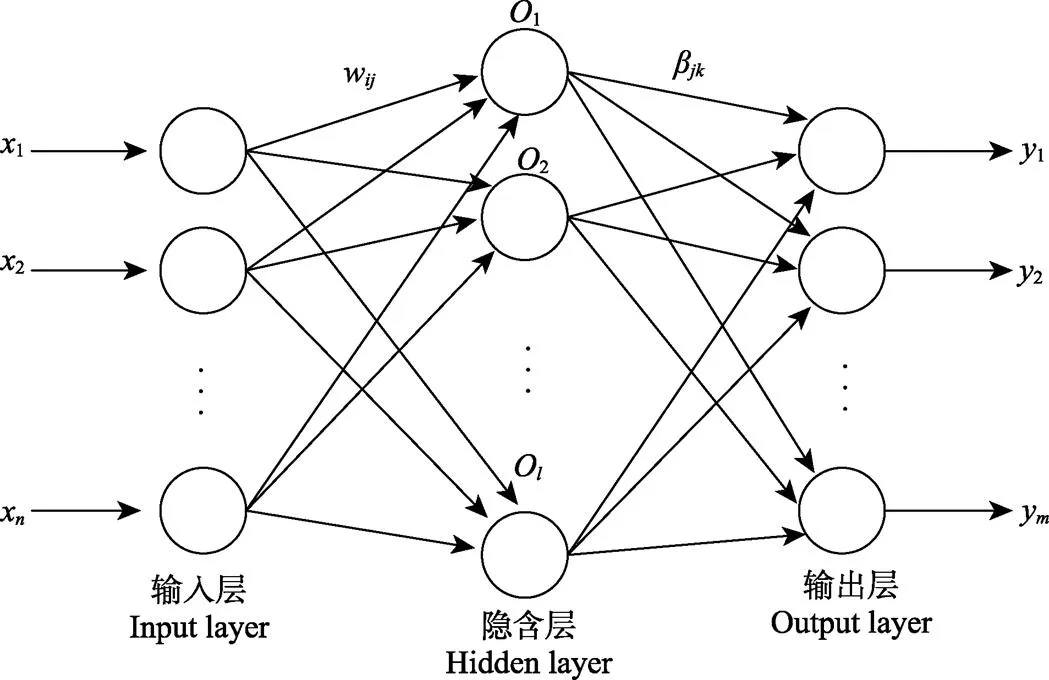

极限学习机是SLFN(single–hidden layer feedforward neural network)中的一种,由一个输入层、一个隐含层、一个输出层组成,输入层与隐含层、隐含层与输入层神经元间全连接。如图2所示,个输入变量输入个神经元,输入层与隐含层之间的连接权值为(´矩阵,隐含层有个神经元),隐含层与输出层间的连接权值为(矩阵),个神经元输出个输出变量。

Huang等提出ELM理论[28],证明当激活函数()无限可微时,输入层与隐含层的连接权值和偏置在训练前可以随机选择,且在训练过程中保持不变。隐含层与输出层间的连接权值可以通过求解如下方程式获得。

注:x1~ xn为输入变量,wij为输入层与隐含层连接权值,O1~Ol为隐含层神经元,βjk为隐含层与输出层连接权值,y1~ ym为输出变量。

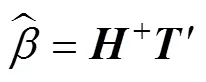

式中表示隐层节点输出,为期望输出。其解为:

为隐含层输出矩阵的Moore-Penrose广义逆。ELM随机产生0到1区间的输入层和隐含层的连接权值及隐含层神经元的阈值,因此只需要设定隐含层神经元的个数,求解从隐含层到输出层的权值即可完成训练过程。ELM算法调参过程和求解方法使得其具有快速学习和泛化性能好的特点[29-30],在大规模数据分类问题上效果较好。实际棉桃采摘环境中光照条件复杂,得到的互不相同的样本个数上万。将样本用ELM训练分类模型,可以得到更精确也更快的分类模型。

ELM棉桃分割过程:

1)初始化:确定输入层、隐含层和输出层神经元的个数,输入层与隐含层的连接权值和隐含层神经元的偏置由随机数发生器产生0到1之间数来决定,在计算的过程中不变,选择Sigmoid函数作为隐含层神经元的激活函数;

2)模型训练:将采集好的样本传入训练模型(棉桃样本标签为1,背景样本标签为0),计算隐含层输出矩阵和输出层权值向量。

3)模型应用:将待分割的图像的所有像素点、、值归一化,每一个像素点的、、归一化值组成的向量都是一个待分类的样本,按顺序传入训练好的ELM分类器,根据输出值为1还是0来确定是棉桃还是背景。

1.3 改进Otsu与ELM融合的自适应分割及棉桃定位

将制作好的样本用于训练ELM分类模型,用训练好的模型分割图像。识别像素点值为1的连通区域,使用文献中的方法[11]去除像素面积小于阈值的小面积噪声部分;再对二值图像进行闭运算。根据文献[31]中的方法计算出棉桃圆形度大于0.3,因此找到圆形度大于0.3的连通区域的质心位置;设置阈值,如果两两连通区域质心的像素距离小于阈值,则通过取两点中心的方式返回一个新的质心位置,使某些因树叶遮挡而分开的距离较近的残缺部分连接起来。再由质心位置对应的深度值得到棉桃的坐标。本文算法流程如图3所示。

图3 改进Otsu算法与ELM融合的自然场景棉桃自适应分割流程

2 试验设计

2017年3月,在三亚的棉田育种基地中,使用双目相机模拟采棉机实际运行的状态,以3 km/h的速度动态拍摄多组视频作为材料样本。将阴天和晴天拍摄的视频各读取300帧保存为分辨率720×720像素的PNG格式图像用于棉桃分割定位研究。

2.1 训练样本采集

将所有图像都使用改进的Otsu方法分割,验证算法的有效性。初步分割结果中有些背景被误识别为棉桃,经过阈值筛选和形态学去噪的优化处理后,最终的效果如图4所示。

从300张晴天棉田图像中选取10幅通过基于改进Otsu算法的自适应样本采集方法进行样本采集,选中的每一个像素点的归一化值向量即为一个样本,得到棉桃和背景各60 000个样本。同样选取10幅阴天的图像采集相同个数的训练样本。

图4 图像经改进的Otsu算法和形态学优化处理的分割结果

2.2 ELM模型训练与分割结果

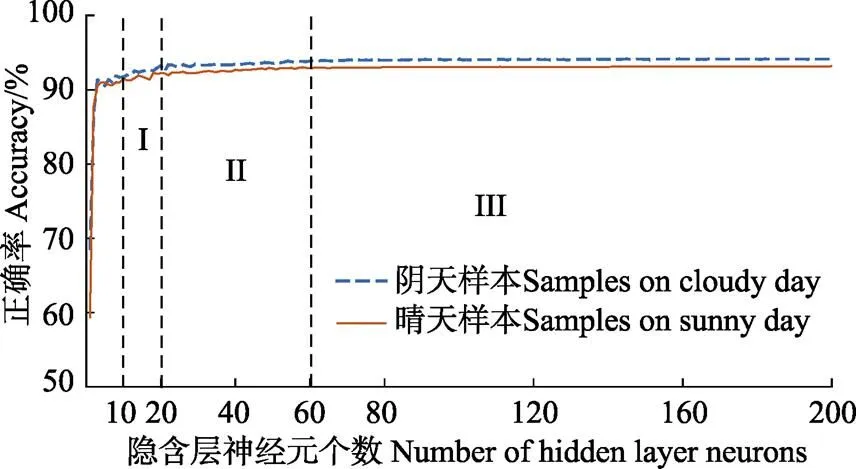

在配置为Intel Core i7-7400 CPU 3.00 GHz, 12 GB RAM,Windows 10 64bits 的计算机上,用MATLAB R2016a 作为分析工具,将样本集的三分之二用于训练ELM模型,三分之一用于测试,将测试结果与样本标签对比来统计模型的正确率。隐含层神经元个数与测试集预测正确率之间的关系如图7所示,随着隐含层神经元个数从1增加到10,分类正确率上升到比较高的水平后,I区域增长速度开始减缓,II区域随着隐含层神经元个数增加,正确率只有缓慢的增大趋势,III区域保持平稳不再变化。

图5 隐含层神经元个数对模型正确率的影响

根据正确率随隐含层神经元个数增长变化的曲线,选取变化阶段的节点处数据,即隐含层神经元个数为10、20、60的模型,将除样本集外的晴天和阴天的图像随机抽取30张用于模型效果测试,分割效果如图6所示,在MATLAB R2016a工具下分割时间和正确率对比如表1所示。

可以看出3种模型的分割效果基本一致,虽然隐含层神经元个数为20和60时,模型正确率比为10时高,但是由于在样本制作时有些阴影部分的棉桃像素点并未加入正样本。为了保证模型的容错率,并不需要正确率过高,正确率过高导致模型的过拟合问题会使棉桃阴影部分被误分类为背景。从图像的分割效果中可以看出,当隐含层细胞个数为10的时候,棉桃可以被完整地分割出来。综合考虑分割效果和运行时间,最终选择隐含层细胞个数为10。

图6 不同隐含层神经元个数的ELM模型分割效果对比图

表1 隐含层不同神经元数ELM模型分割单张图像分割性能

2.3 分割结果优化与识别率统计

通过ELM算法分割后的图像存在一些颜色和棉桃相同的噪声部分。通过形态学处理优化后再进行目标定位,图7所示为最终的识别结果。对于每幅图像,从读入到得到分割结果的时间作为分割时间,人工计数得到的真实棉桃个数与算法自动标注为棉桃的个数之比作为识别率。除去用于提取样本的10幅图像,用本文算法分割剩余的晴天和阴天各290幅图像,统计得到晴天棉桃平均识别率为94.18%,平均分割时间为0.58 s;阴天棉桃平均识别率为97.56%,平均分割时间为0.58 s。

图7 棉桃定位结果

3 算法性能对比分析

将本文算法与经典的分类算法SVM、BP用MATLAB R2016a作为分析工具进行比较。图像分割中还常常提取像素点的Tamura纹理特征中的粗糙度、对比度和方向度作为特征向量,因此在训练样本中加入Tamura纹理特征,即每个像素点周围5×5像素块的粗糙度,对比度,方向度,再加上RGB颜色特征,形成新的特征数为6的训练样本,与本文只提取RGB颜色特征作为训练样本作对比。经试验,SVM分类选择一次多项式核函数(LIBSVM参数为‘-t1-d1’)进行模型训练;BP算法在样本特征数为6和3时分别选择网络结构为6-7-1和3-4-2,激活函数为Sigmoid,学习率为0.1,迭代次数为10 进行训练。同样是使用10张图像得到有纹理特征和无纹理的各120 000个样本,将样本集的三分之二用于训练ELM模型,三分之一用于测试模型。从晴天图像和阴天图像中各随机抽取30张图像用训练好的模型分割,分割后再进行相同的形态学优化处理和定位。试验结果用error bar来表示,分别表示出分割时间和棉桃识别率的极大值,均值和极小值,如图8所示。

图8 不同天气下ELM、SVM、BP分割单幅图像棉桃识别率、效率对比

在晴天图像的分割中,用RGB特征训练的ELM、SVM、BP模型棉桃平均识别率分别为94.57%、77%、83.35%,单张图像的平均分割时间分别为0.58、177.31、6.52 s;使用Tamura纹理特征和RGB特征共同作为训练样本训练的ELM、SVM、BP模型平均识别率分别为75.68%、80.54%、86.17%,单张图像的平均分割时间分别为467.87 、678.35 、551.01 s。在阴天图像的分割试验中各方法的平均识别率比晴天偏高,数据分布规律相似。可以看出本文算法具有最短的分割时间和最高的识别率。从30幅图像分割结果的正确率的极大值、极小值分布来看,本文算法的正确率波动较小,算法稳定性较好。

在加入纹理特征之后ELM的识别率反而下降,从图像的分割结果分析是因为部分背景像素点的纹理特征与棉桃纹理特征相似。如图9所示,为加入纹理和不加纹理的模型分割结果,左图方框圈选出来的为加入纹理后引入的误分割部分。将误分割和棉桃部分、、值分布以及纹理值分布表示如图10所示,可见这2部分纹理值虽然值各不相同,但是相互混杂,无法区分;而这2部分的、、值分布区分度较大。BP和SVM算法在未加入纹理特征时就无法区分白色塑料膜与棉桃部分,因此加入纹理特征后对模型的正确率没有太大影响。

图9 加入纹理前后的ELM分割结果

为了使棉桃识别算法能够适用于实际采棉机的运动过程,本文处理的图像取自于动态拍摄的视频,因此图像会有细节丢失,而且超高清的图像需要处理和传输的数据量太大,为了满足实时性,没有选择超高清的图像采集设备。在训练分类器时特征的选择尤为重要,不恰当的特征会引入误差量,从算法性能对比可知,由于图像质量的限制无法得到高质量的纹理特征,而且提取纹理特征时间消耗大,无法满足实时性的要求。而通过样本自动采集增大样本容量后,选择RGB特征有更好的区分度。试验结果表明,改进Otsu与ELM融合的棉桃自适应分割算法在棉桃识别中具有更好的稳定性,更高的准确度和更快的实时性。

图10 误分割背景和棉桃部分归一化R、G、B 分布以及纹理值分布

4 结 论

本文提出了一种基于改进Otsu分割算法的自适应样本采集方法。分析了灰度直方图的分布与分割效果之间的关系,提出一种改进的Otsu分割方法对图像进行初步分割;并对分割后的棉桃和背景像素点的RGB值进行统计学分析,通过阈值筛选和形态学处理,实现了非结构化的自然环境下棉桃和背景的样本自动采集。

1)传统的分类需要人机交互点选正负样本,分类模型一旦确定就很难修改。本文的自动样本提取方法避免了人工选择样本的过程,在实际运用的时候,可以通过检测实时拍摄图像的灰度均值为光照条件是否变化的判断依据,自动选择样本和重新训练模型,从而能够适应不同的光照条件。

2)本文设计的样本自动提取方法能够得到大量像素点样本,可以避免提取纹理特征来增加样本信息量。通过试验分析,证明本文算法在棉桃分割中不需要提取纹理特征提取就可以达到更好的分割效果,大大减少了分割时间。

3)通过试验证明了本文算法在准确性和速度方面有了很大的提高,在阴天和晴天光照条件下棉桃平均识别率分别为94.18%和97.56%,晴天图像的棉桃识别率比阴天低,从分割结果图像来看,晴天图像中的误分割都是一些反光严重的部分,在以后的研究中还需要继续优化算法。

[1] 董胜,袁朝辉,谷超,等. 基于多学科技术融合的智能农机控制平台研究综述[J]. 农业工程学报,2017,33(8):1—11. Dong Sheng, Yuan Zhaohui, Gu Chao, et al. Research on intelligent agricultural machinery control platform based on multi-discipline technology integration[J]. Transactions ofthe Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(8): 1—11. (in Chinese with English abstract)

[2] 孟庆宽,张漫,杨耿煌,等. 自然光照下基于粒子群算法的农业机械导航路径识别[J]. 农业机械学报,2016,47(6):11—20. Meng Qingkuan, Zhang Man, Yang Genghuang, et al. Guidance line recognition of agricultural machinery based on particle swarm optimization under natural illumination[J]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(6): 11—20. (in Chinese with English abstract)

[3] 张志斌,赵帅领,罗锡文,等. 基于SURF算法的绿色作物特征提取与图像匹配方法[J]. 农业工程学报,2015,31(14):172—178. Zhang Zhibin, Zhao Shuailing, Luo Xiwen, et al. Matching method of green crops based on SURF feature extraction[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2015, 31(14): 172—178. (in Chinese with English abstract)

[4] Ali T, Jhandhir Z, Ahmad A, et al. Detecting fraudulent labeling of rice samples using computer vision and fuzzy knowledge[J]. Multimedia Tools & Applications, 2017, 76(23): 24675—24704.

[5] Sa I, Chen Z, Popovic M, et al. WeedNet: Dense semantic weed classification using multispectral images and MAV for smart farming[J]. IEEE Robotics & Automation Letters, 2017, 3(1): 588—595.(in Chinese with English abstract)

[6] 苗中华,沈一筹,王小华,等. 自然环境下重叠果实图像识别算法与试验[J]. 农业机械学报,2016,47(6):21—26. Miao Zhonghua, Shen Yichou, Wang Xiaohua, et al. Image recognition algorithm and experiment of overlapped fruits in natural environment[J]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(6): 21—26.(in Chinese with English abstract)

[7] 李立君,阳涵疆. 基于改进凸壳理论的遮挡油茶果定位检测算法[J]. 农业机械学报,2016,47(12):285—292. Li Lijun, Yang Hanjiang. Revised detection and localization algorithm forcamellia oleifera fruits based on convex hull theory[J]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(12): 285—292.(in Chinese with English abstract)

[8] Wang C, Tang Y, Zou X, et al.Recognition and matching of clustered mature litchi fruits using binocular charge-coupled device (CCD) color cameras[J]. Sensors, 2017, 17(11): 2564(1—21).

[9] Zhang J, Kong F, Zhai Z, et al. Robust image segmentation method for cotton leaf under natural conditions based on immune algorithm and PCNN algorithm[J]. International Journal of Pattern Recognition & Artificial Intelligence, 2018, 32(5):1854011(1—23).

[10] Mehta S S, Ton C, Asundi S, et al. Multiple camera fruit localization using a particle filter[J]. Computers & Electronics in Agriculture, 2017, 142: 139—154.

[11] 王星,赖惠成,任磊,等.基于YCbCr空间和GA神经网络的棉花图像分割算法[J]. 计算机工程与应用, 2014, 50(11): 176—179.

Wang Xing, Lai Huicheng, Ren Lei, et al. Algorithm of cotton image segmentation based on YCbCr space and GA neural network[J]. Computer Engineering and Applications, 2014, 50(11):176—179. (in Chinese with English abstract).

[12] 张成梁,李蕾,董全成,等. 基于GA-SVM模型的机采籽棉杂质识别[J]. 农业工程学报,2016,32(24):189—196. Zhang Chengliang, Li Lei, Dong Quancheng, et al. Recognition for machine picking seed cotton impurities based on GA-SVM model[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2016, 32(24): 189—196. (in Chinese with English abstract)

[13] 王丽丽,魏舒,赵博,等.基于Niblack自适应修正系数的温室成熟番茄目标提取方法[J]. 农业工程学报,2017,33(增刊1):322—327. Wang Lili, Wei Shu, Zhao Bo, et al. Target extraction method of ripe tomato in greenhouse based on Niblack self-adaptive adjustment parameter[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(Supp.l): 322—327. (in Chinese with English abstract)

[14] 李凯,冯全,张建华. 棉花苗叶片复杂背景图像的联合分割算法[J]. 计算机辅助设计与图形学学报,2017,29(10):1871—1880. Li Kai, Feng Quan, Zhang Jianhua. Co-segmentation algorithm for complex background image of cotton seedling leaves[J]. Journal of Computer-Aided Design & Computer Graphics, 2017, 29(10): 1871—1880. (in Chinese with English abstract)

[15] 贺付亮,郭永彩,高潮,等. 基于视觉显著性和脉冲耦合神经网络的成熟桑葚图像分割[J]. 农业工程学报,2017,33(6):148—155. He Fuliang, Guo Yongcai, Gao Chao, et al. Image segmentation of ripe mulberries based on visual saliency and pulse coupled neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(6): 148—155. (in Chinese with English abstract)

[16] Vendano J, Ramos P J, Prieto F A. A system for classifying vegetative structures on coffee branches based on videos recorded in the field by a mobile device[J]. Expert Systems with Applications, 2017, 88: 178—192.

[17] Liu H, Lee S H, Chahl J S. A multispectral 3D vision system for invertebrate detection on crops[J]. IEEE Sensors Journal, 2017, 17(22): 7502—7515.

[18] Guerrero J M, Ruz J J, Pajares G. Crop rows and weeds detection in maize fields applying a computer vision system based on geometry[J]. Computers & Electronics in Agriculture, 2017, 142: 461—472.

[19] Li Y, Cao Z, Xiao Y, et al. DeepCotton:In-field cotton segmentation using deep fully convolutional network[J]. Journal of Electronic Imaging, 2017, 26(5): 053028(1—14).

[20] Wang Q, Xu B. A coupled-contour model for effective segmentation of cotton cross-sections in wide-field microscopic images[J]. Textile Research Journal, 2017, 87(12): 1509—1521.

[21] Stevica S, Cvetković, Miloš B, et al. Hierarchical ELM ensembles for visual descriptor fusion[J]. Information Fusion, 2018, 41(5): 16—24.

[22] Song Y, Zhang S, He B, et al. Gaussian derivative models and ensemble extreme learning machine for texture image classification[J]. Neurocomputing, 2018, 277: 53—64.

[23] Boemer F, Ratner E, Lendasse A. Parameter-free image segmentation with SLIC[J]. Neurocomputing, 2018, 277: 228—236.

[24] Duan M, Li K, Yang C, et al. A hybrid deep learning CNN-ELM for age and gender classification[J]. Neurocomputing, 2017, 275: 448—461.

[25] Zhang Y, Yuan Y, Wang Y, et al. A novel multimodal retrieval model based on ELM[J]. Neurocomputing, 2018, 277: 65—77.

[26] 裘日辉,刘康玲,谭海龙,等. 基于极限学习机的分类算法及在故障识别中的应用[J]. 浙江大学学报(工学版),2016,50(10):1965—1972. Qiu Rihui, Liu Kangling, Tan Hailong, et al. Classification algorithm based on extreme learning machine and its application in fault identification of Tennessee Eastman process.[J]. Journal of Zhejiang University (Engineering Science), 2016, 50(10): 1965—1972. (in Chinese with English abstract)

[27] Otsu N. A threshold selection method from gray-level histograms[J]. IEEE Transactions on Systems, Man and Cybernetics, 1979, 9(1): 62—66.

[28] Huang G B, Zhu Q Y, Siew C K.Extreme learning machine: A new learning scheme of feedforward neural networks[C]// IEEE International Joint Conference on Neural Networks, 2004: 985—990.

[29] Peng Y, Kong W, Yang B. Orthogonal extreme learning machine for image classification[J]. Neurocomputing, 2017, 266: 458—464.

[30] 李小冬. 核极限学习机的理论与算法及其在图像处理中的应用[D]. 杭州:浙江大学,2014. Li Xiaodong. Kernel ELM Theory and Algorithms and Application in Image Processing[D]. Hangzhou: Zhejiang University, 2014. (in Chinese with English abstract)

[31] 李卓,杨子敬,郝建唯,等.苹果幼果图像的分割与识别算法研究[J]. 沈阳理工大学学报,2015,34(1):34—39. Li Zhuo, Yang Zijing, Hao Jianwei, et al. Segmentation and recognition algorithms for image of young apple[J]. Journal of Shenyang Ligong University, 2015, 34(1): 34—39. (in Chinese with English abstract)

Self-adaptive segmentation method of cotton in natural scene by combining improved Otsu with ELM algorithm

Wang Jian1,2, Zhou Qin1,2, Yin Aijun1,2

(1.400044,2.400044,)

In order to segment cotton from background accurately and quickly under the unstructured natural environment, an improved scene adaptive optimization segmentation algorithm was proposed. Firstly, the traditional Otsu algorithm was adopted for cotton segmentation by analyzing the rule of gray histogram distribution of images acquired. During each segmentation of cotton image, the background pixel was set to zero and the gray histogram distribution of the target pixel was analyzed after segmented. The segmentation stopped when the histogram distribution appeared to be a steep unimodal distribution and the final segmentation threshold was the optimized threshold. There were still some background pixels in the segmentation results in the first step. Therefore, secondly, a threshold selection rule was utilized to segment cotton from background based on the statistical analysis of the RGB (red, green, blue) values. Cotton pixels were then extracted after morphology processing. Thirdly, cotton pixels with the RGB values were labeled as positive samples, and then background pixels with the same number of cotton were labeled as negative samples. The feature vectors which the positive and the negative samples shared in common were removed to improve the accuracy. A large-scale training samples were obtained automatically by using previous steps. In the fourth step, the samples were used to train the ELM (extreme learning machine) classification model for cotton segmentation. In the fifth step, the RGB values of all pixels in the test images were normalized and passed to the classification model and the output value will be 1 if the pixels belong to the cotton, or 0 if the pixels belong to the background. Another morphological procedure was employed to remove the noise segments of the output results. In the final step, the centroids of the connected regions which had a roundness of greater than 0.3 were extracted. If the pixel distance between 2 centroids was less than 40 pixels, a new centroid position was returned as a two-point center, so that some incomplete parts separated by the leaf were connected. Then the unsupervised sampling and segmentation of cotton under the unstructured light environment were achieved and the coordinates of cotton were derived. The algorithm proposed in this paper was verified by cotton segmentation experiment. The original datasets were collected on both sunny and cloudy days in the cotton breeding station located in Sanya, Hainan, China. The training datasets were composed of labeled samples generated from 20 images, 10 from sunny day and 10 from cloudy day. Another 60 images, 30 from sunny day and 30 from cloudy day, constituted the testing datasets. For each image in testing datasets, the accuracy is determined by the comparison of numbers between identified cotton and actual cotton. By applying the proposed method, the cotton was identified after segmentation. The average processing time is 0.58 s and the average recognition rates for the images on sunny and cloudy day were 94.18% and 97.56%, respectively. A comparison analysis was conducted between the proposed method and popular methods under Windows 10 64bits with an Intel Core i7-7400 CPU 3.00 GHz, 12 GB RAM, and MATLAB R2016a. For the segmentation of images on sunny day, accuracies by applying the proposed method, SVM (support vector machine) and BP (back propagation) with only RGB features as training samples were 94.57%, 77% and 83.35%, respectively. And the segmentation time was 0.58, 177.31 and 6.52 s, respectively. Accuracies by applying the proposed method, SVM and BP with Tamura texture and RGB features as training samples were 75.68%, 80.54% and 86.17%, respectively. And the segmentation time was 467.87, 678.35 and 551.01 s, respectively. The segmentation results of images on cloudy day were much like that on sunny days except slightly higher in accuracy. The results indicate that the proposed method exceeds popular methods in segmentation speed and accuracy. Moreover, the proposed method avoids texture feature extraction for each pixel, which guarantees better real-time performance.

image segmentation; crops; image recoginiton; modified Otsu algorithm; extreme learning machine; self-adaptation

王 见,周 勤,尹爱军. 改进Otsu算法与ELM融合的自然场景棉桃自适应分割方法[J]. 农业工程学报,2018,34(14):173-180. doi:10.11975/j.issn.1002-6819.2018.14.022 http://www.tcsae.org

Wang Jian, Zhou Qin, Yin Aijun. Self-adaptive segmentation method of cotton in natural scene by combining improved Otsu with ELM algorithm[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(14): 173-180. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2018.14.022 http://www.tcsae.org

2018-02-08

2018-04-12

国家自然科学基金项目(51675064);重庆科技计划—基于多目立体视觉的智能采棉机关键技术研究(cstc2016shmszx1245)

王 见,男,新疆喀什人,博士,副教授,主要从事机电一体化技术及智能控制研究。Email:vi@cqu.edu.cn

10.11975/j.issn.1002-6819.2018.14.022

S562;S24

A

1002-6819(2018)-14-0173-08