支持向量双效分类器及其应用

2018-07-04荣祥胜

凌 萍,荣祥胜,李 雪

1(江苏师范大学 计算机科学与技术学院,江苏 徐州 221116)2(空军勤务学院 训练部,江苏 徐州 221000)3(澳大利亚昆士兰大学 信息技术学院,澳大利亚 布里斯班 4067)

1 引 言

分类是人类认知未知事物的基础方法之一,也是机器学习领域的重要研究问题之一.在众多分类方法中,以支持向量机(Support vector Machine,SVM)[2]为代表的基于支持向量的分类方法以扎实的理论基础和良好的实验表现成为研究热点,得到了广泛的应用,其变体分类器不断涌现.根据分类模型的不同,可将基于支持向量技术的分类器分为两组:基于超平面的分类器,和基于超球体的分类器.前者在两类之间构造超平面,以分离两类,如GEPSVM[3],MVSVM[4],TWSVM[5],PTSVM[6].后者为各类构造覆盖类内成员的超球体,以获知类别的轮廓,如TCSVDD[7],MCM-SVM[8],THSVM[9],pSVDD[10],NSVDD[11]等.这两组分类器在理论及实践中的作用举足轻重,但随着研究和应用的深入,两组分类器的弊端也逐渐显现.与此同时,也出现了一些通过生成超球体进行类别判断的支持向量分类器,具体而言,基于超平面的分类器在处理含有重叠类别的数据集时,结果不尽人意.究其原因,在于此组分类器对类别之间间隔的过度依赖.倘若类别之间有重叠,则类间的间隔模糊,这给在保证类间间隔最大化的前提下生成优质分割面带来困难,也必然影响最终分类结果.此后,虽有文献提出了一些算法解决这一问题,但所给出的方法均未对支持向量模型本身做出改变,只是执行附加步骤或某简单分类器,构成组合式分类器[12,13].这样的改变往往增加了参数个数和算法运行成本.而且,改变之后的分类器仍是二分分类器.在解决多分类问题时,需要作为基本分类器提供局部决策结果,并根据某种集成策略汇总成为最终决策.

另一方面,对基于超球体的分类器而言,过适应是其难以避免的问题.因为此类方法源于用支持向量做数据描述的问题,其目标在于提供数据分布区逼真的轮廓描述.但,这种逼真的轮廓就分类而言,却往往构成太过紧致的分类边界.这造成,虽然分类器对训练数据有较高的适应性,但对于未知的测试数据其适应能力相对较弱,推广能力不足.

据此,本文提出一种新的双效分类思想,在训练分类模型的同时,学习类间的差异信息及类内的特征信息.从另一角度观察,类间的差异信息是一种全局性信息,而类内的特征信息是一种局部性信息,将二者结合起来训练分类模型,局部性信息将帮助全局性信息解决重叠区域的数据分类,而全局性信息将帮助局部性信息使其获得更大的推广能力.

进而,文中提出了收缩远离球模型以实现双效分类思想,并给出了支持向量双效分类算法(Doubled-Informed classifier based on Support vectors,DISV).DISV为各类建立收缩远离球,然后基于收缩远离球信息来定义决策函数来完成分类.收缩远离球的球面穿过类内的密集分布区,以获知类内的特征信息,同时该球保持与其他类别的最远距离,以达到最大的分类间隔并获得丰富的差异信息.DISV辅以训练数据抽取策略,和参数自适应调整策略,以降低算法代价.

文中将DISV应用于心脏肥大数据辅助诊断问题[15-17].长久以来,心脏肥大诊断问题上一直缺乏有效的计算机辅助诊断算法.原因是已有的心脏肥大训练数据数量较少,且质量较差.加之在数据采集过程中产生的测量误差,更为分类器的训练增加了难度.SVM和神经网络[18-20]是目前可解决心脏肥大诊断问题的两种方法.其中SVM遵循结构风险最小化理论且可应对非线性及小样本数据,因而更为常用.但正如前文所述,SVM在解决类别之间有重叠的数据集时,表现欠佳.而在当前环境下,患者数据和健康人数据之间的类别差异越发模糊,个体的生理信号值越发复杂多变,这给SVM在心脏肥大数据上的应用带来困难.在此情形下,提出双效分类思想及其实现算法解决上述困难,提高计算机辅助诊断的能力,具有实际的意义.

2 相关工作

最小包围球是是本文收缩远离球的理论基础,因此对其做简单介绍.给定数据集{x1…xN},其中xiRn.最小包围球通过优化以下目标函数得到[14]:

(1)

s.t.‖Φ(xi)-a‖2≤R2+ξi,ξi≥0(i= 1…N)

Φ是从输入空间到特征空间的非线性映射,ξi是松弛变量,a是球心,R是半径,C是松弛变量的惩罚系数.引入核函数k(xi,xj)=<Φ(xi)·Φ(xj)>,得到最终优化目标为:

(2)

αi是拉格朗日乘子,满足αi≠0的数据是支持向量.一般k为高斯核函数k(xi,xj)=exp(-‖xi-xj‖2/σ2),σ是尺度参数.

3 DISV算法细节

DISV是双效分类思想的实现算法,它为各类构造收缩远离球,并基于球的信息定义决策函数.为降低计算代价,DISV根据数据自身几何性质对训练数据进行抽取,并给出模型生成所需的平衡系数及邻域尺寸的自适应设置策略.

3.1 收缩远离球的初步模型

设数据集{x1…xN}覆盖M个类,类别号记为:1,…,I,…M.将除I类之外的其他所有类的集合视为一个大类,其类别号记作nonI.则为I类构造的收缩远离球通过优化如下目标函数完成:

minR2-η·∑xu∈nonI‖Φ(xu)-a‖2+C∑xi∈Iξi

(3)

s.t.‖Φ(xi)-a‖2=R2+ξi,ξi≥0 (xi∈I,xu∈nonI)

R,a,C及Φ的意义同前.xi取自I类,而xu取自nonI类.ξi是xi的松弛变量.在优化目标(3)中,‘R2’项与等式约束共同表达了“球面收缩”的要求,优化目标的第二项则使“球尽可能远离其他类”.η是平衡系数,在“收缩”和“远离”两个优化要求之间做出权衡,一般地,取0<η<1.

3.2 决策函数定义

设I类的收缩远离球的球心为a,半径为R,Q是待分类数据,则Q关于I类的隶属度函数定义为:

(4)

决策函数为:

L(Q)=maxJfJ(Q)

(5)

fI(Q)由Q和球心在特征空间内的内积决定,exp机制保证了值的稳定性.优化目标(3)涉及到I类和nonI类,即,全部的数据,因而计算代价较大.考虑到支持向量方法解的稀疏性,即,支持向量方法的解只由少数支持向量决定,这里将根据数据的几何信息抽取出得对模型生成有重要作用的支持向量的候选者构成训练子集.

3.3 数据抽取策略

对I类,生成两个子集:SI和TI.SI收集了I类中位于密集分布区的数据,TI收集了I类边界上的点,这些点将参与优化以保证球与其他类的最大分离.收缩远离球将在SI和TnonI上训练得到,并非在SI和TI之上.TnonI定义为除I类之外、其他类上所有TI子集的并集:

TnonI=∪{TJ|J=1,2…M∧J≠I}

(6)

′Λ′是合取逻辑操作.对I类,TnonI能够包含其他类的全部边界数据.因此,若为I类生成的球能与TnonI保持最大的远离,则可认为该球与nonI类整体保持最大的远离.

具体地,根据数据的邻域信息生成SI.设I类大小为NI,定义I类上的临近度矩阵H=(Hij)NI×NI:

(7)

i,j= 1,2…NI.Nei(xi)表示xi的邻域.若两个数据互为对方的邻居,则它们的临近度非零.定义选择函数为:

(8)

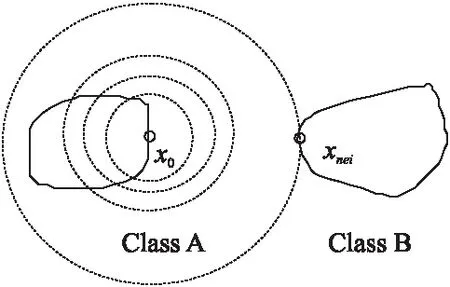

为生成TI,需寻找边界上的点.一般是通过计算数据点邻域中异类邻居的比例来判断数据位置,但此方法在有些情形下失效.如图1所示,当两个占地较小类别彼此远离,x0为 Class A边界上的点,设x0的邻域大小为r,即邻域中邻居的数目.只有当r增大到超过Class A的尺寸时,x0的邻域才有可能覆盖异到类数据.

图1 邻域大小示意Fig.1 Illustration of neighborhood size

受[21]启发,DISV通过观察数据点的邻居是否位于穿过该点的切平面的同一侧来选出边界点.如图2,x1,x2和x3是三个边界点,作出穿过三点与数据区相切的切平面.可知,对于x1和x3,两个位于凸边界的点,其邻域中的全部邻居均位于切线靠近数据区的一侧;对于x2,位于凹边界的点,其邻域中的大多数邻居位于切线靠近数据区的一侧.

图2 边界点上的切平面 图3 μi的近似计算示意

即对xi,求出其指向r个邻居的向量:ρij=xj-xi,(j= 1…r).对ρij做标准化,记标准化结果为Eij,则μi近似计算为:

(9)

(10)

设定阈值λ,(0<λ<1),那么任何满足Gi≥λ的xi入选TI.根据文献[21],λ设为0.82.

3.4 收缩远离球的改进模型

约简训练数据后,生成收缩远离球的要求可改变为:球面需穿过SI中的数据,同时与TnonI中的数据保持最大的距离.下文设SI和TnonI大小分别为Z1和Z2,xi和xj来自SI,xu和xv来自TnonI,则收缩远离球的新优化目标函数为:

(11)

s.t.‖Φ(xi)-a‖2=R2+ξi,ξi≥0 (i=1…Z1,u=1…Z2)

写出(11)的拉格朗日函数:

(12)

求L对各变量的偏导数,得到:

(13)

(14)

(15)

由于拉格朗日乘子γi>0,所以有0<βi (16) 由(14)计算(4)的分子: <Φ(Q),a>= (17) 设xsv为一支持向量,则(4)的分母计算为: R2=‖Φ(xsv)-a‖2 (18) 邻域大小r过大,SI和TI会包含冗余数据;r过小,则造成信息丢失.DISV根据I类内的局部信息对r进行个性化的设置,即每个类都有其特定的r.具体地,在I类内,计算距离矩阵:D= (dij)NI×NI.升序排列D的各行.随后,在各行上寻找产生最大间隔的位置:记gap(i)= maxj{dij-di,j-1},(i= 1…NI,j= 2…NI).最后,设定I类上的邻域尺寸为:r= average {gap(i)},(i= 1…NI). 目标函数(11)中,η是收缩远离球的收缩程度与远离程度之间的权衡系数.本文中,将根据类别大小为每一类设定因地制宜的η.对I类,仍记其训练子集SI和TnonI的大小为Z1和Z2,具体分析如下. 当Z1 首先使用二维人工数据集实验,其包含两个重叠类,如图4所示.将DISV与基于超平面的分类器进行比较:SVM,MVSVM[4],TWSVM[5]和PTSVM[6].图5至图9依次给出了五个分类器的结果.可见,各分类器在非重叠区域上均可做出正确决策.但在类间重叠区上,DISV有11个分类错误,SVM有25个分类错误,MVSVM、TWSVM及PTSVM各有26、19和17个分类错误.这说明双效分类思想有效,可帮助分类器获得类内的特征信息和类间的差异信息,以增强分类器的类属鉴别能力,从而在间隔数据上取得更高的分类准确率. 图4 数据集 图5 DISV分类结果 图6 SVM分类结果 图7 MVSVM分类结果 图8 TWSVM分类结果 图9 PTSVM分类结果 接着,在UCI[22]数据集上观察DISV与TCSVDD[7],MCM-SVM[8],THSVM[9],pSVDD[10],NSVDDv[11].由于pSVDD,TCSVDD与THSVM均为二分分类器,这里只选用二类数据集以避免集成策略等外在因素对分类器自身性能的影响.表1和表2记录了训练集和测试集上的分类准确率,其中”Traning Ratio”一列表示从数据中随机抽取的训练数据的比例,黑体表示最优结果. 表1 训练数据上的分类准确率(%)Table 1 Classification accuracy on training data (%) 表2 测试数据上的分类准确率(%)Table 2 Classification accuracy on testing data (%) 从表1中可得出如下结论: 1)除DISV外,6个超球体分类器在训练集上表现优异.这是由于它们的优化目标的本质目的是建立训练数据的描述,生成紧致的数据轮廓.为此,分类器会收集数据内部尽可能多的特征,以全面掌握训练数据的信息,因此它们能够对训练数据做出准确的类别判断. 2)DISV在训练集上的表现逊于超球分类器,但与最优结果的差距较小. 3)当训练数据增多,各个分类器的训练准确率都有所提高. 从表2可得如下结论: 1)DISV的测试准确率高于6个超球分类器.这说明相对于基于超球体的分类器,DISV有更高的推广能力.这也说明双效分类思想有效,可以避免出现过适应问题. 2)当训练数据较少时,DISV在测试集上相对于超球体分类器的优势更为明显.这是因为,基于超球的分类器仅仅依赖于学习类内的数据特征,当训练数据量少,得到的分类器的类属判断能力会有所下降.而DISV并不完全依赖于类内数据信息,小规模训练数据对DISV的影响并不明显,所以DISV表现良好. 3)当训练数据增多,所有分类器的测试分类准确率均提高. 继续使用UCI上的多类数据集进行实验,观察DISV与超平面分类器和超球体分类器的表现.对其中的二分分类器,采用OVO和OVA方式[23,24]将其集成,最终决策由投票机制确定.随机抽取20%的数据作为训练数据,其他数据作为测试数据.设PTSVM的映射方向数为1. 表3记录了10次独立实验中测试集上分类准确率的平均值及方差.可知,DISV在10个数据集中的6个上取得了较好的结果,在其余4个数据集上给出了与最优结果非常接近的结果.这说明了双效分类思想的有效性.由于GEPSVM、MVSVM、TWSVM和PTSVM生成了穿过数据的超平面,MSM-SVM,TCSVDD,和THSVDD生成了包围球,所以表3也说明,收缩远离球描述类内特征的能力强于超平面和包围球,其学习获得的类间差异信息确实帮助DISV拥有更强的分类能力.就7个二分分类器而言,大多数情形下,OVO方式优于OVA方式.这表明,集成方式确对二分分类器其在解决多分类问题时的结果有影响.注意到TWSVM在Thyroid和Flag上的OVA结果优于其OVO结果,MVSVM在Vowel上,以及pSVDD在Lung Cancer上也有类似情况,如表3中′*′所示.可见,当二分类分类器被用于解决多分类问题时,分类结果不仅与集成方式有关,也与数据本身密切相关. 表3 多类数据集上的测试准确率(%)Table 3 Testing classification accuracy on multi-class datasets (%) 5个超球分类器中,MCM-SVM的表现更好,但它的分类准确率仍低于DISV,原因在于两个方面.一是前者使用了包围球,后者使用收缩球.在描述数据内部特征时,后者能力更强.二是前者是通过令球面与其他类中的最近数据点的距离达到最大,来实现球与其他类数据的远离.这种做法非常易于受到孤立点及错误分布点的影响,导致超球体未能实现与其他类最大程度的远离.注意到在表2给出的二分数据集上的实验结果中,MCM-SVM的表现还不及THSVM,而在表3中,其表现已超过THSVM.这说明,THSVM作为二分分类器,解决二分问题时具有优势,而在解决多分问题时,受多个外部因素的影响,其最终分类能力有所降低. 实验使用MGH/MF和Fantasia数据集[26-28],使用WFDB软件[29]和Cygwin系统[30]对两数据集数据进行观察和处理.MGH/MF和Fantasia数据集分别包含了250个患者及40个健康人的心电记录.其中每个心电记录包含了三个文件:注释文件、心电数据文件和病史文件.实验主要对心电数据文件中的心电波形进行分析处理.视两次R波之间的波形为一次心跳,并在一个心电记录中,选择5次心跳描述该心电信息.由于一次心跳的波形由几百个采样点组成,这里选择50个采样点描述一次心跳过程,即,一次心跳由一个50维的心电向量进行描述.而一个心电记录由5个50维的心电向量进行描述.实验时,将向量中的各分量减去相应维上的平均值来做数据标准化. 训练数据抽取方案为:i){15,25};ii){15,35} ii){15,40};a){35,20};b){50,20};c){65,20};1){30,32};2){35,32}.大括号中的两个数表示分别从MGH/MF和Fantasia数据集中随机选择出的患者记录和健康人记录的数目,它们对应的心电向量将构成8个训练集,其他记录对应的心电向量则组成测试集.这8个训练集覆盖了三种情形:病人数据量小于、大于以及接近于健康人数据量. 为观察DISV的隶属度函数的质量,首先定义一个评价矩阵.设数据集{x1…xN}覆盖了M个类,该数据集上的个隶属度函数记为:f1,f2,…,fM.则对xi(i=1…N)关于fI的隶属度fI(xi)的评价定义为: (19) 其中label(xi)表示xi真正的类别号.整个数据集上的评价结果构成矩阵:W=(WiI)N×M.一般地,较小的WiI表示fI能够较好地表示xi在I类上的隶属程度.此时包含了两种情形.一是I恰为xi的真正类别号,此时WiI越小,fI(xi)越大,那么fI(xi)对“xi属于I类”这一决策的表达越强烈.二是I非xi的真正类别号,此时WiI越小,则fI(xi)越小,它对“xi属于I类”这一决策的表达则非常微弱.因此矩阵W可全面评价M个隶属度函数在数据集上的决策质量.进一步地,在W之上给出如下的测度,以期用一个标量表示隶属度函数的质量: (20) 显然,CE越小,隶属度质量越好. 本文设定NN为三层网络结构,各层的神经元数目分别为50,5/7/9/11和1.其中,隐层的神经元数目分别为5、7、9和11来生成四个不同的NN分类器,记作:NN1,NN2,NN3及NN4.它们的最大迭代次数设为104.各层的转移函数分别为g1(x)=x,g2(x)=2/(1+exp(-2x))+1和g3(x)=x.注意,四个神经网络分类器在训练过程中,以1和-1作为病人记录和健康人记录的理想输出值.这里基于输出层的结果g3(x),定义它们的隶属度函数为: (21) (22) 表4 软分类结果的CE值Table 4 CE values on soft decisions of classifiers 表4给出了各分类器的CE值.其中,MCM-SVM的软分类结果由文献[25]中的方法提供.由表4可知,在心脏肥大疾病诊断问题上,DISV的表现优于4个NN分类器和MCM-SVM.这说明,双效分类思想是有效的,它能够帮助DISV在训练分类器过程中同时收集类内的个性化特征信息和类间差异信息,进而得到具有更强的类属鉴别能力的分类器.实验中MCM-SVM的软分类结果质量好于四个NN分类器,这归功于支持向量技术在解决小样本、非线性问题上相对于神经网络方法的优势.从NN1到NN3,隐层神经元的数目减增,隶属度函数的质量也渐渐提高.但神经元数目并非越多越好.从NN3到NN4,虽然神经元数目增加,但隶属度的评估值并未减低反而增加,即,隶属度函数的质量有所降低.这说明,对本文实验中涉及到的心脏肥大实验数据而言,9个神经元是隐层神经元的最佳数目. 最后,观察DISV的硬分类结果.除了已经涉及到的分类器,这里还运行了LDSVM[31].LDSVM是基于SVM的一个集成分类器,由SVM和KNN组成.SVM在测试数据到达之前训练完成,当测试数据到达后,若SVM给出的决策结果的信心指数低于指定的阈值,则启动kNN,对初始决策进行修正.这里仍根据表4的方案生成8个训练数据集,其他数据作为测试数据.以分类正确率作为评价标准.表5给出了各分类器在10次独立实验的平均正确率和方差. 心脏肥大数据集中的数据的分布更复杂,类别之间的差异更模糊.在这样的数据上,DISV给出了优于同类分类器的表现,这再一次验证了双效分类思想的有效性和DISV可以克服类别之间有重叠及过适应问题的能力.其他各分类器的表现与前文进行二分时的实验结果类似,不再赘述,这里只观察LDSVM的分类结果.LDSVM的表现优于NN3,SVM,TCSVDD,pSVDD和NSVDDv,但次于其他三个分类器.深入分析LDSVM的SVM和kNN均是对间隔较为敏感的分类器.正如前文所述,心脏肥大数据的类间间隔模糊且复杂,即类间间隔内的数据会较其他数据集更多,这造成SVM给出更多的不佳决策需kNN修正.而kNN是根据基于SVM分界面函数定义的测度定义计算数据之间的距离,然后依据近邻原则给出决策.此时分类双方的重叠情况,使得SVM的分界面函数质量欠佳,当然由此定义的测度也受影响,从而令kNN的决策质量下降. DISV的时间耗费主要集中在三个方面.一是在设定邻域大小时,对数据的排序.若使用快速排序算法,则时间复杂度为O(Nc·log(Nc)),其中Nc是各类的平均大小.二是在求各点的切平面时在邻域里计算法向量,其复杂度为O(Nc·r).第三部分时间耗费在生成收缩远离球的二次优化过程上,为O((Z1+Z2)3),其中Z1和Z2是SI及TnonI的大小. 表6列出了相关分类器在二分及多分任务下的时间复杂度.其中′-′表示NN的训练过程涉及多种因素,其时间复杂度难以用显式的式子表达. 表5 DISV和同类算法的正确率比较 (%)Table 5 Comparison of accuracy of DISV with the peers 从表6中可得如下结论. 1)TCSVDD和MCM-SVM在二分任务下的时间耗费一致. 2)SVM和LDSVM在二分任务下的时间耗费一致,他们需要分类双方数据的参与生成间隔内的一个超平面. 3)多分任务下,SVM,LDSVM,TCSVDD的时间耗费一致. 4)表6虽不可给出确定性结论,但DISV是在训练子集上完成二次优化,其他分类器均在数据全集上进行优化,因此可通过设置训练子集的大小间接控制DISV的时间耗费,在算法运行代价上比同类算法有一定的灵活性. 表6 时间复杂度分析Table 6 Analysis of time complexity 本文提出了双效分类思想,该思想在训练分类器过程中同时学习类间差异信息和类内特征信息,从而克服基于超球体和基于超平面的分类思想遇到的过适应及难于解决重叠类别的问题.文中给出了双效分类思想的实现算法DISV,DISV为每一类构造收缩远离球,并基于此定义决策函数.收缩远离球与其他类保持最大程度的远离,且球面穿过类内密集分布区.为提高算法效率,根据数据的几何信息对训练数据进行约简,平衡系数及邻域尺寸也进行了自适应的设定.实验验证了双效分类思想的有效性,而且将DISV应用于心脏肥大数据,进行计算机辅助诊断,其表现优于同类算法. : [1] Vapnik V.Statistical learning theory[M].New York:Wiley Press,1998. [2] Vladimir C,Ma Y Q.Another look at statistical learning theory and regularization[J].Neural Networks,2009,12(7):958-969. [3] Mangasarian O,Wild E.Multisurface proximal support vector classification via generalize eigenvalues[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2006,28(1):69-74. [4] Ye Q,Zhao C,Ye N,et al.Multi-weight vector projection support vector machines[J].Pattern Recognition Letters,2010,31(13):2006-2011. [5] Khemchandani R,Chandra S.Twin support vector machines (TWSVM)for classification[M].Twin Support Vector Machines,Berlin:Springer,2017:43-62. [6] Chen X,Yang J,Ye Q,et al.Recursive projection twin support vector machine via within-class variance minimization[J].Pattern Recognition,2011,44(10):2643-2655. [7] Huang G,Chen H,Zhou Z,et al.Two-class support vector data description[J].Pattern Recognition,2011,44(2):320-329. [8] Hao P Y,Chiang J H,Lin Y H.A new maximal-margin spherical-structured multi-class support vector machine[J].Applied Intelligence,2009,30(2):98-111. [9] Peng X,Xu D.A twin-hypersphere support vector machine classifier and the fast learning algorithm[J].Information Sciences,2013,221:12-27. [10] Nguyen P,Tran D,Huang X,et al.Parallel support vector data description[C].Proceedings of International Conference on Artificial Neural Networks,2013:280-290. [11] Mu T,Nandi A K.Multiclass classification based on extended support vector data description[J].IEEE Transactions on Systems,Man,and Cybernetics,Part B (Cybernetics),2009,39(5):1206-1216. [12] Zhou H,Wang J,Wu J,et al.Application of the hybrid SVM-KNN model for credit scoring[C].Proceedings of 9th International Conference on Computational Intelligence and Security,IEEE,2013:174-177. [13] Nayak R K,Mishra D,Rath A K.A Naïve SVM-KNN based stock market trend reversal analysis for Indian benchmark indices[J].Applied Soft Computing,2015,35:670-680. [14] Tax D M J,Duin R P W.Support vector data description[J].Machine Learning,2004,54(1):45-66. [15] Shiraishi J,Li Q,Appelbaum D,et al.Computer-aided diagnosis and artificial intelligence in clinical imaging[J].Seminars in Nuclear Medicine,WB Saunders,2011,41(6):449-462. [16] El-Baz A,Beache G M,Gimel′farb G,et al.Computer-aided diagnosis systems for lung cancer:challenges and methodologies[J].International Journal of Biomedical Imaging,2013:1-46. [17] Chang W Y,Huang A,Yang C Y,et al.Computer-aided diagnosis of skin lesions using conventional digital photography:a reliability and feasibility study[J].PloS one,2013,8(11):e76212. [18] Anthony M,Bartlett P L.Neural network learning:Theoretical foundations[M].Cambridge University Press,2009. [19] Demuth H B,Beale M H,De Jess O,et al.Neural network design[M].Martin Hagan,2014. [20] Neural network models of conditioning and action[M].Routledge,2016. [21] Li Y.Selecting training points for one-class support vector machines[J].Pattern Recognition Letters,2011,32(11):1517-1522. [22] Arthur Asuncion,David Newman.UCI machine learning repository[EB/OL].http://archive.ics.uci.edu/ml/, 2017.5 [23] Galar M,Fernández A,Barrenechea E,et al.An overview of ensemble methods for binary classifiers in multi-class problems:Experimental study on one-vs-one and one-vs-all schemes[J].Pattern Recognition,2011,44(8):1761-1776. [24] Murino V,Bicego M,Rossi I A.Statistical classification of raw textile defects[C].Proceedings of the 17th International Conference on.IEEE,2004,4:311-314. [25] Hao P Y.A new fuzzy maximal-margin spherical-structured multi-class support vector machine[C].Proceedings of IEEE International Conference on Machine Learning and Cybernetics (ICMLC),2013,1:241-246. [26] Welch J,Ford P,Teplick R,et al.The massachusetts general hospital-marquette foundation hemodynamic and electrocardiographic database-comprehensive collection of critical care waveforms[J].Clinical Monitoring,1991,7(1):96-97. [27] Goldberger A L.Components of a new research resource for complex Physiologic signals,PhysioBank,PhysioToolkit,and PhysioNet,American heart association journals[J].Circulation,2000,101(23):1-9. [28] Iyengar N,Peng C K,Morin R,et al.Age-related alterations in the fractal scaling of cardiac interbeat interval dynamics[J].American Journal of Physiology-Regulatory,Integrative and Comparative Physiology,1996,271(4):1078-1084. [29] Moody G B.WFDB applications guide[J].Harvard-mit Division of Health Sciences and Technology,2003,10:30-31. [30] Vinschen C,Faylor C,Delorie D,et al.Cygwin user′s guide[M].Red Hat,1998. [31] Ling P,Gao D,Zhou X,et al.Improve the diagnosis of atrial hypertrophy with the local discriminative support vector machine[J].Bio-Medical Materials and Engineering,2015,26(s1):1813-1820.4 参数自适应设置策略

5 实验分析

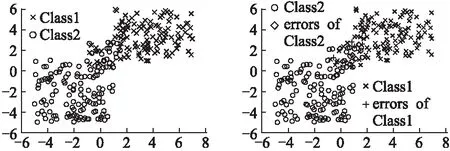

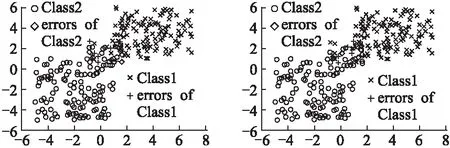

5.1 双效分类思想有效性测试

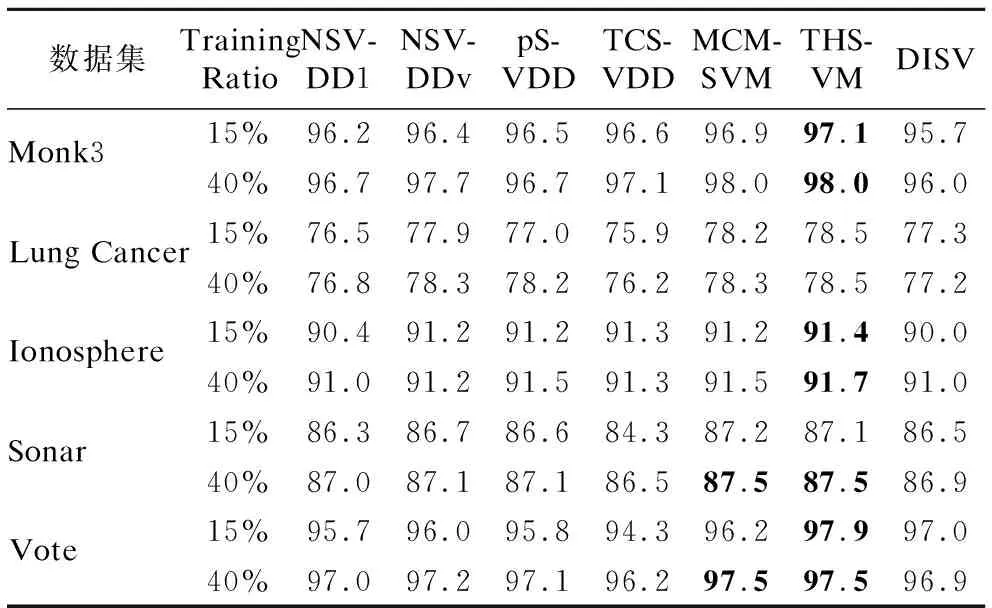

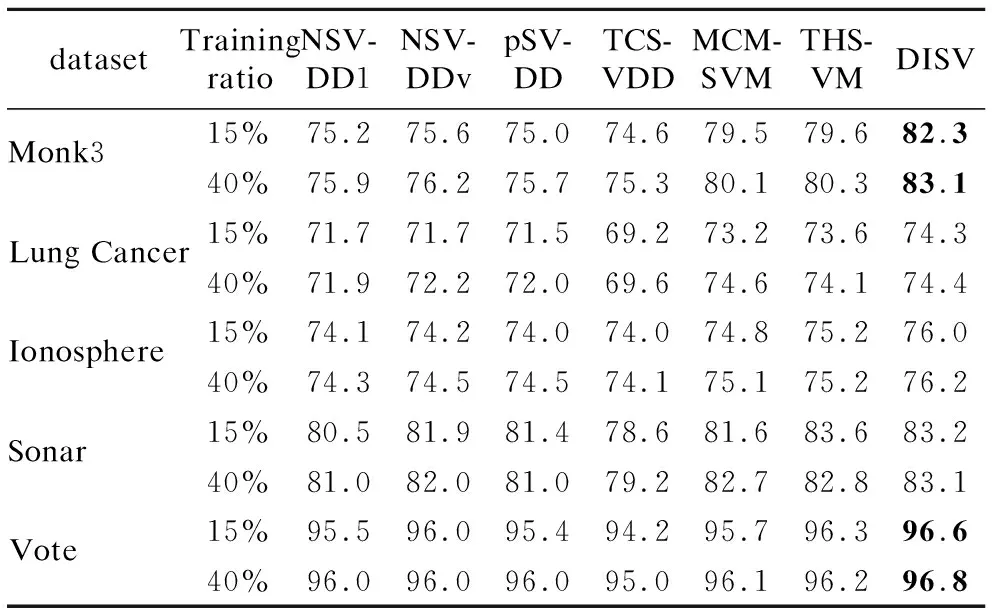

5.2 基准数据集上的实验分析

5.3 在心脏肥大数据上的应用

5.4 复杂度分析

6 结 论