基于全卷积网络的哺乳母猪图像分割

2017-12-20杨阿庆薛月菊黄华盛童欣欣朱勋沐杨晓帆

杨阿庆,薛月菊,3,4,黄华盛,黄 宁,童欣欣,朱勋沐,杨晓帆,毛 亮,4,郑 婵

基于全卷积网络的哺乳母猪图像分割

杨阿庆1,2,薛月菊1,2,3,4※,黄华盛5,黄 宁1,3,童欣欣1,2,朱勋沐1,2,杨晓帆1,毛 亮1,4,郑 婵1,2

(1. 华南农业大学电子工程学院,广州 510642;2. 广东省现代养猪数据化工程技术研究中心,广州 510642; 3. 广东省智慧果园科技创新中心,广州 510642;4. 广东省农情信息监测工程技术研究中心,广州 510642; 5. 华南农业大学工程学院,广州 510642)

猪舍场景下,光照变化、母猪体表颜色不均及与环境颜色对比度不大、母猪与仔猪的粘连等,均给目标分割带来很大的困难。该文提出了基于全卷积网络(FCN,fully convolutional networks)的哺乳母猪图像分割算法。以VGG16为基础网络,采用融合深层抽象特征与浅层细节特征并将融合的特征图上采样8倍的跳跃式结构,设计哺乳母猪分割的FCN。利用Caffe深度学习框架,以7栏伴有不同日龄仔猪的3811幅哺乳母猪训练样本进行母猪分割FCN训练,在另外21栏的523幅哺乳母猪测试集上的分割结果表明:该算法可有效避免光线变化、母猪颜色不均、小猪遮挡与粘连等影响,实现完整的哺乳母猪区域分割;分割的平均准确率达到99.28%,平均区域重合度达到95.16%,平均速度达到0.22 s/幅。与深度卷积网络的SDS(simultaneous detection and segmentation)及传统的基于图论的图像分割、基于水平集的图像分割方法做了对比试验,该文分割方法平均区域重合度分别比这3种方法高出9.99、31.96和26.44个百分点,有较好的泛化性和鲁棒性,实现了猪舍场景下哺乳母猪准确、快速分割,可为猪只图像分割提供了技术参考。

图像分割;算法;试验;全卷积网络;哺乳母猪

0 引 言

计算机视觉为猪的行为监测、体重监测和健康监 测[1-3],及母猪发情监测和分娩监测等[4-5]提供了强有力的技术手段。哺乳母猪行为反映了母猪健康和福利状态,其母性行为如哺乳行为[6]、高危动作[7]是仔猪成活率和生长发育的重要因素,关系到整个猪场的经济效益。因此,用计算机视觉自动分析哺乳母猪行为引起了研究者的广泛关注[8-10]。其中一个关键步骤和经典难题是将哺乳母猪完整地从背景中分离出来,即哺乳母猪分割。

猪只分割算法主要可分为静态图像分割和动态图像分割。常用的静态图像分割方法有阈值分割、边缘检测分割、分水岭分割、基于图论的分割和形态学分割等,如Guo等[11]采用自适应分区和多阈值分割对饮食区域猪只进行了分割;高云等[12]采用阈值分割与基于距离变换的分水岭分割算法,分割了粘连猪只。动态图像分割方法有光流法、帧差法和背景差分法等。Wang等[13]采用背景差分获取猪只目标区域。刘波等[14]通过采集猪只侧视深度图,采用背景差法,提取猪只前景。Guo等[15]利用混合高斯更新背景模型,并结合最大信息熵阈值,分割出小猪个体目标。为适应背景光线变化及前景运动缓慢或短暂滞留等情况的猪只检测,朱伟兴等[16]采用伪球边缘检测算子提取图像边缘,提出基于边缘像素模型的前景帧检测法。但由于前景帧检测依据的是边缘点的概率,故无法检测到前景的完整边缘,不适合作后继目标形状分析。刘龙申等[5]为检测限位栏中的母猪分娩,利用母猪臀部呈现半圆状的特征,构建半圆匹配的母猪分割模型;然后采用单高斯模型对背景建模,检测仔猪目标。上述动态图像分割方法仍难以完整地分割出缓慢移动或静止的目标。本文以梅花哺乳母猪为研究对象,母猪的身体毛色黑白相间,即使同一颜色区域颜色也不均,并且由于光线变化、小猪遮挡及粘连等因素,给母猪完整的分割带来极大的挑战。为此,需要研究更具普适性的哺乳母猪目标分割算法。

自2012年卷积神经网络(CNN,convolutional neural networks)再次兴起[17-19],研究者开始将CNN引入图像分割领域。Hariharan等[20]通过CNN进行目标定位,再利用掩膜在物体包围框中进一步精细分割,提出了协同检测和分割(SDS,simultaneous detection and segmentation),显著提高了图像分割性能。但该类方法需产生大量的建议区域,内存空间消耗大、时间长,且由于掩膜限制了感受区域大小,影响了分割精度。Long等[21]对CNN进行改进,提出了全卷积网络(FCN,fully convolutional networks)的图像语义分割算法,解决了上述问题,并很好地避免了光照不均匀、随机噪声等问题,在图像分割领域获得了新突破[22-24]。针对猪舍场景下花色不均匀的哺乳期梅花母猪图像分割问题,提出基于FCN的哺乳母猪图像分割算法。为猪只图像分割提供技术参考。

1 材料与方法

1.1 试验数据

试验数据采集自广东省佛山市三水区乐家庄养殖场,为获取不同哺乳母猪图像,分别于2016年5月30日(夏季,晴,光照强烈)、2016年11月29日和30日(冬季,晴转多云,光照温和)和2017年4月25日(春季,阴转小雨)进行3次采集,采集时间为8:00‒18:00。每间猪舍由40间猪栏组成,猪栏大小约为3.8 m×2.0×1.1 m,不同栏之间尺寸稍有差异。每间猪栏中均有一头哺乳母猪和10~15头仔猪,母猪体表均呈花色,大部分仔猪为纯黑色,个别仔猪呈花色。采用安装在猪栏顶部的Kinect2.0传感器垂直向下进行RGB-D视频图像采集,为适应不同尺寸猪栏整个区域的拍摄,每栏摄像机安装高度为190~270 cm不等。该文主要利用960×540像素的彩色图像,研究哺乳母猪分割。

1.2 哺乳母猪图像分割的全卷积网络结构

用于图像分类任务的CNN主要由卷积层、池化层、全连接层和softmax分类器层组成[21]。图像经过一系列卷积、池化和全连接后,输出的特征向量能准确识别图像类别,但由于丢失大量像素点,无法达到像素级分类的目的。FCN以CNN分类网络为基础,将全连接层转换为卷积层,以保留空间二维信息,再对卷积二维特征图进行反卷积恢复出原始图像大小,最后通过逐像素分类,获取每个像素类别,从而实现图像分割目的。VGG16[25]是一种经典的CNN结构,采用小尺度感受野以提取图像边缘细节特征,并增加深层卷积,提高了分类准确度。该文以VGG16为基础网络构建哺乳母猪图像分割的FCN,如图1所示。

注:C1、C2、…、C8表示卷积层;C1和C2分别表示连续的两个卷积层;C3、C4和C5分别表示连续的三个卷积层;P1、P2、…、P5表示池化层;2×C8表示对C8的输出结果进行2倍上采样;Fuse-P4表示P4和2×C8的融合结果;2×Fuse-P4表示对Fuse-P4进行2倍上采样;Fuse-P3表示P3和2×Fuse-P4的融合结果;H和W分别表示长和宽;每一层右下角的数值表示输出维度。

1)将全连接层转换成卷积层。利用与对应全连接层输入数据尺寸相同的卷积核,将VGG16的全连接层转化为C6、C7和C8卷积层[21]。其中最后一层卷积层C8输出结果称为热图,热图个数对应类别个数。本文图像分割实质上是母猪与背景的二分类问题,因此热图个数为2。热图中每个坐标点的值表示该位置像素点对应相应类别的概率。

2)增加反卷积层。当输入数据经过步长为2、池化窗口为2×2的池化层后,输出特征图长和宽的维数会降低到输入数据的1/2。图像经过VGG16网络中5次下采样,输出热图的长和宽分别是原图的1/32。FCN在热图之后增加反卷积层,对热图进行上采样以恢复出原始图像尺寸。

3)增加跳跃结构。CNN通过浅层卷积提取图像的细节特征,如边缘、角点等,深层卷积提取语义特征,如类别[26-27]。直接对最后一层卷积特征C8(热图)进行32倍上采样的方式称为FCN-32s,由于该方式只用深层卷积特征,导致浅层轮廓、角点等细节信息丢失,使得分割结果边缘轮廓粗糙、模糊。为融合浅层细节信息,该文设计了两种跳跃结构的FCN:1)FCN-16s-VGG16。在对C8进行2倍上采样(2×C8)的基础上,融合P4层特征,最后对融合后的结果(Fuse-P4)进行16倍上采样。2)FCN-8s-VGG16。在对Fuse-P4进行2倍上采样的基础上,融合P3层特征,最后对融合后的结果(Fuse-P3)进行8倍上采样。

1.3 分割结果评价指标

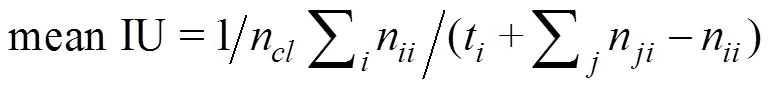

该论文主要利用业界公认的4种语义分割评价指标:统计像素准确率(pixel acc)、类别平均准确率(mean acc)、平均区域重合度(mean IU,intersection over union)和频率加权区域重合度(fw IU),进行分割结果的评价。各指标定义如下[21]:

(1)

2 哺乳母猪图像分割试验

2.1 试验方法

视频图像采集尽可能涵盖不同哺乳母猪花色、尺寸及不同仔猪日龄,3次共采集28栏,每栏拍摄时间长度为1~12 h不等。其前两次共拍摄7栏,最后一次拍摄21栏,仔猪日龄为1~30日。为加强和验证本文算法的泛化性能,从前两次拍摄的7栏视频图像中选取母猪不同姿态的视频帧作为训练样本,主要包括站立、侧卧、俯卧、腹卧和坐立等。从最后一次21栏中选取不同姿态的视频帧作为测试样本。在选择训练样本和测试样本时,母猪姿态未发生变化的视频段中仅随机选取其中一张,避免样本图像的时序相关性,确保样本的多样性。最后,共收集了3 811幅训练样本和523幅测试样本。

对训练样本和测试样本在动物行为专家指导下对母猪区域进行手工标注。母猪目标区域像素值设置为1,背景像素值置0,目标轮廓宽度为3个像素且像素值为255(表示不参与损失计算)。

对不同网络结构的FCN分割模型(包括以AlexNet[17]、CaffeNet[28]为基础网络的模型和不同跳跃结构的模型)进行对比分析;并与SDS[20]、基于图论的图像分割[29]和基于水平集的图像分割算法[30]进行对比。

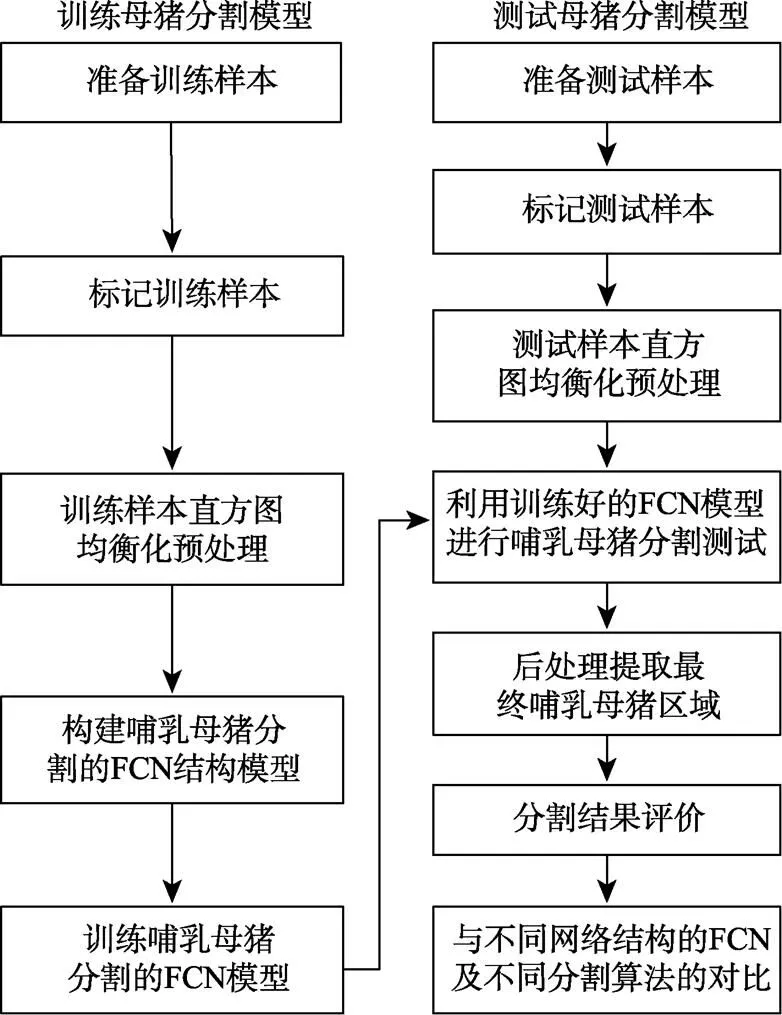

2.2 试验流程

本试验在Ubuntu14.04操作系统下,基于NVIDIA GTX 980 GPU的硬件平台上搭建Caffe深度学习框架,进行母猪图像分割的FCN模型训练和测试。具体流程如图2所示。

图2 基于全卷积网络的哺乳母猪图像分割试验流程图

主要过程描述如下:

1)拍摄哺乳期梅花母猪视频,准备训练样本和测试样本;

2)标记母猪分割样本,形成训练集和测试集;

3)对试验数据进行直方图均衡化预处理,减小亮度不均的影响;

4)在VGG16基础上构建FCN-8s跳跃式结构,并进行结构调整和参数设置,形成哺乳母猪分割的FCN结构;

5)利用训练样本训练哺乳母猪分割模型,以获取最优哺乳母猪图像分割模型;

6)训练好的分割模型对测试集进行分割;

7)对FCN的分割结果进行后处理,首先采用数学形态学闭运算填充空洞,再通过计算连通区域面积,剔除小面积区域,获取最终哺乳母猪区域;

8)选择图像分割的评价指标,进行分割结果统计评价;

9)对不同分割模型算法进行对比试验。

2.3 模型训练与测试

在训练过程中,对训练样本进行直方图均衡化,然后输入FCN-8s-VGG16网络进行前向传播,预测像素点类别,并通过与标记文件进行对比计算代价函数损失;采用带有冲量的随机梯度下降法进行反向学习,以获取最佳网络参数,冲量设置为0.95,固定学习率为10-12,权值的衰减系数为10-4,权值的正则化系数设置为5-4。当代价函数损失收敛且趋于平稳时,停止训练,整个训练过程历时20 273 s,共迭代30 000次,代价函数收敛至0.02。训练结束后,保存训练模型,并将测试集直方图均衡化后输入训练好的FCN模型进行母猪分割,最后采用5×5的磁盘结构体进行形态学闭运算填充空洞,并剔除小于面积阈值T(T=29 000)的连通区域。

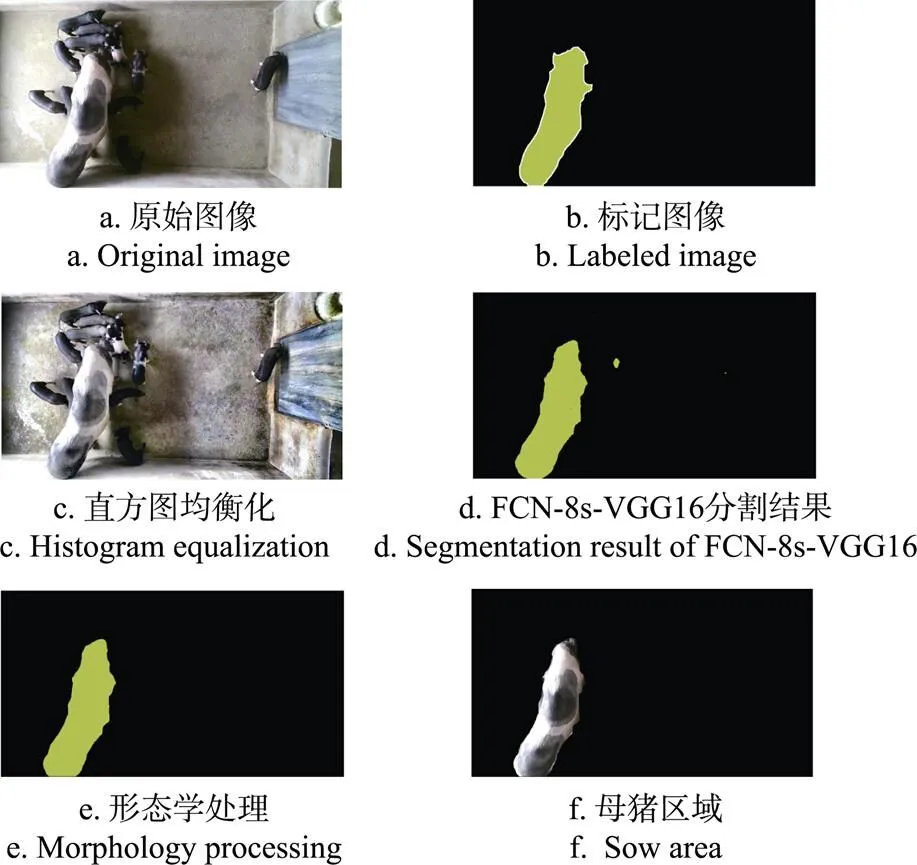

图3是本文算法对哺乳母猪图像分割过程示意图。在准备样本后,首先对原始图像进行直方图均衡化处理,以减少光照影响;将均衡化后的图像(图3c)输入FCN-8s-VGG16模型进行一次前向传播,输出结果如图3d,母猪轮廓清晰、区域完整,但有部分零星点及空洞;采用形态学进一步处理后结果如图3e,最后获取母猪区域如图3f。

图3 本文算法过程的示意图

3 结果与分析

3.1 FCN模型特征图可视化结果

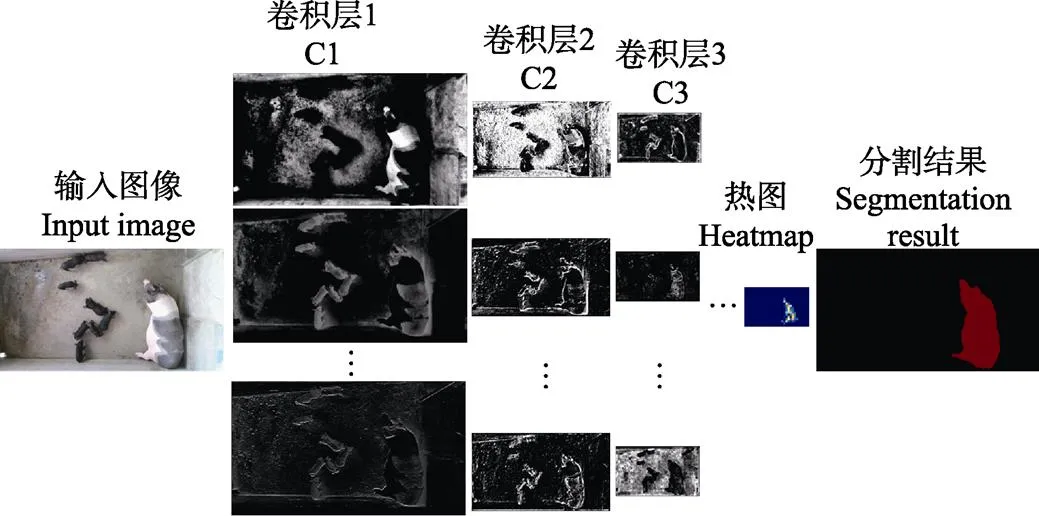

图4为FCN-8s-VGG16模型部分卷积层的输出结果,从图中可以看出,随着卷积深度的增加,产生的特征图越抽象,并且通过将前一层特征图像映射到不同灰度值区间内,如C1和C2层的特征图,以适应不同光照下的图像分割。

3.2 分割算法的精度比较与分析

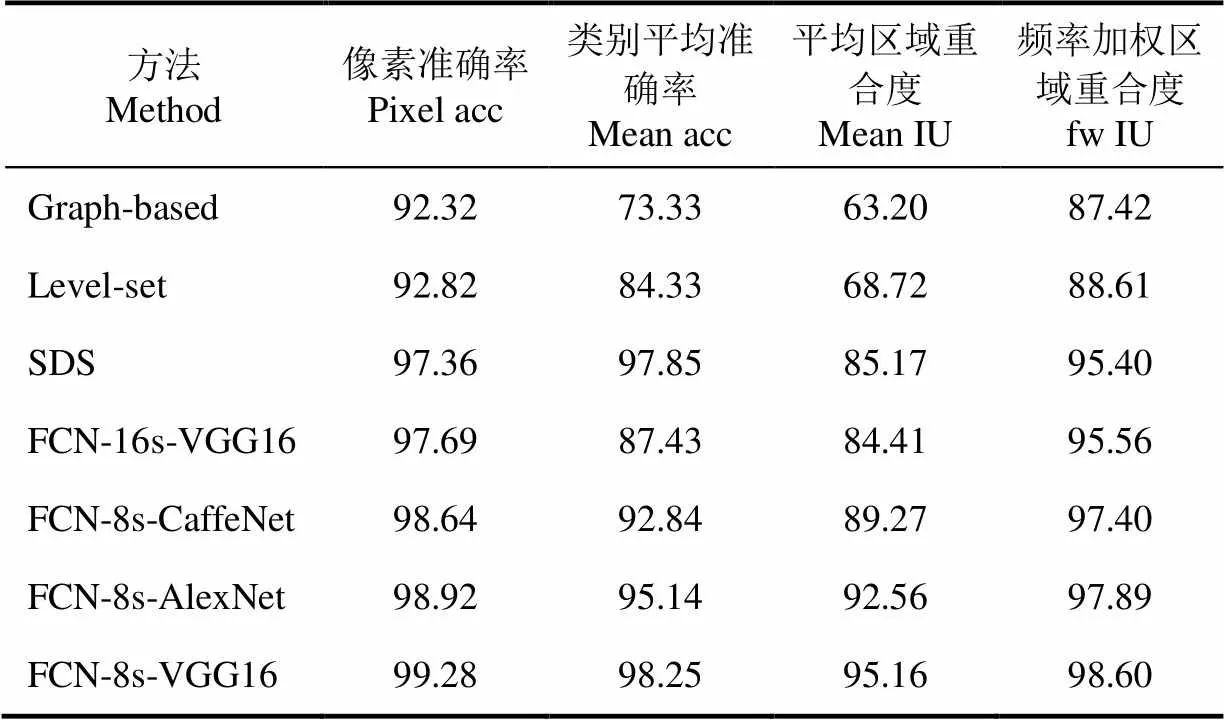

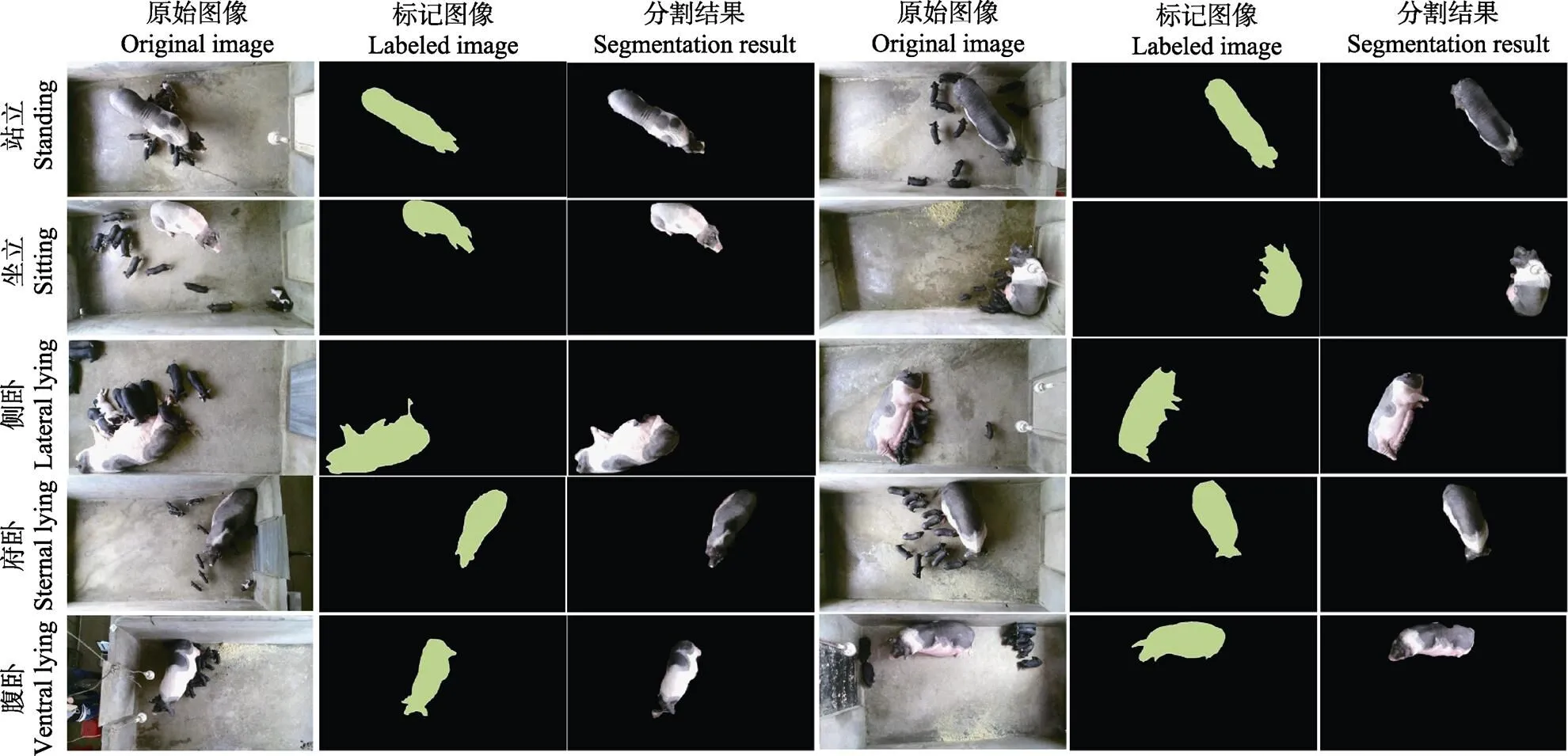

为测试本文算法的泛化能力,选取与训练样本不同栏的母猪视频图像作为测试样本,共计21栏523幅。表1给出了不同网络结构的FCN分割模型,及SDS、基于图论的图像分割(Graph-based)和基于水平集图像分割算法(Level-set)在测试集上的分割结果。图5展示了10组测试数据,代表10栏不同母猪、不同姿态下的分割结果。

图4 FCN-8s-VGG16模型的卷积特征图可视化

表1 不同网络结构及不同分割方法的性能比较

对分割结果分析如下:

1)从表1可以看出,本文算法FCN-8s-VGG16像素准确率和平均区域重合度分别为99.28%和95.16%,比不同网络结构模型FCN-16s-VGG16、FCN-8s-CaffeNet和FCN-8s-AlexNet的平均区域重合度分别高出10.75、5.89和2.60个百分点。可以看出本文的网络模型明显优于其他网络模型,主要是由于FCN-8s-VGG16相比FCN- 16s-VGG16融合了低层P3层卷积特征,保留了更多细节特征;另外,VGG16网络结构相比AlexNet和CaffeNet增加了卷积层个数,并采用小尺度卷积核提高了像素分类精度。

2)与近年提出的基于CNN语义图像分割的代表性方法SDS相比,平均区域重合度分别高出9.99个百分点,主要原因是SDS利用掩膜在物体包围框中进一步精细分割过程中,掩膜限制了感受区域大小,降低了提取的特征质量。与经典分割方法Graph-based和Level-set分割算法相比,平均区域重合度高出31.96和26.44个百分点,主要是因为CNN相比传统方法能够提取更丰富全面的高质量图像特征。需要说明的一点是,在采用传统方法试验时,只能根据图像背景、光照、母猪形态等不同状态,分别采用了不同参数以达到最优效果,无法用统一参数进行分割;而SDS和本文算法利用统一的模型进行测试集的图像分割。

3)在测试集上的平均区域重合度达到95.16%。说明本文算法对猪舍场景下,该类哺乳母猪有较好的泛化能力。由于拍摄高度、母猪大小均不相同,而分割结果并未受到尺度的影响,具有尺度不变性,且很好地解决了母猪体表颜色不均,与背景颜色相近的问题。

图5 本文算法对部分测试样本的分割结果

4)从图5的10组分割结果可以看出,当不同日龄仔猪或紧靠母猪或在吸乳,如第3行第1组和第2组,仔猪日龄分别为30日和3日,母猪腹部部分区域被仔猪遮挡,该方法仍可正确分割遮挡区域,几乎不影响母猪分割结果。这是因为FCN通过多层卷积操作能提取高质量的母猪特征,可有效将仔猪与母猪分开;后处理,通过剔除小面积区域可以有效剔除仔猪区域。该方法很好地解决了遮挡给母猪分割带来的困难,说明了该方法对小区域前景遮挡有较高的鲁棒性。

5)图5所展示的图像拍摄于不同时间段,猪舍中光线强度不同。比如第3行第1组数据拍摄于13:17分,光线从猪舍侧面照进来,导致母猪身体及地面部分区域曝光过度,而第4行第1组数据,母猪所处位置光线较暗。但是从分割结果来看,母猪区域均分割完整,轮廓清晰,未出现缺失,说明本文算法对光照变化有较好的鲁棒性,解决了光线不均给分割带来的困难。

6)分割结果中也出现局部区域缺失,主要体现在母猪身体靠墙部位、耳朵及嘴部局部区域。如图5第5行2组数据,由于母猪背部呈现黑色且靠近墙体,导致母猪背部与墙体间的阴影难以区分。同样,由于母猪头部呈现灰色或黑色,并且大部分时间母猪头部下垂,常伴有阴影,加之仔猪粘连等影响,造成头部分割困难。

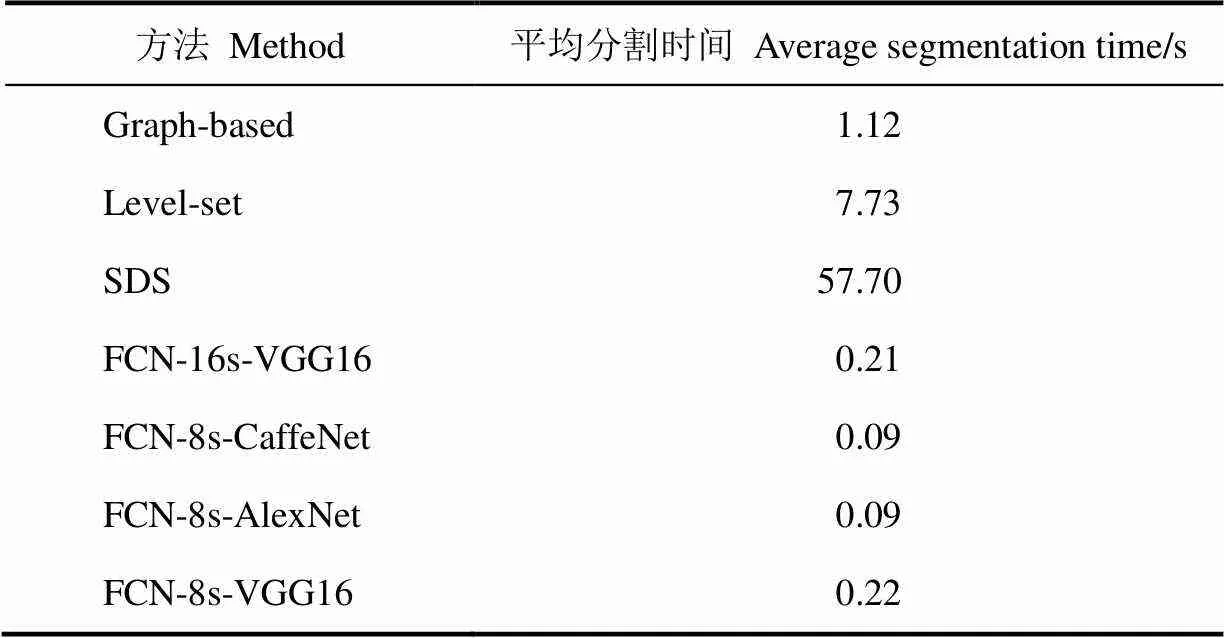

3.3 分割算法的运行速度比较

由表2可知,基于FCN算法的运行速度远远快于其他3种分割算法。原因在于:1)本文端对端(end-to- end)的FCN分割算法采用GPU并行计算,大大减少了计算时间;2)SDS在生成目标候选框的过程中,尚未实现GPU并行计算[20],极大地影响了SDS的速度。3)相比FCN-8s-CaffeNet和FCN-8s-AlexNet网络,FCN-8s-VGG16速度略低。这是由于VGG16网络结构较CaffeNet和AlexNet更为复杂。由于哺乳期母猪运动速度较慢,本文算法的分割速度可满足基本需求,而若对实时性要求较高,可以采用FCN-8s-AlexNet或FCN-8s-CaffeNet。

表2 不同方法在测试集上的分割速度比较

4 结 论

1)本文提出了一种基于FCN的母猪图像分割算法。以VGG16为基础网络,并采用FCN-8s跳跃网络结构,构建了母猪分割网络结构FCN-8s-VGG16,最后通过形态学处理提取母猪个体区域,有效完成了母猪分割的目的。该方法提取的母猪个体区域细节完整,轮廓清晰。结果表明,该方法分割的像素准确率达到99.28%,平均区域重合度达到95.16%,有很好的泛化性能和鲁棒性。

2)与SDS、基于图论的图像分割和基于水平集的图像分割方法相比,本文分割方法平均区域重合度分别比该三种方法高出9.99、31.96和26.44个百分点。

3)在GPU运行框架下,由于运用了并行计算,FCN-8s-VGG16、FCN-16s-VGG16、FCN-8s-CaffeNet和FCN-8s-AlexNet每幅图像分割的平均时间分别为0.22、0.21、0.09和0.09 s,具有良好的实时性。

本文所研究的对象只针对哺乳母猪,每幅图像中只有一个母猪对象及多只小猪,由于小猪身体比例较小,对母猪的影响相对较少。而在群养母猪大密度养殖场景中,母猪间的拥挤、粘连和遮挡,给分割带来很大难题。今后还需对群养母猪多目标分割进行进一步深入研究。

[1] Kashiha M, Bahr C, Haredasht S A, et al. The automatic monitoring of pigs water use by cameras[J]. Computers & Electronics in Agriculture, 2013, 90(90): 164-169.

[2] Kashiha M, Bahr C, Ott S, et al. Automatic weight estimation of individual pigs using image analysis[J]. Computers & Electronics in Agriculture, 2014, 107(3): 38-44.

[3] 纪滨,朱伟兴,刘波,等. 基于脊腹线波动的猪呼吸急促症状视频分析[J]. 农业工程学报,2011,27(1):191-195. Ji Bin, Zhu Weixing, Liu Bo, et al. Video analysis for tachypnea of pigs based on fluctuation ridge-abdomen[J]. Transactions of The Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2011, 27(1): 191-195. (in Chinese with English abstract)

[4] Ostersen T, Cornou C, Kristensen A R. Detecting oestrus by monitoring sows’ visits to a boar[J]. Computers & Electronics in Agriculture, 2010, 74(1): 51-58.

[5] 刘龙申,沈明霞,柏广宇,等. 基于机器视觉的母猪分娩检测方法研究[J]. 农业机械学报,2014,45(3):237-242. Liu Longshen, Shen Mingxia, Bo Guangyu, et al. Sows parturition detection method based on machine vision[J]. Transactions of the Chinese Society for Agricultural Machinery, 2014, 45(3): 237-242. (in Chinese with English abstract)

[6] 闫丽,沈明霞,姚文,等. 基于MPU6050传感器的哺乳期母猪姿态识别方法[J]. 农业机械学报,2015,46(5): 279-285. Yan Li, Shen Mingxia, Yao Wen, et al. Recognition method of lactating sows’posture based on sensor MPU6050[J]. Transactions of the Chinese Society for Agricultural Machinery, 2015, 46(5): 279-285. (in Chinese with English abstract)

[7] 闫丽,沈明霞,谢秋菊,等. 哺乳母猪高危动作识别方法研究[J]. 农业机械学报,2016,47(1):266-272. Yan Li, Shen Mingxia, Xie Qiuju, et al. Research on recognition method of lactating sows’dangerous body movement[J]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(1): 266-272. (in Chinese with English abstract )

[8] Lao F, Brown-Brandl T, Stinn J P, et al. Automatic recognition of lactating sow behaviors through depth image processing[J]. Computers & Electronics in Agriculture, 2016, 125: 56-62.

[9] Tu G J, Karstoft H, Pedersen L J, et al. Illumination and reflectance estimation with its application in foreground detection[J]. Sensors, 2015, 15(9): 21407-21426.

[10] Tu G J, Karstoft H, Pedersen L J, et al. Segmentation of sows in farrowing pens[J]. Iet Image Processing, 2014, 8(1): 56-68.

[11] Guo Y Z, Zhu W X, Jiao P P, et al. Multi-object extraction from topview group-housed pig images based on adaptive partitioning and multilevel thresholding segmentation[J]. Biosystems Engineering, 2015, 135: 54-60.

[12] 高云,郁厚安,雷明刚,等. 基于头尾定位的群养猪运动轨迹追踪[J]. 农业工程学报,2017,33(2):220-226. Gao Yun, Yu Houan, Lei Minggang, et al. Trajectory tracking for group housed pigs based on locations of head/tail[J]. Transactions of The Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(2): 220-226. (in Chinese with English abstract)

[13] Wang Y, Yang W, Winter P, et al. Walk-through weighing of pigs using machine vision and an artificial neural network[J]. Biosystems Engineering, 2008, 100(1): 117-125.

[14] 刘波,朱伟兴,杨建军,等. 基于深度图像和生猪骨架端点分析的生猪步频特征提取[J]. 农业工程学报,2014,30(10):131-137. Liu Bo, Zhu Weixing, Yang Jianjun, et al. Extracting of pig gait frequency feature based on depth image and pig skeleton endpoints analysis[J]. Transactions of The Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2014, 30(10): 131-137. (in Chinese with English abstract)

[15] Guo Y, Zhu W, Jiao P, et al. Foreground detection of group-housed pigs based on the combination of mixture of Gaussians using prediction mechanism and threshold segmentation[J]. Biosystems Engineering, 2014, 125(3): 98-104.

[16] 朱伟兴,纪滨,秦锋. 基于伪球算子边缘模型的猪前景帧检测[J]. 农业工程学报,2012,28(12):189-194. Zhu Weixing, Ji Bin, Qin Feng. Detection of foreground-frame of pig using edge model based on pseudosphere-operator[J]. Transactions of The Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2012, 28(12): 189-194. (in Chinese with English abstract)

[17] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[C]// International Conference on Neural Information Processing Systems. Curran Associates Inc. 2012: 1097-1105.

[18] Ren S, He K, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(6): 1137-1149.

[19] Ross Girshick, Jeff Donahue, Trevor Darrell, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2014: 1-8.

[20] Hariharan B, Arbeláez P, Girshick R, et al. Simultaneous detection and segmentation[J]. Lecture Notes in Computer Science, 2014, 8695: 297-312.

[21] Long J, Shelhamer E, Trevor Darrell. Fully convolutional networks for semantic segmentation[C]// IEEE Conference on Computer Vision and Pattern Recognition. 2015: 3431-3440.

[22] Dai J, He K, Sun J. Instance-aware semantic segmenta- tion via multi-task network cascades[C]// IEEE Conference on Computer Vision and Pattern Recognition. 2015: 3150-3158.

[23] Noh H, Hong S, Han B. Learning deconvolution network for semantic segmentation[C]// IEEE International Conference on Computer Vision. IEEE Computer Society, 2015: 1520-1528.

[24] Chen L C, Papandreou G, Kokkinos I, et al. Semantic image segmentation with deep convolutional nets and fully connected CRFs[J]. Computer Science, 2014(4): 357-361.

[25] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[C]// International Conference on Learning Representations. 2014: 1-14.

[26] Zeiler M D, Fergus R. Visualizing and understanding convolutional networks[C]//Europeon Conference on Computer Vision. 2013: 818-833.

[27] Ian Goodfellow, Yoshua Bengio, Aaron Courville. Deep Learning[M]. Cambridge city: MIT press, 2017: 240-241.

[28] Jia Y, Shelhamer E, Donahue J, et al. Caffe: Convolutional architecture for fast feature embedding[C]//ACM International Conference on Multimedia. ACM, 2014: 675-678.

[29] Hickson S, Birchfield S, Essa I, et al. Efficient hierarchical graph-Based segmentation of R-GBD Videos[C]// Computer Vision and Pattern Recognition. IEEE, 2014: 344-351.

[30] 毛亮,薛月菊,孔德运,等. 基于稀疏场水平集的荔枝图像分割算法[J]. 农业工程学报,2011,27(4):345-349. Mao Liang, Xue Yueju, Kong Deyun, et al. Litchi image segmentation algorithm based on sparse field level set[J]. Transactions of The Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2011, 27(4): 345-349. (in Chinese with English abstract)

杨阿庆,薛月菊,黄华盛,黄 宁,童欣欣,朱勋沐,杨晓帆,毛 亮,郑 婵. 基于全卷积网络的哺乳母猪图像分割[J].农业工程学报,2017,33(23): 219-225. doi:10.11975/j.issn.1002-6819.2017.23.028 http://www.tcsae.org

Yang Aqing, Xue Yueju, Huang Huasheng, Huang Ning, Tong Xinxin, Zhu Xunmu, Yang Xiaofan, Mao Liang, Zheng Chan.Lactating sow image segmentation based on fully convolutional networks[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(23): 219-225. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2017.23.028 http://www.tcsae.org

Lactating sow image segmentation based on fully convolutional networks

Yang Aqing1,2, Xue Yueju1,2,3,4※, Huang Huasheng5, Huang Ning1,3, Tong Xinxin1,2, Zhu Xunmu1,2, Yang Xiaofan1, Mao Liang1,4, Zheng Chan1,2

(1.5106422.510642,351064245106425510642)

The behaviors of a lactating sow reflect welfare and health that affect piglet survival and growth during lactation. Computer vision has been widely used to perceive the behavior of animals for precision husbandry, which is useful to increase the productivity and reduce the disease rate. Effective and accurate segmentation of individual lactating sow is a vital step to record and analyze the lactating sow behavior automatically. However, under real pigsty conditions, it is a challenge to segment lactating sow from the background due to occlusion, uneven color on sow body surface, variations of sow size and pose, varying illumination and complex floor status. In this paper, we proposed an algorithm for lactating sow image segmentation based on fully convolutional networks (FCN). To design FCN for accurate segmentation, VGG16 was chosen as a basic network where the fully connected lays were converted to convolutional layers, and the FCN-8s skip structure was designed by combining semantic information from a deep, coarse layer with appearance information from a shallow, fine layer. We called this network FCN-8s-VGG16. The steps of our work were as follows: First, top view images were taken from 28 pens of pigs under a real pigsty circumstance and a total of 4 334 images were obtained, of which 3811 training images were selected from images of 7 pens and 523 test images were selected from images of the other 21 pens. And, all the images in training set and test set were manually labeled. Second, adaptive histogram equalization was used to improve contrast in training images. Then, the pre-processed training set was fed into FCN-8s-VGG16 to develop an optimum FCN model by the fine-tuning of the network parameters using Caffe deep learning framework on an NVIDIA GTX 980 GPU (graphics processing unit). After that, test set was put into the trained model to obtain the segmentation results. Then, to fill holes within objects and remove small objects, a post-processing was performed by using a disk structure of mathematical morphology and calculating the areas of connected regions. Finally, we compared our FCN-8s-VGG16 network architecture with different network architectures including a different skip architecture (FCN-16s based) and 2 different basic networks (CaffeNet based and AlexNet based). Besides, comparisons with other methods were also conducted, including the previous state-of-the-art simultaneous detection and segmentation (SDS), Graph-based and Level-set algorithm. The results on the test set showed that the algorithm achieved a complete segmentation of lactating sow by minimizing the effects of uneven color, light variations, occlusions, adhesion between sow and piglets and complex floor status, with an average accuracy of segmentation of 99.3% and a mean regional coincidence degree of 95.2% at an average speed of 0.22 second per image. However, it is hard to completely segment the sow’s head when sow’s head is downwards to floor, or close to the wall or adheres to piglets. The comparison with different network architectures showed that the mean regional coincidence degree of our proposed network architecture was higher than that of the others, and on GPU, the segmentation speeds of our FCN-8s-VGG16, FCN-16s based, CaffeNet based and AlexNet based were 0.22, 0.21, 0.09, and 0.09 second per image, respectively, which had good real-time performance. The comparison with other methods showed that our FCN-8s-VGG16 model outperformed others, which improved the mean regional coincidence degree of SDS, Graph-based and Level-set by 9.99, 31.96 and 26.44 percentage point, respectively. All of the experimental results suggest that the proposed method demonstrates a higher generalization and robustness, and provides an effective access to accurate and fast segmentation of lactating sow image under a pigsty circumstance.

image segmentation; algorithms; experiments; fully convolutional networks; lactating sow

10.11975/j.issn.1002-6819.2017.23.028

TP391

A

1002-6819(2017)-23-0219-07

2017-05-15

2017-10-08

国家科技支撑计划(2015BAD06B03-3);广东省科技计划项目(2015A020209148);广东省科技计划(2015A020224038);广州市科技计划项目(201605030013);广州市科技计划项目(201604016122)

杨阿庆,陕西咸阳人,博士研究生。研究方向为机器视觉与图像处理。Email:yangaqing1204@163.com

薛月菊,新疆乌苏人,教授。研究领域为机器视觉与图像处理。Email:xueyueju @163.com