基于MROGH特征描述子的图像局部拷贝—旋转—移动行为取证

2017-09-18于立洋韩琦牛夏牧

于立洋+韩琦++牛夏牧

摘要: 各种数字图像编辑软件的普及让人们的生活更加多姿多彩,但同时也带来了更多的安全隐患——恶意的篡改者伪造图像、传播虚假内容的门槛极大地降低了。图像局部拷贝—移动(copy-move)是最为容易操作且有效的图像篡改手段之一,针对这种图像篡改手段的取证技术也在近年来受到了广泛关注。在图像的局部拷贝—移动篡改过程中,通常会包含一定程度的旋转操作,因此取证手段对于旋转的鲁棒性非常重要。本文提出了以筛选后的哈里斯角点结合MROGH(Multi-support Region Order-based Gradient Histogram)特征描述子的图像局部拷贝—旋转—移动篡改取证方法。实验证明,该方法具有良好的特征点覆盖率和旋转鲁棒性。

关键词: 图像取证; 局部拷贝—移动篡改检测; MROGH特征描述子; 哈里斯角点

中图分类号:TP309

文献标志码:A

文章编号:2095-2163(2017)04-0124-04

0 引言

图像的拷贝移动篡改是指针对一幅图像中的某处或多处区域在经由原型复制后,将其粘贴到同一幅图像的其他位置,从而达到夸大或掩盖事实的加工效果。这种操作方式简单易行,且由于篡改区域来自同一幅图像,而最终的效果图像又往往在光照、色彩和几何比例等方面表现出协调与一致,由此使得人们很难发现加于其上的伪造痕迹,因此这已然成为一种颇具现实发展空间的有效篡改手段。

近年来,针对图像局部拷贝—移动的检测方法已经日渐获得了学界的广泛关注。在众多的针对拷贝—移动行为进行取证的方法中,基于特征点的方法在鲁棒性和时空开销等方面表现出切实显著的优秀性能。然而在检测的查全率方面,这一方法却相对较弱。分析其原因主要在于,如SIFT(Scale-Invariant Feature Transform)[1]和SURF(Speeded Up Robust Feature)[2]等主流的特征点检测方法通常仅选择位于纹理丰富区域的特征点,用以保证特征能够具有良好的区分性,却由此将会引发平滑区域的篡改行为往往可能发生漏检。

另外,基于在篡改过程中多会涉及到旋转操作,这就使得对旋转的鲁棒性已然成为衡量取证技术的一个重要指标。目前大多数基于特征点的方法都采用了SIFT、SURF或旋转不变DAISY等描述子,而这些描述子的旋转不变性却依赖于构造描述子时,对特征支持区域的主方向估计,只是主方向的估计并不会一直始终准确,因此,基于特征点的取证方法在旋转鲁棒性方面仍存在有待提升的改进空间。

[JP3]综上,本文提出了一种新的基于特征点的区域拷贝—移动检测方法。该方法对于纹理和平滑区域的拷贝行为均有良好的检测能力,且具有更好的旋转鲁棒性。本文的主要创新如下:[JP]

首先,本文利用非极大值抑制(NMS,Non-Maximal Suppression)筛选哈里斯角点,在图像上获得满足一定密度要求的特征点,保证纹理和平滑区域均有特征点来实施覆盖;

其次,以MROGH算子[3]作为特征描述子。由于MROGH算子无需主方向估计,在理论上能够实现真正意义上的旋转不变,因此本文的方法具有更好的旋转鲁棒性。

本文的内容安排如下:第二节对近年来比较典型的基于特征點的局部拷贝—移动检测技术进行简要回顾,第三节详细阐述本文提出的方法,第四节给出实验结果,最后,在第五节,将对全文进行总结。

1相关工作简述

目前,针对图像局部拷贝—移动行为进行检测的方法可大致分为2类:基于块的方法和基于特征点的方法。本文的方法属于后者。在此,则对基于特征点的方法于近年来的重点进展进行简要回顾。

SIFT和SURF等局部特征在机器视觉和模式识别等领域取得了可观的成就,受此启发,近年来,研究者们逐渐尝试了将这些特征点和相应的特征描述子应用于图像局部拷贝的检测[4-6]。与传统的基于块的方法相比,基于SIFT或SURF等局部特征的方法在应对各种图像降质时,表现出优质理想的鲁棒性,同时这些方法又呈现了极其优异的时空开销。然而,为了保证能够获得足够的区分性,SIFT和SURF等特征通常位于纹理丰富区域,这无疑必将导致平滑区域的拷贝行为出现漏检。除了基于SIFT或SURF的方法,文献[7]以哈里斯角点作为特征检测子,并以哈里斯角点周围圆形邻域内像素的统计值作为局部特征。该方法要求用户对每幅输入图像均设置一个参数,该参数将设计用于控制特征点的密度。然而,对于一些图像而言,即使图像中的特征点总数已经迹近庞大,[JP2]某些平滑区域中可能依然不会含有足够的特征点而实现覆盖。在文献[8]中,Guo等人利用自适应非极大值抑制(ANMS,Adaptive Non-Maximal Suppression)来获取大致均匀分布的哈里斯角点,并利用旋转不变的DAISY描述子作为局部特征。然而,ANMS的作用是在图像中获得指定数量、而非特定密度的特征点,所以文献[8]必须为不同尺寸的图像指定不同的参数。此外,与SIFT和SURF等特征相似,文献[8]中采用的旋转不变DAISY描述子依赖局部支持区域的主方向来实现旋转不变,而主方向的估计却并不总会稳定、且可靠。[JP]

2本文方法

2.1特征检测及特征提取

[JP2]给定输入图像I,首先计算该图像每个像素(x,y)对应的角点强度CM(x,y)。与文献[8]不同的是,为了免除权重参数的选择,本文采用了Nobel[9]的方法计算角点强度,如式所示:[JP]

CM(x,y)=〖SX(〗AB-C2〖〗A+B〖SX)〗[HT5”][JY](1)

其中,

A=g(〖SX(〗I〖〗x〖SX)〗)2[HT5”][JY] (2)

B=g(〖SX(〗I〖〗y〖SX)〗)2[HT5”][JY] (3)endprint

C=g(〖SX(〗I〖〗x〖SX)〗·〖SX(〗I〖〗y〖SX)〗)[HT5”][JY](4)

运算符表示卷积操作,g为离散高斯核。

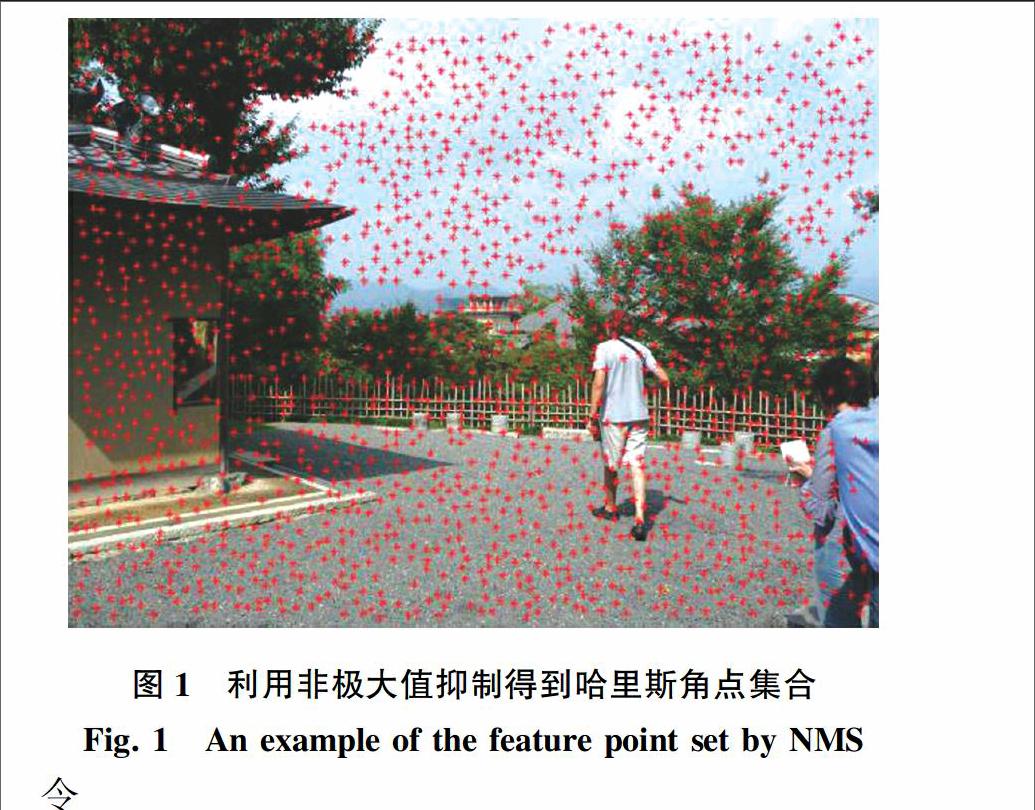

接下来对CM进行抑制半径为r的非极大值抑制,得到一个大致均匀分布、且满足一定密度要求的特征点集合,如图 1所示。为了保持图像清晰,图 1的示例中采用了较大的抑制半径r=30,本文的实验部分均采用r=5。

需要注意的是,本文使用了普通的非极大值抑制,而非文献[8]中采用的自适应非极大值抑制。这是因为自适应非极大值抑制的作用是获取固定数量、而非固定密度的特征点,就将导致对于不同分辨率的图像,用户必须调节不同的参数。可以看到,在对CM进行非极大值抑制后,在图像中的纹理和平滑区域均获得了大致均匀分布的特征点。

[PS于立洋1.EPS;S*1;X*1,BP#]

P={p1,p2,…,pn}[HT5”][JY](5)

表示图像I的特征点集合,对于每个pi∈P,i=1,2,…,n,研究在该点的邻域内提取MROGH特征作为该特征点的特征描述子,得到特征集合为:

F={f1, f2,…, fn}[HT5”][JY](6)

2.2特征匹配及后处理

对于每个特征fi∈F,i=1,2,…,n,本文采用kdtree在特征空间中搜索该特征的前k(在实验中,设置k=10)个最近邻,记为:

n1,n2,…,nk[HT5”][JY](7)

考虑到一对多的拷贝情形,本文采用了文献[4]提出的g2NN方法收集符合要求的匹配特征对。令D=d1,d2,…,dk为给定特征fi和其最近邻nj,j=1,2,…,k之间的升序距离集合,当满足条件:

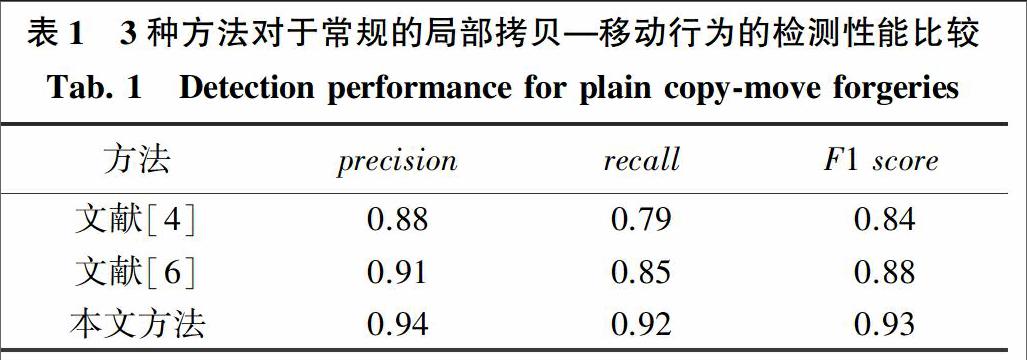

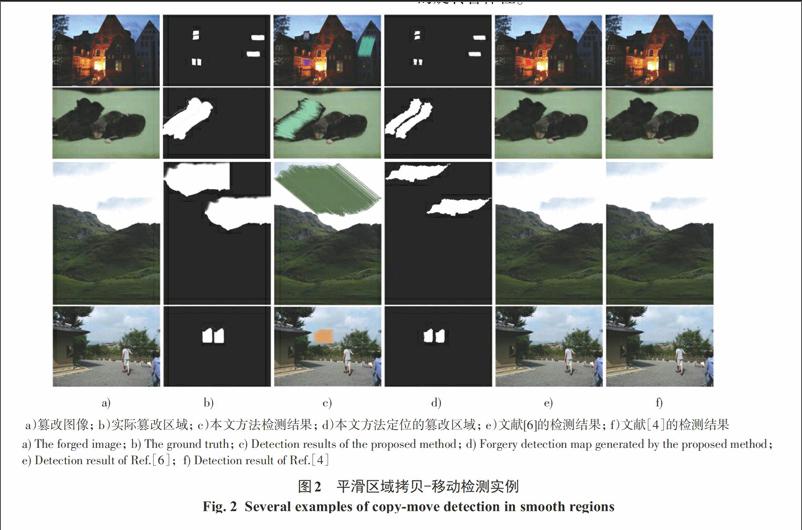

dm/dm+1 [JP2]时,g2NN在距离集合D中迭代地逐元素测试,直到不再满足式中的测试条件。假设w为g2NN测试的停止点,则fi的前w-1个最近邻n1,…,nw-1都将作为fi的合格匹配特征。本文的实验中,设置T=0.8。 在特征匹配完成后,将得到一个匹配特征对集合,下面将对该集合中的特征点进行基于空间距离的聚类。从任意随机特征点pi∈P开始,pi周围半径为R的环形区域内的所有特征点都被划分到pi所属的聚类。该过程持续到匹配特征对集合中的所有特征点都被划分到某个类中为止。在实验中,设置R=50。聚类完成后,由于确定一个二维仿射变换至少需要3对匹配特征,如此即将少于3个成员的聚类中的特征点删除。[JP] 相应地,在保留下来的聚类中,利用随机抽样一致算法[10](RANSAC,RANdom SAmple Consensus)在各个聚类间进行仿射变换估计。对于估计得到的每个单应矩阵,利用式(9)找到符合该变换的匹配特征对: Δ=[JB(=]H〖JB((〗〖HL(1〗xy1〖HL)〗〖JB))〗-〖JB((〗〖HL(1〗x′y′1〖HL)〗〖JB))〗[JB)=]2<Ε[HT5”][JY](9) 其中,(x,y,1)T和(x′,y′,1)T分别为一对匹配特征点的齐次坐标,[WT5”HX]H[WT5”BX]为估计得到的仿射变换单应矩阵,其数学表达如式(10)所示: H=〖JB([〗〖HL(3〗a11〖〗a12〖〗txa21〖〗a22〖〗ty0〖〗0〖〗1〖HL)〗〖JB)]〗[HT5”][JY](10) [HT5”]本文实验中设置E=4。对于每个单应矩阵的类内点,研究将再次进行基于距离的聚类,从而筛除孤立点。最后在剩余的特征点处进行形态学操作,生成篡改区域映射图,用于指示篡改区域。 3实验结果 本文采用了文献[11]中构建的图像局部拷贝检测数据集。本文的实验中,选择了该数据集中的“orig”,“nul”和“rotation”子集来验证本文方法的有效性。其中,“orig”子集包含48幅未篡改过的图像,“nul”子集中则包含了“orig”子集中每一幅图像所对应的篡改图像。而在“rotation”子集的篡改图像中,拷贝区域在粘贴之前,分别经历了2°、4°、6°、8°、10°、20°、60°和180°等不同程度的旋转。 [JP2]实验将以图像级的准确率(precision)、查全率(recall)和融合指标(F1 score)来评价检测性能,如式(11)~式(13)所示:[JP] precision=〖SX(〗TP〖〗TP+FP〖SX)〗[HT5”][JY] (11) [LL] recall=〖SX(〗TP〖〗TP+FN〖SX)〗[HT5”][JY](12) F1 score=〖SX(〗2×precision×recall〖〗precision+recall〖SX)〗[HT5”][JY](13) 其中,TP为正确地检测为篡改图像的样本数,FP为错误地检测为篡改图像的样本数,FN为漏检的篡改样本数。 [JP2]首先,基于“orig”和“nul”2个子集来评估本文方法对常规局部拷贝—移动行为的检测能力。这里是将本文的方法与2种典型的基于特征点的方法进行了对比,这2种方法分别基于SIFT[4]和SURF[6]。對比结果如表 1所示。图 2中给出了若干检测实例。由图2可知,拷贝的区域都属于相对平滑的区域,而这些区域中几乎并不存在SIFT和SURF特征点。在这些用例中,对于文献[4]和文献[6]中的方法而言,只有文献[6]能够检测出第一组测试中3处篡改中的一处,其他的拷贝区域均未能实现检测。并且,文献[6]在第一组测试中还出现了一处虚警。相比之下,本文的方法能够正确检测出所有拷贝的区域。[JP]

進一步地,研究又基于“rotation”子集进行旋转鲁棒性的测试。对于“rotation”子集中的每一种旋转角度,将分别以“orig”子集作为相应的负类样本。图 3给出了本文方法和文献[4]及[6]中方法对于旋转的鲁棒性对比实验结果。可以看到,随着旋转角度的增加,本文方法所对应的曲线具有更小的斜率,这表明本文方法与其他2种方法相比,具有更为强大的旋转鲁棒性。[FL)]

4结束语

[HT5”SS][ST5”BZ][WT5”BZ]

本文提出了一种基于特征点的图像局部拷贝—旋转—移动行为检测方法。该方法首先利用非极大值抑制来筛选哈里斯角点,得到大致均匀分布且满足一定密度要求的特征点,实现了对图像中不同区域的良好覆盖。对于每个特征点,研究则以MROGH算子作为局部特征,实现更强的旋转鲁棒性。

参考文献:

[1] LOWE D G. Distinctive image features from scaleinvariant keypoints[J]. International journal of computer vision, 2004, 60(2):91-110.

[2] Bay H, Tuytelaars T, Van Gool L. Surf: Speeded up robust features[M]//Leonardis A O, Bischof H, Axel P. Computer visionECCV 2006. Berlin Heidelberg:Springer, 2006:404-417.

[3] FAN B, WU F, HU Z. Aggregating gradient distributions into intensity orders: A novel local image descriptor[C]//Computer Vision and Pattern Recognition (CVPR), 2011 IEEE Conference on. Colorado, USA:IEEE, 2011:2377-2384.

[4] AMERINI I, BALLAN L, CALDELLI R, et al. A siftbased forensic method for copymove attack detection and transformation recovery[J]. Information Forensics and Security, IEEE Transactions on, 2011,6(3):1099-1110.

[5] PAN X, LYU S. Region duplication detection using image feature matching[J]. Information Forensics and Security, IEEE Transactions on, 2010,5(4):857-867.

[6] SHIVAKUMAR B, BABOO L D S S. Detection of region duplication forgery in digital images using surf[J]. IJCSI International Journal of Computer Science Issues, 2011,8(4):199-205.

[7] CHEN L, LU W, NI J, et al. Region duplication detection based on harris corner points and step sector statistics[J]. Journal of Visual Communication and Image Representation, 2012, 24(3): 244-254.

[8] GUO J M, LIU Y F, WU Z J. Duplication forgery detection using improved daisy descriptor[J]. Expert Systems with Applications, 2013,40(2):707-714.

[9] NOBLE J A. Finding corners[J]. Image and Vision Computing, 1988, 6(2):121-128.

[10]FISCHLER M A, BOLLES R C. Random sample consensus: a paradigm for model fitting with applications to image analysis and automated cartography[J]. Communications of the ACM, 1981,24(6):381-395.

[11]CHRISTLEIN V, RIESS C, JORDAN J, et al. An evaluation of popular copymove forgery detection approaches[J]. Information Forensics and Security, IEEE Transactions on, 2012,7(6) : 1841-1854.endprint