特征融合和模型自适应更新相结合的相关滤波目标跟踪

2016-10-10王春平

王 暐,王春平,李 军,张 伟

(1. 军械工程学院2系,河北 石家庄 050003;2. 中国人民解放军 63813 部队,海南 文昌 571339;3. 中国人民解放军 66285 部队,河北 怀来 571339)

特征融合和模型自适应更新相结合的相关滤波目标跟踪

王暐1*,王春平1,李军2,张伟3

(1. 军械工程学院2系,河北 石家庄 050003;2. 中国人民解放军 63813 部队,海南 文昌 571339;3. 中国人民解放军 66285 部队,河北 怀来 571339)

提出了一种基于自适应特征融合和自适应模型更新的相关滤波跟踪算法(CFT)。该算法在跟踪的训练阶段利用损失函数计算特征的自适应权重,在检测阶段对不同特征的响应图进行加权求和,从而实现了响应图层面的自适应特征融合。设计了自适应的模型更新策略,采用响应图的峰值旁瓣比判断是否发生遮挡或错误跟踪,据此决定是否在当前帧更新目标模型。在11个视频序列上对所提算法进行了实验,验证了所采用的自适应特征融合策略和自适应模型更新策略的有效性。与多个传统的采用单特征的相关滤波跟踪算法进行了比较,结果显示,所提算法的跟踪精度和成功率典型值分别提升了18.2%和11.5%。实验结果验证了特征融合和自适应模型更新对跟踪算法的改进具有指导意义。

视觉跟踪;相关滤波跟踪;特征融合;模型自适应更新

*Correspondingauthor,E-mail:wang_wei.buaa@163.com

1 引 言

目标跟踪是计算机视觉领域的基础性研究,在精密控制、自动驾驶、安全监控等场景有着广泛的应用[1-2]。自上世纪80年代,跟踪算法的研究主要经历了光流法[3]、基于mean shift的跟踪[4]和基于粒子滤波的跟踪[5]等。近十年来,许多学者采用机器学习方法设计鲁棒的跟踪算法,使视觉跟踪的研究有了长足进步[1],特别是最近比较热的一类是基于相关滤波的跟踪算法(Correlation Filter based Tracking, CFT),它具有精度高、速度快、鲁棒性好的特点[6],已成为了新的研究热点。

相关研究表明,特征表达对CFT的跟踪性能有非常重要的影响[7]。原始CFT仅利用灰度特征进行跟踪,Henriques等[7]对CFT特征进行了多通道扩展,利用角度梯度直方图(Histogram of Oriented Gradient, HOG)[8]进行跟踪,使算法的跟踪精度有了大幅提升。MARTIN等[9]采用颜色名[9]特征(Color Name, CN),并通过奇异值分解来提升跟踪速度,对彩色视频序列的跟踪取得了较大的提升。MA等[10]结合分层深度特征对CFT进行了改进。但是,每种特征是从不同方面对目标进行表达的,对各不同视频序列的跟踪性能差异较大。Yang等[11]将CN和HOG进行组合后用于CFT框架,提出了MF跟踪算法,实验结果表明特征融合能够有效提高跟踪性能。但文献[11]采用串接方式将CN和HOG进行组合,无法针对每个视频序列进行最优的特征融合。此外,CFT在跟踪时只采用线性累加的方式更新滤波器模型[6,7],易将不正确的目标表观更新到滤波器模型中,从而引起漂移。

为此,本文提出一种基于特征融合和模型自适应更新的相关滤波跟踪算法(Feature Fusing and model Adaptive Updating based Tracking method, FAUT)。首先,利用相关滤波响应图评估各特征的跟踪性能,在跟踪过程中自适应地对特征响应图进行加权,以提升跟踪性能。其次,设计了一种自适应的滤波器模型更新策略,根据响应图的峰值旁瓣比决定是否更新跟踪模型,提高了更新的可靠性。在若干视频序列上的对比实验验证了所提算法的有效性。

2 FAUT

本节将对所提算法进行详细描述:首先简要介绍CFT的基本原理,然后对特征在响应图层面的自适应融合进行具体描述,在2.3节给出自适应更新策略,最后对所提算法进行总结。

2.1CFT的基本原理

视觉跟踪的任务为:在视频序列的第一帧由人工或检测算法给定目标状态(一般为目标的最小外接矩形,需要指定矩形中心坐标和边长)的情况下,由跟踪算法估计目标在后续每一帧中的状态。

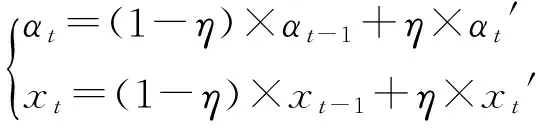

与大多数跟踪算法相同,CFT在每一帧的跟踪中包括两个阶段:目标检测和滤波器模型训练(更新)。第一帧时,由于目标状态已知,可直接根据目标状态训练滤波器模型,滤波器模型由滤波器系数α和目标模板x构成,目标模板x即目标区域的特征表达,滤波器系数α采用岭回归方法训练[6]。对于第t(t>1)帧图像,CFT首先根据第t-1帧训练的滤波器模型(αt-1,xt-1)进行相关滤波,得到滤波响应图,响应图的最大值处即对应检测到的目标状态;然后根据检测结果训练滤波器(αt′,xt′),接着采用线性插值更新滤波器,

(1)

其中,η为插值系数,实验中取固定值0.015。图1(彩图见期刊电子版)所示为CFT跟踪流程,具体细节请参考文献[6, 7]。

图1 CFT的一般跟踪流程图Fig.1 Flowchart of traditional CFT

图2 CN和HOG特征的特点示意图Fig.2 Characteristics sketch of CN, HOG features

2.2自适应特征融合

图2(彩图见期刊电子版)为当存在复杂背景+剧烈光照变化或目标存在连续姿态变化时,单独使用CN和HOG特征的结果。虽然CN和HOG特征都能有效提升CFT的跟踪性能[7,9]。但是,如图2上所示,当背景光照发生剧烈变化时,单独采用CN的CFT均不能有效地从背景中判别出目标;而如图2下所示,当目标发生较大形变时,单独采用HOG的CFT跟踪失败,表明HOG特征无法较好地处理目标变形、旋转等问题[11]。

事实上,CN和HOG的特征是互补的。如果在原始图像上进行差分操作(求梯度),将差分操作的次数称为阶次,则CN和HOG分别为图像的0阶和1阶特征,它们可从不同方面对图像进行表达。颜色和梯度对应视觉系统中不同层面的神经元,它们从不同的层面对图像进行抽象和特征提取,颜色对目标形状、尺度等具有较好的不变性,而梯度对光照等具有较好的不变性[12]。单个特征的表达能力有限,制约了CFT跟踪性能的提升,考虑到颜色和梯度特征的互补性,本文提出从滤波响应图层面进行特征融合,并从不同的方面对目标进行表达,以提升跟踪性能。同时,为了增加融合的适应性,在对不同视频序列进行跟踪时对特征进行自适应加权,以突出视频帧中更具判别力的特征。

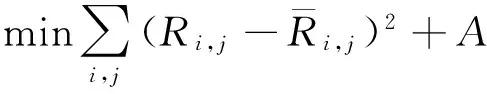

在跟踪训练阶段计算和更新特征权重。CFT采用岭回归方法训练滤波器,训练中采用如下的损失函数:

(2)

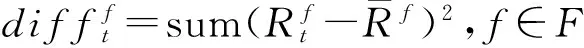

第t帧训练中,损失差的计算简写如下,

(3)

其中:sum(·)表示对矩阵内每一项求和,F={CN,HOG}表示特征的集合。特征f对应的归一化的权重为:

(4)

其中:{F-f}表示F中不同于f的另一特征。

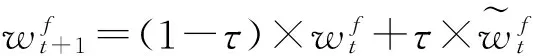

(5)

(6)

2.3自适应更新策略

由于跟踪过程中目标及背景是动态变化的,因此跟踪算法要对目标表观模型进行实时更新。传统的CFT采用式(1)的线性插值方法进行更新,能够保留目标在之前帧的滤波器模型,同时也可以及时将最新的表观加入到模型中。但是当跟踪出现偏差,或者目标被遮挡时,式(1)会将错误的目标表观信息引入到模型中,从而使跟踪误差不断累积,导致后续帧中引入的误差增大,最终导致跟踪失败,即产生所谓的漂移。为了避免上述问题,需要设计自适应的模型更新策略。

为了正确更新目标的表观模型,大多数跟踪算法[13]都通过对跟踪质量的评价实现,即检测跟踪中是否发生遮挡或较大误差。而跟踪质量评价方法应与具体的跟踪算法相结合。对于相关滤波跟踪,其滤波响应图的形状能够有效反映跟踪质量。当目标被遮挡或跟踪出现偏差时,滤波的响应峰值较小,当背景复杂或存在干扰物体时,滤波响应图的峰值附近会产生伪峰值,这两种情况均会使目标相对于背景的响应值不够突出。针对响应图的这种性质,参考文献[14],本文引入响应图的峰值旁瓣比(Peak to Sidelobe Ratio,PSR)对跟踪结果进行评价,PSR的计算方法如下,

(7)

其中:p为响应图Rt的最大值(峰值),峰值周围的区域定义为旁瓣,μ和σ分别为旁瓣区域的均值和标准差。实验中,将峰值周围c×γ的区域定义为旁瓣区域,以避免背景区域对PSRt值计算的干扰。PSRt越大,表明跟踪结果越可靠。本文预定义更新阈值U,只有当PSRt>U时,更新滤波器模型和权重,否则不更新。

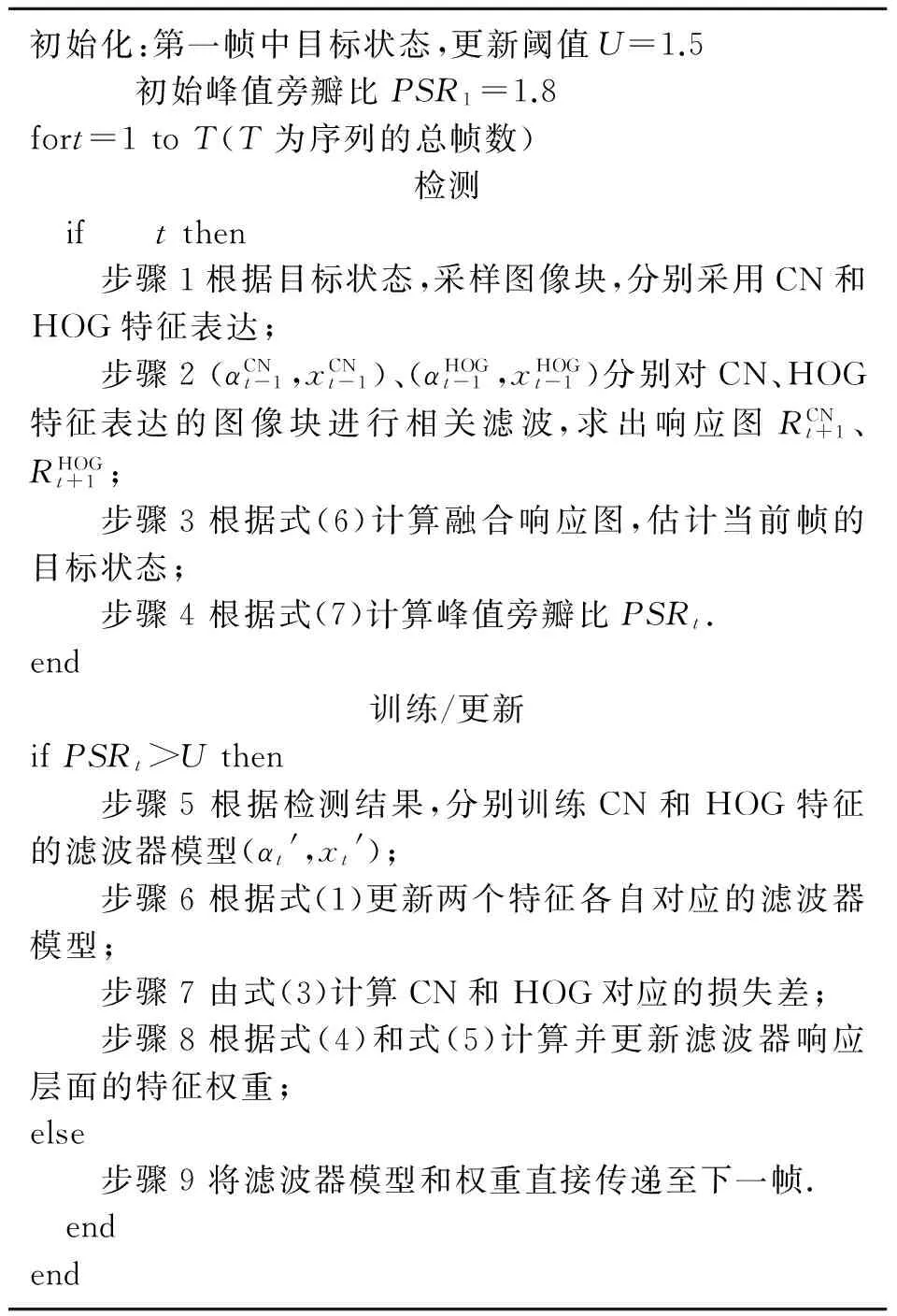

2.4所提算法

综上所述,FAUT算法的流程如下。

初始化:第一帧中目标状态,更新阈值U=1.5 初始峰值旁瓣比PSR1=1.8fort=1toT(T为序列的总帧数)检测 if tthen步骤1根据目标状态,采样图像块,分别采用CN和HOG特征表达;步骤2(αCNt-1,xCNt-1)、(αHOGt-1,xHOGt-1)分别对CN、HOG特征表达的图像块进行相关滤波,求出响应图RCNt+1、RHOGt+1;步骤3根据式(6)计算融合响应图,估计当前帧的目标状态;步骤4根据式(7)计算峰值旁瓣比PSRt.end训练/更新ifPSRt>Uthen步骤5根据检测结果,分别训练CN和HOG特征的滤波器模型(αt',xt');步骤6根据式(1)更新两个特征各自对应的滤波器模型;步骤7由式(3)计算CN和HOG对应的损失差;步骤8根据式(4)和式(5)计算并更新滤波器响应层面的特征权重;else步骤9将滤波器模型和权重直接传递至下一帧. endend

3 实 验

为评估所提算法的性能,本文进行了两组实验分析:一、对所提算法进行了详细的分析实验,以验证特征融合和更新策略的有效性;二、与其它7种算法在11个序列上进行了对比实验。

实验中,旁瓣区域的边长c和r为目标边长的0.1倍,预定义更新阈值U取为1.5,HOG特征提取参数的设置与文献[7]相同。

3.1FAUT算法分析

本文在视频序列Soccer上对提出的自适应特征融合策略和更新策略进行了实验分析。

3.1.1自适应特征融合

图3为CN和HOG特征在每帧的自适应权重值,可见在整个跟踪过程中特征权重不断变化。第31帧,目标存在快速运动,运动模糊导致目标结构信息丢失,表现为该帧的HOG特征响应图在非目标中心出现较大响应,而CN特征的响应较为集中,融合后的响应图能够确定目标中心。第210帧时,目标存在尺度变化,使得CN特征在距离目标中心较远处出现了高响应,而HOG特征的峰值响应则明显降低。但由于特征权重的自适应变化,融合后的响应图抑制了CN特征响应图中背景的高响应,使其具有了更明显的峰值。

3.1.2自适应更新策略

图4为跟踪中每帧的峰值旁瓣比PSR。在Soccer序列第44、156帧,目标处于候选区域中心,且较为清晰,故PSR值远大于自适应阈值U。第54、106、112帧,目标出现运动模糊或被严重遮挡,如果在这几帧更新滤波器模型,则会导致漂移。而本文由于采用自适应更新策略,上述帧的PSR值均小于阈值U,故不对滤波器模型进行更新。该序列的目标尺度在200帧以后逐渐变小,而所提FAUT采用的PSR能够在这种情况下保持较大的值,如第287帧,通过不断更新滤波器模型,实现了稳定跟踪。这也验证了所提自适应更新策略的有效性。

图4 峰值旁瓣比PSR结果(Soccer序列上)Fig.4 Results of PSR

实时性分析算法运行平台为配置2.6 GHz i5处理器、4 GB内存的普通电脑,仿真环境为Matlab 2014b。对于视频序列Soccer,本文算法、KCF和CNT每秒跟踪的帧数分别17.5、55.2和24.1,所提算法基本能满足实时性要求。

3.2算法对比分析

对所提FAUT算法进行了定量的对比分析。对比算法包括4种CFT框架下的算法:原始CSK[6](采用灰度特征)、CNT[9](采用CN特征)、KCF[7](采用HOG特征)、MF[11](采用CN和HOG直接组合的特征),以及其它3种近几年提出的跟踪算法:Struck[14]、CXT[15]、MIL[16]。采用的11个序列均来自于文献[1],包括:Bolt、Couple、Deer、Fish、Football、Football1、Freeman1、Matrix、MountainBike、Soccer、Tiger2。这些序列包含了光照变化、遮挡、变形、快速运动、旋转、背景干扰等跟踪中常见的挑战性场景,保证了公平对比。

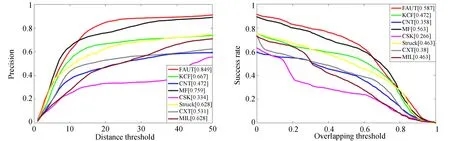

在分析中采用精度曲线和成功率曲线进行定量对比。某一帧图像中,跟踪算法的跟踪框与标注的真实目标框的中心距离称为距离精度,两个框的重叠面积与总面积之比为重叠率。精度曲线的横轴为给定的距离精度阈值,纵轴为跟踪的距离精度大于给定阈值的图像帧占所有图像帧的比例。通常取阈值为20个像素时的精度曲线值(P20)为典型值。成功率曲线的横轴为给定的重叠率阈值,当跟踪的重叠率大于给定阈值时认为该帧跟踪成功。成功率曲线的纵轴为跟踪成功的帧占所有图像帧的比例,将曲线下方的面积(AUC)作为该曲线的典型值。

图5(彩图见期刊电子版)为本文算法和其它7种算法在11个序列上的精度曲线和成功率曲线。由图5可见,FAUT算法的跟踪精度和成功率明显高于Struck、CXT和MIL。在5种CFT框架下的跟踪算法中,3种采用单独特征的算法(即KCF、CNT和CSK)性能差异较大,这验证了特征对CFT跟踪算法的重要性。实验结果还显示,采用特征融合算法(即所提FAUT和MF)的性能明显优于KCF、CNT和CSK。相比于单特征中性能最优的KCF算法,所提FAUT的P20和AUC分别提高了18.2%(0.849 vs 0.667)和11.5%(0.587 vs 0.472),这是因为多特征融合能够从不同方面对目标进行表达,从而提高了跟踪算法的判别力,验证了本文特征融合策略的有效性。相比于通过串接HOG和CN特征直接进行融合的MF算法,FAUT避免了错误的滤波器模型更新,P20和AUC最大分别提高了9%和2.4%,验证了更新策略的有效性。

图5 所提FAUT算法与其它7种算法的性能对比结果Fig.5 Tracking results of proposed FAUT method and other 7 tracking methods

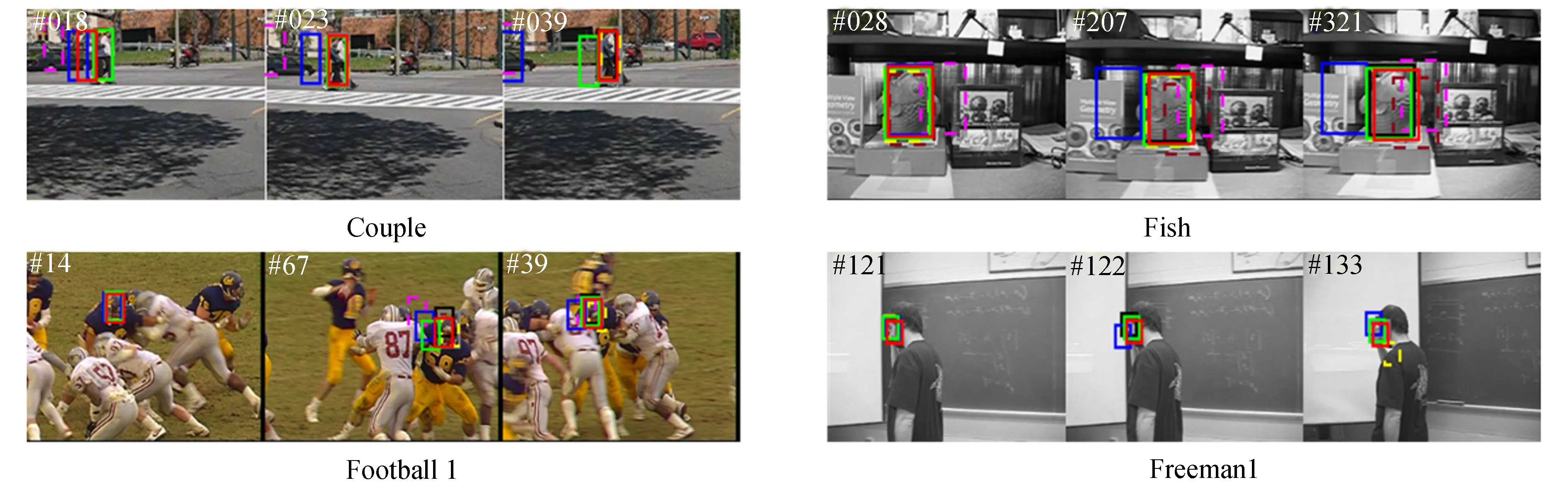

图6(彩图见期刊电子版)为FAUT与其他7种算法的定性分析结果,本文主要对FAUT、CNT、KCF、MF等4种算法进行对比分析。

Couple序列:第18帧中,背景车辆与目标颜色相似,导致本文FAUT和CNT出现跟踪偏差,但由于PSR小于预定义的阈值,FAUT未更新目标模型,且由于FAUT采用了目标的纹理信息(即HOG特征)进行跟踪,使目标更易于从背景中区分出来,所以在第23帧中FAUT又重新捕获了目标。第39帧中,目标与背景的颜色差异较大而具有类似的纹理信息,导致KCF跟踪失败,而FAUT和MF能够继续跟踪目标。

Fish序列:该序列为灰度序列,所以仅采用颜色信息的CNT跟踪失败。目标具有明显的纹理,所以FAUT、KCF和MF均能成功跟踪目标。

Football1序列:该序列中目标快速运动且背景变化较大,导致多数算法在第67帧中跟踪失败,只有所提FAUT能够准确跟踪运动员头部,这进一步验证了特征融合和自适应更新的有效性。

Freeman1和Football序列:在这两个灰度序列上CNT依然最早丢失目标,而其他3种算法则能够实现准确跟踪,且FAUT的跟踪结果最准确。

Deer序列:第25帧,由于目标的快速运动出现了模糊,导致HOG特征的判别力下降,KCF丢失目标。第29帧,MF由于错误的模型更新发生漂移,而所提算法依然能准确跟踪目标。

MountainBike序列:该序列中目标与背景在颜色和纹理上差别均较为明显,且不存在遮挡现象,所以CFT框架下的几种算法均能准确跟踪目标。

Tiger2序列:第227帧中,目标被强光照射,颜色特征失效,MF和CNT跟踪发生偏差,KCF和所提FAUT则能够准确跟踪。第343帧中,由于旋转目标纹理发生较大变化,KCF跟踪失败,而其它3种采用了颜色特征的CFT算法则可稳定跟踪目标。

上述定性分析进一步表明本文所采用的自适应特征融合和更新策略有效提升了跟踪效果。

图6 所提FAUT与其它7种算法的跟踪结果展示。图2、图3和图4已经对序列Bolt、Matrix、Soccer进行了分析,故此处不再列出。Fig.6 Screenshots of tracking results for FAUT and other 7 methods

4 结 论

本文从自适应特征融合和自适应模型更新两个方面对CFT进行了研究。首先,将CN和HOG两种互补的特征在滤波响应图层面进行融合,并利用训练过程中的损失函数自适应地计算特征权重。其次,针对原始CFT在每一帧中无差别地更新滤波器模型,会导致错误跟踪或发生遮挡时滤波器模型性能恶化,利用滤波响应图的峰值旁瓣比对遮挡和错误跟踪进行评估,实现了自适应更新。通过对所提FAUT算法的详细分析和与其他算法的对比实验,得出FAUT较其它CFT框架下的跟踪算法性能更优,验证了特征融合和自适应模型更新对跟踪算法的重要性,对后续跟踪算法的研究有一定的指导意义。

[1]WU Y, LIM J, and YANG M H. Online object tracking: A benchmark[C].2013IEEEConferenceonComputerVisionandPatternRecognition(CVPR),Portland,USA, 2013: 1354-1362.

[2]YILMAZ A, JAVED O, SHAH M. Object tracking: a survey[J].ACMComputingSurveys, 2006, 38(4):1-45.

[3]DECARLO D, METAXAS D. Optical flow constraints on deformable models with applications to face tracking [J].InternationalJournalofComputerVision, 2000, 38(2): 99-127.

[4]COMANICIU D, RAMESH V, MEER P. Kernel-based object tracking[J].IEEETransactiononPatternAnalysisandMachineIntelligence, 2003, 25(5):564 -577.

[5]MEI X,LING H B. Robust visual tracking and vehicle classification via sparse representation[J].IEEETransactionsonPatternAnalysisandMachineIntelligence, 2011, 33(11): 2259 -2272.

[6]HENRIQUES J F,CASEIRO R, MARTINS P,etal.. Exploiting the circulant structure of tracking-by-detection with kernels[C].EuropeanConferenceonComputerVision,Florence,Italy, 2012: 702-715.

[7]HENRIQUES J F,CASEIRO R,MARTINS P,etal..High-speed tracking with kernelized correlation filters[J].IEEETransactionsonPatternAnalysisandMachineIntelligence, 2015, 32(9): 1627-1645.

[8]FELZENSZWALB P F,GIRSHICK R B,MCALLESTER D,etal..Object detection with discriminatively trained part-based models[J].IEEETransactionsonPatternAnalysisandMachineIntelligence, 2010, 32(9): 1627-1645.

[9]MARTIN D, FAHAD S K, MICHAEL F,etal.. Adaptive color attributes for real-time visual tracking[C].IEEEConferenceonComputerVisionandPatternRecognition,Columbus,USA, 2014: 1090-1097.

[10]MA C, HUANG J B, YANG X K,etal.. Hierarchical convolutional features for visual tracking [C].InternationalConferenceonComputerVision,Santiago,Chile, 2015: 3038-3046.

[11]YANG L, ZHU J K. A scale adaptive Kernel correlation filter tracker with feature integration[C].EuropeanConferenceonComputerVision,Zurich,Switzerland, 2014: 254-265.

[12]JIANG Y S, MA J W. Combination features and models for human detection[C].IEEEConferenceonComputerVisionandPatternRecognition,Boston,USA, 2015: 240-248.

[13]WANG N Y, SHI J, YEUNG D,etal.. Understanding and diagnosing visual tracking systems[C].InternationalConferenceonComputerVision,Santiago,Chile, 2015: 3101-3109.

[14]BOMLE D S, BEVERIDGE J R, DRAPER B A,etal.. Visual object tracking using adaptive correlation filters[C].IEEEConferenceonComputerVisionandPatternRecognition,SanFrancisco,USA, 2010: 2544-2550.

[15]SAM H, AMIR S,PHILIP H. Struck: Structured output tracking with kernels[C].InternationalConferenceonComputerVision,Barcelona,Spain, 2011: 263-270.

[16]THANG B, NAM V, GERARD G M. Context tracker: Exploring supporters and distracters in unconstrained environments[C].IEEEConferenceonComputerVisionandPatternRecognition,ColoradoSprings,USA, 2011: 1177-1184.

[17]BORIS B, YANG M H, SERGE J B. Visual tracking with online multiple instance learning[C].IEEEConferenceonComputerVisionandPatternRecognition,Miami,USA, 2009: 983-990.

王暐(1989-),男,甘肃靖远人,博士研究生,主要从事计算机视觉、嵌入式系统设计方面的研究。E-mail:wang_wei.buaa@163.com

王春平(1965-),男,陕西汉中人,教授,博士生导师,主要从事图像处理、火力控制理论与应用方面的研究。E-mail:wchp17@139.com

(版权所有未经许可不得转载)

Correlation filter tracking based on feature fusing and model adaptive updating

WANG Wei1*,WANG Chun-ping1, LI Jun2, ZHANG Wei3

(1.The2ndDepartment,OrdnanceEngineeringCollege,Shijiazhuang050003,China; 2.The63813UnitoftheChinesePeople′sLiberationArmy,Wenchang571339,China; 3.The66285UnitoftheChinesePeople′sLiberationArmy,Huailai571339,China)

A Correlation Filter based Tracking(CFT) method based on adaptive feature fusing and model adaptive updating is proposed. The proposed method computes the adaptive feature weights by using the loss function of a filter model in training stage, and performs the weighted summing for response maps with multiple features in detection stage. Then it realizes the adaptive feature fusing of response maps. Furthermore, an adaptive model updating strategy is designed to estimate the occlusions and wrong tracking results by utilizing the Peak to Sidelobe Ratio (PSR) of the response maps. The model is updated only when the PSR is small enough. The proposed method is tested on 11 video sequences to verify the validity of the proposed adaptive feature fusing and model adaptive updating strategies. Comparing with other CFT methods by using single feature, the proposed tracker has significantly improvements, by 18.2% in representative precision score and 11.5% in representative success score. Experimental results demonstrate that the adaptive feature fusing strategy and model updating strategy are all effective for improving tracking performance.

vision tracking; correlation filter tracking; feature fusion; model adaptive updating

2016-06-06;

2016-06-24.

国家自然科学基金资助项目(No.61141009)

1004-924X(2016)08-2059-08

TP391

A

10.3788/OPE.20162408.2059