一种基于深度学习的异构多模态目标识别方法

2016-09-12文孟飞胡超刘伟荣

文孟飞,胡超,刘伟荣

(1. 中南大学 信息科学与工程学院,湖南 长沙,410083;2. 湖南省教育科学研究院,湖南 长沙,410005;3. 中南大学 信息与网络中心,湖南 长沙,410083;4. 中南大学 医学信息研究湖南省普通高等学校重点实验室,湖南 长沙,410083)

一种基于深度学习的异构多模态目标识别方法

文孟飞1,2,胡超3,4,刘伟荣1

(1. 中南大学 信息科学与工程学院,湖南 长沙,410083;2. 湖南省教育科学研究院,湖南 长沙,410005;3. 中南大学 信息与网络中心,湖南 长沙,410083;4. 中南大学 医学信息研究湖南省普通高等学校重点实验室,湖南 长沙,410083)

提出一种基于深度学习的异构多模态目标识别方法。首先针对媒体流中同时存在音频和视频信息的特征,建立一种异构多模态深度学习结构;结合卷积神经网络和限制波尔兹曼机的算法优点,对音频信息和视频信息分别并行处理,生成基于典型关联分析的共享特征表示,并进一步利用时间相关特性进行参数的优化。分别使用标准语音人脸库和截取的实际电影视频对算法进行实验。研究结果表明:对于这2种视频来源,所提出方法在目标识别的精度方面都有显著提高。

目标识别;深度学习;卷积神经网络;限制玻尔兹曼机;典型关联分析

网络技术的发展使互联网上各种非结构化的海量媒体数据流业务迅速增长[1]。如何建立起一种高效、准确的媒体数据流目标识别方法已成为国内外学者的研究热点[2]。现今互联网上 85%以上的数据业务包含了非结构化的图像、音频和视频等媒体数据[3]。迫切需要根据媒体数据流的特性和规律,进行有效的特征提取和目标识别[4]。机器学习是目标识别的主要方法,目前已经从浅层学习[5-9]发展到深度学习。浅层结构需要依靠人工来抽取样本的特征,难以将其扩展到视频的特征提取[10]且自纠错能力比较有限[11]。而HINTON等[12]提出的深层学习结构,可表征复杂高维函数并提取多重水平的特征[13]。深度学习的2种典型结构为限制波尔兹曼机(restricted boltzmann machines,RBM)和卷积神经网络(convolutional neural network,CNN)。RBM在语音识别体现了较好优势[14]。而LECUN等[15]使用 CNN在处理识别图像信息取得了比其他学习方法更好的结果。目前,随着互联网的发展以及视频编解码技术的成熟,视频数据呈现出爆炸式的增长[16]。目前已经有将深度学习方法应用到视频数据目标识别的若干研究成果[17-19]。但上述的研究成果往往针对视频的视觉信号进行单一模态的处理。而对于一段视频来说,视觉和听觉信号都能够为目标识别提供重要的信息。因此,出现了结合各种不同的模态之间的有效信息的多模态学习方法。如LEONARDI等[20]使用底层的视觉和音频特征来检测足球视频中的进球镜头。NGIAM 等[21]使用多模态方法并行处理人物口型和所发出的音节。目前这2种多模态学习方法都采用同一中深层结构处理音频和视频信号。但在多模态方法中使用不同深层结构将会取得更好的效果。如RBM对声音的识别具有较好的识别效果。而卷积神经网络对时间相关的动态视觉信号有较强的鲁棒性[22]。为此,本文作者提出一种基于深度学习的异构多模态目标识别方法,综合RBM的语音识别能力和卷积神经网络的图像处理能力,并建立RBM和卷积神经网络的共享关联表示,以便更有效地识别视频中的目标。在对视觉信号进行处理时,进一步利用视频中相邻两帧的时间相关性,优化神经网络多层结构的参数,提高目标识别的准确度。

1 异构多模态深度学习的目标识别方法

多媒体数据中目标识别的关键是能够获取数据的主要特征。网络资源中的多媒体视频数据具有较大的复杂性与多样性。仅仅利用视频数据中单一模态进行处理往往难以得到较好的效果。使用多模态结合的方法提取数据特征能够更有效应用于媒体数据流的特征提取:将视觉图像和音频数据分别作为2种模态输入,并行进行处理,同时得到2种模态的高层特征,进而通过最大化2种模态之间的关联性建立模态间的共享表示。可得到更好的识别效果。

由于视频信息中视觉信息和听觉信息的特点不同,本文建立了多模态的异构深度学习神经网络,分别利用RBM和卷积神经网络CNN处理视频数据流的音频信号和视频图像信号。

1.1 基于RBM的深度学习模型

RBM是一种特殊形式的玻尔兹曼机,可通过输入数据集学习概率分布的随机生成神经网络,具有较好的泛化能力。而由多个RBM结构堆叠而成的深度信念网络能提取出多层抽象的特征,从而用于分类和目标识别。

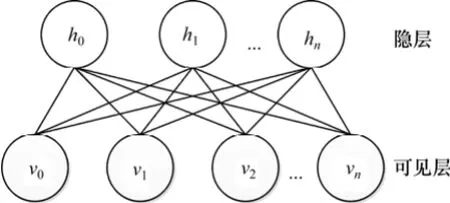

本文采用RBM模型进行音频处理,RBM的结构如图1所示,整体是一个二分图的结构,分为2层:一层为可见层(visible units),也称为输入层;另一层为隐层(hidden units)。

图1 RBM的结构图Fig.1 Structure of RBM

RBM的隐藏变量h和可见变量v之间存在对称性的连接(Wi,j),但是隐藏变量之间或者可见变量之间没有连接。该模型通过模拟热力学能量定义了基于h和v的联合概率分布(方程(1))。由于同层变量之间没有连接,因此根据联合概率分布可方便计算出每一个单元的激发概率。

根据方程(1),可定义隐层和可见层的概率分布:

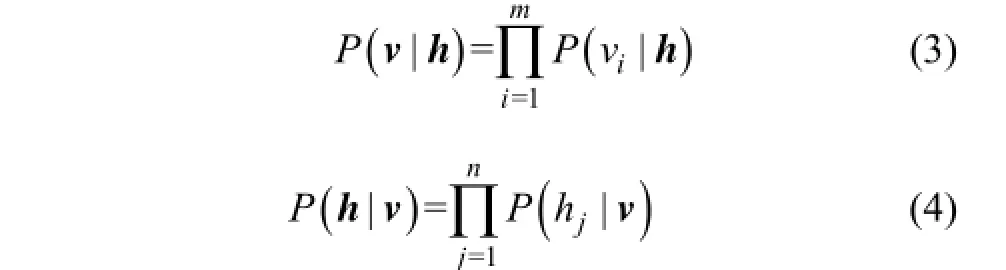

每一个单元的激发概率为:

1.2 基于CNN的深度学习模型

CNN是多层感知机(MLP)的一个变种模型,是近几年来快速发展并引起广泛重视的一种高效识别方法。它是从生物学概念中演化而来的。20世纪60年代,HUBEL等[23]在研究猫脑皮层中用于局部敏感和方向选择的神经元时发现其独特的网络结构可以有效地降低反馈神经网络的复杂性,继而提出了CNN。

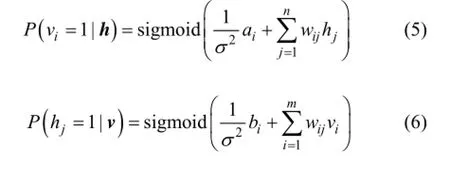

一般来说,CNN的基本结构包括2层:一层为特征提取层,每个神经元的输入与前一层的局部接受域相连,并提取该局部的特征。一旦该局部特征被提取后,它与其他特征间的位置关系也随之确定下来;另一层为特征映射层,网络的每个计算层由多个特征映射组成,每个特征映射是一个平面,平面上所有神经元的权值相等。

特征映射结构采用的 sigmoid函数作为卷积网络的激活函数,使得特征映射具有位移不变性。此外,由于一个映射面上的神经元共享权值,因而减少了网络自由参数的个数。卷积神经网络中的每一个卷积层都紧跟着一个用来求局部平均与二次提取的计算层,这种特有的两次特征提取结构减小了特征分辨率。其具体结构图如图2所示。

1.3 基于深度编码器和关联分析的异构学习

首先将视频模型描述为视听双模态,其中该模型的输入是视频帧和与视频帧同步的连续声谱。本文采用基于稀疏理论的深度自动编码器异构多模态的深度学习方法。

深度自动编码器是一种利用无监督逐层贪心预训练和系统性参数优化的多层非线性网络,能够从无标签数据中提取高维复杂输入数据的分层特征,并得到原始数据的分布式特征表示的深度学习神经网络结构,其由编码器、解码器和隐含层组成。

基于稀疏理论的深度自动编码器[10]对原始自动编码器的隐含层添加了约束条件并增加了隐含层数量,能提取高维数据变量的稀疏解释性因子,保留原始输入的非零特征,增加表示算法的鲁棒性,增强数据的线性可分性,使物体边界变得更加清晰。

该识别模型分为输入层、共享表示层以及输出层。

输入层:为视频资源的2个模态,即声谱和视频帧,其中声谱采用RBM训练,视频帧采用CNN训练。

图2 卷积神经网络多层卷积运算和采样过程图Fig.2 Multilayer convolution operation and sampling process of convolution neural network

共享表示层:这一层的关键是找到特征模态的转换表示从而最大化模态之间的关联性。本文采用典型关联分析(canonical correlation analysis, CCA,)的方法寻找声谱波和视频帧数据的线性转换从而形成性能优良的共享表示。

CCA是先将较多变量转化为少数几个典型变量,再通过其间的典型相关系数来综合描述两组多元随机变量之间关系的统计方法,有助于综合地描述两组变量之间的典型相关关系。基本过程是从两组变量各自的线性函数中各抽取一个组成一对,它们应是相关系数达到最大值的一对,称为第1对典型变量,类似地就可以求出第2对、第3对等,这些成对变量之间互不相关,各对典型变量的相关系数称为典型相关系数。所得到的典型相关系数的数目不超过原两组变量中任何一组变量的数目。

输出层:这一层为声谱和视频的重构。还原视频信息的同时,识别视频中的物体。

2 基于视频时间相关特性的参数优化

2.1 视频相关性描述

视频是由一系列图像所组成,图像中目标识别的方法可以用来对视频进行识别,一段视频可以分解成很多帧,同一视频中连续的2个视频帧很有可能表示同样的内容,视频的这种特性称之为相关特性。将这视频的这种特性用于视频的目标识别,可以使识别效果得到很大程度的提高[22]。

利用视频的时间相关性来提高识别准确性已成功用于视频的动作识别[23]。实验表明具有时间相关性视频卷积网络的识别效果明显比采用视频单帧进行训练的卷积网络效果优越。

2.2 利用视频相关特性的优化

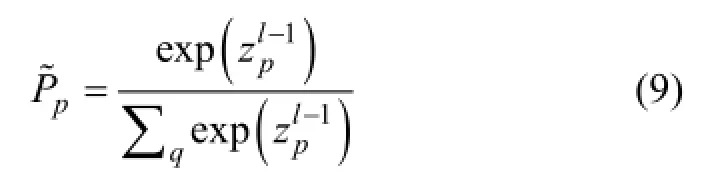

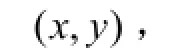

CNN中在每个卷积层和子采样层之后都运用了一个非线性函数tanh(·),最后使用经典的全连接层输出识别标签向量,为了解释这些向量的概率,引入“softmax”层,计算公式如下:

得到的新参数θ能使卷积神经网络对视频中目标识别的性能更准确。其中λ是根据实验选择的学习率。

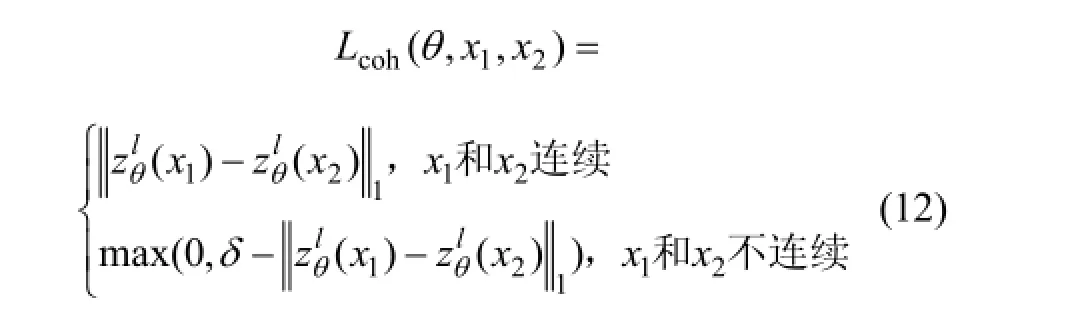

为了使CNN更好地训练θ,以达到更好的识别正确率,利用视频中存在的时间相关性进一步对似然函数L(θ)进行优化。

δ为边缘尺寸,是一个提前选取好的超参数,例如δ=1。

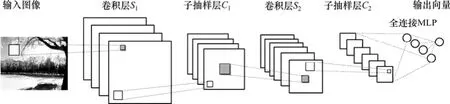

图3 利用相邻帧的相关特性对深度学习参数进行优化Fig.3 Deep learning parameter optimization by using related characteristic of adjacent video frames

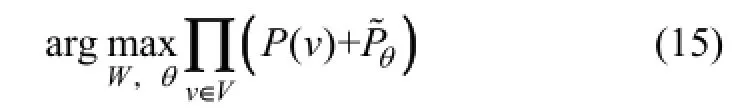

3 基于时间相关的异构多模态深度学习算法

基于时间相关性的异构多模态的结构如图4所示,将视频中的 2个模态视频和音频分别采用 CCN和RBM进行处理得到相应的识别标签向量。

RBM 网络的输入为与视频帧相对应的同步连续声谱,采用深度自动编码的学习模型对音频进行处理,该学习模型仍然与1.3节中类似,分为输入层、共享表示层以及输出层。

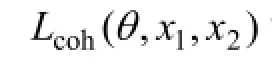

RBM的目标是最大化训练样本集V中的概率之积:

CNN的优化目标则是最大化式(9)中的概率,则基于时间相关的异构多模态深度学习算法的目的就是对参数w, θ,优化RBM和CNN的联合概率:

图4 基于时间相关的异构多模态深度学习结构Fig.4 Heterogeneous multimodal structure of deep learning based on time correlation

利用时间相关性的优化算法如下:

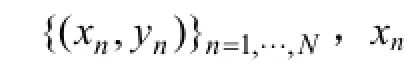

Input:标签数据(an, xn, yn), n=1, 2, …, N,非标签视频数据an, xn,n=N+1, …, N+U。Output: 神经网络的参数w, θ和识别标签label repeat:step1: 取1个随机标签样本(an, xn, yn);step2: 针对音频输入an,执行1次梯度下降迭代优化RBM的连接参数w。step3: 对视频输入帧中连续的 xn, yn和似然函数L(θ, xn, yn),执行1次梯度下降迭代;step4: 对视频输入帧中不连续的 xn, xm和相关似然函数Lcoh(θ, xm, yn),执行1次梯度下降迭代;step5: 针对音频输入an,再执行1次梯度下降迭代优化RBM的连接参数w。选择参数w, θ最大化式(15)中的联合概率。until:迭代误差小于设置的阈值。

上述算法就是通过交替更新目标识别任务的声谱识别和视频图像帧识别的参数来实现优化,在视频图像帧中同时利用了连续帧和非连续帧的特征进行优化。以达到提高识别效率的目的。

4 实验与分析

为了验证本文提出的异构多模态深度学习的目标识别方法的性能,利用如下图像和声音数据库作为测试视频的声音和图像帧信息。

1) Stanford Dataset:是来自于斯坦福大学的1个网络数据库。选用其中的语音数据部分,使用库中23名志愿者朗读从 0~9的数字,从 A~Z的字母和从TIMIT标准语音库里挑选的语句,以作为声音训练和测试数据。

2) Olivetti Faces:是纽约大学的1个人脸数据库,由40个人的400张图片构成,即每个人的人脸图片为10张。每张图片的灰度级为8位,每个像素的灰度位于0~255之间,每张图片为64×64。使用图片构造被测视频的图像帧。采用人工设定视频中的人脸视频与语音数据的对应关系。视频帧中的1,4,5帧作为标签数据,其余的图像作为非标签数据。

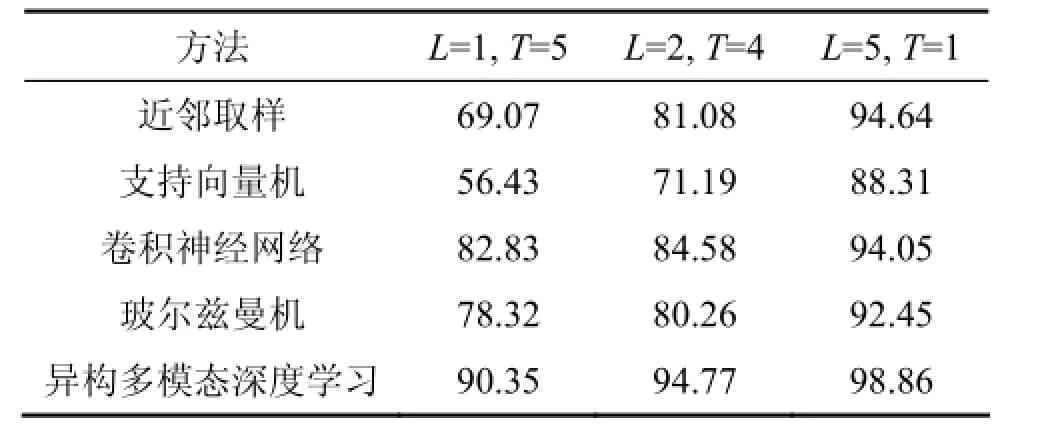

此外,为了验证算法的有效性,将所提出异构多模态深度学习方法同已有的近邻取样、支持向量机和传统的卷积神经网络和玻尔兹曼机等目标识别方法进行比较。其中传统的卷积神经网络和波尔兹曼机即采用同构多模态的方式。将所用图像和语音数据平均分成6组,分为训练组L和测试组T,进行如下操作:1) L=1,T=5。2) L=2,T=4。3) L=5,T=1。实验将对这3种情况比较这些方法对被测对象的识别率。测试的识别结果如表1所示。

表1 基于Stanford Dataset和Olivetti Faces数据库测试的算法识别率结果比较Table 1 Comparison of algorithm tests results based on Stanford Dataset and Olivetti Faces database %

由表1可以看出:随着训练集的规模增大,所有目标识别方法的识别率都得到了显著提高。与传统的4种目标识别方法相比,由于本文提出的异构多模态深度学习方法能够抽象地学习目标与时间相关的特性信息,能不依赖大量对象集进行目标识别训练,所以异构多模态深度学习方法能始终获得最高的识别率。在训练组较小L=1,T=5时,异构多模态深度学习方法的测试精度是90.35%,在训练组较多L=5,T=1时,识别率提升了8.51%,误差率只有1.14%。

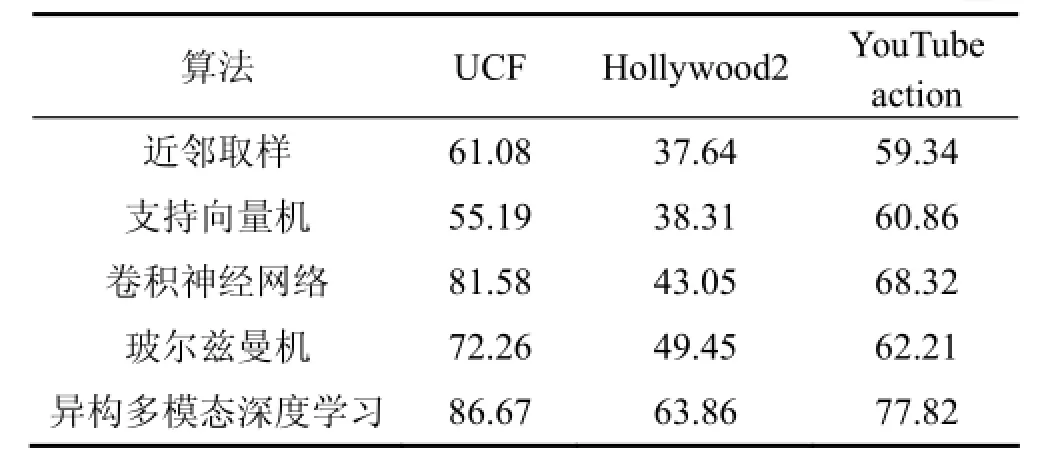

此外,利用以下3种具有复杂场景和多种表情动作的视频数据集以验证本算法的有效性:UCF sport actions, Hollywood2和YouTube action。这些数据集提取自实际场景,具有场景复杂,待识别目标具有移动性,目标捕捉困难,面对干扰较大等特性。在本次实验中利用较多训练组L=5,T=1来验证算法的性能,其指标仍然是目标识别率。比较结果如表2和图5所示。

表2 基于UCF,Hollywood2和YouTube action视频库的算法识别率结果比较Table 2 Comparison of algorithm tests results based on video database coming from UCF, Hollywood2 and YouTube action %

图5 标准视频库和电影视频库的结果对比Fig.5 Comparison of algorithm tests results between standard video database and movie fragment database

由表2和图5可以看出:在更复杂的场景下,4种方法的目标识别都更加困难。特别是针对高度复杂的好莱坞电影场景,目标识别精度最高只有63.86%。由于4种数据集场景具有较大的干扰,所以具有滤波作用的玻尔兹曼机方法和异构多模态深度学习方法具有更高的识别精度。此外本文提出的异构多模态深度学习方法能够抽象出目标与时间相关的特性信息,特别适用于移动场景目标的识别,能获得最高的目标识别精度。

5 结论

1) 针对网络媒体数据中同时包含音频信号和时间相关的视频图像信号的特点,提出了一种异构的多模态深度学习机制,结合RBM和CNN,通过共享特征建立关联。比单模态的处理更能获得有效信息。

2) 在异构多模态的结构中进一步利用相邻视频帧之间的时间相关性提高识别率。通过引入了“softmax”层定义相邻帧的极大似然函数,通过迭代的梯度下降法求解优化的深度学习参数。

3) 分别使用了标准语音人脸库和截取的电影视频对算法进行实验,对比了不同数量训练用例的分组。其中截取的电影视频有更复杂的背景和表情动作。对于这2种视频来源,所提出方法相对于所比较的方法在目标识别的精度方面都有显著提高,显示了本文算法的有效性与优越性。

[1] 王元卓, 靳小龙, 程学旗. 网络大数据: 现状与展望[J]. 计算机学报, 2013, 36(6): 1125-1138. WANG Yuanzhuo, JIN Xiaolong, CHENG Xueqi. Network big data: present and future[J]. Chinese Journal of Computers, 2013,36(6): 1125-1138.

[2] CHEN X W, LIN X. Big data deep learning: challenges and pers pectives[J]. Access, IEEE, 2014(2): 514-525.

[3] 李国杰. 大数据研究的科学价值[J]. 中国计算机学会通讯, 2012, 8(9): 8-15. LI Guojie. The scientific value in the study of the big data[J]. China Computer Federation, 2012, 8(9): 8-15.

[4] LOWE D G. Object recognition from local scale-invariant features[C]// Proceedings of the Seventh IEEE International Conference on Computer Vision. Kerkyra, Greece: IEEE, 1999:1150-1157.

[5] DENG L, YU D. Deep learning: methods and applications[J]. Foundations and Trends in Signal Processing, 2014, 7(3/4):197-387.

[6] ZIVKOVIC Z. Improved adaptive Gaussian mixture model for background subtraction[C]// Proceedings of the 17th International Conference on Pattern Recognition. Cambridge,UK: IEEE, 2004: 28-31.

[7] QUATTONI A, COLLINS M, DARRELL T. Conditional random fields for object recognition[C]// 18th Annual Conference on Neural Information Processing Systems. Vancouver, British Columbia, Canada, 2004: 1097-1104.

[8] SUYKENS J A K, VANDEWALLE J. Least squares support vector machine classifiers[J]. Neural Processing Letters, 1999,9(3): 293-300.

[9] MORGAN N, BOURLARD H. Continuous speech recognition using multilayer perceptrons with hidden Markov models[C]// International Conference on Acoustics, Speech, and Signal Processing. Albuquerque, New Mexico, USA: IEEE, 1990:413-416.

[10] LE Q V, ZOU W Y, YEUNG S Y, et al. Learning hierarchical invariant spatio-temporal features for action recognition with independent subspace analysis[C]// Computer Vision and Pattern Recognition (CVPR). Providence, Rhode Island, USA: IEEE,2011: 3361-3368.

[11] AREL I, ROSE D C, KARNOWSKI T P. Deep machine learning-a new frontier in artificial intelligence research[research frontier][J]. Computational Intelligence Magazine,IEEE, 2010, 5(4): 13-18.

[12] HINTON G E, SALAKHUTDINOV R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006,313(5786): 504-507.

[13] 刘建伟, 刘媛, 罗雄麟. 深度学习研究进展[J]. 计算机应用研究, 2014, 31(7): 1921-1930. LIU Jianwei, LIU Yuan, LUO Xionglin. The research and progress of deep learning[J]. Application Research of Computers,2014, 31(7): 1921-1930.

[14] HINTON G, DENG L, YU D, et al. Deep neural networks for acoustic modeling in speech recognition: the shared views of four research groups[J]. Signal Processing Magazine, IEEE,2012, 29(6): 82-97.

[15] LECUN Y, BOTTOU L, BENGIO Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324.

[16] 程东阳. 基于无监督特征学习的多媒体内容算法研究[D]. 上海: 上海交通大学信息安全工程学院, 2014: 1-93. CHEND Dongyang. Multimedia content analysis based on unsupervised feature learning[D]. Shanghai: Shanghai Jiao Tong University. School of Information Security Engineering, 2014:1-93.

[17] 由清圳. 基于深度学习的视频人脸识别[D]. 哈尔滨: 哈尔滨工业大学计算机科学与技术学院, 2012: 3-20. YOU Qingzhen. The radio face recognition method based on the deep learning[D]. Harbin: Harbin Institute of Technology. School of Computer Science and Technology, 2012: 3-20.

[18] WANG Y S, FU H, SORKINE O, et al. Motion-aware temporal c oherence for video resizing[J]. ACM Transactions on Graphics, 2009, 28(5): 89-97.

[19] ZOU W, ZHU S, YU K, et al. Deep learning of invariant features via simulated fixations in video[C]// 26th Annual Conference on Neural Information Processing Systems. Lake Tahoe, Nevada,USA, 2012: 3212-3220.

[20] LEONARDI R, MIGLIORATI P, PRANDINI M. Semantic indexing of soccer audio-visual sequences: a multimodal approach based on controlled Markov chains[J]. Transactions on Circuits and Systems for Video Technology, IEEE, 2004, 14(5):634-643.

[21] NGIAM J, KHOSLA A, KIM M, et al. Multimodal deep learning[C]// Proceedings of the 28th International Conference on Machine Learning (ICML-11). Bellevue, Washington, USA,2011: 689-696.

[22] MOBAHI H, COLLOBERT R, WESTON J. Deep learning from temporal coherence in video[C]// Proceedings of the 26th Annual International Conference on Machine Learning. Montreal,Quebec, Canada: ACM, 2009: 737-744.

[23] HUBEL D H, WIESEL T N. Receptive fields, binocular interaction and functional architecture in the cat's visual cortex[J]. Journal of Physiology, 1962, 160(1): 106-154.

[24] SIMONYAN K, ZISSERMAN A. Two-stream convolutional networks for action recognition in videos[C]// 28th Annual Conference on Neural Information Processing Systems. Montreal, Quebec, Canada, 2014: 568-576.

(编辑 杨幼平)

Heterogeneous multimodal object recognition method based on deep learning

WEN Mengfei1,2, HU Chao3,4, LIU Weirong1

(1. School of Information Science and Engineering, Central South University, Changsha 410075, China 2. Hunan Provincial Research Institute of Education, Changsha 410005, China;3. Information and Network Center, Central South University, Changsha 410083, China 4. Key Laboratory of Medical Information Research of Hunan Province, Central South University,Changsha 410083, China)

The heterogeneous multimodal object recognition method was proposed based on deep learning. Firstly, based on the video and audio co-existing feature of media data, a heterogeneous multimodal structure was constructed to incorporate the convolutional neural network(CNN) and the restricted boltzmann machine(RBM). The audio and video information were processed respectively, generating the share characteristic representation by using the canonical correlation analysis(CCA). Then the temporal coherence of video frame was utilized to improve the recognizing accuracy further. The experiments were implemented based on the standard audio & face library and the actual movie video fragments. The results show that for both the two kinds of video sources, the proposed method improves the accuracy of target recognition significantly.

object recognition; deep learning; restricted boltzmann machine; convolutional neural network; canonical co rrelation analysis

TP391.4

A

1672-7207(2016)05-1580-08

10.11817/j.issn.1672-7207.2016.05.018

2015-08-17;

2015-10-14

湖南省教育科学“十二五”规划重点项目(XJK014AJC001);国家自然科学基金资助项目(61379111,61003233,61202342);教育部-中国移动科研基金资助项目(MCM20121031) (Project(XJK014AJC001) supported by the Hunan Provincial Education Science Key Foundation during 12th Five-Year Plan; Projects(61379111, 61003233, 61202342) supported by the National Natural Science Foundation of China;Project(MCM20121031) supported by the Science Fund of Education Department-China Mobile)

胡超,博士,讲师,从事网络管理、机器学习、教育信息化研究;E-mail: huchao@csu.edu.cn