感认知增强的智能机械手系统

2016-08-01叶振宇王淑刚李石坚

杨 莎, 叶振宇, 王淑刚, 陶 海, 李石坚, 潘 纲, 朱 斌

(1.浙江大学 计算机科学与技术学院,浙江 杭州 310027; 2.浙江树人大学 信息科技学院,浙江 杭州 310015)

感认知增强的智能机械手系统

杨莎1, 叶振宇1, 王淑刚1, 陶海1, 李石坚1, 潘纲1, 朱斌2

(1.浙江大学 计算机科学与技术学院,浙江 杭州 310027; 2.浙江树人大学 信息科技学院,浙江 杭州 310015)

摘要:为了提高服务机器人的系统服务能力和智能化程度,提出一种面向机械手等器件的感认知增强模型.通过融合来自不同传感通道的感知能力和认知能力,增强机械手的感知和认知.基于此模型,以视觉、触觉为例,在视觉系统上用尺度不变特征变换算法实现目标物体的识别,并对目标物体进行定位;在触觉系统上对触觉传感器采集的数据用主成分分析算法降维,并用支持向量机算法获得分类模型;在认知系统上,机械手在抓取物体时根据物体信息自适应地规划路径并决策物体的抓取模式.通过在多类物体混杂环境中的抓取和分拣实验,验证了该感认知增强机械手系统的可用性.

关键词:感认知增强;机械手;视觉;触觉;认知

随着智能机器人的快速发展,智能机器人应用的领域越来越广泛.普适计算是一种无所不在的计算,各类服务机器人是普适计算智能环境的重要物理平台.为了增强机器人的感认知能力,为机器人增加多类传感器从而提高机器人的系统服务能力和智能化程度.

在机器人上增加各种外部传感器使之感知外界环境,从而更好地提供个性化的服务,如:PR2机器人[1],助残机器人ISAC[2].视觉和触觉在机器人上有着广泛的应用.“Bumblebee2”作为双目视觉传感器的一种家庭服务机器人通过目标物体的颜色信息进行HSV(hue-saturation-value)阈值分割,得到目标物体的三维坐标[3].基于单目视觉的实际室内环境“Pioneer3”机器人在环境地图中实现移动机器人全局定位[4].本文用到的Kinect摄像机是一种3D体感摄像机,采用红外定位感知周边环境中物体的位置.机器人通过触觉传感器感知物体的不同属性.萧伟等[5]利用4组部署在机械手上的触感阵列传感器,基于分段线性动态系统的“模型袋”描述方法进行建模,针对10类物体的分类正确率达到95.97%.Jamali等[6]在机械手指尖部署基于应变力的触感传感器,通过指尖在物体表面的平稳滑动,对获得的应变力曲线进行傅里叶分析,实现了对多类物体表面纹理的分类,正确率超过95%.以上实验所用的设备代价高昂,尤其是触感阵列传感器,综合效益比并不高.

味觉、嗅觉、听觉也是生物体感知外界环境的重要感知系统.模仿嗅觉机制研制的嗅觉传感器在环境检测、食品品质鉴定有广泛应用前景[7].熊猫机器人通过听觉传感器可以感受外界的音量及信号,和人类互动并产生响应的肢体动作[8].在机器人各种感知融合的系统中,3种不同传感器(手腕传感器、惯性传感器、关节检测传感器)的融合来决定操控周围环境的力量和力矩[9].感知融合应用于机器人的导航中,机器人重建周围的环境并对自己定位,识别抓取或者躲避的物体[10].

本文提出一种感认知模型并搭建感认知增强的机械手系统,融合视觉、触觉等各种感知能力和认知能力.机器人利用视觉对物体识别和定位,利用触觉信息补充或者替代视觉系统来确认物体的几何结构[11].机器人根据视觉系统获取物体的形状、位置等信息对机器人的移动路径进行规划,并决策物体的抓取模式.

1问题分析及感认知增强模型建立

1.1问题分析

1.1.1机械手的视觉感知机器人识别目标物体时,需要Kinect识别该物体,并获取该物体的形状、位置等信息.Kinect识别出的物体位置是基于Kinect坐标系统,需要将物体相对于Kinect的位置转换为物体相对于机械手的位置,机械手才能通过工具坐标系的机械爪移动到物体位置并抓取物体.

1.1.2机械手的触觉感知 机械爪在抓取物体时,如果施加力度不当会损坏物体.引入触感功能可以实现在抓取中实时测算机械爪是否接触到物体以及力量是否足够抓握物体.机械手通过部署在机械爪上的触觉传感器获取抓取或者触摸物体表面过程中采集到的压力数据,并进行分析,判断出抓取物体的种类.

1.1.3机械手的认知系统 由于物体形状、位置的不同,要使机械手稳定地抓取不同的物体,需要机械手对移动路径进行规划,对抓取模式进行决策.机械手通过视觉系统获得物体的形状、位置等信息,根据位置信息对机械手的移动路径进行规划,对不同形状的物体自适应地采取抓取模式.

1.2感认知增强模型

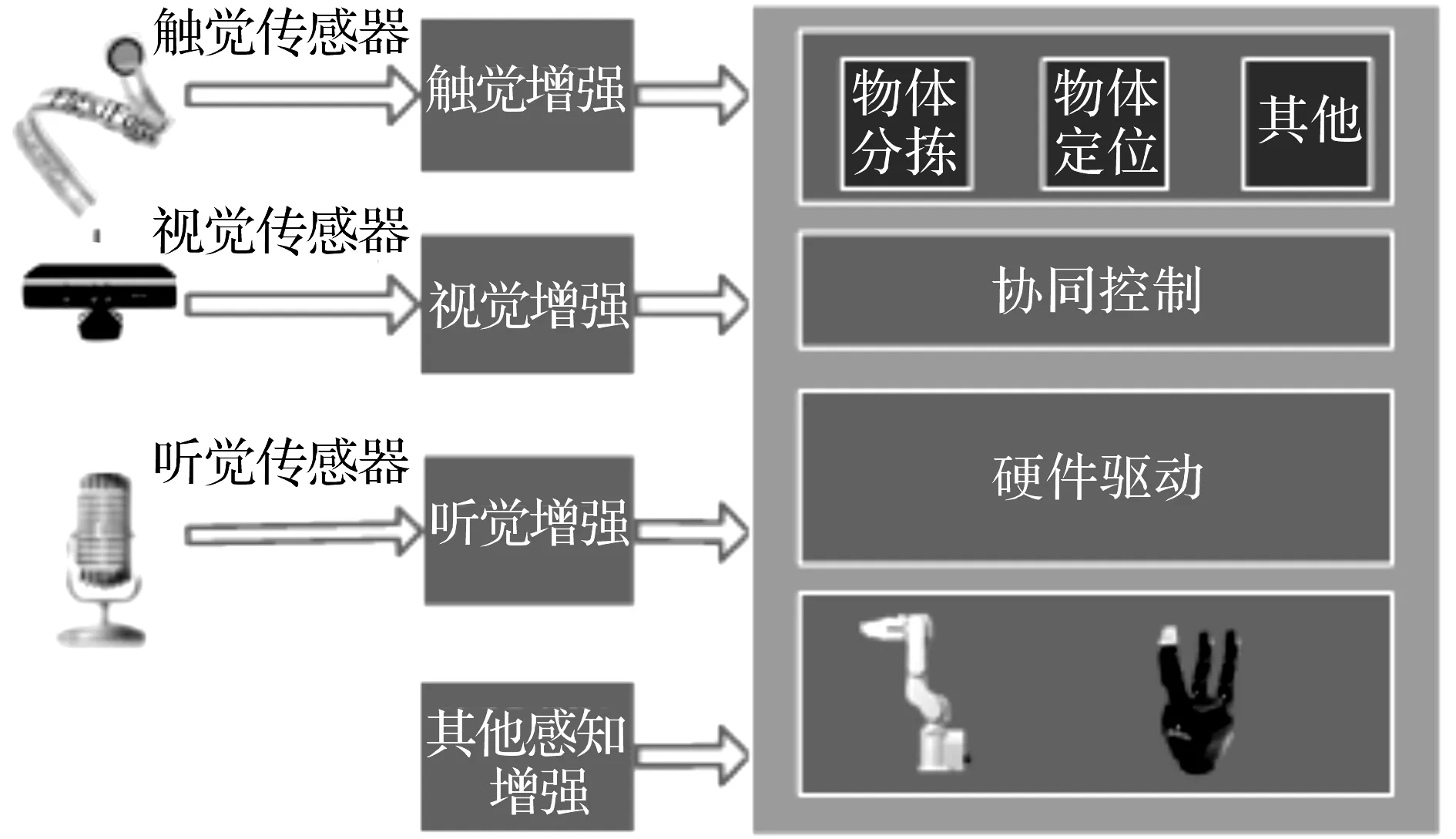

为了融合机器人各部分感认知系统,本文提出一个感认知增强模型,如图1所示.该模型建立在机械臂和机械爪的硬件系统上,由视觉、触觉、听觉和其他感认知模块组成.基于此模型,建立由视觉感知、触觉感知和认知系统组成的感认知增强的机械手系统.机械手系统包括感知和认知2个方面,其中感知方面包括机械手的视觉系统和触觉系统.

图1 感认知增强的机械手模型Fig.1 Perception enhanced model of robotic arm

1.2.1视觉系统 系统定义了Kinect坐标系、机器人坐标系和工具坐标系.Kinect坐标系统中,z轴是红外摄像头的光轴,与图像平面垂直.光轴与图像平面的交点为Kinect坐标系的原点.机器人坐标系是机械手的基本坐标系,工具坐标系是安装在机械手夹具末端的工具的坐标系.该位置通过位置数据(x,y,z)指定且该方向通过方向数据(u,v,w)指定,对应于滚动、倾斜和偏航.工具坐标系安有一个Robotiq3-FingerAdaptiveGripper机械爪.

要实现Kinect对物体的定位,需要先识别目标物体.当Kinect识别物体时,提取物体的SIFT(scale-invariantfeaturetransform)[12]特征点,对SIFT特征建立kd_tree[13],运用kdtree_bbf_knn(Kdtreebestbinfirstk近邻)算法查找匹配的特征点,再用RANSAC[14](RANdomsampleconsensus,随机抽样一致)算法筛选出更有效的匹配点,进而得到目标物体在图像中的位置.校准Kinect的彩色图像和深度图像得到目标物体在Kinect坐标系统中的三维坐标.

视觉系统中定义了3个坐标系统,机器人坐标系统、Kinect坐标系统和工具坐标系统.其中,机器人坐标系到工具坐标系的旋转矩阵R[15]为

R=Rz*Ry*Rx.

(1)

(2)

(3)

(4)

Rz、Ry、Rx分别表示坐标系绕z轴旋转u度,绕y轴旋转v度,绕x轴旋转w度.

根据两个坐标系统的转换关系[15]有

Cr=R(Ck-T).

(5)

式中:Cr为一个点在机器人坐标系中的坐标,Ck为该点在Kinect坐标系中的坐标,R为2个坐标系统的旋转矩阵,T为2个坐标系统的平移向量.机械爪接触目标物体需要得到机械爪的中心点在机器人坐标系统中的位置:

Cr=M·R+Ct.

(6)

式中:Ct为机械手中心点的坐标,M为工具坐标系的原点到机械手中心点的向量.

1.2.2触觉系统触觉系统是将压力传感器部署在机械爪手指指尖平面上.为了防止机械爪抓取力度不当造成物体损伤,需要对物体有防损辅助地抓取,流程如下.

1) 通过视觉系统获得物体的实际位置和粗略的横向宽度.

2) 设置机械爪的抓取模式,使两指间距离减小至略大于横向宽度,设定为试抓距离.

3) 在机械爪减小指间距离时,实时记录指尖触觉传感器的数值,获取在无接触的情况下触觉传感器的基准数值,根据背景噪音动态设定接触阈值.

4) 进一步缩小机械爪指间距离,当触觉传感器的数值大于接触阈值时,初步判定已经抓住物体.作尝试性移动判定物体是否被抓牢,若物体出现滑脱,则复原机械爪指尖距离至试抓距离,提高接触阈值,重复4),直至物体未出现滑脱.

触觉传感器在采集数据时,控制机械爪抓取力度和抓取速度始终不变,获取压力随时间的变化情况.采用抓取物体和在物体表面滑动2种方式获得触感数据.对于抓取物体,根据采集到的压力数据选取基准点,基于基准点选取预设数量的数据作为原始数据向量,对原始数据向量基于主成分分析(principalcomponentanalysis,PCA)算法[16]进行降维,再利用支持向量机(SVM)算法[17]对训练数据进行监督学习获得分类模型.根据此模型,对机械手抓取的未知物体进行分类.对于在物体表面滑动获得的数据,提取实际滑动段的数据,归一化后基于PCA降维,同样采用SVM进行分类模型训练,实现对物体的表面材质分类.

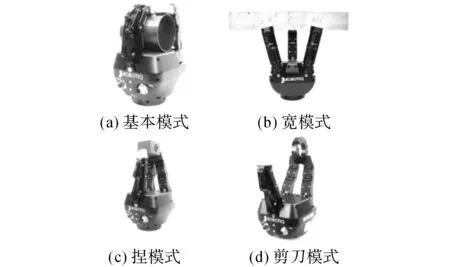

图2 机械爪的4种抓取模式:基本模式、宽模式、捏模式、剪刀模式Fig.2 Four grab modes of robotic arm: basic mode, wide mode, pinch mode and scissor mode

1.2.3认知系统在认知系统中,机械手通过感知周围环境识别目标物体,调整机械爪在机械臂上的角度使机械爪移动到物体位置,设定机械爪的抓取模式保证稳定抓取.根据视觉系统获取的物体形状、位置等信息,机械手规划路径移动到物体位置,根据物体的形状自适应地设定抓取模式.结合机械爪自身结构特征以及目标物体的不同形状,将机械爪抓取模式分成了4种,如图2所示:对圆柱形物体采取基本模式;对长方形物体采取宽模式;对体型小物体采取捏模式;对圆环型物体采取剪刀模式.本文选取特定的已知物体进行实验.通过Kinect对物体识别和定位,调整机械爪在机械臂上的角度使之移动到物体,根据已知识别的物体的形状采取其相对应的抓取模式,从而验证认知系统的有效性.

2实验结果

感认知增强的机械手系统在视觉上增强物体的识别和定位,在触觉上增强物体抓取力量的控制和对物体分类等方面的智能化程度,通过认知系统增强机械手在移动路径的规划和决策抓取模式的认知能力.

2.1视觉系统验证

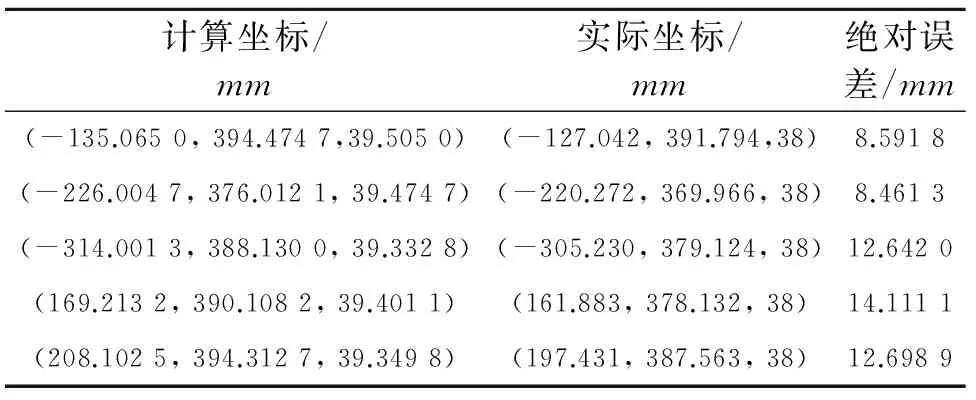

实验选取了苹果和柚子作为识别对象,识别结果如图3所示.实验中将机械爪中心点作为标记点,选取20组标记点在Kinect坐标系中的位置以及在机器人坐标系中不同位置、工具坐标系中不同旋转角度下的数据,得到2个坐标系统的旋转矩阵和平移向量.为了验证该方法的准确性,实验对该方法进行定量分析,如表1所示.绝对误差是物体的实际坐标和计算坐标之间的距离.从绝对误差可以看出视觉系统中物体定位的高准确度.

图3 视觉系统中目标物体SIFT特征识别匹配结果Fig.3 Recognition and matching results of SIFT features of target objects in visual system

Tab.1Computedcoordinate,realcoordinateandabsoluteerroroftargetobject

计算坐标/mm实际坐标/mm绝对误差/mm(-135.0650,394.4747,39.5050)(-127.042,391.794,38)8.5918(-226.0047,376.0121,39.4747)(-220.272,369.966,38)8.4613(-314.0013,388.1300,39.3328)(-305.230,379.124,38)12.6420(169.2132,390.1082,39.4011)(161.883,378.132,38)14.1111(208.1025,394.3127,39.3498)(197.431,387.563,38)12.6989

2.2触觉系统验证

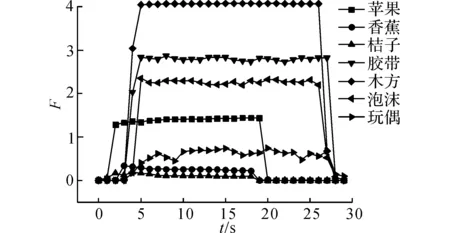

图4 7类物体抓取压力变化图Fig.4 Grasping pressure time profile of seven types of objects

在抓取实验中,选取7类不同刚性硬度的物体进行数据采集和建模,原始数据如图4所示.其中,t为对数据采样的时间,F为机械爪抓取物体时压力值的相对值.当机械手抓取物体后,数值先骤升再趋向稳定,然后当机械手松开物体后,数值骤降.由图可见,不同物体的数据存在不同的波动特征.提取数据的有效段,然后进行PCA降维,再对降维后的特征向量进行SVM监督学习,获得分类模型.7类物体的交叉验证识别率为78.26%.

在滑动实验中,同样针对7类物体表面进行滑动数据采集,原始数据如图5所示.不同物体的数据在滑动时随着表面纹理的不同存在不同的波动特征,对数据进行低通滤波和归一化后,同样采用PCA降维,对降维后的特征进行SVM监督学习,获得分类模型.7类物体的交叉验证识别率为92.7%.

图5 7类物体滑动压力变化图Fig.5 Sliding pressure time profile of seven types ofobjects

2.3认知系统验证

认知系统选取香蕉和瓶盖作为实验对象,通过视觉系统对目标物体识别和定位,如图6所示.将目标物体位置信息传递给机械手,机械手根据物体的形状和位置进行移动路径规划,实验中机械爪相对于机械手坐标轴的角度统一固定为机械爪朝z轴方向.机械爪根据物体形状自适应采取抓取模式,对香蕉采取宽模式,对瓶盖采取捏模式,如图7所示.

图6 认识系统中目标物体SIFT特征识别匹配结果Fig.6 Recognition and matching results of target objects’ SIFT features in cognition sysetm

图7 机械爪对于不同形状物体的不同抓取模式Fig.7 Different grab modes of robotic arm for different shapes of objects

3结语

本文提出了一种感认知增强的机械手模型,建立了感认知增强的机械手系统,提高了机械手的感认知能力,使机械手更好地感知周边的环境,提供更加智能便捷的服务.下一步的工作包括:改进视觉系统物体识别算法;在机械爪上部署更多的传感器或者传感阵列,获得更准确的分类效果;认知系统上自适应地进行机械手的路径规划,增加更多抓取模式的实验;在机械手上添加听觉等感知能力.

参考文献(References):

[1]ROMANOJM,HSIAOK,NIEMEYERG,etal.Human-Inspiredroboticgraspcontrolwithtactilesensing[J].IEEETransactionsonRobotics, 2011, 27(6):1067-1079.

[2]HARAI,ASANOF,ASOHH,etal.RobustspeechinterfacebasedonaudioandvideoinformationfusionforhumanoidHRP-2[J].IntelligentRobotsandSystems, 2004: 2404-2410.

[3] 彭飞,魏衡华.基于单目仿人机器人的障碍物测距方法[J].计算机系统应用,2013, 22(8): 88-90.PENGFei,WEIHeng-Hua.Studyonobstacledistancedetectionbasedonmonocularhumanoidrobot[J].ComputerSystemsandApplications, 2013, 22(8): 88-90.

[4] 厉茂海,洪炳镕,罗荣华,等.基于单目视觉的移动机器人全局定位[J].机器人,2007, 29(2):140-144.

LIMao-hai,HONGBing-rong,LUORong-hua,etal.Monocular-vision-basedmobilerobotgloballocalization[J].Robot, 2007, 29(2): 140-144.

[5] 萧伟,孙富春,刘华平.机器人灵巧手的触觉分析与建模[J].机器人, 2013, 35(4): 394-401.

XIAOWei,SUNFu-chun,LIUHua-ping.Tactileanalysisandmodelingofdextrousrobotichand[J].Robot, 2013, 35(4): 394-401.

[6]JAMALIN,SAMMUTC.Majorityvoting:materialclassificationbytactilesensingusingsurfacetexture[J].IEEETransactionsonRobotics, 2011, 27(3):508-521.

[7] 吴春生,王丽江,刘清君,等.嗅觉传导机理及仿生嗅觉传感器的研究进展[J].科学通报,2007, 52(12): 1362-1371.

WUChun-sheng,WANGLi-jiang,LIUQing-jun,etal.Researchprogressofolfactorytransductionmechanismandbionicolfactorysensor[J].ChineseScienceBulletin, 2007, 52(12): 1362-1371.

[8] 唐科,宗光华.熊猫机器人听觉传感器的设计与实现[J],传感器世界,2008, 14(10): 17-20.TANGke,ZONGGuang-hua.Designandrealizationofrobot’sauditorysensor[J].SensorWorld, 2008, 14(10): 17-20.

[9]GARCIAJG,ROBERTSSONA,ORTEGAJG,etal.Sensorfusionforcompliantrobotmotioncontrol[J].IEEETransactionsonRobotics, 2008, 24(2): 430-441.

[10]KAMM,ZHUXX,KALATAP.Sensorfusionformobilerobotnavigation[J].ProceedingsoftheIEEE, 1997, 85(1): 108-119.

[11]XUDF,LOEBGE,FISHELJA.Tactileidentificationofobjectsusingbayesianexploration[J],RoboticsandAutomation(ICRA), 2013: 3056-3061.

[12]LOWEDG,Distinctiveimagefeaturesfromscale-invariantkeypoints[J].InternationalJournalofComputerVision, 2004, 60(2): 91-110.

[13]MOOREAW.AnintroductorytutorialonKD-trees[D].UK:UniversityofCambridge, 1991.

[14]FISCHLERMA,BOLLESRC.Randomsampleconsensus:aparadigmformodelfittingwithapplicationtoimageanalysisandautomatedcartography[J].CommunicationoftheACM, 1981, 24(6): 381-395.

[15] 于仕琪,刘瑞祯.学习Opencv(中文版)[M].北京:清华大学出版社, 2012: 414-416.

[16] 周志华.机器学习[M].北京:清华大学出版社,2016: 229-232.

[17] 李航.统计学习方法[M].北京:清华大学出版社,2012: 95-115.

收稿日期:2016-01-12.

基金项目:中央高校基本科研业务费专项资金资助项目(2015FZA5017);浙江省自然科学基金资助项目(LY13F020034).

作者简介:杨莎(1989—),女,硕士生,从事普适计算研究. ORCID:0000-0003-0089-0237. E-mail: yangsha@zju.edu.cn 通信联系人:李石坚,男,副教授,博士. ORCID: 0000-0002-3539-8851. E-mail: shijianli@zju.edu.cn

DOI:10.3785/j.issn.1008-973X.2016.06.020

中图分类号:TP 311.5

文献标志码:A

文章编号:1008-973X(2016)06-1155-05

Perceptionenhancedintelligentroboticarmsystem

YANGSha1,YEZhen-yu1,WANGShu-gang1,TAOHai1,LIShi-jian1,PANGang1,ZHUBin2

(1. College of Computer Science and Technology, Zhejiang University, Hangzhou 310027, China;2. College of Information Science and Technology, Zhejiang Shuren University, Hangzhou 310015, China)

Abstract:A perception enhanced model for devices like robotic arm was proposed in order to improve the service capacity and intelligence of service robot. The model enhanced the perception and cognition of robotic arm by fusing perceptive and cognitive ability from different sensing passages. Taking visual and tactile sense for example, scale-invariant feature transform algorithm was applied on visual system to recognize and locate target object, principal component analysis algorithm was applied on tactile system to reduce dimensions of data collected by tactile sensors, and support vector machine algorithm was applied to obtain a classified model. In cognition system, the robotic arm was able to plan the trajectory adaptively and choose grab modes according to the object’s information when grabbing objects. Grasping and sorting experiments was performed in a mixed circumstance with many kinds of objects, of which the results has verified the availability of the perception enhanced robotic arm system.

Key words:enhanced perception; robotic arm; visual sense; tactile sense; cognition