一种粒子群RELM的基因表达数据分类方法

2015-03-23王石磊陆慧娟

王石磊,陆慧娟,关 伟,余 翠

(1.中国计量学院 信息工程学院,浙江 杭州 310018;2.中国计量学院 现代科技学院,浙江 杭州 310018)

一种粒子群RELM的基因表达数据分类方法

王石磊1,陆慧娟1,关 伟2,余 翠1

(1.中国计量学院 信息工程学院,浙江 杭州 310018;2.中国计量学院 现代科技学院,浙江 杭州 310018)

正则极限学习机(regularized extreme learning machine,RELM)具有比极限学习机(extreme learning machine,ELM)更好的泛化能力.然而RELM的输入层权值、隐含层偏差是随机给定的,会影响RELM的稳定性.另外,RELM为了获得较理想的分类精度,仍需设置较多的隐层节点.针对此问题,通过分析粒子群优化算法(particle swarm optimization,PSO)的原理,把RELM初始产生的输入层权值、隐含层偏差作为粒子带入PSO进行寻优.通过在Breast和Brain数据集上进行多次10折交叉验证表明,粒子群改进正则极限学习机(PSO-RELM)可以在隐层节点设置较少时获得比BP神经网络(back propagation,BP)、支持向量机(support vector machine,SVM)、RELM更好的分类精度和更佳的稳定性.

正则极限学习机;输入层权值;隐含层偏差;粒子群

生物信息学是当今生命科学和自然科学的重大前沿领域之一,同时也是21世纪自然科学的核心领域之一.而在后基因组时代,作为生物信息学的一个重要研究方向,DNA微阵列(又称DNA芯片或基因芯片)经由一次测验,就可以在基因水平上大规模并行检测成千上万个基因的表达量,进而提供大量基因序列相关数据.它是基因组学和遗传学研究强有力的工具,并且对癌症等疾病的诊断、治疗以及药物研究都具有非常重大的现实意义[1-2].但如何根据DNA微阵列实验测定的基因表达数据来有效的对样本进行肿瘤分类是机器学习面临的新课题和挑战[3-4].

目前,多种机器学习算法如BP神经网络,SVM已经广泛被应用于各种分类研究中.但在不同的应用场合,传统的神经网络算法存在学习时间较长,网络结构复杂等问题[5].

SVM主要借助二次规划来求解支持向量,对大规模训练样本难以实施,解决多分类问题存在困难[6].2006年,黄广斌[7]等在对单隐层前馈神经网络研究的基础上,提出了一种新颖的神经网络算法—极限学习机.ELM因具有简单易用、分类精度较高等优点,在分类问题应用中具有显著的优势,然而ELM也存在泛化能力较差等问题.为提高ELM的泛化性能,2010年,邓万宇[8]等通过向ELM引入结构风险最小化理论以及正则项,提出了正则极限学习机.RELM具有比ELM更好的泛化性能,但是同ELM一样,RELM的输入层权值、隐含层偏差是随机给定的,会影响RELM的稳定性.另外,RELM为了获得较理想的分类精度,仍需设置较多的隐层节点[9-10].

粒子群优化算法[11-12]具有实现容易、精度高、收敛快等优点.通过分析PSO的原理,针对RELM输入层权值和隐含层偏差随机给定的问题,本文通过把RELM初始产生的输入层权值、隐含层偏差作为粒子带入PSO进行寻优,然后把最终获得的优化的输入层权值、隐含层偏差带入RELM进行训练和测试[13].PSO-RELM与BP、SVM、RELM在Breast和Brain数据集上进行多次实验对比后显示,稳定性和分类精度都有一定的提高.

1 正则极限学习机

标准ELM是基于经验风险最小化原则,这在特定情形下如样本数目是有限时,从统计学的角度看是不完善的.合理的做法是需要对经验风险和置信范围同时进行最小化,因此根据统计学理论,RELM在ELM的基础上引入结构风险最小化原则,并设置参数γ来对这两种风险的比例进行调节,其数学模型表示为

(1)

式(1)中:‖β‖2—统计学理论中的结构风险;‖ε‖2—经验风险,是N个不同样本的误差加权平方和;γ—通过交叉验证方式确定的风险调节参数;βi—第i个隐层节点的输出权值;ai—第i个隐层节点的输入权值;bi—第i个隐层节点的偏差.

为求解式(1)的条件极值问题,先构建相应的拉格朗日函数

(2)式(2)中,α=[α1,α2,…,αN],αj∈Rm(j=1,2,…,N)

代表拉格朗日乘子.

对式(2)中各变量分别求偏导并令偏导数为0,可得

(3)

根据式(3)求得RELM的输出权值矩阵β=(γ-1I+HTH)THTT,其中I为单位矩阵.

2 粒子群优化算法

粒子群优化算法,又称微粒群算法,是近几年发展起来的一种新的进化算法(evolutionary algorithm,EA),由Kennedy与Eberhart两位学者受飞鸟集群行为的规律性启发而在1995年提出.PSO算法属于进化算法的一种,同时也是一种并行算法.它从随机解出发,然后通过迭代寻找最优解,并且也是通过适应度来评价解的品质和通过追随当前搜索到的最优值来寻找全局最优.

在PSO中,搜索空间的鸟被抽象为没有质量和体积的粒子,也可以理解为所要解决的优化问题的可能解.种群中的粒子都有一个适应值,该适应值是由优化问题的适应度函数求得;同时,每一个粒子也还具有一个速度,该速度会决定粒子运动的方向和距离.在种群中的所有粒子随机初始化后,粒子们就通过种群中的信息交流与共享而跟随当前解空间的最优粒子来搜索最优解.PSO是通过迭代的方式来寻找最优解,在每次迭代中,粒子通过跟踪个体极值(Pbest)和全局极值(Gbest)来不断调整自己的飞行速度和方向.Pbest是粒子本身搜索到的最优解,Gbest是整个种群目前搜索到的最优解.

设搜索空间为D维,总粒子数为n,种群表示为X=(X1,X2,…,Xn),分别用D维向量Xi=(Xi1,Xi2,…,XiD)T和D维向量Vi=(Vi1,Vi2,…,ViD)T表示第i个粒子的位置和当前的飞行速度,Pi=(Pi1,Pi2,…,PiD)T表示第i个粒子飞行过程中发现的个体极值对应的最优位置,Pg=(Pg1,Pg2,…,PgD)T表示所有粒子发现的全局极值对应的最优位置.所有粒子按如下公式不断调整自己的飞行速度和方向

(4)

在(4)式中:ω—惯性因子[14],取值正常数,ω较大适于对解空间进行大范围搜索,ω较小适于进行小范围搜索;c1、c2取值正常数,称加速因子,实际应用通常取c1=c2=2;r1、r2为大小在(0,1)之间的两个相互独立的随机数;对于D维的搜索空间,为了防止粒子进行盲目搜索,粒子位置的每一维都限定为[-Xmax,Xmax],粒子速度的每一维都限定为[-Vmax,Vmax],迭代中若位置和速度某一维超过边界范围则取边界值.

3 粒子群改进正则极限学习机

RELM虽然在ELM的基础上通过引入结构风险最小化理论以及正则项提高了泛化能力,但其输入层权值、隐含层偏差在初始仍是随机给定.在通过输入层权值矩阵和隐含层偏差矩阵求取输出矩阵时,这种随机性可能产生的一些为0的值,会导致一些隐层节点成为无效节点.因此,为了获得满意的分类精度,RELM就需要设置相对较多隐层节点,而这种随机性也同样会影响其稳定性.

为了改善上述RELM存在的问题,本文通过分析PSO的原理,把RELM初始产生的输入层权值、隐含层偏差作为粒子带入PSO进行寻优,提出粒子群改进正则极限学习机.PSO-RELM训练过程可归纳如下:

1)用RELM随机产生的多组输入层权值矩阵、隐含层偏差矩阵生成初始粒子群.根据研究者经验,粒子群规模n通常取20~40,对较难或特定类别的问题可以取100~200,粒子群规模越大,算法越容易收敛到最优点,相应耗费时间就越长;搜索空间维度D=k·(n+1)(D也是每一个粒子的长度),其中,k为隐层节点数,n为输入神经元数(即输入向量维度).粒子位置的每一维都限定为[-Xmax,Xmax],粒子速度的每一维都限定为[-Vmax,Vmax],其中Xmax、Vmax通常取1.

2)每次迭代时根据适应度函数求得每个粒子的适应值,其中适应度函数设定为训练样本类别矩阵和每一个粒子对应的输出矩阵的均方根误差(RMSE).把构成粒子的输入层权值矩阵、隐含层偏差矩阵带入RELM求得训练样本类别矩阵和输出矩阵,然后求得本次迭代每一个粒子的适应值;RELM隐含层的激活函数选定为sigmoid函数.

3)评价每个粒子的适应值进行寻优.对种群中每个微粒,将本次迭代求得的适应值与该粒子上次迭代搜索的个体极值Pbest进行比较,如果较好,则将该粒子Pbest更新为其本次迭代的适应值,并更新Pbest对应的位置为本次迭代粒子的位置;将本次迭代每个粒子的Pbest与上次迭代种群的Gbest进行比较,如果较好,则将Gbest更新为最好的Pbest,并更新Gbest对应的位置更新为最好的Pbest所对应的粒子的位置;所有粒子按式(4)更新自己的位置和方向.不断重复上述过程直至迭代结束,最终得到一个较优的输入层权值矩阵、隐含层偏差矩阵.

4)把通过寻优得到输入层权值矩阵、隐含层偏差矩阵带入RELM进行训练和测试.

4 实验结果与分析

为了对PSO-RELM的性能进行测试,本文实验平台为MATLAB R2012b,并选取UCI数据集上的Breast和Brain数据集进行实验验证.数据集已经过归一化处理,前者包括575个样本,每个样本的特征维数为8,为二分类问题;后者样本数为485,样本特征数为8,是五分类问题.每次实验都从Breast和Brain数据集中随机选取训练样本和测试样本,为了降低这种随机性对实验造成的影响,所以每次实验进行10折交叉验证,然后实验结果取均值.

1)为使设置的隐层节点数较为合理,实验首先测试了在Breast数据集上隐层节点数对PSO-RELM的影响.初始把隐层节点数开始设置为10,然后在此基础上逐渐递加到100,共进行91次实验.记录每次实验的训练时间、训练精度和测试精度,结果选取8组,如表1.

表1 隐含层节点数对PSO-RELM的影响

Table1ImpactofhiddenlayernodenumberonPSO-RELM

隐含层节点数实验结果训练时间/s训练精度测试精度1110.67330.76080.75351810.99500.76600.75872511.74360.77130.76223512.14440.77890.77565011.91210.76810.76576016.68670.76930.76048020.40930.76080.769010023.61180.76600.7570

从表1可以看出,随着隐含层节点数的增加,PSO-RELM的训练时间在整体上也是递增的,且递增幅度逐渐增大,而训练精度和测试精度大体上是先增加再降低,并在35时达到最大.说明隐层节点数在相对较少时(不到50),PSO-RELM就能达到较满意的分类精度.因此综合考虑实验精度和时间两方面因素,后续实验PSO-RELM隐层节点数都设为35.

图1和图2展示的分别为PSO-RELM在Breast和Brain数据集上的适应度函数拟合曲线图.从图中可以看出,Breast数据集上迭代次数在50左右,Brain数据集上迭代次数在100左右时,曲线图开始趋于水平,说明适应度函数开始趋于收敛,这表明PSO-RELM的适应度函数具有很好的收敛性.

图1 Breast上的适应度函数拟合曲线图Figure 1 Fitness function fitting curve on Breast

图2 Brain上的适应度函数拟合曲线图Figure 2 Fitting fitness function curve on Brain

为了测试PSO-RELM的效果,本文的对比试验选用了标准的BP神经网络、SVM和RELM三种算法.其中BP神经网络中神经元个数设置为10;SVM采用台湾大学林智仁(Lin Chih-Jen)教授等开发设计的LIBSVM软件包[15],参数C设置为10;RELM隐层节点数设置为75,正则因子C设置为1;PSO-RELM中,粒子群优化算法采用PSOt工具包,根据实验和文献参考,粒子群规模设置为20[16],RELM隐层节点设置为35,正则因子C也设置为1.

稳定性是评价机器学习算法性能一个重要指标,实验进一步通过5次实验对四种算法的稳定性进行对比.

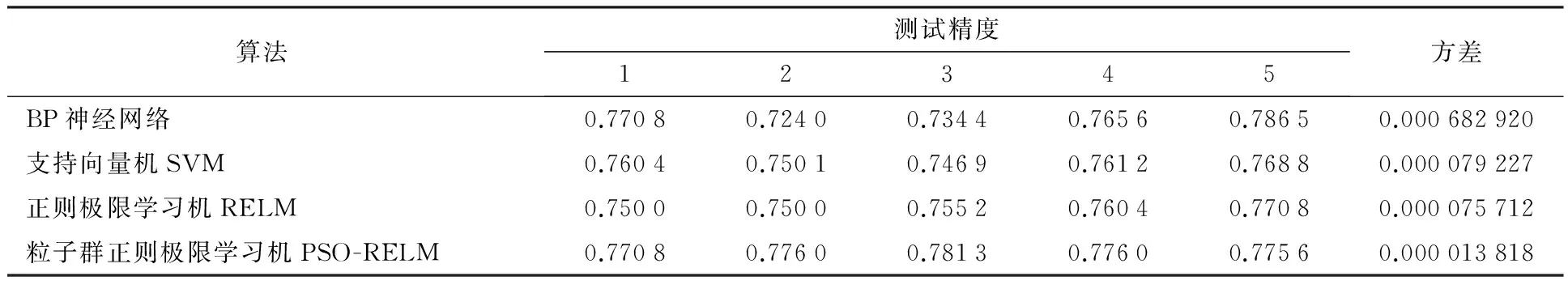

表2记录了四种算法在Breast数据集上五次实验中的测试精度,然后计算了每种算法对应的方差.从表2中可以看出三点:1)BP神经网络对应的方差比其他三个都高了一个数量级(约为10倍),这也表明BP神经网络比较不稳定;2)RELM比SVM稳定,但两者对应的方差相差比较小;3)PSO-RELM对应的方差比SVM、RELM对应的方差都小约0.000 06,稳定性相对提升比较明显.

表2 不同算法的稳定性对比

最后通过10次实验在Breast和Brain上对四种算法的精度进行对比,如图3和图4.

图3 Breast上不同算法的精度对比图Figure 3 Accuracy comparison of different algorithms on Breast

图4 Brain上不同算法的精度对比图Figure 4 Accuracy comparison of different algorithms on Brain

从图3、图4中可以看出,BP神经网络精度波动比较大,RELM波动比SVM小一些,精度也比SVM高一些;PSO-RELM相对RELM整体上比较平稳,且精度提高相对比较明显.

5 结 语

本文通过运用粒子群优化算法对RELM进行改进,提出了一种粒子群改进RELM(PSO-RELM)的基因表达数据分类方法.首先把RELM初始随机产生的一组输入层权值和隐含层偏差作为粒子带入粒子群优化算法进行寻优,然后把符合要求(即使分类误差最小)的最优粒子变换成输入层权值和隐含层偏差进行训练和测试.在Breast和Brain数据集上测试表明,PSO-RELM在隐层节点较少(设置为35)时,稳定性和分类精度相对都有一定的提高.

[1] ANDER E S. Array of hope[J].Nature Genetics,1999,21(Suppl):3-4.

[2] RAMASWAMY S, GOLUB T R. DNA microarrays in clinical oncology[J].Jornal of Clinical Oncology,2002,20(7):1932-1941.

[3] SLONIM D K. From patterns to pathways: gene expression data analysis comes of age[J].Nature Genetics,2002,32(Suppl):502-508.

[4] KURAMOCHI M, KARYPIS G. Gene classification using expression profiles: a feasibility study[J].International Journal on Artificial Intelligence Tools,2005,14(4):641-660.

[5] YI Jianqiang, WANG Qian, ZHAO Dongbin, et al. BP neural network prediction-based variable-period sampling approach for networked control systems[J].Applied Mathematics and Computation,2007,185(2):976-988.

[6] CRISTIANINI N, SHAWE-TAYLOR J. An introduction to support vector machines and other kernel-based learning methods[M].Cambridge University Press,2000:107-136.

[7] HUANG Guangbin, ZHU Qinyu, SIEW C K. Extreme learning machine: theory and applications[J].Neurocomputing,2006,70(1):489-501.

[8] 邓万宇,郑庆华,陈 琳,等.神经网络极速学习方法研究[J].计算机学报,2010(2): 279-287. DENG Wanyu, ZHENG Qinghua, CHEN Lin, et al. Research on extreme learning of neural networks[J].Chinese Journal of Computers,2010(2):279-287.

[9] 陆慧娟.基于基因表达数据的肿瘤分类算法研究[D].徐州:中国矿业大学,2012. LU Huijuan. A study of tumor classification algorithms using gene expression data[D].Xuzhou: China University of Mining and Technology,2012.

[10] 陆慧娟,安春霖,马小平,等.基于输出不一致测度的极限学习机集成的基因表达数据分类[J].计算机学报,2013,36(2):341-348. LU Huijuan, AN Chunlin, MA Xiaoping, et al.Disagreement measure based ensemble of extrme learning machine for gene expression data classification[J].Chinese Journal of Computers,2013,36(2):341-348.

[11] KENNEDY J, EBERHART R. Particle swarm optimization[C]//Proceeding of IEEE International Conference on Neural Networks. Piscataway, NJ: IEEE Press,1995:1942-1948.

[12] EBERHART R, KENNEDY J. A new optimizer using particle swarm theory[C]//Proceeding of the 6th International Symposium on Micro Machine and Human Science, Piscataway, NJ: IEEE Press,1995:39-43.

[13] 王杰,毕浩洋.一种基于粒子群优化的极限学习机[J].郑州大学学报:理学版,2013,45(1):101-104. WANG Jie, BI Haoyang. A new extreme learning machine optimized by PSO[J].Journal of Zhengzhou University: Natural Science Edition,2013,45(1):101-104.

[14] HAN Fei, YAO Haifen, LING Qinghua. An improved evolutionary extreme learning machine based on particle swarm optimization[J].Neurocomputing,2013,116:87-93.

[15] CHANG C C, LIN C J. LIBSVM: a library for support vector machines [EB/OL].(2014-11-10)[2012-11-16]http://www.csie.ntu.edu.tw/~cjlin/libsvm/.

[16] 王维博,林川,郑永康.粒子群算法中参数的实验与分析[J].西华大学学报:自然科学版,2008,27(1):76-80. WANG Weibo, LIN Chuan, ZHENG Yongkang. The experiment and analysis of parameters in particle swarm algorithm[J].Journal of Xihua University: Natural Science Edition,2008,27(1):76-80.

A method of particle swarm optimization RELM for gene expression data classification

WANG Shilei1, LU Huijuan1, GUAN Wei2, YU Cui1

(1. College of Information Engineering, China Jiliang University, Hangzhou 310018, China; 2. College of Modern Science and Technology, China Jiliang University, Hangzhou 310018, China)

Regularized extreme learning machines (RELM) have better generalization ability than extreme learning machines (ELM). However, the input layer weights and hidden layer bias of RELM are given randomly which could affect the stability of RELM. In addition, RELMs need to set lots of layer nodes in order to obtain relatively ideal classification accuracy. Aiming at this problem, we proposed a method which brought the initial input layer weights and hidden layer bias of RELMs into the particle swarm optimization (PSO) as partilces and optimized them by analyzing the theory of PSO. Through a series of 10-fold cross-validations on the Breast and Brain dataset, the results show that particle swarm optimization RELM (PSO-RELM) can obtain better classification accuracy and stability with fewer hidden nodes compared with the BP neural network, support vector machines (SVM) and RELMs.

regularized extreme learning machine; input layer weights; hidden layer bias; particle swarm

1004-1540(2015)02-0221-06

10.3969/j.issn.1004-1540.2015.02.018

2014-12-19 《中国计量学院学报》网址:zgjl.cbpt.cnki.net

国家自然科学基金资助项目(No.61272315,60842009),浙江省自然科学基金资助项目(No.Y1110342,Y1080950).

TP181

A