支持向量机原理及展望

2010-04-11陈冰梅樊晓平周志明李雪荣

陈冰梅,樊晓平,周志明,李雪荣

CHEN Bing-mei1,2, FAN Xiao-ping1, ZHOU Zhi-ming3, LI Xue-rong2

(1. 中南大学 信息科学与工程学院,长沙 410083;2. 中南大学 湘雅二医院,长沙 410011)3. 长沙环境保护职业技术学院,长沙 410004)

支持向量机原理及展望

The principle and prospect of support vector machine

陈冰梅1,2,樊晓平1,周志明3,李雪荣2

CHEN Bing-mei1,2, FAN Xiao-ping1, ZHOU Zhi-ming3, LI Xue-rong2

(1. 中南大学 信息科学与工程学院,长沙 410083;2. 中南大学 湘雅二医院,长沙 410011)3. 长沙环境保护职业技术学院,长沙 410004)

支持向量机(SVM)是90年代中期发展起来的基于统计学习理论的一种机器学习方法,通过寻求结构化风险最小来提高学习机泛化能力,实现经验风险和置信范围的最小化,从而达到在统计样本量较少的情况下,亦能获得良好统计规律的目的。该方法不但算法简单,而且具有较好的“鲁棒”性,与神经网络相比,它的优点是训练算法中不存在局部极小值问题,在解决小样本、非线性及高维模式识别问题中表现出许多特有的优势,并能够推广应用到函数拟合等其他机器学习问题中,现在已经在许多领域取得了成功的应用。

支持向量机;神经网络;分类器;核函数

0 引言

支持向量机(Support Vector Machine,SVM)是由Vapnik领导的AT&TBell实验室研究小组在1963年提出的一种新的非常有潜力的分类技术,SVM是一种基于统计学习理论的模式识别方法,主要应用于模式识别领域。由于当时这些研究尚不十分完善,在解决模式识别问题中往往趋于保守,且数学上比较艰涩,这些研究一直没有得到充分的重视。直到90年代,统计学习理论 (Statistical Learning Theory,SLT)的实现和由于神经网络等较新兴的机器学习方法的研究遇到一些重要的困难,比如如何确定网络结构的问题、过学习与欠学习问题、局部极小点问题等,使得SVM迅速发展和完善,在解决小样本、非线性及高维模式识别问题中表现出许多特有的优势,并能够推广应用到函数拟合等其他机器学习问题中,从此迅速的发展起来,现在已经在许多领域取得了成功的应用。

1 基本原理

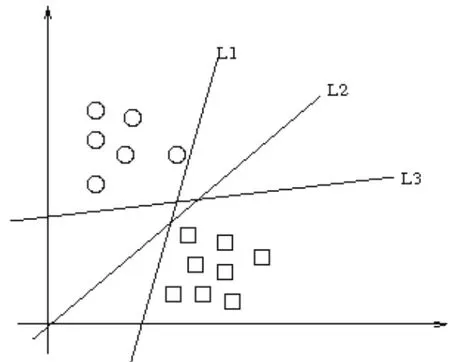

假设如图1这些数据点是n维实空间中的点。我们希望能够把这些点通过一个n-1维的超平面分开。通常这个被称为线性分类器。有很多分类器都符合这个要求。但是我们还希望找到分类最佳的平面,即使得属于两个不同类的数据点间隔最大的那个面,该面亦称为最大间隔超平面。如果我们能够找到这个面,那么这个分类器就称为最大间隔分类器。

图1 多种分类超平面示意图

如图1有很多个分类器(超平面)可以把数据分开,但是只有一个能够达到最大分割。

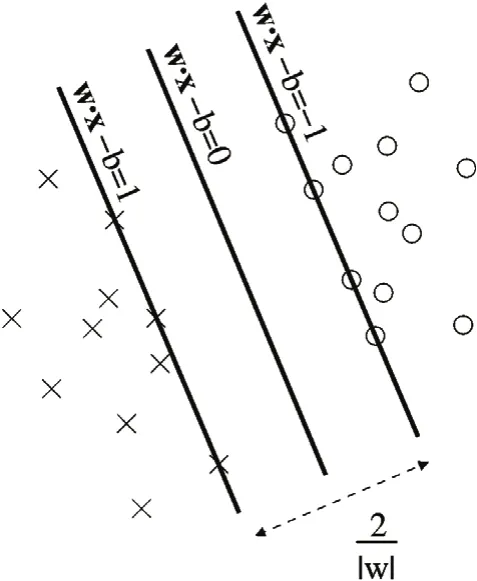

支持向量机将向量映射到一个更高维的空间里,在这个空间里建立有一个最大间隔超平面。在分开数据的超平面的两边建有两个互相平行的超平面。建立方向合适的分隔超平面使两个与之平行的超平面间的距离最大化。假定平行超平面间的距离或差距越大,分类器的总误差越小。

支持向量机属于一般化线性分类器。他们也可以认为是提克洛夫规则化(Tikhonov Regularization)方法的一个特例。这种分类器的特点是他们能够同时最小化经验误差与最大化几何边缘区。因此支持向量机也被称为最大边缘区分类器。

所谓支持向量是指那些在间隔区边缘的训练样本点。 这里的“机(machine,机器)”实际上是一个算法。在机器学习领域,常把一些算法看做是一个机器。

图2 在超平面上的样本点也称为支持向量

如图2设样本属于两个类,用该样本训练svm得到的最大间隔超平面。在超平面上的样本点也称为支持向量,支持向量机方法是建立在统计学习理论的VC 维理论和结构风险最小原理基础上的,根据有限的样本信息在模型的复杂性(即对特定训练样本的学习精度)和学习能力(即无错误地识别任意样本的能力)之间寻求最佳折衷,以期获得最好的推广能力 。

支持向量机(Support vector machines,SVM)与神经网络类似,都是学习型的机制,但与神经网络不同的是SVM使用的是数学方法和优化技术。

2 支持向量机的算法

SVM的支持向量机的主要思想可以概括为两点:

1)它是针对线性可分情况进行分析,对于线性不可分的情况,通过使用非线性映射算法将低维输入空间线性不可分的样本转化为高维特征空间使其线性可分,从而使得高维特征空间采用线性算法对样本的非线性特征进行线性分析成为可能;

2)它基于结构风险最小化理论之上在特征空间中建构最优分割超平面,使得学习器得到全局最优化,并且在整个样本空间的期望风险以某个概率满足一定上界。

支持向量机的目标就是要根据结构风险最小化原理,构造一个目标函数将两类模式尽可能地区分开来,通常分为两类情况来讨论:线性可分与线性不可分。

2.1 线性可分情况

在线性可分的情况下,就会存在一个超平面使得训练样本完全分开,该超平面可描述为:

w ·x + b = 0 (1)

其中,“·”是点积, w是n维向量, b为偏移量。

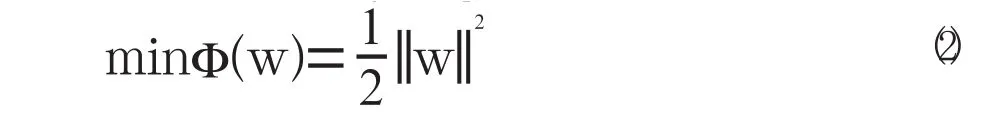

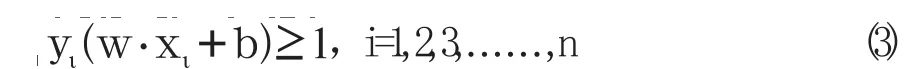

最优超平面是使得每一类数据与超平面距离最近的向量与超平面之间的距离最大的这样的平面,最优超平面可以通过解下面的二次优化问题来获得:

满足约束条件:

在特征数目特别大的情况,可以将此二次规划问题转化为其对偶问题:

满足约束条件:

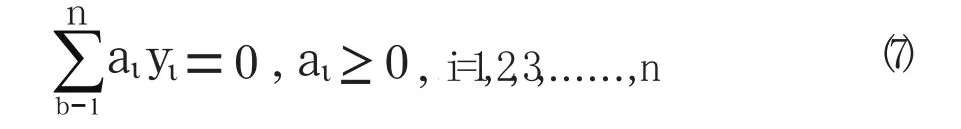

这里α=(α1,...,αn)是Lagrange 乘子,b*是最优超平面的法向量, 是最优超平面的偏移量,在这类优化问题的求解与分析中,KKT条件将起到很重要的作用,在(7) 式中,其解必须满足:

从式(5)可知,那些aι=0的样本对分类没有任何作用,只有那些aι>0的样本才对分类起作用,这些样本称为支持向量,故最终的分类函数为:

根据f (x)的符号来确定X 的归属。

2.2 线性不可分的情况

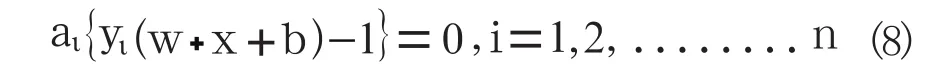

对于线性不可分的情况,可以把样本X 映射到一个高维特征空间H,并在此空间中运用原空间的函数来实现内积运算,这样将非线性问题转换成另一空间的线性问题来获得一个样本的归属,根据泛函的有关理论,只要一种核函数满足Mercer条件,它就对应某一空间中的内积,因此只要在最优分类面上采用适当的内积函数就可以实现这种线性不可分的分类问题。此时的目标函数为:

其相应的分类函数为:

2.3 内积核函数

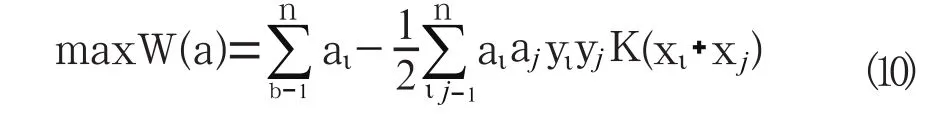

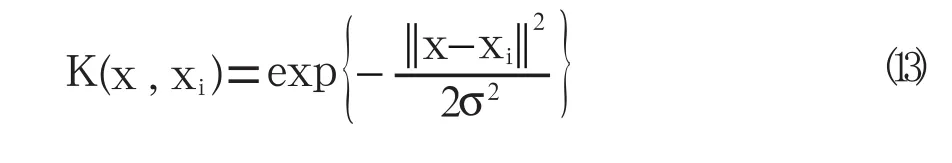

SVM的关键在于核函数。低维空间向量集通常难于划分,解决的方法是将它们映射到高维空间。但这个办法带来的困难就是计算复杂度的增加,而核函数正好巧妙地解决了这个问题。也就是说,只要选用适当的核函数,就可以得到高维空间的分类函数。在SVM理论中,采用不同的核函数将导致不同的SVM算法。目前有三类用的较多的内积核函数:第一类是

我们所能得到的是p阶多项式分类器,第二类是径向基函数(RBF),也称作高斯核函数:

第三类是Sigmoid函数:

这时SVM实现的就是包含一个隐层感知器,隐层结点数是由算法自动确定的。究竟用哪一种核函数比较好,这还是取决你对数据处理的要求,不过建议可以使用径向基函数。

3 支持向量机的特点

1)它是专门针对有限样本情况的,其目标是得到现有信息下的最优解而不仅仅是样本数趋于无穷大时的最优值;

2)算法最终将转化成为一个二次型寻优问题,从理论上说,得到的将是全局最优点,解决了在神经网络方法中无法避免的局部极值问题;

3)算法将实际问题通过非线性变换转换到高维的特征空间(Feature Space),在高维空间中构造线性判别函数来实现原空间中的非线性判别函数,特殊性质能保证机器有较好的推广能力,同时它巧妙地解决了维数问题,其算法复杂度与样本维数无关;

4)在SVM方法中,只要定义不同的内积函数,就可以实现多项式逼近、贝叶斯分类器、径向基函数(Radial Basic Function或RBF)方法、多层感知器网络等许多现有学习算法。

5)该方法不但算法简单,而且具有较好的“鲁棒”性。

4 结束语

支持向量机算法是一个凸二次优化问题,能够保证找到的极值解就是全局最优解,是神经网络领域取得的一项重大突破。与神经网络相比,它的优点是训练算法中不存在局部极小值问题,可以自动设计模型复杂度(例如隐层节点数),不存在维数灾难问题,泛化能力强,SVM已初步表现出很多优于已有方法的性能。 SVM正在成为继神经网络研究之后新的研究热点,并将推动机器学习理论和技术有重大的发展。

支持向量机能非常成功地处理回归问题(时间序列分析)、模式识别(分类问题、判别分析)、 概率密度函数估计等诸多问题,并可推广于预测和综合评价等领域,例如,在模式识别方面,对于手写数字识别、语音识别、人脸图像识别、文章分类等问题,SVM算法在精度上已经超过传统的学习算法或与之不相上下。目前国际上支持向量机理论研究和实际应用两方面都正处于飞速发展阶段。

[1] B.E.Boser,I.M.Guyon,and V.N.Vapnik. A training algorithm for optimal margin classifiers.In D.Haussler, editor,5th Annual ACM Workshop on COLT,pages 144-152,Pittsburgh,PA,1992.ACM Press.

[2] Corinna Cortes and V.Vapnik,"Support-Vector Networks,Machine Learning,20,1995,1.

[3] 张艳.一类基于支持向量机的软件故障预测方法[J].小型微型计算机系统,2010.31(7):1380-1383.

[4] 杜树新,吴铁军.模式识别中的支持向量机方法[J].浙江大学学报(工学版), 2003,9,37(5):521-526.

[5] 刘渤海.基于ANN和SVM的质量预测方法研究[J].制造业自动化,2010.32(5):152-155.

[6] 韦抒.应用支持向量机实现转子故障的模式分类[J].制造业自动化,2009.31(7):82-85.

TP273

A

1009-0134(2010)12(上)-0136-03

10.3969/j.issn.1009-0134.2010.12(上).45

2010-08-17

国家自然科学基金题(39270262)

陈冰梅(1963 -),女,广西玉林人,高级,工程师,在读博士,研究方向为人工智能和智能计算。