用于图像检索的多区域深度特征加权聚合算法

2020-12-01张超林正春姜允志贾西平王静

张超 林正春 姜允志 贾西平 王静

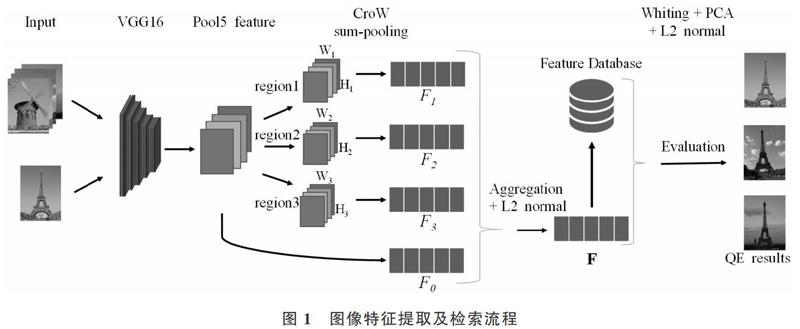

摘 要:针对图像检索中多区域加权聚合算法局部特征提取过程较繁琐、耗时及内存占用高等问题,提出多区域深度特征加权聚合算法(MR-CroW)。该算法通过增大深度卷积神经网络(DCNN)最后一个卷积层池化窗口,调整预训练DCNN模型VGG16,得到全局特征提取器; 选择子区域作为检索对象响应区域,抑制非主要目标噪声;引入跨维度加权聚合算法(CroW),将多个区域特征进行加权聚合,得到最终的特征向量。在Oxford5K和Paris6K数据集上的实验结果表明,MR-CroW平均准确率(mAP)高于其它几种算法,特征处理阶段时间低于其它几种算法。

關键词:深度卷积神经网络;特征提取;多区域;加权聚合

DOI:10. 11907/rjdk. 201032

中图分类号:TP312文献标识码:A 文章编号:1672-7800(2020)010-0133-05

Abstract:A weighted depth features of multi-region aggregation algorithm (MR-CroW) is proposed for image retrieval to solve the problem that multi-region weighted aggregation algorithms the local feature extraction process is cumbersome, time-consuming, and high memory usage. MR-CroW enlages the pooling window of the last convolutional layer of model VGG16 as the global feature extractor, selects the sub-region as the response region to denoise the non-primary target, uses cross-dimensional weighted aggregation algorithm (CroW) and aggregates weighted features of multi-region to get the final eigenvector. The experimental results on the Oxford5K and Paris6K datasets show that the average accuracy (mAP) of MR-CroW is higher than other algorithms; the time consumption of the feature processing phase is lower than others.

Key Words: deep convolution neural network; feature extraction; multi-region; cross weighted aggregation

0 引言

图像检索是计算机视觉研究领域热点之一,早期的图像检索是基于文本(TBIR)的,随着图像数据量增加,TBIR已不能满足时代需求,取而代之的是基于内容的图像检索(content-based image retrieval,CBIR)[1-2]。传统的CBIR使用颜色、纹理、形状等全局描述子。以SIFT(scale-invariant feature transform)为代表的局部描述子以及词袋模型BoW(bag of words),其不受尺度变换与旋转影响,具有良好的鲁棒性,可在不同目标与场景下实现更可靠的匹配,逐渐取代全局描述子成为研究热点[3-4]。这些方法在前期的图像检索中成绩斐然,但始终未解决低层特征与高层语义之间的语义鸿沟问题[5]。

2012年AlexNet网络在ImageNet大赛上取得令人惊讶的成绩,此后DCNN(deep convolutional neural network)逐渐成为计算机视觉研究热点[6]。人们发现通过DCNN训练可以学习到更深层次的图像特征,并在一定程度上弥合低层特征与高层语义之间的语义鸿沟。研究表明,在ImageNet等足够大且多样化的数据集上训练DCNN可成功应用到其它视觉任务上,如图像分类[7]、目标检测[8]、语义分割[9]等领域。DCNN出色的特征提取与表达能力为图像检索研究带来新思路。利用DCNN方法提取特征描述子取代传统特征提取方法成为图像检索研究的主流,基于ImageNet等大规模数据集训练得到的预训练网络模型广泛应用于图像检索的特征提取[10]。

本文提出基于DCNN的改进多区域特征加权聚合方法MR-CroW,通过调整预训练神经网络模型最后一个卷积层的池化方式得到图片的全局特征,再对检索对象可能出现的位置进行局部采样,整合有限个子区域特征,最后将多个区域特征进行加权聚合得到最终的特征表示。实验表明,MR-CroW在不进行重新训练网络模型前提下, Oxford5K数据上的重排平均准确率达0.804,在Paris6K数据上的重排平均准确率达0.892。

1 相关工作

深度卷积神经网络主要由卷积层和全连接层两大部分组成,形成以卷积层特征作为图像描述子和以全连接层特征作为图像描述子两大分支。由于全连接层特征描述子作为高层特征在图像分类任务中表现出色,因此早期利用DCNN进行图像检索的研究一般采用全连接层特征作为描述子[11]。但该方法存在特征维度高、图片输入有限制等问题。随着检索任务复杂程度的增加以及研究的深入,发现相比于全连接层,卷积层特征包含一定的位置特征信息,使其更适合作为图像描述子。因此,图像特征描述子研究逐渐由全连接层转向卷积层。

Babenko等[12]针对深度特征提出SPoC(Sum-Pooled Convolution)方法,通过预训练深度网络得到最后一个卷积层输出作为描述子,利用全局聚合池化结合白化PCA(Principal Component Analysis),获得比最大池化方法更好的结果,有效降低特征维度;Kalantidis等[13]针对空间和通道特征,提出跨维度加权聚合方法CroW(Cross-Dimensional Weighting),显著提高检索性能。虽然以上方法都提出了区域加权思想,但本质上还是全局特征,对局部检索对象缺乏重视。Gong等[14]提出多尺度无序池化方法MOP(Multi-scale Orderless Pooling)用于解决DCNN缺乏几何不变性问题;Tolias等[15]采用类似MOP的方法,提出局部最大池化聚合算法R-MAC,对图像的多个子区域进行采样。不同的是,R-MAC(Retrieval with integral Max-pooling)使用卷积层特征作为全局特征表示,这种变换使R-MAC在性能上相对于MOP有大幅提升。虽然这种方法考虑到图像的局部明显特征,但是忽视了通道特征。

文献[16-17]使用融合方法,将CroW与R-MAC两种方法结合使用提升检索结果,但在子区域选取方面,R-MAC使用大面积滑窗采样方法。虽然这种采样方法可以提取更多的细节特征,但是滑动采样存在随机性问题。随着非目标区域采样增加,噪声影响也变得明显,同时过多的子区域选择增加了特征提取与处理时间。为此,本文提出MR-CroW算法对传统预训练网络池化层进行结构调整,只提取和使用3个主要目标子区域特征,在有效规避噪声引入的同时,大幅缩减特征处理阶段复杂度,提升检索效率,取得较好的实验结果。

2 MR-CroW算法

将多区域加权聚合用于实例图像检索方法MR-CroW的图像特征提取及检索过程如下:

(1) 池化特征提取。使用一个去除全连接层的预训练DCNN模型作为特征提取器,设输入图像I的大小为HI×WI,经过卷积层激活(响应)和池化,得到C×H×W 维的三维特征张量。H和W分别代表图片的高度和宽度映射,C为输出特征通道个数,输出特征图尺寸将根据输入图片大小而变化,这是将卷积层特征作为描述子的优点之一。获取池化层特征方式不同于传统VGG16的max pooling采用[2×2]窗口,而是采用[5×5]窗口,使特征更加稀疏。

(2) 子区域选择。子区域选取采用文献[18]提出的主要响应区域法,在提取全局池化特征基础上,在区域采样时不是像R-MAC过多地选择子区域,而是针对性采样以减少子区域特征提取时间,提升检索效率。

(3) 加权聚合。针对pool5特征以及选取的子区域特征,采用跨维度加权聚合方法CroW,对每个独立区域的池化特征分别进行空间和通道加权,将子区域特征向量聚合形成紧凑的全局特征向量。

(4) 度量评估。为度量不同维度,对全局特征向量进行白化和PCA处理,再进行L2归一化,得到不同维度的特征向量。将查询特征向量与数据库中特征向量进行相似性比较,通过常用的扩展查询方法得到最终的检索结果。

2.1 跨维度加權聚合算法CroW

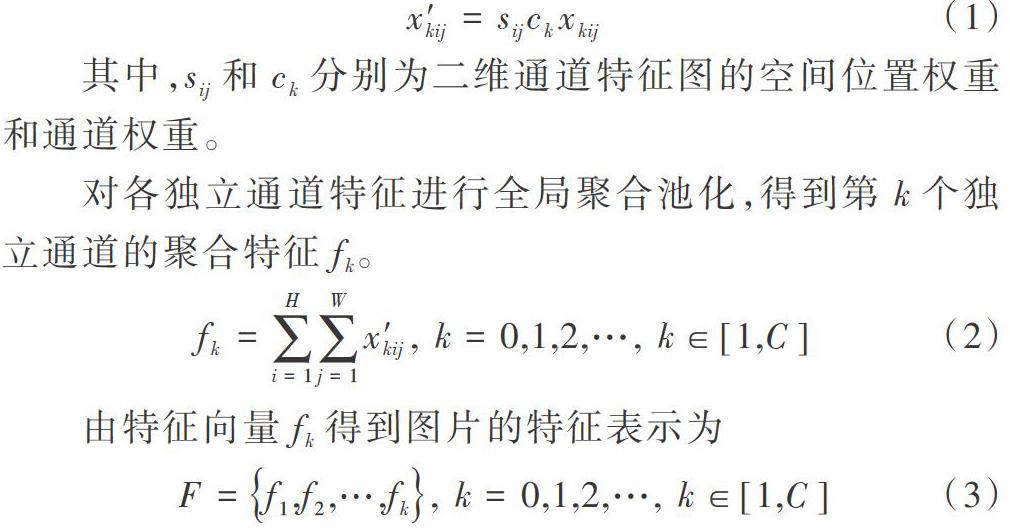

对得到的三维特征张量,每个独立通道特征是一个[H×W]的2D张量。设[C(k)]表示第[k]个通道的特征图,[xkij]表示[C(k)]在坐标[(i,j)]处的特征值,则该位置加权特征为

对各独立通道特征进行全局聚合池化,得到第[k]个独立通道的聚合特征[fk]。

2.2 子区域选择

Gong等[14]对图片进行裁剪后多次输入预训练模型得到子区域特征。在每次提取子区域特征时都需要重新加载模型,重复的输入输出以及模型加载会消耗大量时间。针对这一问题,R-MAC使用卷积层特征作为全局特征。卷积层输出特征较好保留了原图尺寸和位置属性,可在全局特征上进行子区域选取,降低子区域特征选择时间。虽然R-MAC比Gong提出的方法高效很多,但R-MAC提出的复杂窗口滑动检测方法带有一定的随机性。随着采样区域增加,引入的非目标区域噪声也随之增加,造成子区域特征选取耗时增加。文献[12]利用对象通常出现在图像几何中心的特点,提出SPoC算法,使用中心先验空间加权增强图像中心出现的特征。本文采用类似方法着重对中心区域进行子区域选择,简化子区域选择流程,采用更少的子区域得到更好的检索结果。

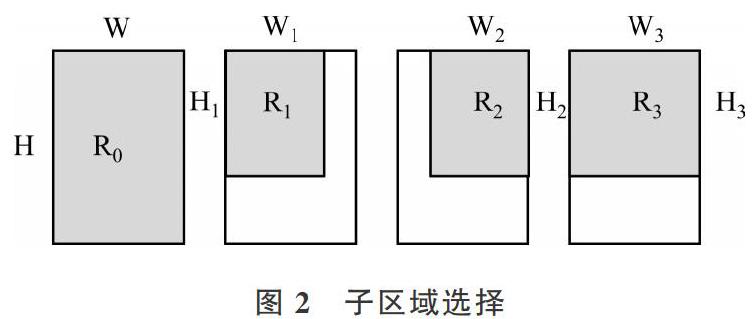

检索对象的关键部分集中在图片上半部,因此本文只采集左上部、右上部、上部3个子区域,采样过程如图2所示。

连同全局特征,本文一共使用4个区域特征聚合。R0代表pool5全局特征,选取3个子区域分别为R1、R2、R3,3个子区域高度相同,即[H1=H2=H3=H*β],其中R1和R2宽度相同,为[W1=W2=W*α],R3的宽度为[W3=W]。经过试验得出[α]和[β]值,较合理取值为:[α=0.3],[β=0.6]。

2.3 特征聚合

聚合操作可看作是区域加权操作的另一种形式。在进行特征聚合前,需要对每个独立子区域特征进行加权操作。令Fr为每个独立子区域的特征向量,对选取的子区域特征Fr进行对应维度聚合操作,则最终图像聚合特征F为:

2.4 白化

对不同维度特征进行比较时,需要对数据进行白化和PCA降维。白化使不同维度的数据具有相同的方差,同时使各个维度之间的相关性降低。本文采用的白化处理方法与文献[13]中的交叉白化测试方法相同,对Oxford5K测试时使用Paris6K数据作为白化参数,反之对Paris6K测试使用Oxford5K数据作为白化参数。

2.5 度量计算

向量与向量之间的相似性度量常用方法有欧氏距离与余弦距离。欧氏距离在孤立数据集表现良好,即便两个向量没有共同的属性值,它们之间的数值距离也可能比另一对包含有相同属性的向量要小。余弦距离计算两个特征向量之间的夹角,更加注重数据维度之间的差异而不单单是数值上的差异,从而有效规避不同维度数值带来的认知差异。虽然经过归一化的余弦距离和欧式距离是等价的,但是欧氏距离计算量更大,计算时间更长[19]。使用余弦距离计算DCNN特征相似度,普遍比使用欧氏距离计算的准确率高,因此本文采用余弦距离作为度量方法[20]。

2.6 扩展查询

检索结果最终评估使用官方提供的评估代码测试查询(共110张图片)的平均精度(mAP)。扩展查询[21](Query Expansion,QE)对TOP-K的结果聚合后做L2归一化处理,再进行检索重排。这种方法计算简单且能有效提升检索效果,是图像检索常用的方法。最终结果比较使用相同的查询扩展方法,对扩展查询数据取TOP-10进行比较,与其它文献一样。

3 实验

3.1 数据集描述

为验证本文方法的真实性与有效性,在Oxford5K[22]和Paris6K[23]两个地标数据集上进行测试。两个数据均从Flickr上收集得到,并且所有数据都被人工标注。其中Oxford5k由5 062张图片组成,Paris6k由6 392张图片(提供的6 412张图片中有20张已损坏)组成。根据官方提供的标准评价协议,两个数据集分别含有11个类别55张查询图。每张图像查询结果都有3种可能:good、ok、junk。其中,good和ok图像认为是正例结果,junk作为负面结果在计算最终检索结果时主动忽略不予考虑。

3.2 特征提取

本文使用Caffe[24]预训练模型VGG16作为特征提取器,对输入图片减去平均像素进行归一化处理,采用官方提供的坐标数据进行裁剪后再提取图像的池化特征,采用最后一个池化层特征作为全局特征。与其它方法不同,本文对池化窗口进行改进,使用更大的窗口([5×5]),将多个区域特征加权聚合得到的512维特征向量进行降维以节省存储空间,使后续子区域特征选取和计算的速度得到提升。

由图3和图4可以看出,当选择大小为[5×5]的池化窗口时,相对于其它尺寸窗口,CroW算法检索准确率较高。

3.3 实验结果与分析

表1为MR-CroW算法与其它几种常见算法的比较结果。在3个数据维度上,MR-CroW均表现较好。使用扩展查询(QE)后,检索效果进一步提升。相比于Crow方法,本文在Oxford5K的3个维度平均准确率提升约5%,使用TOP-10扩展查询(QE)后提升约7%;对Paris6K数据,未使用QE的结果平均提升约4.3%,使用QE的结果则提升约5.5%。与Dong等提出的改进方法相比,MR-CroW算法的准确率也高出2%。

对MR-CroW和R-MAC提取整个数据集的多个子区域特征进行测试,在相同实验环境下(虚拟机:vmware workstation 14,系统:Ubuntu-18.04.2,CPU:4核 Intel(R) Core(TM) i7-6700 CPU @3.4GHz,内存:8GB,硬盘:120GB)使用不同大小的池化窗口和不同采样方式对时间消耗进行实验对比,验证MR-CroW算法在检索任务中的有效性,改进的池化层结构在一定程度上提升了检索效果。通过对多个目标子区域提取特征进行加权聚合,检索结果得到显著提升。此外,与R-MAC提出的滑动检测法提取子区域特征不同,本文选择指定子区域进行特征提取,大大縮减了特征处理时间,提升了检索效率。

4 结语

本文提出一种多区域深度特征加权聚合算法MR-CroW用于图像检索。该算法无需重新训练新的网络模型,只是对预训练神经网络模型进行调整和改进。在获取全局特征时使用更大的池化窗口,针对检索对象可能出现的区域进行针对性采样,得到多个子区域特征表示,通过加权聚合得到图片的最终特征表示,使用度量计算比较以及扩展查询得到最终的检索结果。与几种常见的图像检索方法进行比较实验,结果表明本文方法效果更优。后续可对子区域选择及网络微调进行更深入研究,以进一步提高检索性能。

参考文献:

[1] 周文罡,李厚强,田奇. 图像检索技术研究进展[J]. ,2017,9(6):613-634.

[2] ZHENG L, YANG Y, TIAN Q. SIFT meets CNN: a decade survey of instance retrieval[J]. IEEE Transactions on Pattern analysis and Machine Intelligence, 2017, 40(5):1224-1244.

[3] LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision,2004,60(2):91-110.

[4] SIVIC J, ZISSERMAN A. Video google: a text retrieval approach to object matching in videos[C]. Appearsin:Proceedings of International Conference on Computer Vision, 2003.

[5] WAN J, WANG D, HOI S C H, et al. Deep learning for content-based image retrieval: a comprehensive study[C]. Proceedings of the 22nd ACM International Conference on Multimedia, 2014:157-166.

[6] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[C]. Advances in Neural Information Processing Systems, 2012:1097-1105.

[7] SIMONYAN K,ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. https://arxiv.org/pdf/1409.1556. pdf.

[8] REN S, HE K, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[C]. Advances in Neural Information Processing Systems, 2015:91-99.

[9] LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015:3431-3440.

[10] 张皓, 吴建鑫. 基于深度特征的无监督图像检索研究综述[J]. 计算机研究与发展, 2018, 55(9):1829-1842.

[11] BABENKO A,SLESAREV A, CHIGORIN A, et al. Neural codes for image retrieval[C]. European Conference on Computer Vision, 2014:584-599.

[12] BABENKO A, LEMPITSKY V. Aggregating deep convolutional features for image retrieval[J]. arXiv preprint arXiv,2015(1510): 74-93.

[13] KALANTIDIS Y, MELLINA C, OSINDERO S. Cross-dimensional weighting for aggregated deep convolutional features[C]. European Conference on Computer Vision, 2016:685-701.

[14] GONG Y, WANG L, GUO R, et al. Multi-scale orderless pooling of deep convolutional activation features[C]. European Conference on Computer Vision, 2014:392-407.

[15] TOLIAS G, SICRE R, J?GOU H. Particular object retrieval with integral max-pooling of CNN activations[DB/OL]. https://arxiv.org/pdf/1511.05879.pdf.

[16] 董荣胜, 程德强, 李凤英. 用于图像检索的多区域交叉加权聚合深度卷积特征[J]. 计算机辅助设计与图形学学报, 2018, 30(4):658-665.

[17] 袁晖, 廖开阳, 郑元林,等. 基于CNN特征加权和区域整合的图像检索[J]. 计算机工程与科学, 2018,41(1):117-125.

[18] BABENKO A, SLESAREV A, CHIGORIN A, et al. Neural codes for image retrieval[C]. Proceedings of European Conference on Computer Vision, 2014:584-599.

[19] WANG H, CAI Y, ZHANG Y, et al. Deep learning for image retrieval: what works and what doesnt[C]. Proceedings of 2015 IEEE International Conference on Data Mining Workshop (ICDMW), 2015:1576-1583.

[20] 周晔,张军平. 基于多尺度深度学习的商品图像检索[J]. 计算机研究与发展,2017,54(8):1824-1832.

[21] CHUM O, PHILBIN J, SIVIC J, et al. Total recall: automatic query expansion with a generative feature model for object retrieval[C]. 2007 IEEE 11th International Conference on Computer Vision, 2007:1-8.

[22] PHILBIN J, CHUM O, ISARD M, et al. Object retrieval with large vocabularies and fast spatial matching[C]. 2007 IEEE Conference on Computer Vision and Pattern Recognition, 2007:1-8.

[23] PHILBIN J, CHUM O, ISARD M, et al. Lost in quantization: improving particular object retrieval in large scale image databases[C]. 2008 IEEE Conference on Computer Vision and Pattern Recognition, 2008:1-8.

[24] JIA Y, SHELHAMER E, DONAHUE J, et al. Caffe: convolutional architecture for fast feature embedding[C]. Proceedings of the 22nd ACM International Conference on Multimedia, 2014:675-678.

[25] JIMENEZ A, ALVAREZ J M, GIRO-I-NIETO X. Class-weighted convolutional features for visual instance search[J]. arXiv preprint arXiv,2017(1701):25-81.

[26] XU J, SHI C, QI C, et al. Unsupervised part-based weighting aggregation of deep convolutional features for image retrieval[C]. Thirty-Second AAAI Conference on Artificial Intelligence, 2018.

(責任编辑:杜能钢)