低照度边缘增强的语义分割模型研究

2020-09-21芦春雨

罗 晖,芦春雨

(华东交通大学信息与通信工程学院,江西 南昌330013)

语义分割是将整个图像分割成多个像素组的机器视觉任务。 基于深度学习的图像语义分割网络是近几年的研究热点,其分割精度和处理效率都明显优于传统分割模型[1]。 文献[2]提出全卷积网络(FCN,fully convolutional network), 实现了对输入图像的密集语义分割预测, 证明了卷积神经网络(CNN,convolutional neural network)在语义分割中的可行性。 相较此前的分割方法,FCN 分割效果更好,但其分割图仍较粗略。此外,CNN 的空间不变性,会造成特征图位置信息的丢失,影响分割。 为此,文献[3]提出了SegNet,通过引入跳跃卷积,并将由池化索引得到稀疏特征图进行解码得到分割结果,提高了分割速率。 文献[4]将CNN的最后一层输出与条件随机场相结合来改善分割精度,并利用膨胀卷积(atrous convolution)增加卷积的特征感受野,改善分割效果。 随后,为了进一步提升基于CNN 的语义分割模型的分割精度和分割效率,文献[5]引入空间金字塔池(ASPP,atrous spatial pyramid pooling)结构对DeepLab V1 进行了改进;文献[6]中,将Xception 中可分卷积结构引入ASPP 中作为编码,并用膨胀卷积的输出编码特征的分辨率来平衡编码-解码结构的精度和运行时间。文献[7]将条件独立的假设添加到全连接的CRF 中,并与卷积神经网络结合,加快了网络的训练和推断速度。 文献[8]在深度特征输出上施加空间金字塔注意力结构,并结合全局池化策略学习出更好的特征表征。 文献[9]将深度特征卷积之后,通过上采样与浅层特征相乘,获取融合特征图,以改善分割效果。

以上文献介绍的语义分割模型虽然都在一定程度上对以往的模型进行了改进,但针对光照较弱背景下的图像语义分割的研究并不多。 为此,在FCN 的基础上,从局部特征增强的角度,引入一种局部增强算法来增强低图像照度边缘特征,并提出低光照边缘增强的语义分割模型(EESN,semantic segmentation model with low-illumination edge enhancement),以提高对低照度图像语义分割精度。

1 基本理论

在本节中更详细地回顾了用于语义分割的残差网络(ResNet,residual network)[10]的结构,并讨论专为生成高质量区域建议而设计的区域提议网络(RPN,region proposal network)[11]。

1.1 残差网络

CNN 可被视为由浅层网络和深层网络共同组成,且深层网络是浅层的等价映射。 浅层网络的输出x 为深层网络的输入,且对应的深层网络的输出为H(x)。 因为深层网络是浅层网络的等价映射,则有

而直接学习该恒等映射比较困难。 因而,将重点放在深层网络和浅层网络的差值即残差F(x)分析

这样学习恒等映射式(1)则可以转换为式(3)的学习

而对深度卷积神经网络而言,F(x)随x 的变化幅度远远大于H(x)随x 的变化幅度。根据F(x)的变化来调节训练中网络参数,能够有效地避免因神经网络层数过深而带来的梯度消失或梯度爆炸问题。

ResNet 的提出使得训练更加深层的卷积网络成为可能,进而使学习图像中更深层的语义信息成为可能。

1.2 区域建议网络

在RPN 之前,常用的候选区域块生成算法包括选择性搜索(SS,selective search),Bing,Edge b-Boxes等。 这些算法首先生成一系列候选目标区域,然后利用CNN 提取目标候选区域的特征,再根据学习到的特征做后续处理,这需要耗费大量的计算量。

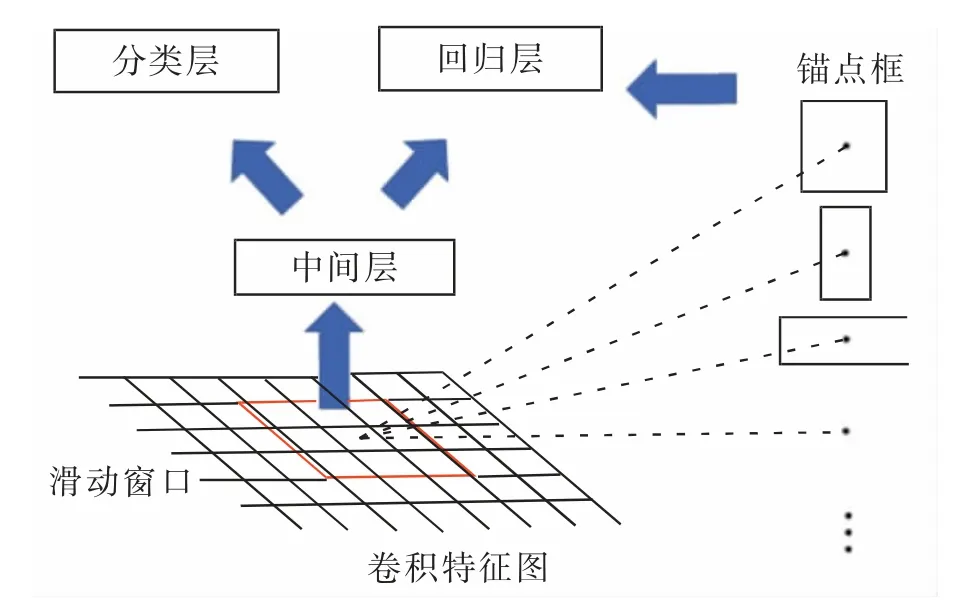

为减少候选区域生成的耗时, 提出了RPN来生成目标候选区域,具体的过程如图1 所示。

在RPN 中, 首先根据设定的长宽比和尺度在特征图像以滑动生成不同尺度的锚点,然后根据对这些锚点的二分类结果去除负样本锚点,最后基于锚点与真实目标边框做初步回归,得到较高质量的建议区域。 使用RPN 作为EESN 的区域建议网络能够减少计算量,同时保证其分割的效率。

图1 基于RPN 目标候选区域生成示意图Fig.1 Schematic diagram of candidate region generation based on RPN

2 低照度边缘增强语义分割

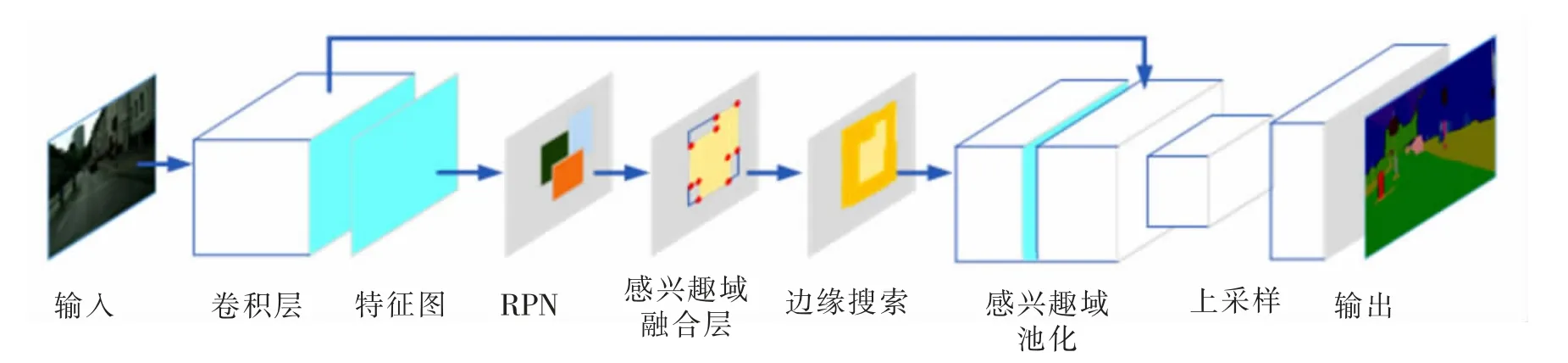

低照度场景下,光靠调节拍摄装置的曝光率仍旧不能完全解决某些区域出现的模糊和信息丢失的问题。 为了克服图像中低照度边缘的识别困难,将一种局部增强算法引入语义分割网络,其结构模型如图2所示。

利用EESN 模型实现语义分割的具体过程如下:首先利用卷积层提取输入图像的语义特征;然后通过RPN 生成目标区域建议,再利用融合层将重叠区域融合;在融合形成的兴趣域基础上,通过搜索窗口检测是否包含低照度边缘,并根据增强算法对检测到的低照度边缘进行局部增强;增强之后的特征图输入联合池化层,再由上采样层进行上采样后,得到与原图等大的预测结果。

图2 EESN 示意图Fig.2 Schematic diagram of EESN

2.1 基于RPN 的区域建议生成

EESN 采用ResNet-101 作为主干网,对输入图像进行卷积特征提取,并将其最后卷积层的输出特征图输入到RPN 中。 RPN 在输入特征图上滑动产生锚点,并采用与Faster R-CNN 相同的锚点生成方式,即面积有三种(128*128,256*256,512*512),长宽比有三种(1∶1,1∶2,2∶1);用来采样的锚点的IoU 阈值为0.7;每张图最终得到约300 个区域建议。 通过RPN 生成的区域建议具有较高质量,这些区域建议是由具有相似特征的像素聚合而成的同质块,它们反映了图像中重要的统计特征。 与单个和孤立的像素相比,区域建议中可以提取更有意义的统计特征,同时能够保留目标的原始真实边界信息,进而更利于提高语义分割的鲁棒性。

2.2 区域建议融合

RPN 所生成的区域建议的集合R 为

真实的语义分割区域集合GR 为

其中:n 为图像真实存在的语义类别的个数;ri为第i 个语义类中实例的区域建议集合;gi为第i个语义类别的真实边界框。 为了减少后续低照度边缘搜索的计算量, 需要去除冗余的区域建议;同时,为提高边缘搜索的效率,将属于同一实例的区域建议进行融合,以保证被搜索的区域包含分割实例的完整轮廓信息。 所提出的融合算法的概念图如图3 所示。

图3 融合算法概念图Fig.3 Conceptual diagram of fusion algorithm

区域建议融合层的算法流程如下:

输入:区域建议集合R 以及融合后区域集合F

其中

fi为ri中置信度最高的建议区域,其位为

1) 初始化

2) 以原特征图右下角角点为原点, 水平向右方向为x 轴,垂直向上方向为y 轴,将区域建议的坐标rik初始化为

其中:(x1,y1),(x2,y2)分别对应区域建议的左上角和右下角;

3) 对第i 类语义区域建议中剩余的区域建议ti进行遍历,其中

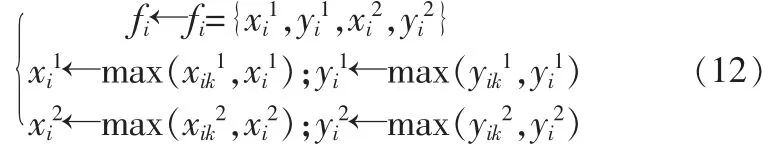

比较tik与fi,并对fi更新,更新原则如下

4) 重复第二步,直到遍历完所有语义类;

5) 开始下一个语义兴趣域的融合,令

6) 重复2)到5),直到i=n;

输出:融合后兴趣域F。

通过以上过程,能够将存在重叠区域的区域建议融合成数量与图像中语义类别数量相同的兴趣区域。

2.3 低照度边缘搜索及局部增强

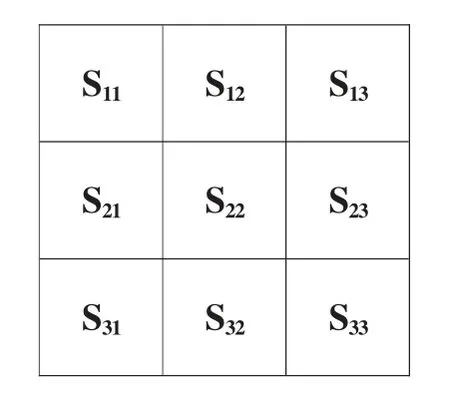

融合形成的兴趣域中可能存在低照度边缘,这些边缘会影响分割效果,因此需要对兴趣域进行低照度边缘搜索及特征增强。图像的边缘信息可以体现在特征图中梯度值的变化上, 因此,这里用一个3×3 窗口对融合后的兴趣域进行滑动搜索,搜索步长设为2,滑动搜索窗口S 如图4。

分别从-45°,0°,45°,90°四个方向对兴趣域F 对应的特征图I 进行滑动梯度检测, 并对检测到的低照边缘特征进行局部增强,该过程的具体算法流程如下:

图4 滑动搜索窗口Fig.4 Sliding search window

输入:融合后兴趣域F 映射的特征图区域为

其中:m,k 分别对应特征区域Ii中特征点的横、纵坐标;

1) 初始化

2) 滑动窗口遍历第i 个特征区域Ii中的特征点,即

3) 计算特征点pmk邻域的四个方向梯度

其中:δ 是设定的低照度边缘梯度边缘的最大值,超过δ 则视为非低照度边缘;s-⊥/2,s0,s⊥/2,s⊥分别表示S22领域(如图5 所示)中的-45°,0°,45°,90°四个方向上的梯度值;

4) 将搜索到的低照度区域进行增强

其中ξ 用来记录该区域的四个方向上梯度变化最大的梯度值,即边缘信息最明显的特征差;

5) 对最大梯度变化方向的正交方向做强差变换,并将搜索框对应的中心值做等值处理,例如,当ξ =s-⊥/2时,该区域的梯度特征被变化为

6) 更新到下一个特征区域的遍历,令

7) 重复2)到5),直到i=n;

输出:边缘增强后的特征图I。

通过上述流程后,卷积特征图的局部边缘特征将被增强,同时,特征图中边缘噪声能够被很好的抑制。

3 实验及分析

该部分首先介绍了用于实验的数据集、 实验设备和设备配置以及用于评价的语义分割模型性能的指标。 然后,展示了EESN 模型在两个典型语义分割数据集(Pascal VOC12 和Cityscapes)上的分割实验结果。最后,将所提出的EESN 同其他语义分割方法在以上几个数据集的基础上进行了性能对比实验,并给出实验数据。

3.1 数据集及硬件配置

Pascal VOC12 数据集包含了20 个室内和室外目标类别以及一个背景类别。 实验中采用了该数据集中的10 582 幅图像进行训练,1 449 幅图像进行验证,1 456 幅图像进行测试。

Cityscapes 数据集是一个通过车载摄像机采集到的大型城市街道场景数据集。 它包含5 000 张经过精细注释的图片。 实验中使用该数据集中19 种目标类别和一个背景类别的2 975 张图像用于训练,500 张图像用于验证,1 525 张图像用于测试。

实验在配有16 GB 内存、Intel i5-7600 处理器和两张GT1080Ti GPU 显卡的图形工作站上进行。工作站同时安装了CUDA 9.0 和CuDNN 7.0。

3.2 评价指标

为了充分分析EESN 模型的分割性能,除平均交并比(mIoU,mean intersection over union)之外,还引入了标记精度(TA,tagging accuracy)、定位精度(LA,locating accuracy)和边界精度(BA,boundary accuray)三个指标对EESN 的分割结果进行评价, 其中:TA 用于评价预测的像素级标签与场景真实值标签之间的差异,能够反映模型对包含多种语义类别图像的分类准确性;LA 定义为目标的预测边界框与真实边界框之间的IoU, 用于估计模型对图像中目标定位的精度;BA 表示正确定位目标的预测语义边界与实际语义边界的差值,它用于反映网络的语义分割精度。

3.3 实验结果

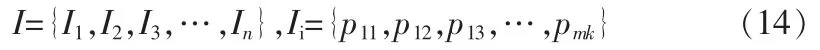

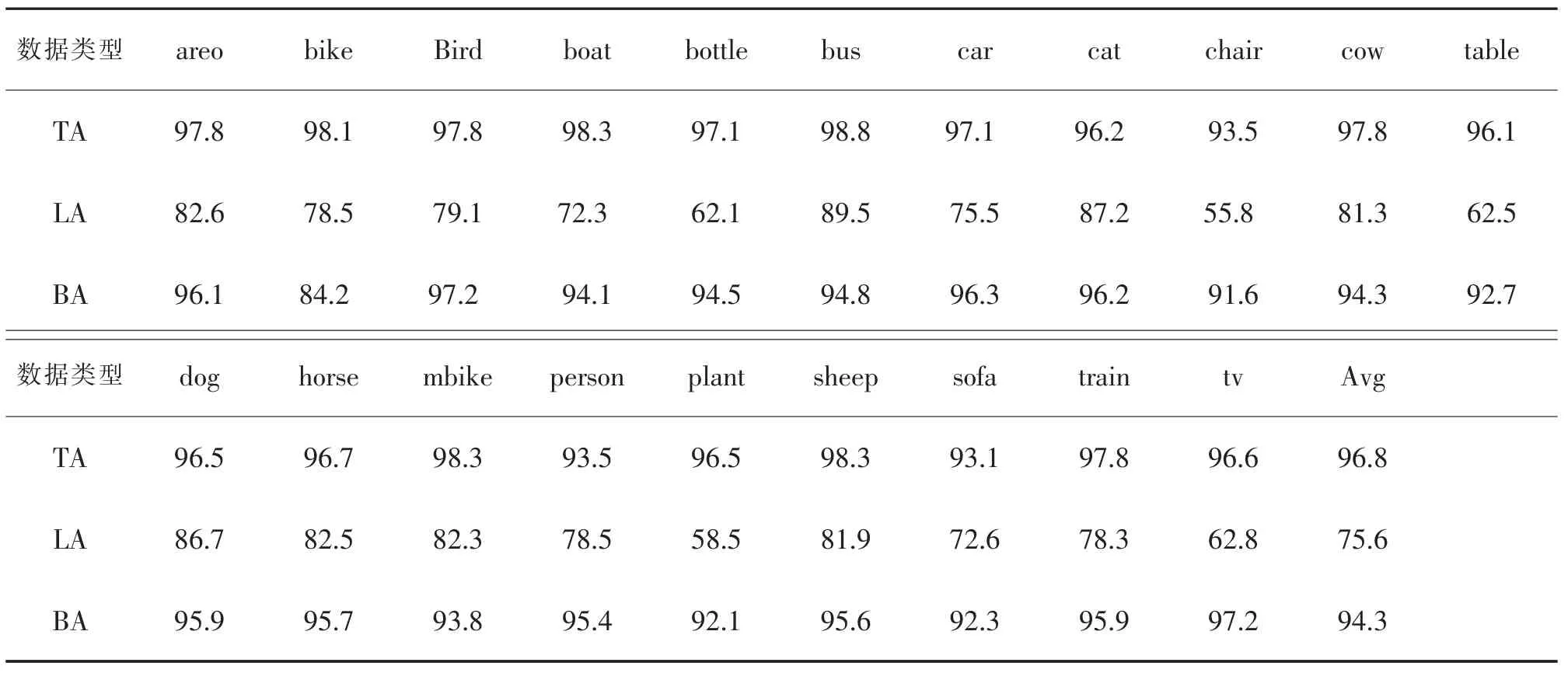

用COCO 2014 对EESN 进行预训练, 并选取Pascal VOC12 中的20 个类图像对EESN 进行训练和测试,预训练和训练的迭代次数分别为150k 和30k,mini-batch 的大小设置为10,学习率设置为0.01。 表1为EESN 对Pascal VOC12 中20 类目标的分割结果的TA,LA 和BA 指标。

表1 EESN 模型在Pascal VOC12 数据集上的分割评价Tab.1 Evaluation of segmentation results of EESN on VOC12 dataset

表1 中,EESN 模型对Pascal VOC12 数据集上图像分割结果的TA,LA,BA 3 个评价的平均值分别为96.8%,75.6%和94.3%,该结果表明EESN 模型能够较好地对Pascal VOC12 数据集中的图像进行语义分割,即EESN 模型能够实现图像语义分割。 在此基础上,为证明EESN 模型能够提高语义分割精度,进行了以下实验。

3.3.1 Pascal VOC12 数据集上实验结果

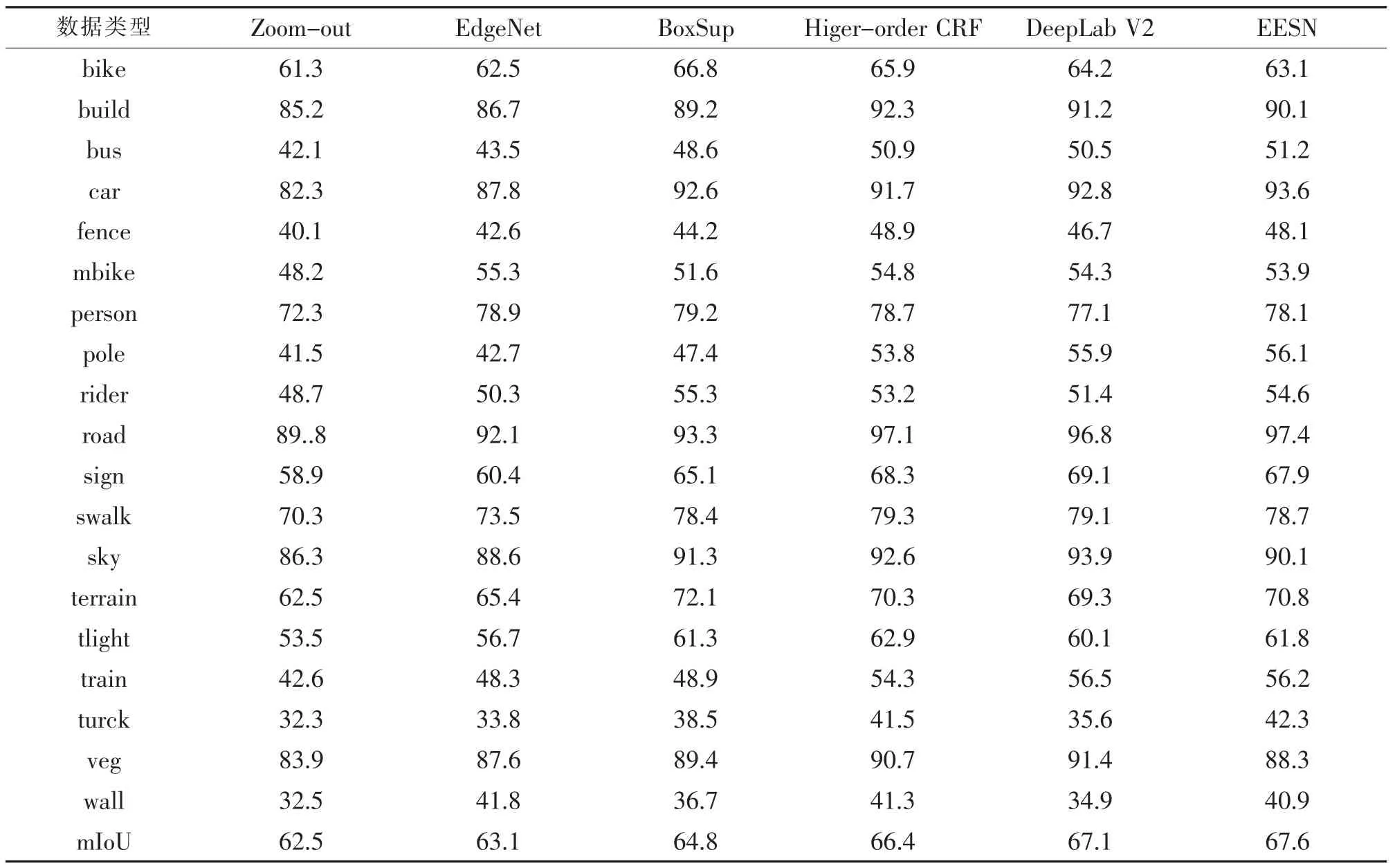

为进一步验证EESN 模型对提高语义分割精度的有效性, 将EESN 模型与其他多种分割模型 (包括Zoom-out[12]、DeepLab V2[5]、EdgeNet[13]、BoxSup[14]和Higher-order CRF[15])的分割性能进行了比较。 不同模型的分割结果的评价结果如表2 所示。

由表2 可知,EESN 模型在Pascal VOC12 测试集上的分割结果的mIoU 为80.5%,高于其他网络。 此外,EESN 对交通场景中目标的语义分割性能良好(如boat,bus,car,mbike,train 等),而这些目标极易受光照不均或光照过低影响,与场景中其他目标混淆。 该实验证明了EESN 模型对低照度图像的语义分割性能良好。

3.3.2 Cityscapes 数据集上实验结果

为避免实验结果的偶然性, 将EESN 模型与上个实验中用到的几种分割模型对Cityscapes 数据集中图像进行了语义分割,并统计出不同模型的分割结果的mIoU 指标,结果如表3 所示。

表3 中,EESN 模型的分割结果的mIoU 达到了67.6%的,高于其他几种模型。 同时也能发现EESN 模型对Cityscapes 数据集中bus,car,road,train 和truck 等目标的分割性能较好, 而这些目标同样具有易受光照影响而与周围目标混淆的特性。

表2 Pascal VOC12 数据集上的分割结果比较Tab.2 Comparison of segmentation results evaluation on Pascal VOC12 dataset

表3 Cityscapes 数据集上分割结果的比较Tab.3 Comparison of segmentation results evaluation on Cityscapes dataset

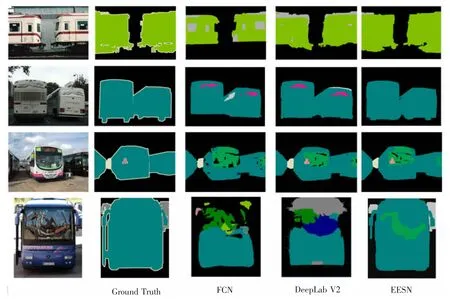

图5 Pascal VOC12 数据集上几种语义分割模型的分割视觉质量图对比Fig.5 Comparison of visual quality maps of several semantic segmentation models on Pascal VOC12 dataset

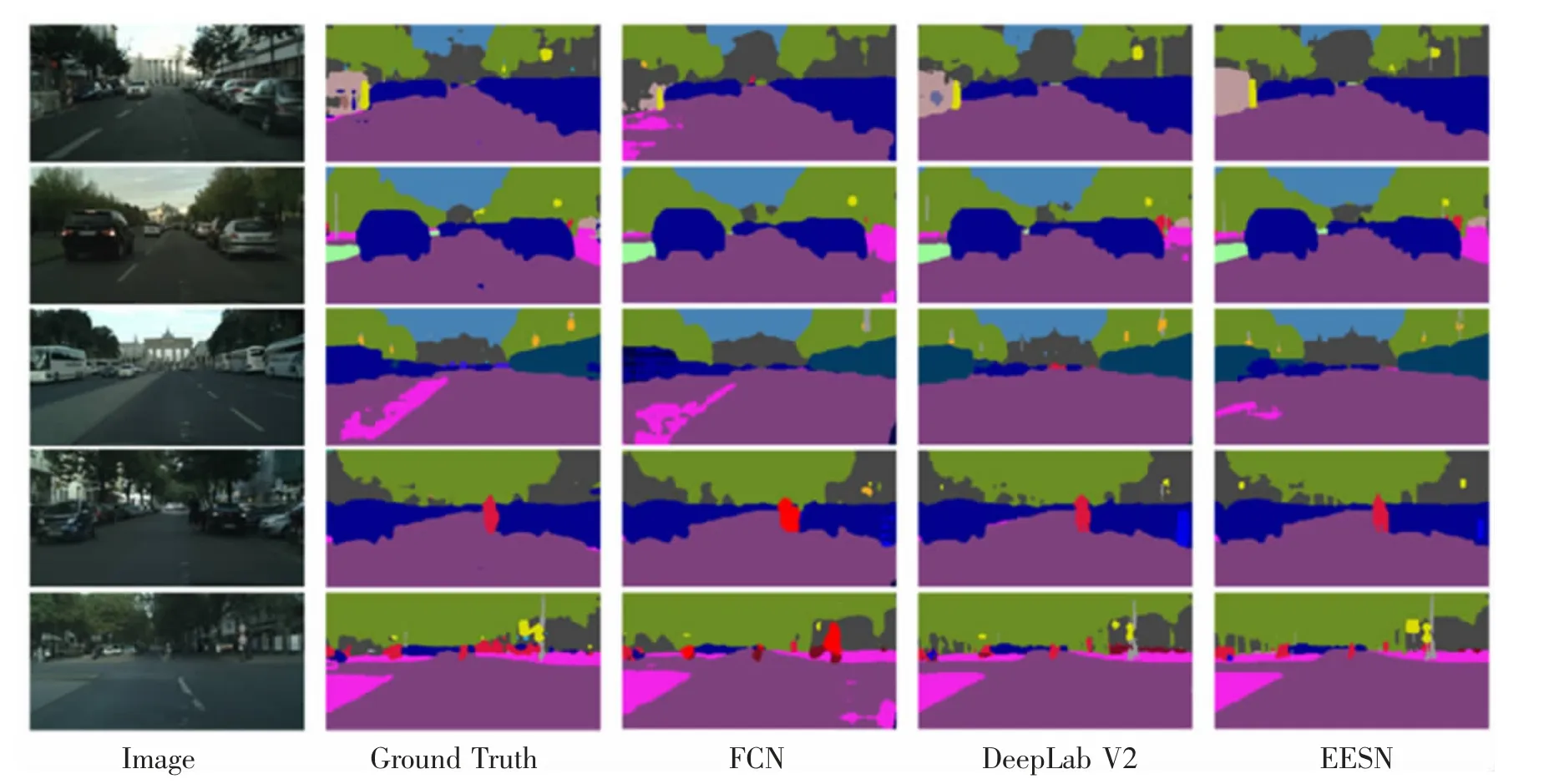

图6 Cityscapes 数据集上几种语义分割模型的分割视觉质量图对比Fig.6 Comparison of visual quality maps of several semantic segmentation models on Cityscapes dataset

最后,为了更直观地观察EESN 的分割性能,图5,图6 分别给出了从Pascal VOC12 数据集和Cityscapes数据集中选取的几幅具有代表性的图像,以及使用FCN、DeepLab V2 和EESN 对这些图像的分割效果图。

从图5 中可以看出,EESN 模型对暗区域中公交车车轮的分割效果优于FCN 模型和DeepLab V2 模型的分割效果(第2 行)。 另外,图5 中第4 行,在大巴挡风玻璃上由于反射率不同导致的复杂阴面的场景下,EESN 模型对大巴的分割结果的完整性仍然得到了保证,并优于另外两个模型。 对于Cityscape 数据集,从图6的整体来看,EESN 模型对近地面暗区于的车轮分割效果明显优于FCN 和DeepLab V2。 另外, 图6 第2 行中,EESN 模型能够很好地分割出处于车辆与树间暗区域中的行人;第3 行中,EESN 模型对站在车辆左暗区域中司机腿部的分割结果也优于其他两个模型。

在本小节中, 首先,EESN 模型在Pascal VOC12 数据集上的分割实验及其结果分析证明了EESN 模型的有效性。 其次,通过对EESN 与几种典型语义分割模型在Pascal VOC12 和Cityscapes 两个数据集上的分割实验结果分析,证明了对含有低照度边缘图像的分割任务而言,EESN 模型比其他几种模型的分割效果更好,并在一定程度上提升了分割精度。 可以推断出,所提出的低照度边缘增强算法是合理、有效的,并且EESN 模型对提高图像分割精度是有效的,特别是对含有低照度边缘的图像。

4 结束语

为了更加准确地描述语义分割任务中目标边缘特征,提高模型对低照度图像的分割精度,本文提出了EESN 模型, 其优点如下: ①EESN 以深度残差网络为主干网, 可以保证模型对图像特征的学习效率;②EESN 利用RPN 生成高质量的区域建议,可加快网络的运算速度;③EESN 采用融合算法对候选区域块进行融合,剔除了重复的候选区域,可提高网络的运算速度和分割的精度;④EESN 采用局部增强算法,有针对性地强化低照度边缘特征,可进一步提高网络对图像特征的描述能力,进而提高网络分割性能。 通过比较EESN 与几种典型语义分割模型在Pascal VOC12 数据集和Cityscapes 数据集的分割, 证明了EESN 能够提升对低照度图像的分割精度。