模拟大脑+万倍加速英特尔神经拟态计算和量子计算技术前瞻

2020-07-04张平

张平

自从集成电路、电脑被发明,信息高速公路大规模建设以来,人们利用各种计算机设备或者移动计算设备大幅度推动了生产力的发展,并构建了现代社会经济文化的方方面面。随后AI计算的出现,让人们对智能和智能化产生了极大的兴趣,尤其是现在大热的深度学习,在产业界兴起了又一波AI计算热潮。在这种情况下,宣称下一代AI的首选、模拟大脑的神经拟态计算是怎样的发展途径呢?是否能解决目前深度学习计算中出现的各种问题?不仅如此,量子计算原理的完善和逐渐走向实用化,在部分运算中,量子计算展现出了比传统计算方法高出数个数量级的计算能力,使得人们可以更精确、更深入地了解这个世界。那么,目前在神经拟态计算和量子计算上,作为全球半导体第一大企业的英特尔有哪些行动,业界又有哪些新的进展呢?

计算机的发明,让人们掌握了可以进行大规模计算的工具。不过,现代计算机受制于架构、能耗、工艺极限等因素,在进行诸如人工智能、极限模拟时,往往会遇到算力不足或者效率低下等问题。为了解决这些重要场合或者特殊应用领域的计算问题,人们设计了针对性的架构或者全新的系统予以应对。目前,在AI计算方面的神经拟态计算和全新的量子计算是最热门的两个领域。

模拟真实的大脑初窥神经拟态计算

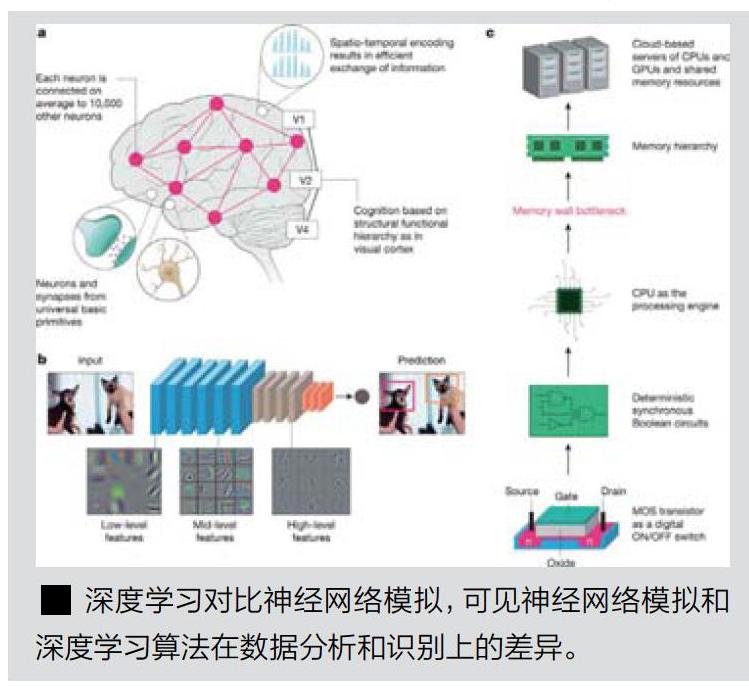

AI计算主要是依靠卷积网络或者其他类型的计算网络进行的深度学习计算。在这种计算中,计算机通过对海量数据的学习和信息提取,最终获得包含目标内容特征的模型,这个模型就可以用于数据推理和判断了。英特尔认为目前流行的以深度学习为代表的AI计算属于第二代AI计算。早期的第一代AI计算则是基于规则,并模拟一些经典逻辑,从而在特定范围或者定义狭窄的问题域内得出合理的结论,典型的例子包括用于提高效率的过程监视。第二代AI计算主要涉及的领域是识别、传感和感知,这也是深度学习网络的特长之处。

神经拟态计算则算作第三代AI计算,可以把人工智能扩展到与人类认知相对应的领域,比如解释和自主适应。这对于克服第二代也就是以深度学习为主的人工智能的“脆弱性“至关重要。所谓“脆弱性“,是指目前深度学习技术在应用中,仅仅能够对那种确定性的观点进行判断,无法产生上下文相关性,也就是并没有真正的思维体系。不仅如此,在数据需求量上,现有的第二代以深度学习为主的AI计算所需要的数据量堪称巨大,比如典型的动物识别、照片分类等应用动辄需要几干乃至几万次学习,耗费大量的时间和电能,这在生物大脑上是不可能出现并和自然状态完全相悖的。此外深度学习操作的稳定性差、抗干扰能力差、容错性低、编程过程麻烦等,都是不够智能化的表现。

因此,下一代人工智能必须能够克服这一点能够处理全新的情景和对其特征进行抽象,向普通人类活动级别的自动化靠近。现在,要实现第三代AI计算,业内重点关注的领域集中在神经拟态计算上。

模拟大脑运作神经拟态计算简介

神经拟态计算并不是一个新的概念。在20世纪80年代后期,工程和技术人员已经开始考虑使用超大规模集成电路来模拟大脑运作的方式。但是,要想模拟大脑运作的方式,就必须先了解大脑是如何运作的,尤其是如何产生意识等艰深的问题。因此,神经拟态计算也是一个复杂的、跨越多个学科的领域,其内容覆盖了生物学、物理学、数学、计算机科学、电子工程学等,整体实现难度颇高。

根据现有的资料,神经元是人类神经系统的基本结构和功能单元之一。人脑中大约有860亿个神经元,每个神经元的结构又可分为神经元细胞体和神经元突触两个部分,神经元突触可以分为树突和轴突。树突用于承受刺激并发出信息传递给细胞体,轴突用于将刺激信息(又称为冲动)传输给终末端。目前,人类对单个神经元的工作方式和刺激形成等已经有了初步的了解,但是如此巨量的神经元如何协同工作,意识又是如何在巨量协同中产生,依旧是谜题。

鉴于此,科研人员提出了一个思路,那就是利用现代计算机技术尤其是集成电路技术来模拟神经元集群的工作,从而获得有关AI和意識方面的内容。2006年,佐治亚理工学院就发布了一种可编程神经元阵列,允许MOSFET栅极上的电荷通过可编程来模拟神经元通道的离子特性,这是最早出现的模拟神经元集群工作的芯片。随后的2011年,麻省理工学院使用了400个晶体管来模拟2个神经元之间的通讯清况。2012年,有关忆阻器和侧向自选阀可以用于神经元研究的论文被提出,重现神经元工作的基础材料有了进一步的发展。2013年9月,有关尖峰神经网络也就是SSN的相关技术被提出,这是神经拟态技术发展的重要节点之一。在这之后,相关SNN芯片也层出不穷,包括斯坦福大学拥有65536个神经元的Neurogrid,曼彻斯特大学的SpiNNaker,欧洲委员会投资13亿美元的人脑项目BrainScaleS、IBM推出的拥有一百万个神经元,运行SNN模拟的TrueNorth芯片、英特尔Loihi等神经拟态芯片都陆续登场,SNN神经拟态计算研究进入了高峰期。

所谓SSN(Spiking Neural Network)是指一种更紧密的模仿自然神经网络的人工神经网络算法。相比传统的ANN也就是人工神经网络,SNN可以更有效地对有机体生物的中枢神经系统进行模拟,比如不了解周围环境下寻找食物的昆虫行为。由于其相对拟真,因此可以用于研究生物神经回路,并月从生物神经回路的功能和假设开始,就可以将SNN的计算模拟结果和真实的结果进行比对,从而评估相关模型的合理性。此外SSN输出的结果以概率为主,而不是一个确定值,这更接近于生物尤其是人体运动和意图预测所呈现的结果。

海底的火山Loihi芯片介绍

在各家的神经拟态芯片研究上,英特尔的产品颇受市场关注。其主要原因不外乎英特尔本身就是芯片市场的“头号玩家“,和客户端距离很近。2017年10月,英特尔发布了全新的神经拟态芯片,被称为Loihi,发音为“low-ee-hee”,这个单词本来属于夏威夷大岛南部海岸的海平面以下的一座火山,英特尔用这个名称命名这款神经拟态芯片,可能是希望其终有一天能够爆发出海平面,寓意相当不错。

根据英特尔的描述,Loihi已经是英特尔实验室设计的第五代自学习神经形态研究测试芯片。前三款芯片是早期的内部测试芯片,第四款是10nm晶圆级研究的产品,第五款才是Loihi。Loihi采用的是异步尖峰神经网络也就是SNN模型构建,芯片本身不发送信号,而是根据激活的突触发送尖峰信息,其基本工作模式和之前介绍的SNN一样,并且整个Loihi芯片都采用了异步、定时的模式进行信息处理。

宏观来看,Loihi采用14nm工艺打造,单颗芯片内大约包含了13万个神经元和1.3亿个突触,包括128个神经拟态核心和3个用于芯片管理控制的Lakemont核心,以及片外通信接口。片外通信接口可以让Loihi芯片在四个平面方向上扩展连接许多其他芯片,根据英特尔的数据,Loihi最多可以扩展至4096颗片上核心和16384个芯片。目前的Loihi单芯片仅有128颗片上神经拟态核心,未来可能还会随着工艺变化和市场需求而进一步扩展。

进一步深月亥心的话,每颗Loihi的神经拟态核心包含了1024个原始的尖峰神经单元,这些神经单元被分组并组合为树状结构,以简化实现过程。Loihi实现了一种基于电流的突触(CUBA)泄露积分一激发神经元模型的变体,且包含了2个内部状态变量,包括突触响应电流一输入尖峰、恒定偏置的加权和Ui,以及膜电势泄漏(即随时间减弱)电势电位函数,后者允许电势超过阈值时发出电击Vt。整个系统的运行也比较简单,也就是一旦累积了足够的尖峰并超过预定义的阈值,那么芯片内就会创建尖峰并将其发送至各个目标核心中的其他组。Loihi支持神经拟态计算中几乎所有特性,包括单播、多播、广播、稀疏网络、可变突触格式和基于种群的层次连接等。在学习能力方面,每个内核都包含有一个所谓的“学习引擎”,可以对其进行编程以适应不同的网络参数,例如尖峰的时间、影响值等。

在软件方面,英特尔开发了和Loihi一起使用的完整工具链,包括Loihi Python API、编译器以及一组用于在Loihi上构建和执行SNN的运行库等。在大多数情况下,Loihi的相关API和现有框架比如PyNN相似,但是考虑到SNN的特殊性,Loihi API也提供了一种使用自定义配置比如衰减时间、突触权重、峰值阈值创建神经元和突触的方法。

4种产品形态

从小到大,适应不同的场合

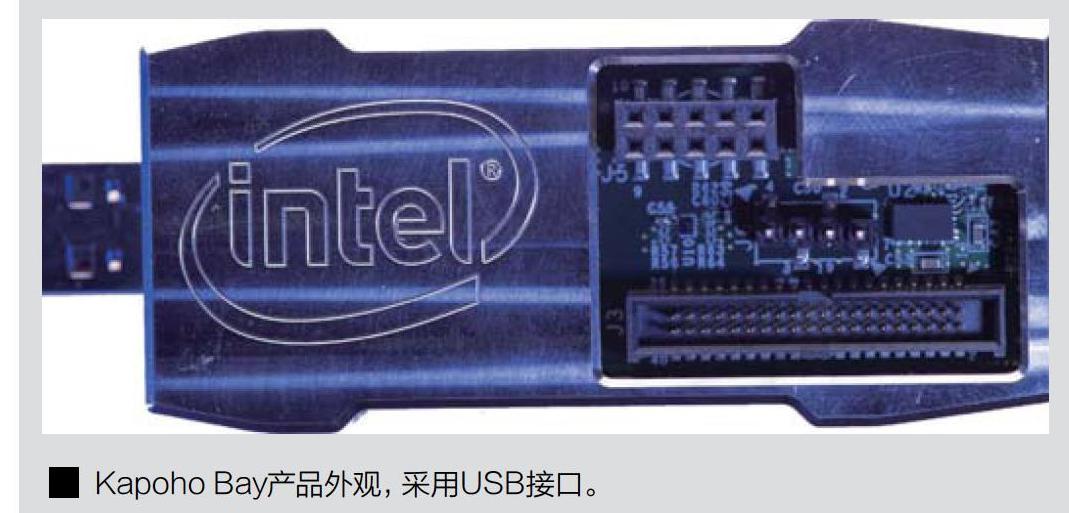

目前英特尔为Loihi推出74种相关产品,涵盖了从USB供电的便携版本到大型设备所使用的扩展版本。最迷你的版本被称作Kapoho Bay,它的外形和一个闪存盘基本相同,接口采用了USB和DVS,可以在电脑上实现自由插拔使用。Kapoho Bay包含2颗Loihi芯片,具X256个神经拟态核心、262144个神经元或者2.6亿个突触。这个产品的应用场合主要是照相机、移动计算等设备的神经拟态计算开发和验证。

较大一些的版本Wolf Mountain整合了4颗Loihi芯片,所有数据相比Kapoho Bay都翻倍了,包括512个神经擬态核心、524288个神经元和5.2亿个突触。Wolf Mountain目前以开发板的形态呈现,主要提供给专业用户使用。

更大一些的版本也就是英特尔在近期发布会上展示的产品被称为Nahuku,这个较大尺寸的开发板上最多可以集成32颗Loihi芯片,英特尔可以根据需要配置8~32颗不同芯片的版本。32颗芯片的版本共有4096个神经拟态核心,其中包含4194304个神经元和41.6亿个突触。另外,英特尔还推出了一个名为Pohoiki Beach的版本,使用2个Nahuku连接在一起,继续提供翻倍的性能。

最后则是最大规模的PohoikiSprings,由24块Nahuku连接在一起组成,总共有768颗Loihi芯片,共98304个神经拟态核心,合并了1.00663296亿个神经元和998.4亿个突触。该系统包含8行,每行3个插槽可以安装3块Nahuku,8行总共24块板。即便使用如此多的芯片,其运行功耗也低于500W,其神经元容量大概类似于一个小型哺乳动物比如仓鼠等。

由于有了成熟的产品和可扩展的方案,英特尔在神经拟态研究上也做出了不少成果。比如英特尔宣布,Loihi芯片和相关方案,联合72个化学传感器,完成了10种不同气味的学习和分辨,对单一样本的识别率高达92%。与此相对应的是如果采用传统的深度学习方法来完成的话,每一类气味至少需要现有方案3000倍以上的训练样本。神经拟态芯片强大的威力初露端倪。此外,英特尔还宣称,在稀疏编码、图式搜索、路径规划、SLAM、约束满足问题等特定应用中,Loihi要比传统CPU速度快最多1000倍,能效高最多10000倍。

总的来看,作为一个才刚刚兴起的全新一代AI产业分支,英特尔又迈出了坚实的一步。新的Loihi芯片和其代表的技术架构,已经向人们展示了神经拟态计算在AI方面的巨大潜力。接下来英特尔需要做的,应该就是不断强化芯片、提高性能,最终实现模拟大脑的目标吧。

万倍加速量子计算发展浅析

作为现代物理学的支柱之一,量子物理和相关的技术往往给产厂种高高在上的神秘感。量子计算这个顶着“量子”大帽子,又携带着量子霸权”光环的技术,究竟代表了怎样的力量呢?

量子计算

并不神秘的计算模式

所谓量子计算,是指使用量子逻辑进行计算。由于采用了量子逻辑,因此量子计算设备被称为量子计算机,其用于存储数据的对象是量子比特,使用量子算法进行操作。在一些文章中,量子计算或者量子计算机被渲染成比传统计算设备快万亿倍甚至无所不能,这显然是不正确的。

从发展历史来看,量子计算和量子计算机在1969年就已经有科学家提出了相关的思想,但是量子计算理论开始丰富和突破则是在20世纪80年代。1982年,理查德费曼提出了利用量子体系实现通用计算的方法,1985年大卫杜斯则给出了量子计算机的图灵机模型。1994年,彼得秀尔完成了量子计算机最重要的量子质因数分解算法,证明了量子计算机能够进行离散对数运算,并且在部分场景下,速度比传统计算机要快得多得多。那么,量子计算机的强势之处在哪里呢?

除了量子计算芯片外,英特尔还在量子计算的控制芯片上展示出了强大的实力。2019年2月份,英特尔推出了全新的、代号为“Horse Ridge”的互联控制设备,采用了同时适用于量子位和控制电子设备的可扩展架构,通过组件月上系统(SoC),实现了对多个量子位高保真度的控制。

Horse Ridge的硅片尺寸为4毫米长、4毫米宽,采用英特尔22nm FFL工艺制造。Horse Ridge将SRAM、数字核心、模拟和射频电路都集中到了单个封装中,这样可以使用微波脉冲操纵量子系统中的量子位状态。HorseRidge集成了頻率在2~20KGHz的高速数模转换器和宽带变频器,此外还支持最高41us的包络,后者可以由查找表提供信息,并为每个量子位定义8条指令。Horse Ridge在一个设备中共有4个射频频道,利用频率复用可以控制多达128个量子位,能够通过32个数控振荡器以200Hz的高精度产生32个复用量子位频率。

Horse Ridge的关键性优势在于缩小了运行量子系统所需要的PCB、芯片的尺寸,并减少了所需要的功率,提尹了能耗比。另外它还能够扩展和控制更多的量子位,提高整体量子门的保真度,并且能够自动校正相位移动,在每次控制后更新数字代码等。

英特尔量子硬件总监Jim Clarke表示,业内很多厂商在量子比特位的提高上拥有充足的经验,但是很少有人去关注量子计算系统所需要的控制和互联系统。Horse Ridge的推出,改变了目前很多厂商采用单独控制每个量子位的方法,转而同时控制多个量子位,这有助于人们从量子理论研究过渡至量子实用性研究。

英特尔在量子计算上的投入和产出的成果是卓有成效的,无论是49量子比特位的量子计算芯片,还是Horse Ridge控制芯片,都展示了英特尔在量子产品长远而全面的考虑。目前来看,在业内厂商中,英特尔和谷歌、IBM等厂商在量子计算上走在前列,量子计算芯片和控制芯片的推出,更加强了这种产业优势。未来英特尔还可能进一步推出更多量子比特位、控制能力更出色的产品,在量子计算从实验室走向商业空间的漫漫长路中,印下自己坚实的印记。

后记:面向未来的计算

总的来说,无论是神经拟态计算还是量子计算,都是人类下一代计算设备发展路径上无数备选产品中的优选代表。前者模拟的是人脑,后者带来了特定计算的万亿倍加速,其目的和最终结果都将远远抛离硅芯片和现有计算架构所能达到的上限,从而开拓出一个全新的计算天地。反观现有硅芯片和冯诺伊曼结构计算机,似乎已经成为一个快被榨干了的柠檬,努力施加压力,还可能榨出最后几滴汁水,但要继续进步的话,就不得不抛弃这个即将干涸的外壳,走向一片新的森林了。这也是所有计算机学科、交叉学科研究人员,以及英特尔、谷歌、IBM等主要芯片厂商努力的方向,可以预见他们持续不断的科技创新成果将成为改变未来世界的关键。