基于得分规整的说话人确认

2020-03-18梁春燕

曹 伟, 梁春燕

(山东理工大学 计算机科学与技术学院, 山东 淄博 255049)

0 引 言

说话人识别,也称为声纹识别,是指利用语音波纹中所包含的信息自动识别说话人身份的技术[1]。由于语音获取方便,采集设备简单,并能通过网络远程识别,说话人识别正成为一种主要的生物特征识别手段[2]。

根据识别的目的不同,说话人识别可以分为说话人辨认(Speaker Identification)和说话人确认(Speaker Verification)两种方式[3]。说话人辨认是从给定说话人集合中找到与测试语音匹配的说话人;说话人确认是判断测试语音是否属于某个预先声明的说话人,即需要将测试识别对(由测试语音和其声明的说话人身份构成)作出“True”或“False”的二类判决。根据是否依赖于语音的内容,说话人识别可以分为与文本有关和与文本无关两种类型[4]。本文主要基于文本无关的说话人确认展开研究。

在说话人确认的测试阶段,不同识别对的得分分布存在着很大的差异性[5],差异性主要来自以下方面:

(1)相同说话人的不一致性。由于受时间、健康状况、心理状态、录音条件等因素的影响,同一说话人的不同测试语音在目标说话人模型上的得分并不是一个恒定值,而是呈现某种概率分布。

(2)不同说话人之间的不一致性。由于受说话习惯、嗓音、语言等因素的影响,不同说话人模型对应的识别对得分表现出不一致性。有的说话人模型对应的识别对得分普遍偏高,有的说话人模型对应的识别对得分则相对偏低。

(3)不同测试语音间的不一致性。在时长、环境噪声、信道情况等影响下,不同测试语音对应的识别对得分也会表现出不一致性,比如有的测试语音对应的识别对得分普遍偏高,有的测试语音对应的识别对得分则偏低,而有的测试语音在目标说话人模型和非目标说话人模型上的得分比较接近,不容易区分。

综合以上方面的原因,如果将所有识别对的得分汇集在一起,“True”和“False”两类识别对的得分会出现严重的交叉和混叠;在这种情况下使用统一的门限对每一个识别对作“True”或“False”的判决,会严重影响说话人确认系统的性能[6]。因此,需要在识别对原始得分的基础上进行得分规整[7]。

目前最常用也是最典型的得分规整方法有零规整(Zero normalization,Znorm)、测试规整(Test normalization,Tnorm)以及二者的结合算法ZTnorm等,通过估计“False”识别对的得分分布,对测试识别对的得分进行规整,将“False”识别对的得分规整为均值为0、方差为1的分布,从而消除不同说话人模型间的差异或不同测试语音之间的差异,有效减小两类识别对得分汇集后的混叠部分,从而提高说话人确认的系统性能。一般来说,得分规整不受限于系统所使用的说话人模型建立方法,无论是简单基础的高斯混合模型-通用背景模型(Gaussian Mixture Model-Universal Background Model,GMM-UBM),还是目前比较主流的联合因子分析(Joint Factor Analysis,JFA)、总变化因子分析(Total Variability Factor Analysis)技术等,原始测试得分均需要进行得分规整,而现有的得分规整方法也都适用于基于以上不同说话人模型的确认系统。

现有的得分规整方法中,大多数都是通过规整“False”识别对得分分布的方式,以减小两类识别对得分汇集后的重叠部分,却没有有效扩大同一说话人模型或同一测试语音对应的两类识别对得分之间的差距;在这些得分规整方法中,都需要预先收集和选取大量的非目标说话人语音数据来估计“False”识别对得分的均值和方差,而非目标说话人语音数据选取的好坏会影响最终得分规整的效果。

针对现有得分规整方法的不足,本文提出一种对数似然值归一化得分规整算法(Log-likelihood Normalization,LLN),通过扩大同一测试语音在目标说话人模型与非目标说话人模型上的得分差距,使同一测试语音对应的两类识别对得分混叠现象得到有效改善;与Znorm、Tnorm和ZTnorm等方法相结合,可同时从不同角度解决两类识别对得分汇集后的混叠问题,从而进一步提高系统识别性能。

1 说话人确认系统

1.1 说话人确认系统的基本框架

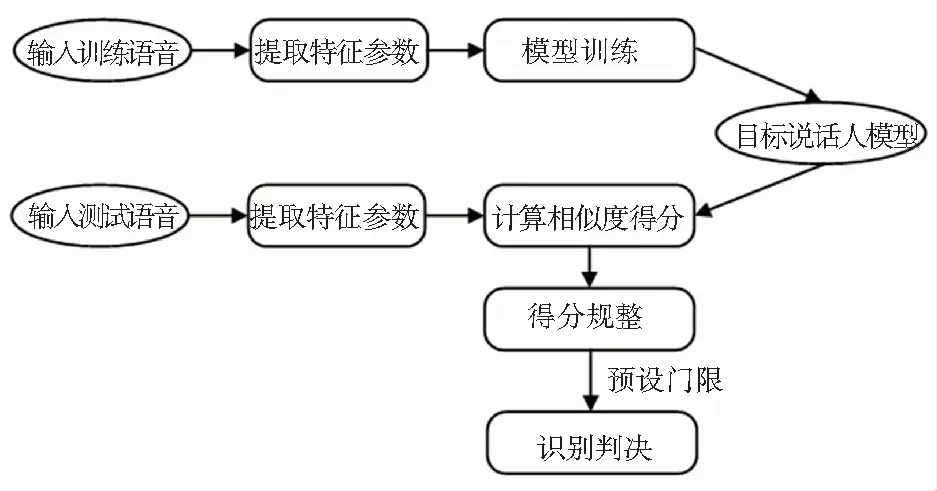

说话人确认系统如图1所示,主要分为三部分:提取特征、建立模型和打分判决[8]。

图1 说话人确认系统

1.2 说话人确认系统的评价指标

在说话人确认系统中,每一次测试,就是将一组识别对进行“True”和“False”判决的过程。当本是“False”的识别对判决为“True”(非目标说话人被接受)时,称之为“虚警”(False Alarm);当本是“True”的识别对判决为“False”(目标说话人被拒绝)时,称之为“漏检”(Miss),这两种错判出现的概率分别称为虚警率和漏检率。

(1)等错率(Equal Error Rate,EER)。实际应用中,应同时降低虚警率和漏检率,然而这二种错误概率相互约束,随着判决门限设定的不同,二者呈相反趋势变化,只有当虚警率和漏检率大致相等的时候,系统的性能被认为达到了最大发挥,此时的错误率称为等错率(EER)。

(2)最小检测代价(Minimum Value of Detection Cost Function,minDCF)。不同的应用场景对虚警率和漏检率要求不同,系统门限的设定会按需调整,为了对不同情况下系统性能进行更加贴切地描述,引入了检测代价函数(Detection Cost Function,DCF)的概念,其数学表达式(1)为:

(1)

其中,CM和CFA分别是漏检率PM|T和虚警率PFA|NT对应的代价,PT是测试中应该判决为“True”的识别对出现的概率,(1-PT)是应该判决为“False”的识别对出现的概率。检测代价函数是描述识别错误发生后损失大小的一个函数,可以很好地表示系统的性能。设定门限可以得到该门限对应的DCF值,遍历判决门限,获得最小检测代价(minDCF),这是目前美国国家标准技术研究院说话人识别评测(NIST SRE)中最重要的指标。

1.3 零规整(Znorm)和测试规整(Tnorm)

Znorm方法是用大量非目标说话人语音对目标说话人模型打分,计算出对应于目标说话人模型λ的辅助参数均值μλ和方差σλ,用来规整得分分布的差异,其得分规整公式(2)如下:

(2)

Tnorm是用测试语音对大量非目标说话人模型计算得分,得到对应于测试语音的辅助参数,同样是均值和方差,用来减少测试语音环境不同对得分分布的影响,最终得分公式同(2)。

对于说话人确认系统,Znorm参数计算在模型训练阶段完成,Tnorm参数计算在测试阶段完成。ZTnorm是在得分域将训练模型和测试语音的信息结合起来,即将Znorm和Tnorm相结合的得分规整方法。上述3种得分规整方法的不足之处是没有有效扩大同一说话人模型或同一测试语音对应两类识别对得分之间的差距;并且必须引入先验知识,需要将训练数据中的一小部分预留出来作为开发集,用来估计得分规整时需要的参数,而开发集选取的好坏会影响最终得分规整的效果。

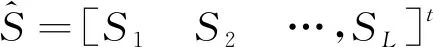

2 对数似然值归一化(Log-likelihood Normalization,LLN)

本文提出一种基于LLN的得分规整方法,该方法相对于Znorm、Tnorm和ZTnorm的优势在于扩大了同一测试语音在目标说话人模型与非目标说话人模型上的得分差距,使同一测试语音对应的两类识别对得分混叠现象得到有效改善;并且可以直接对测试得分进行规整,不需要引入先验知识,因此不需要预留训练数据。

(3)

(1)如果i=t,则Si较大,规整量Ni因不包含St,故数值较小;

(2)如果i≠t,则Si较小,规整量Ni因包含St,故数值较大。

公式(3)中每个得分Si作为e的指数是考虑目标说话人模型得分的独特性(较大且数目少),充分扩大其得分的影响,求和是利用非目标说话人模型得分的共同特点(较小且数目多),减少单个得分的影响,取对数可避免非目标说话人模型得分的规整量差距过大。经过(3)式规整,测试语音对目标说话人模型和非目标说话人模型得分差距会进一步拉大,即可以使识别对中“True”识别对和“False”识别对的得分具有更好的区分性,从而更容易设定门限区分“True”识别对和“False”识别对,提升了系统确认性能。

3 实 验

3.1 实验配置

本文实验在NIST SRE 2008核心测试集 (short2-short3)的电话训练、电话测试(tel-tel)情况下开展。实验主要针对女声测试集,该测试情况下共23 385个测试对,涉及1 674个测试语音和1 140个目标说话人模型,在LLN得分规整阶段,每个识别对得分都是基于测试语音数据与全部1140个说话人模型的匹配得分经公式(3)得到。

本实验中所使用的特征为36维的梅尔频率倒谱系数(Mel Frequency Cepstral Coefficents,MFCC)特征,其每帧特征由18维的基本倒谱系数及其一次差分(delta)构成。首先用音素解码器来对语音数据进行语音活动性检测(Voice Activity Detection,VAD),以去除数据中的静音部分;然后根据25ms的窗长和10 ms的窗移提取36维的MFCC特征。由于得分规整方法具有普适性,不受限于系统所使用的说话人建模方法,且目前主流的说话人建模技术大多基于GMM-UBM模型,因此本实验的说话人建模方法选用简单基础的GMM-UBM。使用NIST SRE 2004 1side的目标说话人训练数据训练与性别相关的UBM,UBM高斯数为1023[9]。并利用本征信道(Eigenchannel)技术在模型域做了信道补偿,训练Eigenchannel信道空间的数据,选择的是NIST SRE 2004、2005以及2006的电话语音数据,包含755个说话人的数据,共9 855个语音文件。另外,从NIST SRE2006的数据中挑选了340条数据,用于Tnorm得分规整和340条数据用于Znorm得分规整,基本上保证这两个小数据集每个说话人只有一条语音数据。

3.2 实验结果

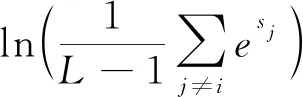

表1比较了Znorm、Tnorm、ZTnorm和LLN不同得分规整方法的实验结果。从表1可以看出,LLN在不需要开发集的条件下,具有良好的规整性能,相比无得分规整的情况,EER相对提升9.7%,minDCF相对提升4.57%,本身的规整性能可以和Znorm、Tnorm相当。

表1 NIST SRE 2008测试集上Znorm、Tnorm和LLN性能比较

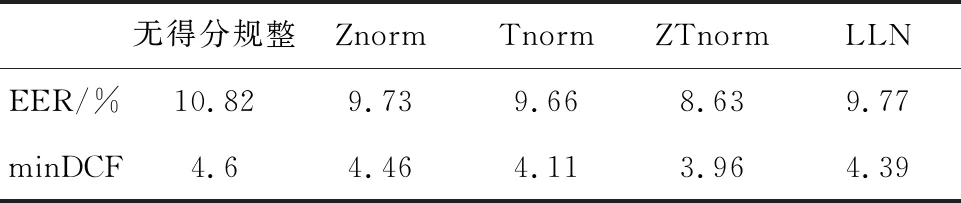

表2是在Znorm、Tnorm和ZTnorm基础上做LLN规整的实验结果。结合表1和表2中的实验结果可以看出,LLN可以大幅度提升原有说话人确认系统的性能。在Znorm基础上做LLN和不做LLN相比,系统的EER和minDCF分别有20.45%和24.44%的性能提升;在Tnorm基础上做LLN和不做LLN相比,系统的EER和minDCF分别有5.59%和9.98%的性能提升;在ZTnorm基础上做LLN和不做LLN相比,系统的EER和minDCF分别有11.7%和18.69%的性能提升。

表2 NIST SRE 2008测试集上做LLN的性能

对比LLN规整前后某测试语音在15个说话人模型上的得分变化,如图2所示。其中,spk13为该测试语音的目标说话人,其余为非目标说话人。从图2可以看出经LLN规整后,测试语音对目标说话人模型和非目标说话人模型得分差距会进一步拉大。如果门限保持不变,相比LLN规整前,系统的虚警率会明显降低。

图2 某测试语音在不同说话人模型上得分

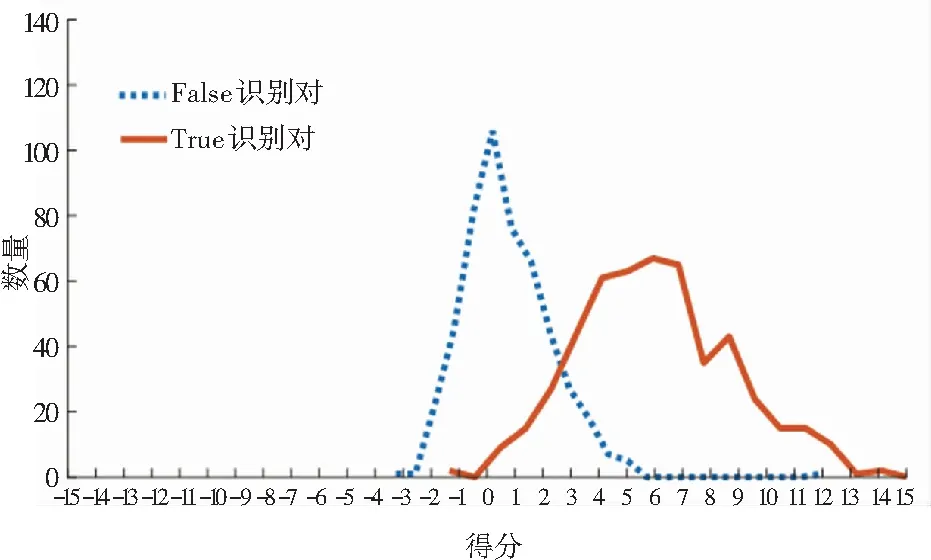

随机选取500个“True”识别对和500个“False”识别对,比较LLN规整前后的得分分布,如图3所示。从图3可以看出经LLN规整后,“False”识别对的得分分布明显向左偏移,而“True”识别对的得分分布变化不明显,“True”识别对和“False”识别对的得分差距拉大,区分性增强,有效降低了虚警率。因此,用统一的门限进行判决时会更有优势。LLN虽然不会改变同一测试语音在每个目标说话人上得分的排序,但可以有效降低EER和minDCF。

(a) LLN规整前识别对得分分布曲线

(b) LLN规整后识别对得分分布曲线

4 结束语

针对说话人确认系统中现有得分规整方法的不足,本文提出基于对数似然值归一化(LLN)的得分规整方法。对每个测试对得分,充分利用其测试语音与集中所有说话人模型的得分做出规整,使同一测试语音对目标说话人模型和非目标说话人模型的得分差距拉大;该方法不需要预留额外开发集来估计规整参数,在后端得分域即可进行,因此也不受限于系统所使用的特征参数和模型;与已有的Znorm、Tnorm和ZTnorm得分规整方法能够很好互补,使不同测试语音或不同说话人模型的得分分布一致的同时,扩大“True”和“False”两类得分距离,在系统的统一门限下,获得更好的确认准确率,使说话人确认系统的性能进一步提高。