基于强化学习协同训练的命名实体识别方法

2020-02-14程钟慧陈珂陈刚徐世泽傅丁莉

程钟慧 陈珂 陈刚 徐世泽 傅丁莉

摘 要:命名实体识别是一项从非结构化大数据集中抽取有意义的实体的技术。命名实体识别技术有着非常广泛的应用,例如从轨道交通列车产生的海量运行控制日志中抽取日期、列车、站台等实体信息进行进阶数据分析。近年来,基于学习的方法成为主流,然而这些算法严重依赖人工标注,训练集较小时会出现过拟合现象,无法达到预期的泛化效果。针对以上问题,本文提出了一种基于强化学习的协同训练框架,在少量标注数据的情况下,无须人工参与,利用大量无标注数据自动提升模型性能。在两种不同领域的语料上进行实验,模型F1值均提升10%,证明了本文方法的有效性和通用性。同时,与传统的协同训练方法进行对比,本文方法F1值高于其他方法5%,实验结果表明本文方法更加智能。

关键词:强化学习;协同训练;命名实体识别

中图分类号:TP391.1 文献标识码:A

Abstract:Named entity recognition(NER)is a technique for extracting meaningful entities from unstructured big datasets.NER has a wide range of applications.An example of NER is advanced data analysis which extracts date,train,platform and other entity information from a large operation logs dataset produced by rail transit trains.In recent years,the reinforcement learning based method has become the mainstream method of solving this task.However,these algorithms rely heavily on manual labeling.The over-fitting problem may occur when the training set is small,and cannot achieve the expected generalization effect.In this paper,we propose a novel method,Reinforced Co-Training.With only small amount of labeled data,the performance of the named entity recognition model can be automatically improved by using a large amount of unlabeled data.We have experimented our framework on corpus in two different fields,the results show that the F1 value of our proposed method is increased by 10%,which proves the effectiveness and generality of the method in this paper.We also compared our method with the traditional co-training methods,the F1 value of our method is 5% higher than other methods,which shows that this method is more intelligent.

Keywords:reinforcement learning;co-training;named entity recognition

1 引言(Introduction)

給定一个非结构化大数据集(如轨道交通列车控制系统产生的车辆运行控制日志),命名实体识别(NER)技术的目的是从该数据集中提取出具有特定意义的实体,如站台名、列车号、控制指令等[1],进而为其他大数据建模任务提供实用信息。研究者们将NER任务归约为序列标注问题[2],基于统计机器学习的方法和深度学习的方法成为主流,例如条件随机场模型[3],基于卷积网络的序列标注模型[4]以及基于双向LSTM网络的模型[5]等。然而,基于学习的方法严重依赖人工标注,训练集较小时会出现过拟合现象,无法达到预期的泛化效果。同时,命名实体具有极强的不确定性,在进行大规模的数据标注时需要消耗大量的人力和时间,其代价是难以接受的。与标注语料不同,无标注语料数量巨大且极易获得,因此如何发挥大量无标注语料的价值,在少量标注数据的情况下改善模型学习性能是命名实体识别进一步研究的重点。

半监督学习[6]方法通常利用大量的无标注数据来辅助少量的有标注数据进行学习,从而提高模型学习性能。协同训练(Co-training)[7]是广泛使用的半监督学习方法之一,它利用两个学习器的“相容互补性”来互相标记样本扩大训练集,从而达到借助无标注数据提升学习性能的目的。协同训练的关键在于挑选高质量的无标注数据添加到训练集中,目前通常使用启发式的样本选择策略。然而,现有的协同训练算法存在一些缺陷。首先,在训练过程中,每次添加两个弱分类器的伪标注数据到训练集中,会造成噪声累积。其次,由于少量标注数据和大量无标注数据在分布上具有一定差异,在训练一段时间后,会导致采样偏差向无标注数据方向偏移,进而导致训练模型性能降低。此外,传统的协同训练方法为了减少噪声的引入,每次添加模型置信度高的预测结果到训练集中,容易造成局部采样限制,会限制模型泛化能力[8]。

因此,一种理想的协同训练算法应该具备两个特性,一是扩充训练集带来的噪声应尽可能小,二是能对数据空间进行充分探索,以获得更好的泛化学习性能。基于以上,本文利用深度Q网络(Deep Q-network)[9]自动学习选择策略替代传统的启发式样本选择策略,进而提高协同训练效果。

本文的主要贡献如下:

(1)提出了一种基于强化学习的协同训练框架,在少量标注数据情况下,无须人工参与,利用大量无标注数据自动提升命名实体识别模型的性能。

(2)提出了一种基于实体级置信度的模型集成方法,减少协同训练过程中噪声的引入,进一步提高添加样本的质量。

(3)在人民日报和金融新闻语料上进行重复实验,证明了本文方法的有效性、通用性和鲁棒性。同时,与传统的协同训练方法进行对比实验,本文方法F1值高于其他方法5%。

2 相关工作(Related work)

针对如何在少量标注数据的情况下,使用半监督学习方法进行命名实体识别任务,已有学者做了相关研究。Liao[10]等人提出了一种基于CRF单一分类器的半监督命名实体识别方法,需要人工分析数据,提取有效规则,难度较大且规则的领域移植性较差。Aryoyudanta[11]等人使用SVM单一分类器,基于上下文和实体两种不同的属性视图构建两个学习器进行协同训练。Xiao[12]等人提出了一种基于CRF和SVM协同训练的中文机构实体识别算法,定义了一种启发式样本选择策略。然而,这些半监督学习方法都是基于人工预先设定的样本选择策略,无法对数据空间进行充分准确的学习。协同训练算法的核心在于样本选择策略,Zhang[13]等人提出了一种性能驱动的样本选择策略,选择有助于提高分类精度的无标注数据进行半监督学习。同时,Chawla[14]等人论证了随机挑选样本的方法会导致训练模型向无标注数据分布方向发生采样偏移。

与上述半监督命名实体识别方法相比,本文使用深度强化学习模型自动学习样本选择策略。深度强化学习(DRL)[15,16]是人工智能领域新的研究热点,它将深度学习(DL)[17]在特征表示方面较强的抽象感知能力和强化学习(RL)[18]的推理决策能力相结合。Lange[19]等人最先将深度学习模型和强化学习方法结合,提出了一种深度自动编码器,但是只适用于状态空间维度较小的问题。Mnih[9]等人结合深度学习中的卷积神经网络和传统强化学习中求解最优动作值函数的Q学习算法,提出了深度Q网络模型(DQN)来近似表示动作值函数。近年来,深度强化学习在自然语言处理领域获得了越来越多的关注,在会话生成、文本摘要等任务中均有应用。但由于语言是离散的,句子空间是无穷的,所以在将NLP任务转化为DRL问题时存在诸多挑战。

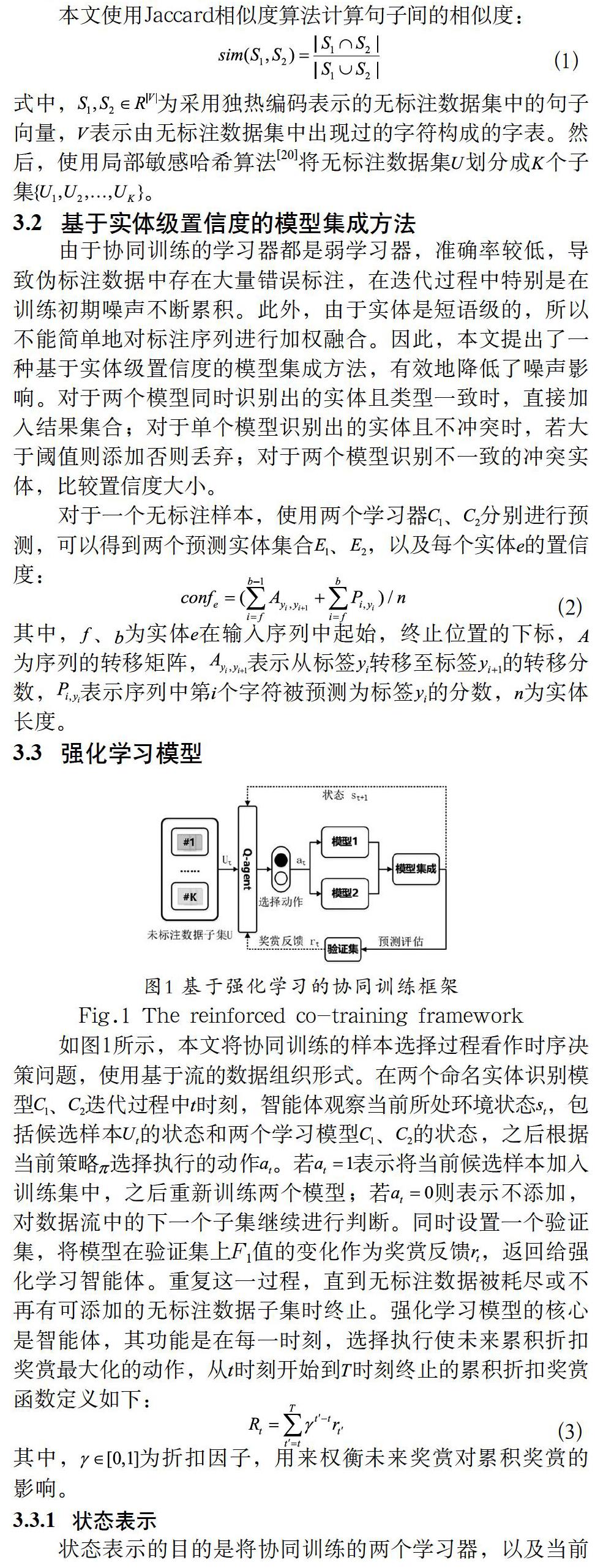

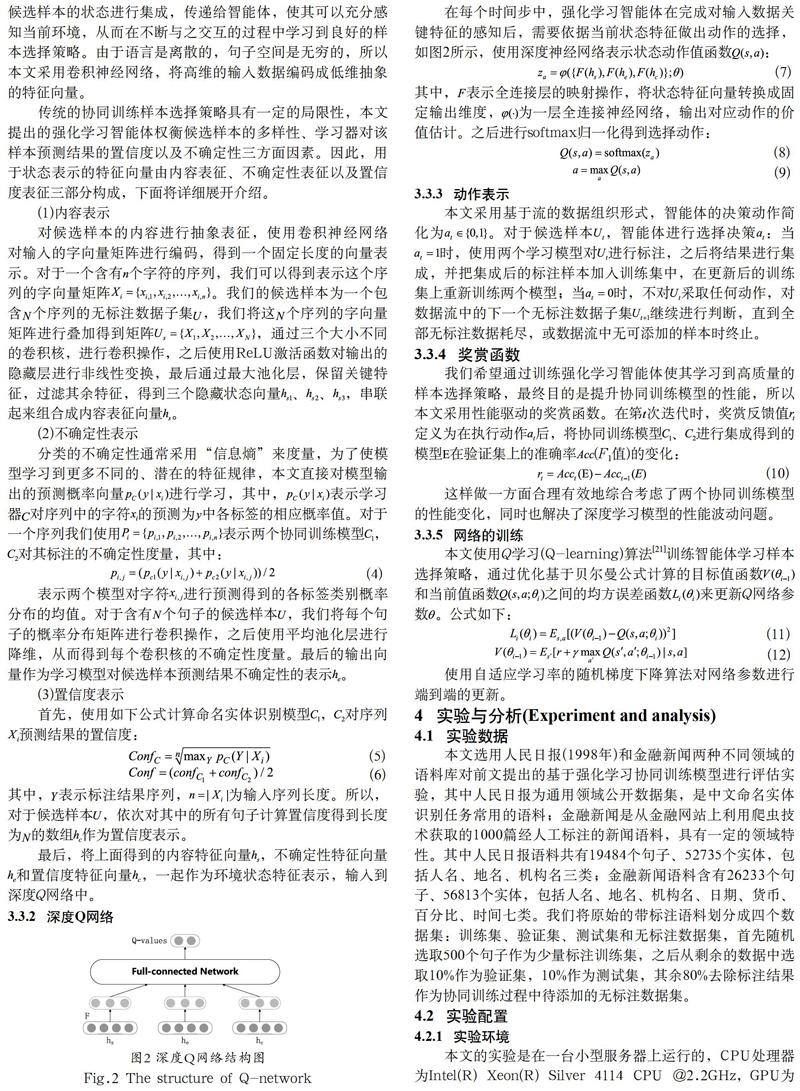

3 基于强化学习的协同训练框架(Reinforced Co-training)

3.1 未标注数据子集的划分

由于无标注数据数量巨大,如果在每次迭代过程中只选择一个样本添加到训练集中,并重新训练两个学习器,那将十分低效。所以,我们首先将大量的无标注数据样本切分成句子,并根据句子间的相似度大小,将其划分成子集。这样每次算法挑选一個无标注数据子集作为候选样本添加到训练集中,更新两个学习器,能极大提高计算效率,节约时间成本。

4 实验与分析(Experiment and analysis)

4.1 实验数据

本文选用人民日报(1998年)和金融新闻两种不同领域的语料库对前文提出的基于强化学习协同训练模型进行评估实验,其中人民日报为通用领域公开数据集,是中文命名实体识别任务常用的语料;金融新闻是从金融网站上利用爬虫技术获取的1000篇经人工标注的新闻语料,具有一定的领域特性。其中人民日报语料共有19484个句子、52735个实体,包括人名、地名、机构名三类;金融新闻语料含有26233个句子、56813个实体,包括人名、地名、机构名、日期、货币、百分比、时间七类。我们将原始的带标注语料划分成四个数据集:训练集、验证集、测试集和无标注数据集,首先随机选取500个句子作为少量标注训练集,之后从剩余的数据中选取10%作为验证集,10%作为测试集,其余80%去除标注结果作为协同训练过程中待添加的无标注数据集。

4.2 实验配置

4.2.1 实验环境

本文的实验是在一台小型服务器上运行的,CPU处理器为Intel(R) Xeon(R) Silver 4114 CPU @2.2GHz,GPU为GeForce GTX 1080Ti,内存为100GB,操作系统为Ubuntu 18.04.1 LTS Server。使用的编程语言为Python,版本为3.6.7,使用深度学习框架TensorFlow 1.12.0。

4.2.2 实验设置

(1)协同训练模型

本文选用了两个主流的命名实体识别模型进行协同训练,其一是CRF序列标注模型[3],另一个则是基于深度学习的BiLSTM-CRF模型[5]。前者属于传统的概率图模型,对条件分布进行建模,后者旨在通过一个深度神经网络直接学习从输入文本到标注序列的映射关系,是一个端到端的过程。两种模型从学习和训练的原理上具有显著的差异性和互补性。

实验使用python-crfsuite库实现CRF模型。为避免分词的影响,采用基于字符特征的CRF模型。特征方面选择大小为2的上下文窗口,考虑前后各两个字符对当前字符的影响,特征包括1-Gram、2-Gram、字符所在词的词性以及在词中的位置特征。BiLSTM模型的batch_size为16,学习率取0.001,采用Adam梯度下降优化算法,为防止过拟合,实验中采用early_stop准则,使用验证集,如果评价指标在验证集上连续三个epoch没有变化,就停止训练。

(2)网络参数设置

在本文的协同训练框架中,我们将无标注数据子集的数量设置为100。在候选无标注样本的内容表示部分,分别通过128个大小为3、4、5的卷积核,步长为1进行卷积,使用ReLU激活函数。在不确定性表示部分,使用20个大小为3的卷积核,步长为1进行卷积。全连接层输出向量维度为256。设置折扣因子为0.99,batch_size为32。回放记忆单元最大容量为1000个转移样本,学习率和行为策略的参数都设置为从开始到1000个转移样本区间内线性递减的形式,即从0.005降到0.00025,从1.0降到0.0001。

(3)对比实验设置

我们将本文提出的基于强化学习的协同训练方法RL Co-Training与两种经典方法对比:

①Standard Co-Training:协同训练的两个模型各自随机选择伪标注样本进行协同训练[7]。

②CoTrade Co-Training:协同训练的两个模型各自挑选置信度高的偽标注样本,添加到对方的训练集中[22]。

4.3 实验结果分析

本文在人民日报和金融新闻两种不同领域的语料上分别进行实验,并与两种经典的协同训练算法Standard Co-Training,CoTrade Co-Training进行对比。实验中,首先使用从语料中随机选择的500个句子作为少量的带有标注的训练数据对两个学习模型进行初始化,得到两个弱学习器,之后分别使用三种不同的协同训练算法,每次根据各自不同的样本选择策略不断添加100句伪标注数据,扩增训练集,迭代训练学习模型,最后利用测试集计算模型对所有实体识别的F1值,具体结果如表1和表2所示。

从中可以看出,(1)本文提出的基于强化学习的协同训练方法RL Co-Training在只有少量标注数据初始化模型的情况下,无须人工参与,通过利用大量无标注语料迭代训练,可以有效提升模型性能,在两种测试语料上模型的F1值均可有效提升10%左右,证明了本文方法的有效性和通用性;(2)本文的RL Co-Training方法表现效果要好于传统的协同训练方法,其F1值高于其他方法5%左右。

为了进一步比较分析三种协同训练算法样本选择策略的性能,图3和图4分别给出了在两种语料上,各方法在验证集上F1值随迭代次数的变化情况。在每种语料上分别展示了在协同训练迭代过程中,两种协同训练模型CRF和BiLSTM,以及对两个模型进行集成后的性能变化,横轴表示迭代过程中添加进训练集中的伪标注数据的句子数量,纵轴表示模型在验证集上的F1值。

从中可以看出:(1)在添加句子数量相同的情况下,本文的RL Co-Training方法获得了最好的效果,模型性能的提升最大,说明本文提出的协同训练算法学习效率最高;(2)Standard Co-training随机选择添加样本的方法造成了模型极强的不稳定性,CoTrade Co-training可以有效提升协同训练效果,但是每次迭代只添加置信度高的样本限制了模型的泛化能力。本文方法与两者相比有显著提升,证明了本文使用强化学习智能体来自动学习一种样本选择策略,替代传统的预先定义的启发式样本选择策略方法的有效性。强化学习智能体可以对样本空间进行充分探索,选取更高质量的无标注数据,不仅可以帮助改善Standard Co-Training算法在随机挑选样本时发生的采样偏移问题,还可以改善CoTrade Co-Training算法由于局部采样造成的对模型泛化能力的限制。

此外,为了验证本文方法的鲁棒性,我们设计了如下实验:首先,使用原始数据划分训练强化学习智能体Q-agent。在测试时,随机生成另外五个训练集,并将剩余数据按原比例划分为测试集和无标注数据集,使用Q-agent已经学到的样本选择策略对两个模型重新进行协同训练,将两个模型集成后在测试集上进行测试,结果如表3所示。结果表明,本文方法对不同的初始化训练集具有鲁棒性,我们模型中的强化学习智能体Q-agent可以学习到一个良好的鲁棒的样本选择策略来选择高质量的无标注子集,以帮助协同训练过程。

5 结论(Conclusion)

本文提出了一种基于强化学习的协同训练框架,在少量标注数据的情况下,无须人工参与,利用大量无标注数据自动提升模型性能。框架中的强化学习智能体可以学习一种良好的样本选择策略,选择高质量的无标注数据进行协同训练。我们在两种不同领域的语料上对模型进行了评估,实验结果表明本文方法性能优于其他的协同训练算法。我们还对强化学习智能体进行了测试,证明了学习到的样本选择策略对不同的初始化训练集和数据划分具有鲁棒性。在未来的研究中,我们计划将本文提出的框架扩展应用到其他不同类型的任务中去。

参考文献(References)

[1] Grishman R,Sundheim B.Message Understanding conference-6:a brief history[C].Proceedings of the 16th International Conference on Computational Linguistics,1996:466-471.

[2] Finkel J R,Grenager T,Manning C.Incorporating non-local information into information extraction systems by Gibbs sampling[C].Proceedings of the 2005,43rd Annual Meeting of the Association for Computational Linguistics,2005:363-370.

[3] Lafferty J,McCallum A,Pereira F.Conditional random fields:probabilistic models for segmenting and labeling sequence data[C].Proceedings of the 18th International Conference on Machine Learning,2001:282-289.

[4] Collobert R,Weston J,Bottou L.Natural language processing(almost) from scratch[J].Journal of Machine Learning Research,2011,12:2493-2537.

[5] Chiu J P C,Nichols E.Named entity recognition with bidirectional LSTM-CNNs[J].Transactions of the Association for Computational Linguistics,2016(4):357-370.

[6] Chapelle O,Scholkopf B,Zien A.Semi-supervised learning (chapelle,o.et al.,eds.;2006)[book reviews][J].IEEE Transactions on Neural Networks,2009,20(3):542-542.

[7] Blum A,Mitchell T.Combining labeled and unlabeled data with co-training[J].Proceedings of the eleventh annual conference on Computational learning theory,1998:92-100.

[8] Zhang R,Rudnicky A I.A new data selection principle for semi-supervised incremental learning[C].IEEE,2006(2):780-783.

[9] Minh V,Kavukcuoglu K,Silver D.Human-level control through deep reinforcement learning[J].Nature,2015,518(7540):529-533.

[10] LIAO W,Veeramachaneni S.A simple semi-supervised algorithm for named entity recognition[C].Naacl Hlt Workshop on Semi-supervised Learning for Natural Language Processing,2009.

[11] Aryoyudanta B,Adji T B,Hidayah I.Semi-supervised learning approach for Indonesian named entity recognition (NER) using co-training algorithm[C].International Seminar on Intelligent Technology & Its Applications IEEE,2017.

[12] XIAO K.Chinese organization name recognition based on co-training algorithm[C].International Conference on Intelligent System & Knowledge Engineering IEEE,2008.

[13] ZHANG R,Rudnicky A I.A new data selection principle for semi-supervised incremental learning[C].18th International Conference on Pattern Recognition,IEEE Computer Society,2006:780-783.

[14] Chawla N V,Karakoulas G.Learning from labeled and unlabeled data:An empirical study across techniques and domains[J].Journal of Artificial Intelligence Research,2005,23:331-366.

[15] Mnih V,Kavukcuoglu K,Silver D,et al.Human-level control through deep reinforcement learning[J].Nature,2015,518(7540):529.

[16] Silver D,Huang A,Maddison C J.Mastering the game of Go with deep neural networks and tree search[J].Nature,2016,529(7587):484-489.

[17] Yu K,Jia L,Chen Y.Deep learning:yesterday,today,and tomorrow[J].Journal of computer Research and Development,2013,50(9):1799-1804.

[18] Sutton R,Barto A.Reinforcement learning:An Introduction[M].MIT Press,1998.

[19] Lange S,Riedmiller M.Deep auto-encoder neural networks in reinforcement learning[C].The 2010 International Joint Conference on Neural Networks,2010,1-8.

[20] Rajaraman A,Ullman J D.Finding similar items[J].Mining of Massive Datasets,2010,77:73-80.

[21] Watkins C J C H,Dayan P.Q-learning[J].Machine learning,1992,8(3-4):279-292.

[22] Zhang M L,Zhou Z H.CoTrade:confident co-training with data editing[J].IEEE Transactions on Systems,2011,41(6):1612-1626.

作者簡介:

程钟慧(1995-),女,硕士生.研究领域:自然语言处理.

陈 珂(1977-),女,博士,副教授.研究领域:时空数据库,数据挖掘,数据隐私保护.

陈 刚(1973-),男,博士,教授.研究领域:大数据管理.

徐世泽(1973-),男,本科,高级工程师.研究领域:电力系统及自动化.本文通讯作者.

傅丁莉(1988-),女,本科,工程师.研究领域:通信技术.