网络重构城域网数据中心化解决方案

2018-07-23陈鼎张涛刘可兰强

陈鼎,张涛,刘可,兰强

网络重构城域网数据中心化解决方案

陈鼎,张涛,刘可,兰强

(新华三技术有限公司,浙江 杭州 310052)

运营商网络重构的基本技术思路是以DC为核心进行建设。在现网规模试商用经验总结基础之上,提出了三级DC架构、统一通信云基础设施部署、城域网vBRAS资源池和转控分离方案。并从业务角度出发,提出城域网业务率先从大会话小流量和IPTV场景切入,从而加快运营商城域DC的建设,培养运营商ICT融合运维能力,切实推动城域网重构有序进行。

网络重构;通信云;SDN/NFV;vBRAS;转控分离

1 引言

全球运营商面临着互联网时代的冲击。为谋求更好的生存与发展,业务转型网络重构已经从犹豫彷徨走到迭代实践的阶段。近5年来,运营商从业务和技术方面都在尝试转型——海外运营商转型已在近期看到成效:新技术的引入使得美国Verizon预估到2020年将节省百亿美元;美国AT&T认为网络转型降低了建网成本,预计年底将达到新技术引入临界点;美国CenturyLink在完成60%局端的虚拟化过程中,收获到新技术为其运维流程简化和效率提升带来的灵活性优势。中国的运营商同样在探索适合自身的转型之路,网络重构CTNet2025、NovoNet2020、CUBE-Net2.0是中国三大运营商为自身打造的企业发展战略,尤为关注如何借助新技术实现网络架构、业务模式和组织管理的整体转型[1]。

当前中国三大运营商的基本思路都是以数据中心(DC)为核心进行网络重构,将电信级网元虚拟化的灵活性和云网融合的便捷性有机融合在一起,实现多样化的业务服务和快速业务交付。运营商撕掉传统网络管道提供商的标签,真正实现“网络即服务(network as a service,NaaS)”。“网络即服务”并不是传统意义上的管道智能化,它从更多维度得到用户“画像”,将原来割裂的承载网和DC有机融合起来,网络和业务功能、性能以更细的颗粒度划分后再按需重组,实时交付给用户。用户可以自服务,也可以根据应用的需要随选。

新华三技术有限公司(以下简称新华三)的运营商网络重构整体解决方案为运营商转型而生。整体重构解决方案基于SDN、NFV和云技术,逐步引入大数据、AI等新兴前沿技术,服务于移动、政企、家庭等全业务网络重构。网络重构解决方案的目标是构建面向全业务承载的统一通信云。将业务点引入DC内,通过NFV实现弹性;将承载能力与通信网元能力结合,通过SDN和编排实现协同;扩展DC的服务能力,从通信服务扩展到ICT综合服务。

2 网络重构统一通信云DC化建设目标

统一通信云是面向全业务服务的数据中心化整体架构,不仅包含网络基础设施和虚拟化层、容器等基础资源,还包含服务于业务的各类VNF和PNF网元以及管理和编排。统一通信云将运营商网络中的实体从上至下、从DC内到DC外有机地融合到一起,成为云网融合的整体。新华三统一通信云逻辑架构如图1所示。

从目前中国的行政划分、用户业务和运营商资源分布角度出发,统一通信云DC划分为三级DC:第一级为区域级,面向全国集中型的资源池,以大区形式服务于区域内的用户;第二级为本地网核心级,面向本体网集中型的资源池,服务于本地网内的用户;第三级为边缘级,面向分布式部署的资源池,服务于就近用户。

图1 新华三统一通信云逻辑架构

DC内的统一通信云基础设施建设目标用于承载电信云以及业务云,这里的电信云特指电信网元,尤其是NFV化的电信网元;业务云指为用户提供服务的从IaaS到PaaS再到SaaS的资源池。DC内的基础设施,包含网络、服务器、存储以及虚拟化平台等,是可以统一建设的。基础设施为所有电信云和业务云服务,这也是DC构建的终极目标。在实际部署和管理过程中受制于当前的组织结构、管理复杂度等非技术因素,初期可能会有逻辑分离甚至物理分离的情况存在。DC内的网络建设目前主要采用SDN思路建网[2],实现网络的快速部署和灵活调整,目前主流思路采用EVPN+VxLAN分布式网络网关方案作为电信云和业务云的统一基础网络方案。方案的优点在于:高性能、灵活、大规模组网以及高支持度。DC内的云部署方案目前主流方案是虚拟化+OpenStack的商用版本。由于考虑到电信云对低时延、实时性、高性能和高可靠性的要求,虚拟化层更强调在这4个方面的能力增强。云管理则强调了与行业云、IT云等传统私有云、专有云的不同,增强了高可靠性和可维护性,并面向电信云,需要向上提供给编排层以丰富的接口,以便云网协同。在云管理部署上,由于整个通信云跨越了三级DC,对规模和时延都是前所未有的挑战,目前主流方案为云管理的分级部署。第一级DC内部署统一云管平台,第二级DC内部署虚拟基础设施管理,第三级DC目前的部署云规模还较小,又与第二级DC同城,初步方案考虑不下沉虚拟基础设施管理,只部署虚拟化。新华三统一通信云三级结构如图2所示[3]。

新华三网络重构统一通信云的整体解决方案基于开放架构,各个层级、各个模块之间做到解耦合,能与其他厂商的模块和组件解耦部署。中国的三大运营商已经成功完成解耦测试,并在重点省份实现了解耦部署的商用开局。同时新华三的解决方案也提供端到端的能力:面向全业务场景的DC化改造SDN方案、统一电信级云和统一编排器是网络重构的基石;面向家庭宽带业务和政企业务,新华三还可以提供丰富的网元,协助运营商快速实现重构实践,为运营商转型提供软件赋能和运营赋能。

尤其在固网领域,新华三网络重构整体方案下的城域网vBRAS解决方案,已经率先在中国联通、中国电信和中国移动省公司规模商用。

3 城域网重构DC化建设方案

3.1 城域网业务发展情况

传统运营商城域网大致可分为接入网层、汇聚层、业务控制层和核心路由层,业务控制层是城域网的业务核心,也是城域网运维的重点,一般都是通过一台宽带网络接入网关(broadband network gateway,BNG)来实现多种业务能力(例如PPPoE、IPoE、portal等),这能够有效减少网元的维护数量,简化网络架构,提高设备利用率,降低投资。运营商现网的BNG设备上基本上都会承载宽带、IPTV、Wi-Fi、ITMS、VoIP、二层专线以及三层专线等数种业务类型,而综合考虑投资、组网复杂和业务安全,现网BNG设备实际都没有做备份,单台设备承载用户规模一般在3万户上下,当设备出现故障时会大面积影响业务。

图2 新华三统一通信云三级结构

现有的城域网架构在实际业务上线和新业务开展过程中也逐渐发现:单一设备虽然能够做到多业务承载,能够实现大流量的吞吐能力,但是业务控制能力和流量的吞吐能力并不匹配。现网硬件BNG主要以承载IPTV、用户上网等对流量有较高要求的业务发展思路进行设计,导致现网设备的控制面会话(session)资源和转发能力不匹配,当承载小颗粒、大并发业务时,占用了大量的会话资源,从而转发能力过剩。而且单一网元承载多种业务,导致配置复杂,故障定位困难,业务之间也会存在相互影响的问题。

NFV、SDN等技术的出现使得城域网逐步向云化方向演进,原有多功能融合承载的网元将被一个个VNF功能模块取代,最终在城域网内形成以通信云为特征的城域网DC。x86架构近年来在密集计算和高性能吞吐方面都有了长足进步,这些功能模块根据其处理的业务特点不同可以选择在不同的虚拟化网元(vBRAS)上进行承载,业务的承载在网元上实现了分片,不同的业务根据自身需要选择不同的资源能力集和不同的部署物理位置。这样既能够通过云计算集约化的规模效应降低网络建设投资,提高利用率和网络可靠性;又可以通过部署在贴近用户的边缘DC内来提高业务响应的速度,降低时延,提高客户感知。vBRAS将以资源池的形式部署在统一通信云架构之上,逐步推进城域网演进,最终实现整个城域网的虚拟化目标。城域网业务云化后实现业务弹性如图3所示。

业务实现灵活调度、弹性伸缩的关键点在于固网业务在城域网边缘的POP交换机处实现了业务的分流,通过城域网内的VxLAN实现用户接入的物理位置与NFV化的业务处理点(vBRAS)之间的解耦,通过MANO实现在全城范围内的调度。无论是哪个用户从哪里接入,理论上都可以根据城域网的overlay隧道访问到任何一个业务切片后的vBRAS网元上。在MANO的统一编排下,正常规划时,运营商可以根据业务预估发展规划,规划好用户业务overlay隧道的起止点;在需要全城资源共享、负载分担、故障调度、新增增值业务等一系列无法预估的情况下,运营商可以灵活快速地连接好用户接入点和业务处理点之间的通道。这不仅是传统意义上的弹性管道,也是承载网络与服务节点资源池之间的弹性融合。

图3 城域网业务云化后实现业务弹性

3.2 城域网重构背景下固网业务的承载方向

vBRAS依托于x86平台,通过软件的方式实现现有硬件BNG的全部能力,具备承载现有城域网固网全部业务的能力。城域网DC的设立,逐步将城域网中所有业务网元的能力收至DC内通信云中,采用统一标准的基础网络架构来实现固网所有业务的承载,而业务会将适合采用x86服务器承载的先部署到DC内,达到成熟规模商用之后,再逐步将其他业务从现网进行剥离。

由于x86平台在计算方面能力突出,NFV形态的网元特别适合处理大会话、小流量业务的承载。如城域网内的ITMS、VoIP、Wi-Fi等业务,这类业务的典型特征是大会话、小流量,适合做全地市甚至全省的集中承载。通过边缘汇聚分流层设备将这类业务通过VxLAN技术封装送至核心DC的通信云内,由vBRAS资源池进行统一承载,可以高效地解决性能过剩和会话瓶颈的限制问题,大大提升业务的可靠性和经济性,并且业务的扩展性也大大增强,可以真正做到云化网络资源的因需而动。这类业务在现网应用广泛,已率先成熟商用,同时也是中国运营商固网业务虚拟化的力推方向。通过将现网BNG上大会话小流量业务进行剥离,可以大幅降低现网BNG的会话压力,也可以逐步推进网络虚拟化步伐,保护现网投资。中国电信江苏公司、中国电信江西公司等现网都有数百万应用规模,并在持续扩大。该方案将在第4节中做详细介绍。

近两年城域网流量增长的最主要来源是IPTV的迅猛增长,已经普及的高清IPTV和正在推广的4K IPTV将是流量业务体。IPTV的流量转发越来越倾向于将内容和转发下沉到城域网边缘,更靠近用户接入。从中国运营商的当前情况来看,基本上完成了地市级内容边缘节点的建设,为了应对4K的挑战以及未来VR、AR业务的基础承载储备,正在考虑内容边缘节点进一步向城域网边缘下沉。那么在IPTV关键的用户认证和转发节点BNG设备上,应该将集中的认证能力和分布式的转发能力相结合。于是,新华三结合城域网现状,通过vBRAS和POP交换机的结合,设计了IPTV业务的CU转控分离,在城域本地核心DC部署vBRAS-C(vBRAS的控制面网元),在汇聚分流节点部署基于交换机架构的vBRAS-U(vBRAS的转发面网元),vBRAS-U同时兼做接入网汇聚交换机可以减少组网建设投资。在此方案中IPTV业务的认证和控制流量由DC内的vBRAS控制面网元来处理,IPTV的业务流量则由汇聚分流节点的交换型转发面来承载,发挥了各自的优势,使得投资效益大幅提升。该方案将在第5节中做详细介绍。

另外,x86性能也在快速提升,vBRAS-UDK技术和高速网卡逐渐普及,vBRAS系统整体的吞吐性能也在快速提升。vBRAS在承载传统固网业务方面也具备了相当的实力。在中国联通山东公司、中国联通河北公司的试点中已经采用vBRAS作为宽带上网的业务处理节点,并实现了规模商用。目前单个虚拟机(VM)部署一个vBRAS,并采用Intel的X710芯片网卡情况下,可以提供40 Gbit/s的双向吞吐能力,如果采用4路服务器部署vBRAS网元,则单台服务器可以提供160 Gbit/s的吞吐能力。单个vBRAS按1万用户并发进行设计,则峰值并发用户户均可以达到4 Mbit/s的速率,高出目前现网户均峰值流量(<1.2 Mbit/s)3倍以上,基本上可以满足3~5年内的流量增长需求。随着x86平台不断引入新技术(如FPGA网卡等),整体吞吐能力也在不断攀升,单网卡提供80 Gbit/s甚至200 Gbit/s吞吐的能力也将在一两年内推向市场。

城域网宽带业务,由城域网汇聚分流设备(POP交换机)汇聚并封装VxLAN之后送入vBRAS上进行承载,业务流程示意如图4所示。专线类业务也类似,也是由POP交换机通过VxLAN封装之后送至DC内的vBRAS进行处理。

图4 x86形态vBRAS承载宽带业务示意

4 面向大会话小流量的vBRAS资源池建设方案

4.1 ITMS/VoIP业务部署方式

随着物联网、智慧家庭等产品渗透率的不断提升,城域网中小颗粒业务将持续增长。VNF基于x86平台,在计算方面能力突出已是明显的事实。ITMS/VoIP对于城域网而言,都是城域内基于MPLS L3 VPN的IPoE业务,主要用于管理各种家庭终端和实现家庭语音接入。这类业务的一个典型特征就是大并发、小流量,为了减轻物理BNG的会话压力以及实现ITMS/VoIP业务的集中管理,采用本地核心DC内vBRAS资源池集中承载ITMS/VoIP业务。

VxLAN是一种网络虚拟化技术,通过MAC-in-UDP的封装技术。通常VxLAN的运作依赖于VTEP(VxLAN tunneling end point,VxLAN隧道终端),该组件可以封装/解封装VxLAN的大二层隧道,为终端系统提供二层以太网服务所需功能。

大并发小流量业务部署方式如图5所示,由POP汇聚交换机、核心DC内的资源池网关、VNF作为VTEP,建立两段VxLAN隧道。将业务分流到该核心DC内对应的vBRAS,再由vBRAS终结VxLAN隧道进行业务处理。隧道的封装根据全省情况统一规划,由于VxLAN的VNI(VxLAN network identifier)具有1 600万个[2]。根据实际的用户规模,将一个或多个VSI的业务引流到一个vBRAS网元进行处理。

在城域网中引入vBRAS具有如下优势。

• 节省投资:vBRAS以x86强大计算能力,释放了现网硬件BRAS的会话能力,大量节省了BRAS扩容的成本。

• 支持快速业务创新:NFV技术可满足BRAS快速业务创新需求,而不依赖于硬件设备,新业务功能的提供仅需要进行软件升级。

• 简化运维、增强系统稳定性:通过构建vBRAS资源池,将分散的ITMS/VoIP业务集中管理,配置集中设置,简化运维压力。vBRAS天然支持业务云化,支持资源池内HA、多个资源池间的HA,提升系统的顽健性。

• 支持弹性扩展,提供精细化运营服务:以SDN、NFV及云技术构建的vBRAS资源池的扩展能力强,可根据不同负载情况动态扩展资源,提供精细化运营服务。

4.2 ITMS/VoIP业务HA方案

ITMS/VoIP业务的故障倒换方式有多种,首先可以在DC内进行资源的备份,采用vBRAS IRF(intelligent resilient framework)堆叠技术进行不同vBRAS网元之间的倒换。其次,在POP汇聚交换机至核心DC的pool-GW之间有两条underlay路径,单条underlay路径故障依靠underlay路由收敛,保证业务会话不中断。第三种是跨DC的保障机制,当整个核心DC故障或者核心DC无法访问时,由编排器向POP汇聚交换机下发流表,将业务切换到另一个核心DC。

当vBRAS采用IRF堆叠时,单个vBRAS故障业务不受影响。HJSW、边缘DC的pool-GW、核心DC的pool-GW也都采用IRF堆叠和双链路,pool-GW到CR也都采用双链路,单个设备或单个链路出现故障时,业务均不受影响。DC内故障倒换方式如图6所示。

DC间故障倒换方式如图7所示,如果CR和核心DC的pool-GW之间双链路出现故障、核心DC的pool-GW整机出现故障或整个核心DC出现故障,需要将业务切换到另一个核心DC,原有会话丢失,用户需要重新上线。为了实现核心DC之间业务的快速切换,需要在备用核心DC的备用vBRAS网元上提前通过MANO配置好相关业务。

图5 大并发小流量业务部署方式

图6 DC内故障倒换方式

4.3 VoIP业务跨DC可靠性保障方案

VoIP业务可靠性要求较高,在机房整体出现故障的极端情况下,业务可以快速地切换到另一个核心DC并且尽量将业务中断时间控制在分钟级。

由于VoIP业务采用的是IPoE协议,vBRAS故障、重启或更换vBRAS,VoIP终端无法快速感知,需要等VoIP终端IP地址租约到期,或者通过ITMS系统重启ONU终端,VoIP终端重新上线之后,才能接入新的vBRAS。所以建议ITMS和VoIP业务分别由不同的核心DC承载,如果承载VoIP的核心DC出现故障,可以通过另一个核心DC的ITMS系统重启ONU,使VoIP终端快速上线。

5 vBRAS转控分离方案和面向IPTV业务的创新

运营商城域网重构中,考虑到当前各类型芯片的能力和发展,将vBRAS控制与转发分离(以下简称转控分离),打破现有物理BRAS设备控制和转发一体化结构,遵循“控制集中、转发高效、交互简单、弹性可扩”的原则,选择合适的网元形态分别承载控制面和转发面。

图7 DC间故障倒换方式

5.1 vBRAS转控分离的基本原理

转控分离由处理控制面功能的vBRAS-C和处理转发面功能的vBRAS-U构成。vBRAS-C池和vBRAS-U可以根据业务需要部署在合适的物理位置,两者协同配合,能够实现原来单一BRAS设备的全部功能,并提供更容易横向扩展的物理架构和更容易支撑新业务开发的软件架构。vBRAS转控分离架构示意如图8所示。

图8 vBRAS转控分离架构示意

转控分离下的转发面vBRAS-U实现原有硬件BNG报文识别和转发方面的功能,vBRAS-U首先识别PPPoE/IPoE的控制报文和数据报文,如果是控制报文,将其透传至vBRAS-C资源池进行处理,vBRAS-C资源池完成用户认证后,将下发用户流表给vBRAS-U,vBRAS-U将收到的用户流表转换为硬件表项保存至本地;如果是数据报文,vBRAS-U将根据此前收到的用户流表来确定其的处理方式,从而实现控制和转发流程的分离。

转控分离的控制面vBRAS-C资源池主要实现原有硬件BNG控制方面的功能,包括:负责处理PPPoE/IPoE控制报文、与远端AAA系统进行交互认证、建立和维护用户会话表,并在用户认证通过后,把用户的二/三层信息和业务信息形成流表下发到vBRAS-U,指导vBRAS-U对用户后续的操作进行处理。

由于vBRAS-C资源池主要处理控制方面的功能,因此要求能处理复杂逻辑和维护状态机,需要强大的计算能力、超级大的内存以及灵活的扩展能力等,因此基于x86的服务器是vBRAS-C资源池承载的主流方案。同时考虑到vBRAS-C作为资源池,一般部署在省公司区域DC或者地市核心DC统一通信云基础设施上,采用ETSI规范中的NFV形态更符合运营商标准化的要求,并可根据资源的使用情况进行弹性的扩缩容,实现资源的动态调配,从而提高资源的利用率。vBRAS-C资源池实现的主要功能如下:

• 支持与RADIUS服务器交互,完成接入用户的认证、授权和计费;

• 支持利用本地地址池或远程DH vBRAS-C服务器,给认证通过的用户分配IP地址;

• 维护用户会话表,根据控制报文更新会话状态,记录认证结果和用户QoS策略,并形成流表下发给vBRAS-U;接受vBRAS-U反馈的会话统计并更新对应表项;

• 支持CGN控制功能,给认证通过的用户分配公网地址和端口段;

• 支持将故障vBRAS-U的用户会话表下发到备份vBRAS-U上,以实现vBRAS-U间∶1热备份。

转控分离的vBRAS-U实现用户认证通过后的数据报文的快速转发,因此一般部署于靠近终端用户的汇聚机房或边缘DC,主要功能如下。

• 支持传统硬件BNG设备的转发功能,包括PPPoE/IPoE加解封装、三层转发、基于用户的流量统计、基于用户的QoS处理(filter/remark/CAR)、基于用户的队列处理(HQoS)等。

• 支持CGN的转发功能,上行方向将报文私网地址/端口转换为公网地址/端口,下行方向将报文公网地址/端口转换为私网地址/端口。

• 支持多播、MPLS等功能。

转控分离后的vBRAS-C和vBRAS-U功能明确、分工清晰,因此vBRAS-C对vBRAS-U形态并不关注,只要vBRAS-U能识别控制报文并透传给vBRAS-C,并且能根据vBRAS-C下发的用户流表进行后续数据报文的转发即可。这种vBRAS-C对vBRAS-U架构的透明性,使得vBRAS-U的具体实现形态可根据不同场景和业务特点进行合理的选择。

vBRAS-U设备虽然功能得到大大简化,但转发性能要求高,根据业务特性的不同,可采用基于x86、NP和ASIC来实现vBRAS-U的功能。这3种形态的vBRAS-U设备都有自身适合的应用场景:x86形态的vBRAS-U设备,处理能力强、可扩展性高但转发性能低,因此当前大规模在现网实践大并发小流量的业务处理,例如ITMS、VoIP等业务;NP形态的vBRAS-U设备,处理能力、转发性能、可扩展性适中,适合于并发和流量适中、特性丰富的业务,网络已有设备和架构考虑延续,或者对建网成本不敏感的运营商;ASIC形态的vBRAS-U设备,业务处理能力灵活性弱但转发性能超强,而且价格具有极大吸引力,因此适合大流量、特性单一的业务,例如IPTV业务。根据3种vBRAS-U形态设备的各自特点,不同业务特征的运营商城域网业务选择不同的转发承载方式,有效降低总成本,将是网络功能和业务切片之后的最佳选择。

5.2 vBRAS转控分离的高可靠方案

由于转控分离包括vBRAS-C、vBRAS-U和vBRAS-C与vBRAS-U的连接链路,因此转控分离的可靠性包括:vBRAS-C的可靠性、vBRAS-U的可靠性、vBRAS-C与vBRAS-U连接的可靠性。

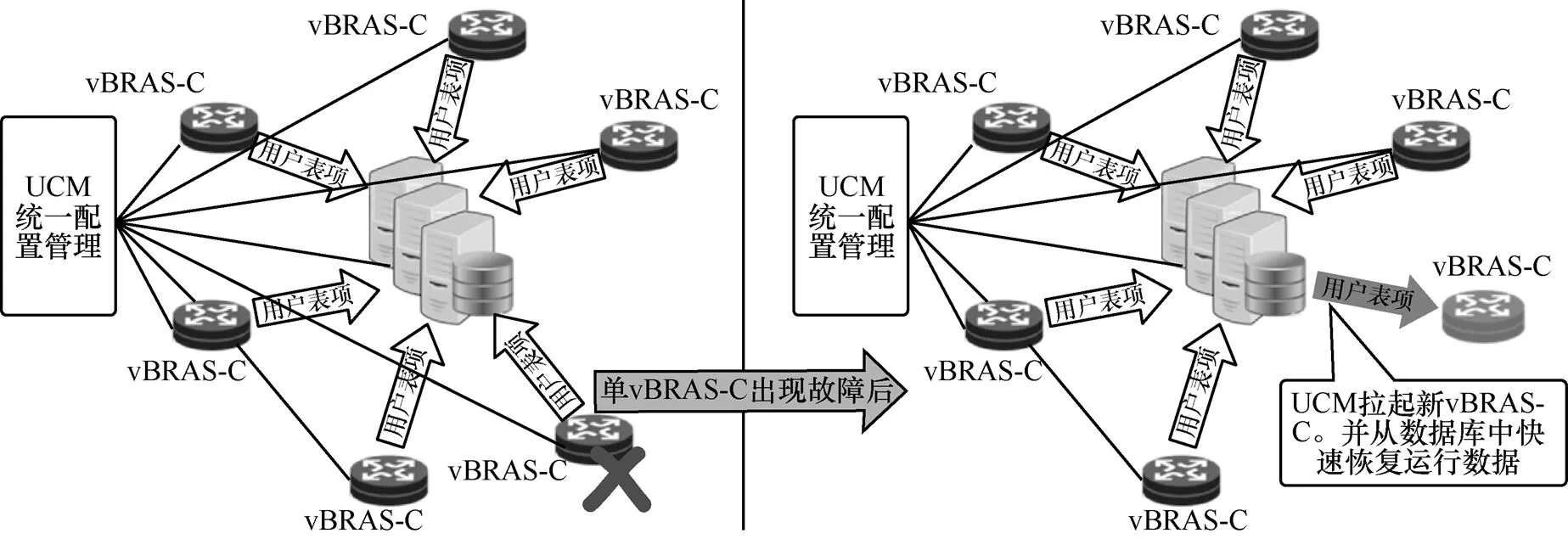

针对vBRAS-C的可靠性,通过引入共享数据库的方式实现1∶的故障保护机制。vBRAS-C的高可靠方案如图9所示。

从vBRAS-C软件模块中独立一个统一配置管理模块(UCM)来管理全部的vBRAS-C,通过共享数据库机制,所有的用户会话表项保存于此数据库中,所有vBRAS-C无状态,当某一个vBRAS-C出现故障时,UCM将重新生成一个新的vBRAS-C,将故障vBRAS-C的用户会话表运行数据恢复到新的vBRAS-C中,并将故障vBRAS-C管理的vBRAS-U重定向到新vBRAS-C,对于用户而言无感知,实现vBRAS-C的可靠性保障。

图9 vBRAS-C的高可靠方案

vBRAS-U的可靠性,除了原来硬件BRAS的1+1备份方式外,还可以采用如图10所示的负荷分担方式的备份方式。

其中vBRAS-U1和vBRAS-U2是两个相互独立的汇聚局的设备,OLT通过汇聚交换机与vBRAS-U1和vBRAS-U2都有链路。当vBRAS-U1出现故障时,vBRAS-C检测到vBRAS-U1不可用,将把vBRAS-U1上的活动用户会话表下发到vBRAS-U2,同时,汇聚交换机也检测到vBRAS-U1不可用,将用户上行链路指向vBRAS-U2,实现vBRAS-U2的热备份。如果是vBRAS-U感知与vBRAS-C失联,现有业务离线保持,即已经上线用户业务不变,新用户无法上线。

至于vBRAS-C和vBRAS-U连接的可靠性,首先vBRAS-C和vBRAS-U之间的连接隧道采用VxLAN技术,本身就是处于overlay层,当承载VxLAN隧道的物理设备或者物理链路出现故障时,这个underlay承载网络自身就有故障恢复机制,能够保证VxLAN隧道自愈。即使underlay网络无法恢复,vBRAS-C和vBRAS-U之间还有echo心跳检测机制来选择其他vBRAS-U来承载用户。

5.3 vBRAS转控分离在IPTV业务的应用

当前的转控分离方案的转发面选择有x86、NP和ASIC芯片方案,上文介绍了3种方案的特点和适用场景,本节将详细介绍ASIC方案应用在IPTV业务的创新方案。由于ASIC形态的vBRAS-U有高速的报文转发性能、低廉的建设成本,因此十分适合运营商自营的采用IPoE方式认证的IPTV视频业务。

图10 vBRAS-U的高可靠方案

运营商自营的IPTV业务一般是采用机顶盒作为用户终端,并且为用户的家庭网关(光纤入户的网关是ONU)分配一个端口供IPTV业务使用。基于ASIC的IPTV转控分离方案组网简化示意如图11所示。

ASIC形态的vBRAS-U设备收到IPoE控制报文后,将此报文透传到vBRAS-C资源池进行处理,vBRAS-C与AAA系统进行用户认证交互,认证通过后将给用户端设备分配IP地址,并给vBRAS-U下发指导后续转发的用户会话表。vBRAS-U将收到的用户流表转化为交换机硬件转发表项保存本地,后续用户数据在本地查表直接由高性能硬件转发。同时,vBRAS-U将vBRAS-C为其分配的网段地址通过路由协议发布出去,使IPTV业务系统(CDN等)学习到客户的地址。vBRAS-C和vBRAS-U的网关需要配置为相同的IP地址和MAC地址,认证通过后的数据报文直接由vBRAS-U进行处理,上行的数据报文目的MAC地址匹配vBRAS-U上的网关,查路由表直接进行三层转发;下行的数据报文在vBRAS-U上查找用户信息流表,匹配目的IP地址进行转发。IPTV业务转控分离基本流程如图12所示。

图11 vBRAS-U的高可靠方案

在机顶盒正式开始使用前,必须进行终端认证,以便能分配到IPTV业务的IP地址以及能接入IPTV的业务系统中。机顶盒向vBRAS-U发起DHCP请求,vBRAS-U设备进行报文识别,判断此报文是协议控制报文还是数据报文,如果是协议控制报文,将透传给vBRAS-C资源池进行处理,vBRAS-C与AAA系统进行认证交互,认证通过后为机顶盒分配IPTV业务的IP地址,并且vBRAS-C将用户信息表项(包含IP地址、MAC地址、VxLAN ID、QinQ、出端口)组装为用户信息ARP流表下发给vBRAS-U,用于指导下行数据报文的转发。如果是数据报文,vBRAS-U将直接与IPTV业务系统进行数据交换。

以上流程是IPTV业务IP地址获取、点播功能的流程,针对IPTV业务的多播功能,用户在认证通过以后,将用户加入vBRAS-U的多播组中,与城域网原有多播模式类似:多播复制点下沉到OLT,OLT上开启多播VLAN,ASIC形态的vBRAS-U启用PIM和IGMP实现多播的分发。

6 总结与展望

网络重构不是一蹴而就,就像罗马城不是一天建成的。在以DC化为核心的网络重构方向下,运营商应该快速地以各类业务进行切入,在现网进行实践探索。目前的大会话小流量业务和大流量的IPTV业务都是vBRAS和vBRAS转控分离方案绝佳的适应场景。通过现网实践快速拉动产业链的发展,积累新架构下的运维经验,快速将增值业务嵌入传统业务中,实现网络的自动化和业务的创新。

以vBRAS方案承载的大会话小流量的业务将在现网不断提升规模,省级规模将推向千万级,充分将vBRAS集中式资源池的能力发挥到最大。以vBRAS方案承载IPTV业务将在现网快速铺开,该方案不仅仅在于承载一种业务,同时要考虑未来大容量转发面的定制化灰牌机乃至白牌机的规范和标准制定,拉动产业链上游向城域网重构方向发展[4]。

技术方案并不是网络重构的瓶颈,知识库和运维运营架构的更新将是运营商在接下来的重构之路中面临的首要问题。新华三在重构方向上,不仅仅引领技术创新,也在不断尝试模式创新。传统意义上的设备厂商定位已经无法与运营商转型重构需求相匹配。新华三将突破传统模式,通过端到端并且可解耦的方案,为运营商进行软件赋能和运营赋能。网络不仅仅只提供管道业务,网络与云结合通过聚合通信能力、互联网能力和行业能力实现运营商整体服务的升维。

[1] 网络重构, 美国运营商收获头茬果实[N]. 人民邮电报, 2017-11-14.

Network reconfiguration, American operators harvest the first crop[N]. Renmin Youdian, 2017-11-14.

[2] 赵辉, 丁鸣, 程青松, 等. SDN与NFV技术在云数据中心的规模应用[J]. 电信科学, 2016, 32(1): 144-151.

ZHAO H, DING M, CHENG Q S, et al. Application of SDN and NFV technology in the cloud data center[J]. Telecommunications Science, 2016, 32(1): 144-151.

[3] 中国联通网络技术研究院. 中国联通边缘业务平台架构及产业生态白皮书[R]. 2018.

China Unicom Network Technology Research Institute. China Unicom’s edge business platform structure and industrial ecology white paper[R]. 2018.

[4] 韦乐平. SDN的战略性思考[J]. 电信科学, 2015, 31(1): 7-12.

WEI L P. Strategic thinking on SDN [J]. Telecommunications Science, 2015, 31(1): 7-12.

Telecom cloud solution in re-architecture of MAN

CHEN Ding, ZHANG Tao, LIU Ke, LAN Qiang

New H3C Technologies Co., Ltd., Hangzhou 310052, China

Evolving the legacy network to SDN/NFV network is the strategy of carrier network re-architecture. Based on large-scale cases, multi-tier data centers architecture, application-driven telecom cloud infrastructure, vBRAS pool and C-U separation solutions were proposed. Session-consumed services and IPTV are the first several services that can be implemented by the new solution in MAN. And in those usecases, the carriers’ operators really combine the IT and CT operation teams into one virtual team, and push the evolution gradually.

network re-architecture, telecom cloud, SDN/NFV, vBRAS, control-user plane separation

TP393.1

A

10.11959/j.issn.1000−0801.2018219

2018−06−16;

2018−07−10

陈鼎(1983−),女,新华三技术有限公司运营商资深产品经理,主要研究方向为运营商IP网络、电信云、网络重构、城域网SDN/NFV等。

张涛(1978−),男,新华三技术有限公司运营商高级产品经理,主要研究方向为运营商IP网络、云计算技术、城域网络SDN/NFV演进等。

刘可(1972−),男,新华三技术有限公司运营商高级产品经理,主要研究方向为运营商IP网络演进、SDN、NFV、overlay等新技术对运营商城域网重构的应用。

兰强(1992−),男,新华三技术有限公司运营商产品经理,主要研究方向为运营商IP网络、数据中心SDN/NFV技术演进。