基于无监督学习算法的推特文本规范化

2016-07-19邓加原姬东鸿费超群任亚峰

邓加原 姬东鸿 费超群 任亚峰

摘要:推特文本中包含着大量的非标准词,这些非标准词是由人们有意或无意而创造的。对很多自然语言处理的任务而言,预先对推特文本进行规范化处理是很有必要的。针对已有的规范化系统性能较差的问题,提出一种创新的无监督文本规范化系统。首先,使用构造的标准词典来判断当前的推特是否需要标准化。然后,对推特中的非标准词会根据其特征来考虑进行一对一还是一对多规范化;对于需要一对多的非标准词,通过前向和后向搜索算法,计算出所有可能的多词组合。其次,对于多词组合中的非规范化词,基于二部图随机游走和误拼检查,来产生合适的候选。最后,使用基于上下文的语言模型来得到最合适的标准词。所提算法在数据集上获得86.4%的F值,超过当前最好的基于图的随机游走算法10个百分点。

关键词:

规范化;无监督学习;二部图;随机游走;拼写检查

中图分类号: TP391; TP18 文献标志码:A

0引言

近年来,由于微博的快速发展,用户生成内容的数量大幅度增加。推特作为最流行的微博服务之一,它拥有10亿个活跃用户,每天产生5亿条微博(http://expandedrambling.com)。然而,由于其快速发布的性质,推特文本中包含了大量由用户有意或无意中创造的非标准词。比如:用数字替换字母2gether(together)和2morrow(tomorrow);重复字母来强调要表达的内容coollll(cool)和birthdayyyy(birthday);省略元音字母ppl(people);用发音相似的字母来替换fon(phone)。除此之外,还有另外一种类型的非标准词,主要包括多个连续的标准词之间省略了空格、标点和字母,例如:theres(there is)、loveyousomuch(love you so much)、ndyou(and you)和untiltheend(until the end)等。根据对1000条推特进行统计,发现其中包括了1329个非标准词,其中大约22%的比例(294个)需要规范化为两个或者更多的标准词。

推特作为极有价值的信息源,引起来了众多自然语言处理任务和应用的关注。比如信息抽取[1]、自动摘要[2]、情感分析[3-4]、灾难检测[5]和事件发现[6-7]等。然而,推特文本中的非标准词严重限制了这些任务和应用的性能[1,8]。比如:对于标准的自然语言处理工具来说,命名实体识别在推特文本中从90.8%骤降到45.8%[9];词性标注和依存句法分析分别下降了12.2%和20.65%[10]。基于此,为了使得推特文本能有效被用于标准的自然语言处理任务,设计合理的文本规范化算法至关重要。

近年来,涌现了一批文本规范化系统来将非标准词规范化为标准词[8,11-15],但是,这些工作假设一个非标准词对应于一个标准词。比如hiiiii规范化为hi,值得注意的是,在先前的系统中,theyre规范化为they,itmay规范化为it,这些系统会丢失一些关键的信息,这显然是不够合理的。

本文主要集中于推特文本的规范化处理工作,其主要面临以下两个挑战:

1)对一个非标准词,它应该被规范化为一个还是多个标准词?

2)推特文本的规范化系统应该具有很高的准确率和召回率,才能使得其作为标准自然语言处理工具的预处理步骤中产生较好的作用。

本文提出了一个创新的无监督文本规范化系统来解决应对上述两个挑战。首先,根据非标准词的特性,基于前向和后向搜索将一个非标准词转化成所有可能的多词组合(由标准词和非规范化词构成);然后,整合二部图的随机游走算法和误拼检测算法,为非规范化词产生候选列表;最后,根据基于上下文的语言模型来确定最合适的解。

1相关研究

近年来,随着社交网络的快速发展,文本规范化吸引了众多研究者的关注。最近的工作主要集中于推特文本的规范化,把非标准词转化为其标准形式。

Han等[8]基于词的形态和音位的相似性构造分类器来规范化非标准词。Gouws等[16]提出了基于字符串和分布相似性的方法构造标准词典,来检测非标准词。基于分布和字符串的相似性,Han等[12]提出了一个相似的方法,来为一个非标准词产生多个标准的候选。

更近的,Hassan等[13]首次提出了基于二部图来发现候选词,然后使用N元语法模型选出最较好的规范化词。Wang等[14]提出了集束搜索(beam search)解码器有效地结合了不同的规范化操作,并将其规范化系统有效地应用到中英文翻译系统。Li等[15]提出整合各种不同的规范化系统的候选结果,基于词向量的语义相似性和其他基于距离的相似性策略对候选结果进行重排序,以此来提高候选集合的质量。

上述的已有方法无法获得能满足实际应用的效果。主要原因归结于这些方法都假设非标准词到标准词的关系是一对一的关系。然而,现实中有很多非标准词(例如howyou和havent)应该被规范化为多个标准词,如果把这些词规范化为单个标准词,会损失很多重要的信息。在本文提出的系统中,一个标准词将根据其特性被规范化为一个或多个标准词,使得规范化系统在自然语言处理任务中能够取得更好的结果。

2推特文本规范化系统

本文旨在将非规范化的推特文本作为输入,输出其对应的标准化文本。所提出的主要框架如图1所示。对于一个推特文本,标准词典被用于检测该推特是否需要进行规范化。然后,推特中的非标准词,将会被根据其特征来考虑进行一对一(11)还是一对多(1N)规范化。对于需要一对多的非标准词,通过前向搜索和后向搜索算法,计算出所有可能的多词组合。对于多词组合中的非规范化词,基于二部图随机游走算法和误拼检查,产生合适的候选。最后使用基于上下文的语言模型来得到最合适的标准词。接下来详细介绍本文提出的系统。

2.1预处理和标准词典

所提系统的第一步是判断一条推特文本是否需要规范化。根据推特文本本身的特性,在判断是否需要规范化之需要一些预处理,下述几种类型的词不需要作规范化处理:

1)以#或@开头所构成的词(例如:#kingJames,@michael);

2)由纯数字所构成的单词(例如:2014);

3)表情符和URL(Uniform Resource Locator)。

在推特文本中,还有很多表示人名或者地名的命名实体不需要规范化,因此,使用的标准词典必须足够广阔以至于能够尽可能地包含这些命名实体。为了获得较合适的标准词典,基于一个大规模的语料LDC(Linguistic Data Consortium)统计了所有单词的出现频率,并且删除所有频率低于5的单词。然后,使用GNU ASpell词典(v0.60.6)过滤掉一些单词。剩下大约68000个单词构成本文使用的标准词典。自然而然地,本文认为,凡是没有出现在这个标准词典中的词都应该是需要规范化的非标准词。

2.2统计规则

2.1节中讨论了哪些词需要规范化。接下来,一个重要的挑战就是判断一个非标准词应该被规范化为一个还是多个标准词。通过观察和分析大量的非标准词,对其特性进行了总结。对符合以下特性的非标准词进行11规范化:

1)如果某个非标准词所所包含的字符总数少于4个,则直接将其规范化为一个标准词,例如,u(you)和r(are);

2)如果某个非标准词是字母和数字的组合,则将其直接规范化为一个标准词,例如,be4(before)和2day(today)。

在本文提出的系统中,符合以上特性的非标准词,将直接进行11规范化;否则,该非标准词将会被考虑有可能规范化为多个标准词。当然,上述两条规则没有捕获所有的情况,比如ur可能需要规范化为you are,也有可能需要规范化为your或者our。这类非标准词由于长度太短,本身具有太大的歧义,需要依靠特定的上下文,但是符合上述特性的非标准词绝大多数情况是属于11规范化的。

本文也分析和总结了另一类非标准词,这类非标准词应该被规范化为两个或者更多的标准词。这类非标准词主要包括以下3种类型。

类型1非标准词主要由两个或更多的标准词构成,标准词之间的空格被用户有意识或无意识地省略。例如,iloveyou(i love you)和rememberwith(remember with)。

类型2非标准词由一个或多个标准词,连同一个非规范化词构成。例如,wasnt(was not)和ndyou(and you)。

类型3非标准词由两个或者更多的标准词的单个字母缩略构成。例如,ur(you are)和sm(so much)。

类型3的非标准词是非常有限的,这种类型的非标准词本身也具有很大的歧义性。本文提出的系统将整合互联网用户整理的俚语表(slang dictionary(http://www.noslang.com/dictionary)),连同算法所计算出的候选集合。最终根据语言模型来计算出最合适的标准词。

2.3前向搜索和后向搜索

对于一个非标准词,本研究提出使用前向搜索和后向搜索算法,为其找出所有可能的多词组合。前向搜索能够解决两种类型的非标准词:第1种类型是非标准词由一个或多个标准词和一个非标准词按顺序组成,例如,theyre(they are)和wouldnt(would not)。第2种类型是由两个或者多个标准词组成,例如,aboutthem(about them)和iloveyou(I love you)。具体的前向搜索如算法1所示。

算法1前向搜索ForwardSearch。

有序号的程序——————————Shift+Alt+Y

程序前

输入:单词查找树的当前节点node,存储组合的列表(Set),将要匹配的字符串word,已经匹配到的字符串matchedWord。

输出:所有可能的多词组合。

1)

If(node.state==1)

2)

{

3)

Set

4)

matchedLength=len(matchedWord)

5)

word=word.subString(matchedLength)

6)

matchedWord=′ ′;

7)

ForwardSearch(Trie.root,set2,word,matchedWord)

8)

For(String str:set2)

9)

{ set.add(matchedWord+″ ″+str);}

10)

}

11)

If(len(word)!=0)

12)

{

13)

char c=word.charAt(0);

14)

int index=c-′a′;

15)

if(node.next[index]!=null)

16)

{

17)

word=word.subString(1)

18)

matchedWord+=c;

19)

ForwardSearch(node.next[index],set,word,matchedWord);

20)

}

21)

}

程序后

需要指出的是,算法1中,Trie是由标准词典构造的单词查找树,可方便用于快速查找一个非标准词中所包含的标准词。

类似于前向搜索,后向搜索算法也能解决两种类型的非标准词:第1种类型是非标准词由一个非标准和一个或多个标准词按顺序组成,例如,ndyou(and you)和looveyou(love you)。第2种类型是由两个或者多个标准词组成。后向搜索算法的过程与前向搜索类型,唯一不同的是单词查找的构造和搜索的顺序都是逆序的。

对于一个非标准词,基于前向搜索和后向搜索后,可以找到非标准词所有可能的多词组合。例如,theyre的前向搜索有“the yre”和“they re”两种组合结果。然后将所有组合中的非规范词(yre和re)进行11规范化。与此同时,非标准词本身(theyre)也要进行11规范化,确保不会遗漏任何可能存在的情况。在后面的章节,将讨论如何对非规范词进行11规范化。

2.4随机游走和误拼检查

非规范化词有很多类型,例如,重复字母用来强调、字母替换、字母到数字的替换、字母发音替换等。一个很自然的想法就是通过误拼检查来将非规范化词进行规范化,但是,误拼检查仅仅能还原用户无意的漏掉个别字符的非规范化词。同时,为了能为用户刻意创造的非规范化词找到合适的候选,本研究使用基于二部图的随机游走算法来找到候选集,因此,对于一个非规范化词,为了进行11规范化,本文整合基于二部图的随机游走算法和误拼检查来产生候选集合。

本文提出使用上下文的相似性来为非标准词找到其可能的标准词的候选集合。比如任意5元语法序列,如果两个中心词的前后两个词完全一样,那么这两个中心词可能就是同一个词或者语义相关的词。例如,非规范词be4和标准词before,由于其共享上下文“the day * the day”和“dress yourself * contract me”,因此,可以认为这两个词是同一个词或者语义相关的词。最终通过基于字符串的相似度和基于上下文的语言模型可以判定,“before”就是“be4”的规范化结果。上述分析证明了非规范词和标准词可以通过大规模的推特语料来获取,基于此,本文提出使用基于二部图的随机游走算法,来为一个非规范词,通过上下文相似性,找到其对应的标准词候选集合。首先介绍二部图的构造。

2.4.1构造二部图

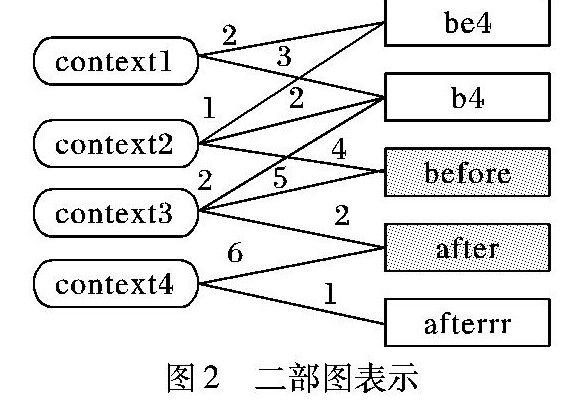

上下文的相似性可以用二部图来表示:第1种类型的节点代表词;第2种类型的节点代表可能被词共享的上下文。词节点的类型可能是非规范词,也可能是标准词。图2显示了二部图G(W,C,E)的一个样例,其中蓝色灰色这样描述是否符合要求?请明确。的节点表示标准词。

二部图G(W,C,E)中,W表示非规范词或者标准词,C表示所有的上下文,E表示连接词节点和上下文节点的边,边的权重是词节点和上下文节点共现的次数。二部图的构造如算法2所示。

算法2构造二部图。

有序号的程序——————————Shift+Alt+Y

程序前

输入:推特语料。

输出:二部图G(W,C,E)。

1)

Extract all 5gram sequences from corpus;

2)

Store all sequences into NgramTable;

3)

For each sequence NgramTable;

4)

W*Add(CenterWord);

5)

C*Add(Context);

6)

E*Add(Context,CenterWord,Count)

程序后

2.4.2随机游走产生候选集

基于二部图的随机游走算法首先被Norris所定义[17],然后被广泛应用于各种自然语言处理任务中。例如,Hughes等[18]提出在WordNet图上使用随机游走算法来检测词语的语义相关性;Das等[19]提出在两种语言上使用图模型的标签传播来进行跨语言的知识转移;Minkov等[20]提出一种基于受限路径图的随机游走算法来计算图中节点的相关性;Hassan等[13]提出使用Twitter和LDC语料构造的二部图来考虑词语规范化。不同于上述算法,本文仅仅使用大规模的推特语料,使用二部图的随机游走算法来为非规范词找到合适的候选集合。

对于一个非规范词,随机游走算法使用轮盘赌的方式随机游走4步来遍历二部图。算法从非规范词节点开始,到标准词节点或者走完最大步数结束。在本文提出的框架中,对于每个非标准词,其随机游走的过程都迭代100次。

考虑一个二部图随机游走过程,以图2中的二部图为例,假设随机游走算法从非规范词节点be4出发,通过轮盘赌随机移动到上下文节点context2,然后再移动到标准词节点before,本次随机游走结束,这次的随机游走将be4和before联系起来。同时,在下次的随机游走过程中,非规范词节点be4可以通过随机游走将将非规范词节点be4同after联系起来:

be4 → context1 → b4 → context3 → after

那么对于非规范词be4,如何判断候选词的好坏,即对于be4来说,after和before,哪个是更好的候选。

本文中,对于一个非标准词,通过计算置信度ConValue(N,S)对其随机游走的候选结果进行排序,其中N表示非规范词,S表示标准词,ConValue(N,S)的计算如下:

ConValue(N,S)=α*F(S)+β*Sim(N,S)(1)

其中α和β是权重,这里使用均匀插值,即设置α=β=0.5。F(S)的计算如下:

F(S)=S_frequency/total_frequency(2)

其中:S_frequency表示标准词S在100次随机游走中最终被识别的次数,total_frequency表示在100次随机游走中找到的标准词个数。Sim(N,S)是基于最长公共子序列比率的字符串相似度函数[21-22],其计算方式如下:

Sim(N,S)=LCS(N,S)/MaxLength(N,S)ED(N,S)(3)

其中:LCS(N,S)表示N和S的最长公共子序列,ED(N,S)表示N和S的编辑距离。

对于一个非规范词,可以使用随机游走算法为其计算出可能的候选集合,并通过ConValue(N,S)值选取Top5对候选集合进行修剪。随机游走算法的优点是可以为绝大多数非规范词找到合适的候选词。然而,由于数据集的规模限制,基于二部图的随机游走算法不可能为所有的非规范化词找到候选集合,因此必须同时结合其他方法,为一个非规范词产生一定的候选集合。本文采用经典的误拼检查算法来产生候选,将其结果同随机游走算法产生的候选整合到一起作为整个候选集合。

2.4.3误拼检查

对于误拼写错的非规范词,误拼检查算法是个简单并且有效的规范化方法。本文中采用Jazzy spell checker(http://jazzy.sourceforge.net/),并且同时整合DoubleMetaphone声音匹配算法,来考虑单词之间的字符的取代、插入、删除和交换等操作。本文设置编辑距离为2之内的所有标准词来作为一个非规范词的候选集合。

2.4.4产生Topn候选集

对于一个非标准词N,通过随机游走算法和误拼检查为其产生了一定数量的候选,需要对这些候选进行排序,除了比较字符串的相似性外,还考虑了其语义相似性,对于非标准词N,其所有候选的得分通过式(4)来计算:

S(N,S)=Sim(N,S)+Cos(vec(N),vec(S))(4)

Sim(N,S)的计算方法已在前面介绍过,函数Cos(vec(N),vec(S))表示非标准词N和标准词S的词向量之间的余弦相似度,为了计算词N和词S的词向量,本文使用了谷歌的开源工具word2vec(http://code.google.com/p/word2vec/),基于800万条推特语料来训练,词向量的维度被设置为200。基于S(N,S),最终为每个非标准词选取Topn个候选词(n=1,3,5)。

2.4.5基于语言模型来规范化推特

对于一个非标准词,整合随机游走和误拼检查为其产生Topn个候选词。为了确定该非标准词的最佳候选,需要考虑该非标准词的上下文信息。基于大规模的文本数据,通过使用3元和4元语法模型来对维特比(Viterbi)路径进行打分,基于此来选择最合适的候选,进行规范化。本文在使用基于上下文的语法模型时,分别考虑了3种不同类型的数据。

3实验

3.1实验设置

实验中使用了5个数据集,数据集(1)和数据集(2)将用于词级别(wordlevel)的评估;数据集(3)不仅用于词级别的评估,还用于句子级别(messagelevel)的评估。值得注意的是,数据集(1)和数据集(2)的非标准词,仅仅需要被规范化为一个标准词。5个数据集的介绍如下。

数据集(1)3802个非标准词及其对应的人工标注的标准词。这些非标准词来自于2009年到2010年之间的6150条推特文本[11]。

数据集(2)2333个非标准词及其对应的人工标注的标注词,这些非标准词来自于2577条推文本[15,23]。

数据集(3)邀请了3个母语为英语的学生标注的1000条推特文本。其中有850条推特需要进行规范化的,另外150条不需要规范化。该数据集中总共包含1345个非标准词,其中297个非标准词需要被规范化为两个或更多的标准词。

数据集(4)通过推特流API(http://dev.twitter.com/docs/streamingapis)获取的800万条推特文本数据,这些推特来自于2014年10月到12月。该数据被用于构建随机游走的二部图。

数据集(5)来自英文LDC Gigaword(http://www.ldc.upenn.edu/Catalog/LDC2011T07),该语料被用于构建标准词典。

词级别(wordlevel)的规范化旨在判断非标准词对应的标准词是否在所产生的候选集合中,因此,对于一个非标准词,系统通过其候选集Topn中是否包含其标准词来判定它是否被正确地规范化。为了同已有算法相比较,分别计算了在不同Topn设置下的准确率。对于文本级别(messagelevel)的评价,基于不同类型的大规模文本数据,分别构造语言模型来计算准确率、召回率和F值来评估Top1、Top3和Top5设置下的系统性能。

3.2词级别实验结果

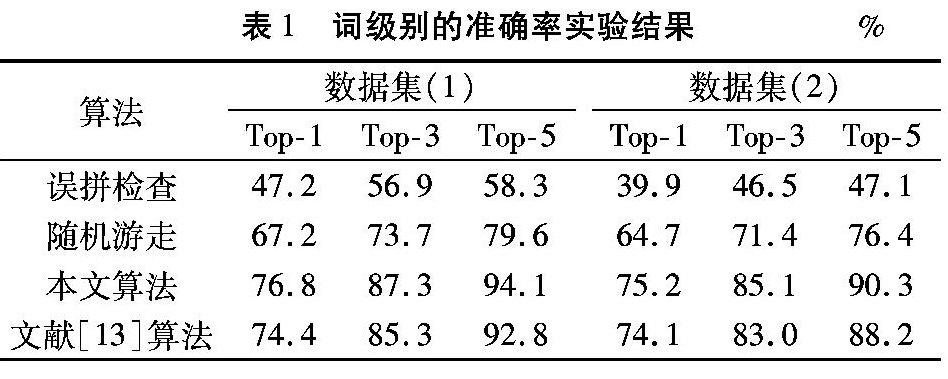

词级别的结果呈现在表1中,本文分别在数据集(1)和数据集(2)中进行评估,分别展示了Top1、Top3和Top5的准确率。

从表1中可知,仅仅使用误拼检查,数据集(1)和(2)上的准确率为40%到60%,这说明仅仅通过比较词的相似性无法有效规范化用户有意识创造和使用的非标准词。同时,随机游走算法取得了相对较好的结果,在两个数据集中获得了65%到80%的准确率,比起误拼检查,随机游走能够有效地捕获人们有意创造的非标准词。最后,本文提出的系统,通过整合误拼检查和随机游走作为整个候选集,在Top5混合系统中获得了90%到94%的准确率,这证实本文算法的有效性。

比起当前的算法最好的算法文献[13]算法,本文提出的无监督文本规范化系统能获得更高的准确率,主要原因归结于本文的系统所产生的候选集,整合了随机游走算法和误拼检查的结果,能更好地覆盖到人们有意或者无意创造的非标准词。

3.3文本级别实验结果

文本级别的规范化旨在为推特文本的每个非标准词找到最符合上下文的候选。基于数据集(3),表2中呈现了文本级别的规范化结果。

在表2中,“w/o context”表示的是Top1词级别的系统设置下的规范化结果。值得注意的是,尽管Top1仅有一个候选词,但由于本文所提出的系统的高效性,最终获得了84%的F值。为了计算Top3和Top5设置下的实验结果,使用3种不同类型的文本数据,基于语言模型(LM),采用维特比算法来解码。在使用推特文本(Twitter)的语言模型中,能够看到准确率和召回率随着候选集合大小n(1,3,5)的增大而增大,在n=5时,获得本文所提出的系统可获得高达86.4%的F值。同时,从表2可以看到混合文本语言模型(Mixed LM)和推特文本语言模型(Twitter LM)超过了当前算法的性能。

需要指出的是,基于LDC语料的语言模型(LDC LM),其结果随着候选集合大小n的增大而变差,其主要原因有推特文本的性能所决定,对推特文本来说,即使非标准词被规范化后仍然会存在一些语法上的错误。这不难解释单纯使用推特文本的语言模型(Twitter LM)会比混合语言模型(Mixed LM)有更好的结果。

同时,从表2中可以看出,比起当前的系统[13,15],本文提出的系统在F值上有超过10%的提高了10个百分点以上,主要原因在于提出的系统考虑了非标准词一对多的规范化,而之前的工作全都集中在一对一的情况,限制了该任务的性能。

3.4结果分析

图3呈现了数据集(3)的3个原始推特,经过不同系统规范化后的结果。在图3中,S表示原始推特,B表示当前的方法[15],O表示本文提出的系统。在第一条推特文本中,所有的非标准词都能被正确规范化,但是,对于后两条推特,现有的系统使用一对一的规范化损失了一些关键的信息,使得规范化的结果出现一定的错误。而在本文提出的无监督文本规范化系统中,根据非标准词的特性,为其产生一个或多个标准词,来作为规范化的结果,更能满足实际应用。基于上述分析,可以证实本文提出系统的有效性。

4结语

本文提出了一个无监督的推特文本规范化系统。对于一个非标准词,根据其特性,基于前向搜索和后向搜索将其划分为可能的多词组合。然后,整合随机游走算法和误拼检查为非规范词产生可能的多个候选。最后,使用基于上下文的语言模型来为非标准词计算出最合适的候选。实验结果证实本文所提算法的有效性,比起当前算法,本文提出的算法在F值获得超过10%的上提高了10个百分点以上。本文提出的无监督文本规范化系统能够有效用于自然语言处理任务的预处理。

参考文献:

[1]

RITTER A, CLARK S, MAUSAM M, et al. Named entity recognition in tweets: an experimental study [C]// Proceedings of the 2011 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2011: 1524-1534.

[2]

LIU F, LIU Y, WENG F. Why is “SXSW” trending? Exploring multiple text sources for twitter topic summarization [C]// Proceedings of the 2011 ACL Workshop on Language in Social Media. Stroudsburg, PA: Association for Computational Linguistics, 2011: 66-75.

[3]

MUKHERJEE S, BHANACHARYYA P. Sentiment analysis in twitter with lightweight discourse analysis [C]// Proceedings of the 26th International Conference on Computational Linguistics. New York: ACM, 2012: 1847-1864.

[4]

TANG D, WEI F, YANG N, et al. Learning sentimentspecific word embedding for Twitter sentiment classification [C]// Proceedings of the 52nd Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2014: 1555-1565.

[5]

SAKAKI T, OKAZAKI M, MATSUO Y. Earthquake shakes Twitter users: realtime event detection by social sensors [C]// Proceedings of the 19th International Conference on the World Wide Web. New York: ACM, 2010: 851-860.

[6]

WENG J, LEE BS. Event detection in Twitter [C]// Proceedings of the 5th International Conference on Weblogs and Social Media. Menlo Park, CA: AAAI Press, 2011: 401-408.

[7]

BENSON E, HAGHIGHI A, BARZILAY R. Event discovery in social media feeds [C]// Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg, PA: Association for Computational Linguistics, 2011: 389-398.

[8]

HAN B, BALDWIN T. Lexical normalisation of short text messages: mken sens a #twitter [C]// Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg, PA: Association for Computational Linguistics, 2011: 368-378.

[9]

LIU X, ZHANG S, WEI F, et al. Recognizing named entities in tweets [C]// Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg, PA: Association for Computational Linguistics, 2011: 359-367.

[10]

FOSTER J, CETINOGLU O, WAGNER J, et al. #hardtoparse: POS tagging and parsing the twitter verse [C]// Proceedings of the AAAI Workshop on Analyzing Microtext. Menlo Park, CA: AAAI Press, 2011: 20-25.

[11]

LIU F, WENG F, WANG B, et al. Insertion, deletion, or substitution? normalization text messages without precategorization nor supervision [C]// Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies. Stroudsburg, PA: Association for Computational Linguistics, 2011: 19-24.

[12]

HAN B, COOK P, BALDWIN T. Automatically constructing a normalization dictionary for microblogs [C]// Proceedings of the 2012 Joint Conference on Empirical Methods in Natural Language Learning. Stroudsburg, PA: Association for Computational Linguistics, 2012: 421-432.

[13]

HASSAN H, MENEZES A. Social text normalization using contextual graph random walks [C]// Proceedings of the 51st Annual Meeting of the Association for Computation Linguistics. Stroudsburg, PA: Association for Computational Linguistics, 2013: 1577-1586.

[14]

WANG P, NG H T. A beam search decoder for normalization of social media text with application to machine translation [C]// Proceedings of the 2013 Conference of the North American Chapter of the Association for Computation Linguistics: Human Language Technologies. Stroudsburg, PA: Association for Computational Linguistics, 2013: 471-481.

[15]

LI C, LIU Y. Improving text normalization via unsupervised model and discriminative reranking [C]// Proceedings of the ACL 2014 Student Research Workshop. Stroudsburg, PA: Association for Computational Linguistics, 2014: 86-93.

[16]

GOUWS S, HOVY D, METZLER D. Unsupervised mining of lexical variants from noisy text [C]// Proceedings of the First workshop on Unsupervised Learning in NLP. Stroudsburg, PA: Association for Computational Linguistics, 2011: 82-90.

[17]

NORRIS J R. Markov Chains [M]. Cambridge, UK: Cambridge University Press, 1997: 35-38.

[18]

HUGHES T, RAMAGE D. Lexical semantic relatedness with random graph walks [C]// Proceedings of the 2007 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2007: 581-589.

[19]

DAS D, PETROV S. Unsupervised partofspeech tagging with bilingual graphbased projections [C]// Proceedings of the 49th Annual Meeting of the Association for Computation Linguistics: Human Language Technologies. Stroudsburg, PA: Association for Computational Linguistics, 2011: 600-609.

[20]

MINKOV E, COHEN W W. Graph based similarity measures for synonym extraction from parsed text [C]// TextGraphs712: Workshop Proceedings of TextGraphs7 on Graphbased Methods for Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2011: 20-24.

[21]

MELAMED I D. Bitext maps and alignment via pattern recognition [J]. Computational Linguistics, 1999, 25(1): 107-130.

[22]

CONTRACTOR D, FARUQUIE T, SUBRAMANIAM V. Unsupervised cleaning of noisy text [C]// Proceedings of the 23rd International Conference on Computation Linguistics. New York: ACM, 2010: 189-196.

[23]

PENNELL D, LIU Y. A characterlevel machine translation approach for normalization of SMS abbreviations [C]// Proceedings of the 5th International Joint Conference on Natural Language Processing. Stroudsburg, PA: Association for Computational Linguistics, 2011: 974-982.

本文的主要贡献如下:

1)本文提出的文本规范化系统中,一个非标注词可以转化为一个或多个标准词。这种一对多的推特文本正规化是被首次提出的,更能满足实际的应用。

2)实验结果表明本文提出的系统取得了最较好的性能,比起之前最好的系统,本文所提方法在F值上提高了10%,这样的结果可以使得提出的系统作为推特文本自然语言处理任务的预处理步骤。