体感技术现状和发展研究

2014-10-31张诗潮钱冬明

张诗潮, 钱冬明

(1.华东师范大学 教育信息技术学系,上海 20062;2.华东师范大学 教育信息化系统工程研究中心暨上海数字化教育装备工程技术研究中心,上海 20062)

0 引 言

计算机发展的历史,是人机交互的发展史,也是从人类适应计算机到计算机不断适应人的一个发展史.Jürgen Ziegler将人机交互技术归纳为以下几个发展阶段[1].

(1)早期的手工作业阶段.当时的交互是由设计者采用手工操作和二进制机器代码的方法去操控计算机.

(2)20世纪中期的作业控制语言及交互命令语言(Command Line Interface,CLI)阶段.其特点是计算机程序员采用批处理作业语言以及交互命令语言的方式实现人与计算机之间的交互,需要程序员牢记许多计算机命令和熟练地敲击键盘.

(3)20世纪70年代后期到现在的图形用户界面(Graphical User Interface,GUI)阶段.其主要特点是桌面隐喻、WIMP(窗口(Windows)、图标(Icons)、菜单(Menus)、指针选取(Pointing))技术、直接操纵和“所见即所得(What You See Is What You Get,WYSIWYG)”.GUI简明易学,使不懂计算机的普通用户也可以熟练地使用键盘和鼠标操作电脑.因此计算机的使用人群迅速扩展.

(4)多通道人机交互阶段(Multimodal Human-Computer interaction,MMI).它利用人的多种感觉通道和动作通道(如声音、姿势、表情等输入),以并行、非精确的方式与计算机进行交互,可以提高人机交互的自然性和效率[2].用户可以使用不同生理和心理信息通道(图1所示),来实现与计算机应用例程的对话[3].从1946年第一台计算机的诞生到现在,人机交互的模式绕了一圈后又回到人类自然状态下的交互模式.人机自然交互技术(Human-Computer Nature Interaction,HCNI或Human-Machine Nature Interaction,HMNI)是一种基于视线跟踪、语音识别、手势输入、面部识别、感觉反馈等功能的新型交互技术,允许用户利用自身的内在感觉和认知技能,以并行、非精确方式与计算机系统进行交互,旨在提高人机交互自然性和高效性的一种交互方式[4],也被称为直觉化的交互.

图1 多通道人机交互界面概念模型Fig.1 Multimodal human-computer interface conceptual model

人机交互技术从手工作业阶段到多通道交互阶段的发展变化可以归纳为以下几点.

(1)交互载体,由计算机向移动设备转变.从最开始电脑到笔记本,然后平板电脑、智能手机,交互的载体逐步微型化和便携化.

(2)交互环境,由桌面变成无处不在的物理空间.随着声音、姿势等交互方式的融入,交互环境不再被客观的硬件设备所限制,用户可以在一定的交互空间内自由活动.

(3)交互方式,从命令方式转变成感知方式.现在人们不需要通过生硬的代码命令行来控制电脑,可以通过笔、语音、视觉、触觉实现同电脑的交互.

(4)交互处理,由原来命令加参数的交互处理模式转变为上下文理解、经验捕捉的模式.计算机可以通过捕捉用户的生活经验,以及交互活动的上下文来理解用户的意图和情感状况.

正如比尔·盖茨所预言:电脑毫无表情的时代即将结束,21世纪将是情感电脑大行其道的时代;未来计算机发展方向是让计算机能看、能听、能说、会思考!像人一样听得见,看得见,像人一样交谈.这些都将依赖于人机自然交互的发展.

1 人机自然交互的教育应用

Horizon年度报告[5]是新媒体联盟(New media consortium,NMC)基于 Horizon项目(Horizon Project)上的持续工作报告.Horizon项目是一个长期的定性研究项目,旨在确立并阐述可能会对以教育为主的组织机构里教学、学习、研究或创作产生重大影响的新兴技术.表1中列出了2011—2013年Horizon报告所列出的重要新兴技术.其中,姿势计算以及可穿戴技术都是自然交互中的一种.不难想象,人机自然交互技术的发展对于教育的促进作用不容忽视,目前教育的革新已经日益依赖于当前的技术发展.目前我国大部分教育所使用的交互技术还是处于图形界面阶段,多通道人机交互技术在教育领域还处于研究试用阶段.

表1 2011-2013年Horizon报告Tab.1 2011-2013 Horizon report

人机自然交互相比传统 WIMP模式下的教学的特点[6-7]是:①比基于命令与反馈的WIMP模式更自然、更具表现力;②减少师生对传统键盘和鼠标的依赖;③用户界面更加自然,使之易学或无需学习;④适用于更为广泛的教育群体,比如聋哑人群或智障人群等;⑤适用于更多类型的计算机应用;⑥以用户为中心,而不是以设备为中心.

人机自然交互技术能为学生提供一个熟悉且逼真的交互场景,学习活动中学生所需要的技术能力降到最低,可让学生更加专注于知识内容本身的学习.通过声音、动作与学习内容进行交互能有效增加学生的参与度,让学生一个旁观者成为一个学习活动的参与者,从而大大提高学生的积极性促进有效教学.泛在学习(U-Learning)也是当前教育的一个重要发展趋势,传统移动设备的交互模式已经难以满足教师和学生的学习需求,自然交互技术为泛在学习的进一步发展提供了一个新的方向.“情感计算”、“学习分析”“姿势计算”等等都与人机交互的发展有着密切的关系.人机自然交互在教育领域有着很大的应用前景,可推动传统的教学环境的革新.

1.1 基于人机自然交互技术的学习资源

学习资源包括学习资源本身以及学习工具.教师可利用增强现实技术和自然交互技术呈现的各种真实的学习场景,让学生通过手势、声音以及姿势动作与学习资源进行交互,使他们在学习活动中能够身临其境,增强其学习兴趣和动机,改变传统教育中以教师为主学生为辅的教学模式.在学习过程中,学习者的面部表情、身体姿势和语言是非常丰富的,当他们能够理解并接受学习内容时,会处于情绪高涨状态,产生微笑的表情或欢快的言语;反之,若是情绪低落,则表现为眉头紧锁、目光凝滞、意志消沉等.在传统的教学中,教师却无法顾及到每个学生的面部表情、姿势或者语言.但是通过人机自然交互技术就可以实时对学生进行监控,通过“情感模型”,从而感知,识别并且理解学生的情感.除了上述方面,人机自然交互技术还可为学生的学习档案袋提供更多的数据支持,教师可以对学生在知识获取、课堂互动、小组协作等各个环节进行学习状况追踪,建立学习者模型,以便更好地开展教学活动.

1.2 基于人机自然交互技术的教学社群建立与研究

基于人机自然交互技术的教学社群,结合虚拟现实技术可以为学生提供一个虚拟的交流社群,即学生和教师可以在异地同时登陆到教学社群,组成小组,建立一个虚拟的圆桌会议讨论,学生和教师可以自由选择一个虚拟的人物代表自己参加圆桌会议,而这个虚拟的人物可以完全模仿某主人的姿势动作、手势、脸型等.学生和教师通过自然交互技术如身临其境地参加圆桌会议.这种基于人机自然交互的教学社群改善了原来只有单纯的文字和图片的交互方式,把教师和学生的声音、姿势以及脸型等所有的信息整合起来,增加了教师和学生在教学社群中个人参与的情境性,提高了教师和学生的用户体验.

此外,基于人机自然交互技术的教学社群,可以通过对学生学习风格等相关数据(声音、姿势动作)的分析,为学生智能地形成教学社群,即对于不同的学习活动,对学习风格不同的学生进行相应的分组,让教学社群的建立更加科学,更加智能化.

1.3 基于人机自然交互技术的教学方式

传统的教学都是教师演示,学生在下面被动接受教师所传授的知识.而基于人机自然交互技术的教学强调的是学生主动通过姿势动作、手势以及声音这些交互元素身临其境地去学习知识.这样学生则由一个被动的接受者,成为了一个主动的探索者,其学习的积极性得到了增加.

人机自然交互技术是社会信息化背景下学生对教育发展的诉求,代表了教育信息化的一个重要方向.基于人机自然交互技术的学习资源、教学社群以及教学方式所组成的教学环境的核心理念在于为学生提供一个 “个人自学”、“研讨性学习”、“在做中学”的学习环境,可极大地发挥学生学习的自主性,改善传统“课堂学习”的被动性和依赖性.教师需要从以学习者为中心的教学理念出发,结合自然人机交互技术,设计个性化学习的学习环境,让学生可以轻松地、投入地和有效地在一个智能的学习环境中学习.

2 体感技术以及Kinect历史

Kinect是微软公司研制的一款体感外设,最初是针对其游戏主机XBOX360推出的一套外设产品.Kinect的整个发展历史经历了XBOX360—Natal—Kinect三个阶段(见表2).XBOX360主要是为了给用户创建一个生动的娱乐体验.它注重用户的个性化喜爱和个人风格,硬件设备包括游戏主机以及手柄摇杆等外接设备.但这种传统的娱乐方式使游戏玩家和所有人都分隔开了.Kinect可以通过3D体感摄影机,导入即时动态捕捉、影像辨识、麦克风输入、语音辨识、社群互动等功能,让玩家在游戏中开车、互动,通过互联网与其他玩家分享图片和信息等.

Kinect是以XBOX360游戏机的周边外设发展出来的.把XBOX360比作游戏机,则Kinect可比作为游戏手柄,只不过此游戏手柄能识别玩家的姿势动作、手势以及声音.随着Kinect技术不断地成熟,Kinect最终独立于XBOX360,可以直接和普通的PC机连接,对人体的姿势动作进行识别.由于Kinect设备单一简单,除了在游戏领域,医学、教育、农业等众多领域都有Kinect的身影.

表2 Kinect的历史发展Tab.2 The history development of Kinect

3 Kinect技术基本框架

Kinect主要技术有三个:深度识别(3D图像识别技术)、人体骨骼追踪技术(动作捕捉技术)、语音识别技术.

3.1 深度识别(3D图像识别技术)

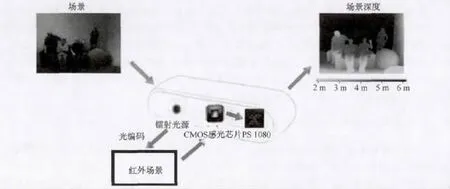

采用3D深度摄像机技术,可以捕捉到人所在的空间位置,原理是红外线感应.Kinect上有1个3D深度感应摄像头,首先通过红外线发射器发出一种不可见镭射光,这个光线经过扩散片分布在测量的空间内;当镭射光射到人体之后会形成反射斑点,另外一个红外线摄像机对这些反射斑点进行记录,通过芯片合成出3D深度信息的图像(图2)。

图2 Kineet的深度识别Fig.2 The recognition of the depth by Kineet

3.2 人体骨骼追踪技术(动作捕捉技术)

识别到3D图像深度信息后,通过软件计算出人体主要的骨骼位置,通过精确掌握玩家身形轮廓与肢体位置来判断玩家的姿势动作,从而捕捉到人(玩家)的动作.目前只支持2个人的骨骼捕捉(图3).

3.3 语音识别技术

在3 m以外过滤掉背景噪音和其他不相干声音,准确地识别出玩家的语音;同时也支持语音控制.Kinect系统还有一个根据不同国家不同的口音建立的“声效模型”,用来识别不同的口语和语言.语音识别技术在视频会议中很有用,远距离拾音,使用更方便.这个技术为Kinect的可视通话提供了保障.

图3 Kineet的人体骨骼追踪技术Fig.3 Human body skeleton tracking technology by Kineet

4 Kinect应用现状

随着体感技术的高速发展,Kinect在各个领域的应用价值已初见端倪,主要包括教育领域、医学领域、虚拟应用、机械控制等.

4.1 教育领域

(1)特殊教育

特殊教育事业是国民教育中的一个重要组成部分,是体现教育公平的一个重要标志.由于教育对象的特殊性,教学工作者在现实的教学过程中面对着更多的问题:学生理解能力差,在领会教师讲授的知识点上存在难度;学生的心理压力大,自卑心理严重,影响教学效果的实现;学生先天基础参差不齐,对教学内容的分配及组织带来难度等.Kinect作为一种自然人机交互手段,可以有效地缓冲特殊儿童的教学抵触情绪,通过一种娱乐的手段来达到教学目的.此外Kinect体感技术可以实时监控特殊儿童的身体动作,并及时反馈给教师.

Elton S.Sarmanho等借助一个教育游戏ALERV来帮助残疾儿童完成阅读和写作任务.而ALERV的设计正是使用了Kinect的体感技术和声音识别技术.残疾儿童在学习写作和阅读的过程中,表现出了浓厚的好奇心和积极性.此外ALERV也提高了儿童的互动能力[7].

含手指行为在残疾儿童中是一个常见的现象,大约有17%的残疾儿童有此行为.含手指给教师的正常教学带来了诸多不便,因为教师不可能时时刻刻看着学生.Tzu-Wei Wei通过Kinect深度成像技术,来识别残疾儿童含手指行为,其正确反馈率达到86.5%.该方法能快速准确地将含手指行为反馈给特殊教育教师,并且及时提出干预策略[8].

YaoJen Chang等人基于Kinect动作捕捉系统开发了一个智能康复系统,帮助残疾学生恢复身体.参与者借助于这套智能康复系统,有效地提高了运动能力,肌肉耐力也有很好的恢复.该系统有助于提高残疾学生的参与积极性,从而减少治疗师的工作量.

(2)数学教育

目前,Kinect在数学中的运用主要目的在于突出Kinect自然交互特性和游戏性.Begel指出动觉学习活动(Kinesthetic learning Activity)能有效地吸引学生的注意力[9].基于Ki-nect的数学学习活动,不仅仅需要学生进行脑力运算,还需要学生协调他们的肢体.通过肢体的交互活动,不仅增加了学生的参与度,还提高了学生的注意力.此外,基于Kinect的学习工具可以及时有效地反馈学生的学习态度,帮助教师调整教学策略.

Washington Bothell的两位学生Jack Chang和Jeb Palveas用Kinect开发了一个数学教学软件,让学生通过肢体控制二次曲线的状态[10].Elwin Lee,Xiyuan Liu等在数学算术教学中使用Kinect数学游戏Xdigit,让学生通过手势以及头部动作控制电脑程序来学习10以内的加减乘除,从而达到算术学习的目的[11].此外Steuart W.Weller小学使用Kinect辅助数学算术教学,通过射飞镖的游戏,让学生体会加法减法运算中所出现的各种情况,以及其算法之间的规律[9].Katherine Isbister在数学教育中使用Scoop,让学生以一种比较舒适的姿势动作来学习,改善了学生数学学习的态度[12].

(3)语文教育

传统的语文阅读教学中,看重的是学生的文字表达,而忽视学生的肢体动作.但是一个人要向外界传达完整的信息,文字成分只占7%,声调占38%,另外55%的信息都需要由非语言的体态语言来传达.上述Kinect的应用,能让语言文字和姿势动作完美融合在语言模仿教学中,帮助学生真正地进行阅读学习.

微软公司于CES2011公布的Avatar Kinect帮助Steuart W.Weller小学的学生克服阅读障碍.在该教学应用中,学生给电脑中虚拟的“Avatar”配音,同时“Avatar”能同步学生的肢体动作以及面部表情,让学生不仅觉得好玩同时也能达到语文阅读教学的目的,在减轻学生阅读压力的同时也增加了学生阅读的兴趣[13].与此相类似的还有Yoostar2:让学生通过Kinect观看好莱坞影片,并模仿片中人物对话的表情、语音语调、肢体语言和动作,学生在整个模仿声音、动作的过程中学习课文的朗读.

(4)体育教育

Kinect可以阅读人的姿势动作,而体育教学中大部分需要教导学生如何正确地做动作.微软已经开发了大量的体育游戏类软件,比如舞蹈中心3、阿迪达斯、运动教练等.除此之外JoséGabriel Teixeira与Pedro Pinto Teixeira基于Kinect开发了一个专门为儿童设计的Exergame,把传统的教室扩大到操场,让学生结合体育活动进行探索式学习和高阶认知活动[14].Steuart W.Weller小学借助Kinect教学生打乒乓球正确的姿势[15].

4.2 其他领域

对于一些微观物体、无法触及或者不方便触及的物体,可以通过3D建模,加上Kinect体感技术,通过手势和语音,控制模型而模拟出微观世界所发生的情景,增强人们对事物感知的情境性.欧洲时装店Topshop在莫斯科旗舰店安装了一种全新的试衣间,借助Kinect,顾客无需试穿就能在镜子中见到自己身着新衣的样子[16].Ultra-Realistic联手英国Sotouch科技公司一起推出了Air presenter,让用户通过手势操控电脑中的图片、3D模型,以协助用户进行演讲[17].除了虚拟应用领域,Kinect还可以应用在机器人领域,充当机器人的眼镜.匹兹堡大学一研究小组使用Kinect传感器,让机器人和人们一起玩抛球游戏,完成接球和抛球的动作;机器人如果接球失败,会做摇头、向后看、向下看或耸耸肩等动作[18].微软机器人测试开发人员Jordan Correa使用Kinect设备,借助Microsoft Robotics Developer Tool 4进行软件开发让其作为机器人的“眼睛”,让机器人可以一直跟随在你的身后,帮助你携带啤酒等小型物品[19].

当前Kinect的发展重点虽然还在游戏领域,但是从长远发展来看,为了体验更加绚丽与科幻的操控方式和人机交互体验,Kinect的应用必将会呈多样性发展趋势.除了人体骨骼追踪技术之外,语音识别技术也在快速发展中.Kinect自带的麦克风可供用户进行简单的命令操作.Windows8系统中,PC操作系统就自带了非常强大的语音识别功能,且能天然识别包括中文在内的主要语言.Kinect在微软的计划中也将随Windows 8操作系统的面世而大展宏图.

5 Kinect技术实现

Kinect体感技术的本质就是通过RGB摄像头以及红外线CMOS摄像头识别姿势动作、手势这些输入元素,从而实现对虚拟物体或者实体物品进行控制.根据对国内外相关文献的研究,我们对Kinect所识别的元素以及其中涉及的算法进行了分类(见表3):

表3 Kinect输入元素研究分类Tab.3 The research classification of Kinect Input element

Kinect应用中主要涉及的算法是手势识别、骨骼追踪、深度数据.开发需要的环境分别是 Microsoft’s Kinect SDK(www.microsoft.com/en-us/kinectforwindowsdev/Start.aspx)和PrimeSense OpenNI安装(www.openni.org).另外,Kinect还有大量的资源网站可参考:

(1)体感游戏网(http://www.cnkinect.com/forum.php?gid=1):包含体感专题、体感游戏、体感开发的相关介绍,以及各种体感项目的源码资源.

(2)Kinect综合网站(http://123kinect.com):包含 Kinect最新新闻、Kinect游戏介绍、Kinect开发指南等.

(3)Kinect for PC 项目的 wiki(http://www.javaforge.com/project/Kinect2PC):包含Kinect体感硬件软件以及原理各个方面的介绍,此外还包含了Kinect软件开发的相关资源.

(4)OpenNI开源资源(http://github.com/openni):包含大量自然交互的开源框架.

(5)OpenNI开源资源(http://github.com/PrimeSense/Sensor):包含大量PrimeSensor开发的开源驱动程序.

(6)Kinect开发程序资源(http://fivedots.coe.psu.ac.th/~ad/kinect/):包含大量开发案例和源码.

(7)教育相关资源(http://www.kinecteducation.com):包含 Kinect在教育中的运用案例,部分教育软件的下载链接等.

5.1 OpenNI手势识别

OpenNI能支持的手势有四种:Wave(挥手)、Click(点)、RaiseHand(举手)、Moving-Hand(移动手).创建手势的基本方法如下:

xn::DepthGenerator mDepthGenerator;

eRes= mDepthGenerator.Create(mContext);(注释:创建一个手势GestureGenerator生成器)

mGesture.AddGesture("Wave",NULL);mGesture.AddGesture("Click",NULL);

mGesture.AddGesture("RaiseHand",NULL);

mGesture.AddGesture("MovingHand",NULL);(注释:分别加入手势)

通过GestureGenerator的回调函数来检测手势的完成情况,GestureRecognized和GestureProgress分别代表侦测到一个已经完成的手势和检测到手势正在进行中.而当手势被侦测到的时候,GestureGenerator就会执行这两个回调函数,对侦测到的手势进行处理.

XnCallbackHandle hHandle;

mGesture.RegisterGestureCallbacks(GRecognized,GProgress,NULL,hHandle);(注释:对侦测到的手势进行处理)

mContext.StartGeneratingAll();

while(true)

{mContext.WaitAndUpdateAll();}(注释:对用户手势的实时监控)

如果需要其他复杂的手势可以自己去定义,并借助以上代码,可以实现诸如用手势控制PPT翻页以及视频控制等简单操作.

5.2 OpenNI深度数据识别

Kinect的深度数据设别是通过3D深度摄像机技术.识别红外线射到人体之后会形成反射斑点,通过芯片合成出3D深度信息的图像.深度数据可以通过如下方法获取:

xn::DepthGenerator mDepthGenerator;

eResult= mDepthGenerator.Create(mContext);

eResult= mDepthGenerator.SetMapOutputMode(mapMode);

eResult= mContext.StartGeneratingAll();

const XnDepthPixel* pDepthMap= mDepthGenerator.GetDepthMap();可以进一步通过对深度数据进行处理,获得需要的信息.

5.3 OpenNI骨骼追踪

通过处理深度数据可以建立人体各个关节的坐标,骨骼追踪能够确定人体的各个部分:手、头部以及身体,还能确定用户所在的位置.获取人体的骨架图的方法:

xn::UserGenerator mUserGenerator;

mUserGenerator.Create(mContext);

XnCallbackHandle hUserCB;

mUserGenerator.RegisterUserCallbacks(NewUser,LostUser,NULL,hUserCB);

xn::SkeletonCapability mSC= mUserGenerator.GetSkeletonCap();

mSC.SetSkeletonProfile(XN_SKEL_PROFILE_ALL);

XnCallbackHandle hCalibCB;

mSC.RegisterCalibrationCallbacks(CalibrationStart,CalibrationEnd,

&mUserGenerator,hCalibCB);

XnSkeletonJointTransformation mJointTran;

mSC.GetSkeletonJoint(aUserID[i],XN_SKEL_HEAD,mJointTran);

手势、深度和骨骼追踪是人机自然交互中最为基础的部分,同时也是最为实用的部分.通过对手势、深度和骨骼追踪的组合,组装成一些基本姿势的定义,再通过对这些基本姿势的组合,就可以开发出通过肢体的自然交互,来控制计算机的操作.

本研究团队正在通过Kinect体感技术构建更加智慧的教学环境.其中之一的研发就是通过Kinect获取人体骨骼信息与深度数据.根据手部的位置,取邻近的深度值,抓出手的区域;把抓到的手部区域,透过OpenCV找出手的轮廓,并简化轮廓;找到手的轮廓的在几何上的凸包以及凹进去的点,然后对这些点做进一步的分析,来判断手的形态,并且结合人体的骨骼信息来创建手语教学辅助系统.

6 结束语

目前Kinect应用技术的开发还只是刚刚起步.但是凭借其自然交互的优点,已经表现出强大的生命力和多样性发展趋势.随着Kinect技术的进一步成熟和充分挖掘,人机交互带来物质的突破,必将在教育领域得到广泛应用.

[1] ZIEGLER J.Interactive techniques[J].ACM Computing Surveys,1996,28(1):185-187.

[2] OBRENOVICZ ,STARCEVIC D.Modeling multimodal human-computer interaction[J].Computer,2004,37(9):65-72.

[3] 董士海,王衡.人机交互[M].北京:北京大学出版社,2004.

[4] 董士海,王坚,戴国忠.人机交互与多通道用户界面[M].北京:科学出版社,1999.

[5] NMC.Horizon Project[EB/OL].2013[2013-4-24].http://www.nmc.org/horizon-project.

[6] 张顺.基于运动的感知用户界面模型及其应用[D].浙江:浙江大学,2009.

[7] ELTON S.SARMANHO,ELLTON B,et al.A game for teaching children with disability in reading and writingin Portuguese using voice recognition and kinect sensor[C]//Proceedings of X Brazilian Symposium on Computer Games and Digital Entertainment.IEEE,2011.

[8] WEI T-W.Detecting the Hand-Mouthing Behavior of Children with Intellectual Disability Using Kinect Imaging Technology Proceedings of the 14th lnternetional ACM SIGACCESS Conference on Computers and Accessibility.NEW York:ACM,2012:295-296.

[9] BEGEL A,GARCIA D D,WOLFMAN S A.Kinesthetic learning in the classroom.ACM SIGCSE Bulletin,2004,36:183-184.

[10] Classrooms of Tomorrow,Today:Kinect Math App Available for Download [EB/OL].2011[2013-4-24].http://www.kinecteducation.com/blog/tag/jeb-palveas/.

[11] LEE E,LIU X,ZHANG X.Xdigit:An Arithmetic Kinect Game to Enhance Math Learning Experiences[EB/OL].2012[2014-01-07].http://www.elwinlee.com.

[12] ISBISTER K,KARLESKY M,FRYE J.Scoop!Using Movement to Reduce Math Anxiety and Affect Confidence[C]//Proceedings FDG'12.NEW York:ACM,2012:228-230.

[13] MELLON E.Gesturing to Learn Video game technology is in motion in Loudoun County schools.[EB/OL].2012[2013-4-24].http://www.districtadministration.com/article/gesturing-learn.

[14] TEIXEIRA J G,TEIXEIRA P P.Zun-A Math Exergame[EB/OL].2012[2014-01-07].http://www.oyvo.net.

[15] Ericka Mellon.Gesturing to Learn Video game technology is in motion in Loudoun County schools.[EB/OL].2012[2013-4-24].http://www.districtadministration.com/article/gesturing-learn.

[16] Augmented Reality:Kinect fitting-room for TopShop,Moscow[EB/OL].2011[2013-4-24].http://www.wired.com/beyond_the_beyond/2011/05/augmented-reality-kinect-fitting-room-for-topshop-moscow/.

[17] Wltra-Realistic.Air Presenter[EB/OL].2012[2013-4-24].http://blog.ultra-realistic.com/cn/?tag=Air+presenter.

[18] Digital Arts.Disney Research hacks Kinect to let robot juggle and catch [EB/OL].2012[2013-4-24].http://www.digitalartsonline.co.uk/news/hacking-maker/disney-research-hacks-kinect-let-robot-juggle-catch/.

[19] Robotics Developer Studio 4 Lets You Build Kinect-Guided Robots[EB/OL].2012[2013-4-24].http://www.techhive.com/article/251524/robotics_developer_studio_4_lets_you_build_kinect_guided_robots.html.